论文翻译:AIED 2025 AIBAT: AI Behavior Analysis Tool for Teacher-Driven Contextual Evaluation of Language

随着AIED越来越依赖不透明的黑盒支架(如大型语言模型)来支持学生学习,人们越来越担心它们在不同教学情境中使用时的局限性。这种不透明性往往削弱了教育工作者的信任并影响他们的看法,导致学校对采用AI支架的抵制。为了应对这些挑战,我们开发了AIBAT,这是一个旨在支持教育工作者在其特定教学情境(例如,学科、年级水平、英语熟练程度)中审计和批判性评估AI系统的潜在益处和危害的工作流程和系统。通过AIBA

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://link.springer.com/chapter/10.1007/978-3-031-98414-3_5

论文集下载:https://download.csdn.net/download/WhiffeYF/92543315

论文原文:https://download.csdn.net/download/WhiffeYF/92544371

论文阅读:https://blog.csdn.net/WhiffeYF/article/details/156714497

AIBAT: AI Behavior Analysis Tool for Teacher-Driven Contextual Evaluation of Language Models in Education

AIBAT: 教育中语言模型的教师驱动情境评估AI行为分析工具

Shamya Karumbaiah(✉), Yaxuan Yin, 和 Aayush Bharadwaj

威斯康星大学麦迪逊分校,麦迪逊,WI 53706,美国

{shamya.karumbaiah,yaxuan.yin,abbharadwaj}@wisc.edu

摘要

随着AIED越来越依赖不透明的黑盒支架(如大型语言模型)来支持学生学习,人们越来越担心它们在不同教学情境中使用时的局限性。这种不透明性往往削弱了教育工作者的信任并影响他们的看法,导致学校对采用AI支架的抵制。为了应对这些挑战,我们开发了AIBAT,这是一个旨在支持教育工作者在其特定教学情境(例如,学科、年级水平、英语熟练程度)中审计和批判性评估AI系统的潜在益处和危害的工作流程和系统。通过AIBAT,教师可以指定预期行为——即他们期望AI支架应该做什么——并针对这些期望测试系统。我们对14名教师进行了探索性用户研究,以考察AIBAT如何促进AI相关风险的识别和意义建构,同时使教育工作者能够使用证据来校准他们对AI支架的信任。我们的研究发现表明,教师重视参与AI决策而不是被动接受它们的能力,将这一过程描述为增强透明度、信任和控制感的"对话"。我们确定了促进用户在AI审计过程中有意义参与的关键机会,并讨论了促进教师负责任和有效参与教育环境中AI系统评估和部署的更广泛影响。

关键词: 大型语言模型 · 评估 · 教师 · 情境 · 行为分析 · 支架 · 教育中的负责任AI

1 引言

在课堂中公平和协同使用AI进行支架必须承认教学情境的差异。在课堂中,支架通常分布在材料、同伴、技术和教师之间[16]。支持学生学习的AI系统可以释放教师的时间,使他们能够专注于最需要支持的学生[22,23]。因此,设计为与教师实践协同工作的AI系统更加有效[24]。由于教学情境各不相同,支架需求和优先级也不同——教师对系统失败的定义也是如此。

然而,AI评估通常假设普遍部署,忽略了情境差异。事实上,AI评估的主流方法(即测试数据的泛化估计)往往会高估实际性能[20,29]。在大多数情况下,用于评估泛化的测试数据不能很好地代表现实世界场景的范围,并且通常包含与训练数据相同的偏见。即使使用来自部署情境的数据进行测试,人口分布也可能随时间而变化[17]。

自然语言处理(NLP)——一种涉及文本计算模型的AI系统——的最新研究表明,让利益相关者分析NLP模型行为(在与其情境相关的条件下)对于识别在泛化测试中可能被忽视的失败是有效的[8,9]。具有有限AI先验经验的利益相关者能够在评估用于语言翻译、内容审核和问答的NLP系统时识别关键能力的失败,例如公平性(例如,对语言少数群体的偏见)、对扰动的鲁棒性(例如,拼写错误)以及特定领域的词汇。

尽管在情境中分析AI系统行为为使利益相关者能够审问AI黑盒提供了一个有前景的途径,但我们仍然不知道:(1)这种方法对教育AI的利益相关者(如教师)具有什么价值;(2)我们如何能够更好地将其与教师的情境需求对齐;(3)如何建立教师在识别有益和有害的支架行为方面的专业知识和能动性;(4)它如何影响教师对AI支架的信任和实践。已经存在多种形式的AI系统用于分布式支架(例如,用于写作反馈的NLP系统、对话代理、AI辅导员),现在随着生成式AI的出现,教师面临着信任这些先进技术以利用它们的困难选择。信任这些系统尤其困难,因为它们变得不那么透明并引发对少数群体学生的公平性担忧。正如学习科学对学生和教师与技术的能动性提出批判性问题[1],我们问道:我们如何为教育利益相关者配备工具,以建立他们在课堂中可信赖和公平的AI使用方面的专业知识和能动性?因此,我们研究中的核心研究问题是:教师如何分析AI系统行为以识别与他们的学生使用AI支架的益处和危害?

2 概念框架

我们首先将AI系统框定为支持学生学习的支架,并论证人类中介对于在课堂中适当使用AI是必要的。然后,我们展示了系统失败如何因教学情境而异,这些方式没有被泛化估计所捕获。最后,我们解释了允许教师等利益相关者在其教学情境中评估AI系统行为如何促进信任和能动性,以实现公平和协同的人类-AI支架。

2.1 AI系统作为支持学生学习的支架

支架与Vygotsky提出的学习的社会文化观点密切相关[2],其中学习首先发生在与他人互动的社会层面,后来发生在个人层面。尽管支架最初被描述为成人在儿童的最近发展区(ZPD)中提供的一对一支持,但当今课堂的实际限制对同时负责多个ZPD的一名教师构成了约束。因此,支架通常在教学材料、同伴、技术和教师之间协同分布[22]。设计为支架的AI系统[30]可以预测学生在其ZPD中不断变化的需求,并支持他们发挥潜力[6]。设计良好的支架对学生的ZPD敏感[16]。例如,在过去40年中,关于AI辅导员的研究已经开发了模型来评估学生当前的技能水平并在当下调整教学支持[12],使教师能够关注需要个性化支持的学生[18]。

2.2 分布式支架中的人类-AI协同

尽管作为支架的AI系统可能被狭义地定义为支持特定任务[30],但支架作为对话过程,在理论上基于社会文化方法[16]。人类中介,涉及学习环境中的人际互动,是材料支架或工具得到适当使用的关键[33]。在课堂中,促进与同伴和教师对话的社会结构作为社会支架,使工具学习成为可能(例如,[31])。此外,教师在基于学生不断变化的需求在当下调整和持续调整支架方面发挥着关键作用[19],做出敏感、有意识的决定来补充工具提供的支持。教师还负责响应性地淡出支架以促进学生的独立性。因此,支架系统(即分布式支架[16]),涉及工具和社会支架,必须协同运作才能有效地支持课堂中的学生。例如,过去关于AI辅导员的研究表明,即使技术被设计为以最少的人工干预工作,教师实践对学生学习也很重要[7]。此外,适应性体验由教师和技术共同促进[14]。因此,与AI的自动化优先方法相比,在课堂中使用AI的更有益方法可能是智能增强[21,26],其中AI建立在教师的教学知识之上。

2.3 公平AI需要超越泛化估计

尽管使用教育AI系统的教学情境存在显著差异,但AI评估通常仅限于泛化估计(例如,整体准确度、均方误差),这些估计本质上假设普遍部署[32]。此外,已知AI系统在罕见群体上系统性地失败,这些群体在聚合评估中不明显[27],例如少数群体学生群体。过去的研究表明,在AI辅导员的设计中忽略学习者情境可能会在其中引入有害偏见[3]。尽管最近在识别和减轻教育AI中的偏见方面努力激增[10],但仍然存在重大挑战。公平性的常见方法是确保系统对学生亚组表现良好。除了对学生人口统计的过度简化或受政治影响的分类之外,这些方法在考虑学生身份交叉的无数方式方面不足[15]。此外,偏见的技术概念往往是模糊的,缺乏规范性基础,并且与偏见的社会理解存在分歧[28]。因此,"什么样的系统行为是有害的,以什么方式,对谁,为什么?"的答案[25]需要在利益相关者的生活经验中具有情境基础。

2.4 利益相关者驱动的行为情境评估以建立人类-AI信任

越来越多的人呼吁情境评估[11],承认利益相关者生活经验的差异,这反过来又以不同方式定义系统失败[13]。指定期望的系统行为在透明度和信任中发挥重要作用,使AI系统接受利益相关者的审查[8]。先前的工作已将人类-AI信任形式化为契约性的,即信任建立在利益相关者基于AI系统的预期行为指定的明确、特定于情境的契约之上[5]。通过测试定义的系统行为可以作为这种契约的组成部分——特别是当它们结合利益相关者的情境专业知识将隐含期望(例如,公平性)转化为明确的、可测试的标准时。除了更明智的信任之外,AI支架行为的情境评估可以提高AI透明度[4]。随着对在其情境中使用AI支架的益处和局限性的更好认识——以及相关的公平性担忧——利益相关者可以更有效地将AI支架定位在其分布在工具和社会支持之间的更广泛的支架系统中。这可能涉及调整支架实践以放大AI支架的益处并减轻其局限性。

3 AIBAT系统设计

通过AIBAT,教师指定行为(即他们期望AI支架做什么)并针对这些期望测试支架(如大型语言模型(LLM))。例如,为了分析LLM如何公平地对待双语学生,教师可以定义目标LLM行为(例如,标记不正确的学生响应以获得反馈)并测试该行为是否基于指定条件保持不变(例如,当相关的西班牙语习语添加到响应中时评估没有变化)。尽管AI支架可能被期望执行各种任务,如评估、反馈和问答,但我们在本研究中专注于评估作为说明性示例,因为它通常是诊断学生支架需求的第一步。在本节中,我们首先在第3.1节中描述AIBAT的基础设施和迭代工作流程。然后,我们从第3.2节到第3.4节介绍三个集成的设计功能,以及图2中显示的界面,旨在帮助教师理解AI性能的危害和益处以及信任。

3.1 系统概述

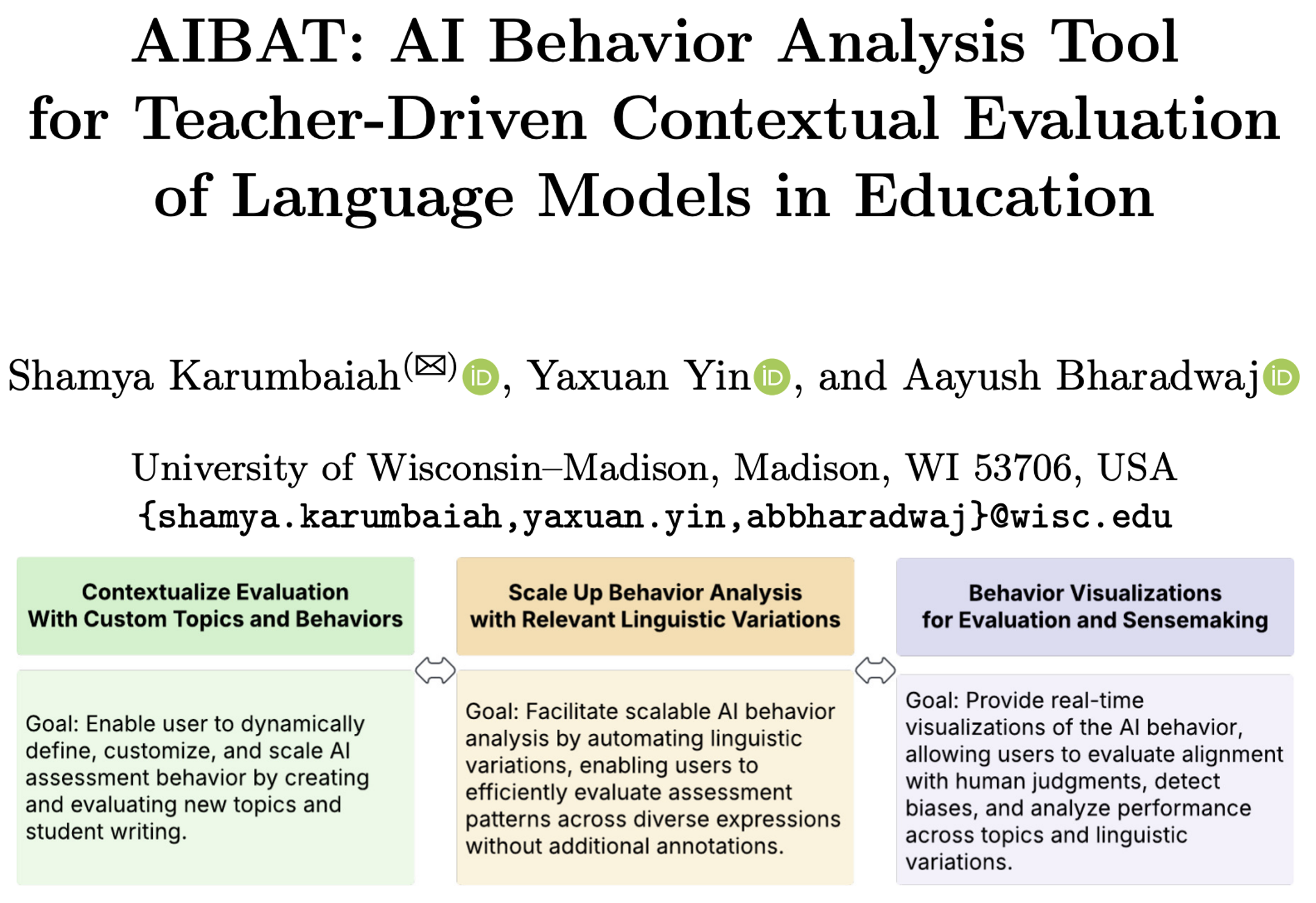

如图1所示,AIBAT有三个关键设计功能:1)通过自定义主题和行为进行情境化评估,2)通过相关语言变化扩大行为分析,3)用于评估和意义建构的行为可视化。首先,教师通过提供测试案例(例如,学生响应)和预期评估(例如,可接受与不可接受)来定义预期的AI行为。教师可以通过创建与其学科相关的新主题并添加反映其学生写作的测试案例来情境化评估过程(见第3.2节)。其次,平台提供完整的测试案例管理,使用户能够根据需要编辑、删除或添加测试案例。在审查AI的评估后,教师可以指示他们是否同意它,AIBAT通过交互式图表可视化这些结果。这些可视化提供了对AI评估性能、潜在偏见和整体一致性的洞察(见第3.4节)。第三,AIBAT允许教师引入语言变化(见第3.3节),如拼写错误、缺少标点符号、翻译和测试陈述的释义版本,以评估AI评估如何处理其学生写作的不同方式。AIBAT使用Django和Next.js构建,并托管在Lambda Cloud GPU实例上。

图1. AIBAT的工作流程包括通过自定义主题和行为进行情境化评估、通过相关语言变化扩大行为分析,以及用于评估和意义建构的行为可视化,以促进对LLM评估的益处和危害的意义建构。

3.2 通过自定义主题和行为进行情境化评估

默认情况下,平台包括两个示例中学科学主题——势能(PE)如何随高度变化以及质量如何影响总能量——以及一组预定义的学生响应。对于每个主题,用户在主面板上看到20个预定义陈述,每个陈述都附有AI生成的评估,指示该陈述是否被认为是可接受的或不可接受的。用户可以审查这些评估,并通过单击一次同意或不同意AI的决定来提供反馈。为了提供对不同学科领域和评分标准的适应性,AIBAT提供了自定义主题定义功能,允许用户动态定义和评估新主题。

此功能包括两个可配置选项以支持不同的评估需求。首先,自定义主题允许教师通过定义评估提示并添加多达10个针对其学科的测试陈述来创建自己的主题。这些用户定义的主题充当提示,帮助AIBAT生成可添加书签的主题页面,类似于默认的高度/PE和质量/能量主题,允许用户在它们之间切换。如果教师希望通过额外的自动生成测试陈述来增强其评估,他们可以选择"生成更多陈述",提示AIBAT在定义的主题下生成新陈述。

其次,用户定义陈述允许用户在现有主题下手动输入特定陈述以供AI评估。用户可以编辑现有陈述并保存它,提示LLM重新评分修改后的陈述,或者输入一个全新的陈述而不是修改预定义的陈述,指示他们是否认为它是可接受的或不可接受的。提交后,该陈述出现在所选主题下的面板中,附有LLM生成的评估(可接受/不可接受)以及AI的评估是否与教师的决定一致的指示(同意/不同意)。这些选项共同允许教育工作者将AIBAT的评估系统定制到一系列评分需求,确保超出其默认主题和陈述的灵活性。

3.3 通过相关语言变化扩大行为分析

AIBAT纳入了语言变化功能以考虑表达给定陈述的不同方式。当教师通过单击"分析AI行为"按钮启用此功能时,每个陈述都会扩展为一个下拉菜单,显示多个语言修改版本。默认情况下,这些变化包括拼写修改、否定、同义词、释义、缩写词、反义词和西班牙语翻译等调整。此外,用户可以访问条件编辑器面板来定义自定义语言变化,提供关键信息以帮助微调模型的响应。从整体上看,此功能旨在通过允许教师评估跨多种语言形式的AI评分模式(其先前的决定自动填充)而不是手动审查每个孤立的案例来增强可扩展性。在现实世界的课堂环境中,学生的响应在措辞、语法和措辞方面自然会有所不同,但传统的AI评估方法通常依赖于固定的表达,限制了评估的范围。通过自动生成系统的语言变化,AIBAT使教育工作者能够有效地大规模检查AI模型如何处理不同的输入。

3.4 用于评估和意义建构的行为可视化

AIBAT包括一个实时AI性能分析面板,通过条形图提供对AI模型评估准确性的动态洞察。可视化围绕三个关键维度构建:(a)不同主题的性能——系统评估各种学科领域的AI行为,使用户能够评估模型是否有效泛化或在某些主题上挣扎。此功能有助于识别可能影响评分公平性的特定于学科的偏见和不一致性。(b)用户审计与AI决策之间的一致性——此指标衡量用户审计决策与AI评估一致的程度。它区分真阳性(正确接受)、真阴性(正确拒绝)、假阳性(错误接受)和假阴性(错误拒绝)。这允许用户识别AI错误的模式并评估其在不同评分场景中的可靠性。©跨语言变化的性能——AIBAT还分析AI如何响应不同的语言变化,如语法、拼写和否定的变化。通过跟踪这些变化的性能,用户可以检测模型处理不同语言表达能力中的潜在偏见或弱点。

3.5 LLM模型规格

AIBAT在整个应用程序中利用各种LLM来有效执行不同的任务。对于评分默认主题,平台使用微调的RoBERTa分类模型,专门训练以评估与默认学科相关的响应。当涉及评分新的用户定义主题时,AIBAT切换到通用的预训练Llama 3模型,该模型为更广泛的评分任务提供灵活性。对于生成新的测试案例,AIBAT依赖于Mistral模型,该模型有助于创建多样化和相关的测试场景。使用Mistral生成语言扰动。通过这些精心选择的模型,AIBAT确保准确的评分、有效的测试案例生成以及针对各种教育需求的稳健扰动处理。

4 方法

4.1 参与者招募

我们通过机构网络招募了14名参与者(3名男性,11名女性)参与本研究,该研究在机构审查委员会(IRB)批准下进行。所有参与者都有先前的教学经验,从K-12到大学级别,平均有16年的教学经验。他们的学科背景涵盖各个领域,包括艺术、历史、社会研究、技术和创业。虽然9名参与者自我报告熟悉ChatGPT等LLM工具,但其余5名没有先前使用它们的经验。我们亲自进行了思维出声会话,每次会话持续58到110分钟。

4.2 程序和数据分析

为了评估AIBAT的可用性和有效性,我们进行了一项用户研究,其中参与者在提供实时反馈的同时探索该工具的功能。我们首先介绍AIBAT的目标,解释其预期的应用场景以确保参与者理解其目的和相关性。在此介绍之后,研究人员引导参与者完成每个功能,演示其功能并鼓励实际互动。然后,参与者有机会独立探索AIBAT,同时被指示思维出声,表达他们的想法、印象以及他们遇到的任何挑战。为了捕获他们的实时互动,参与者在整个会话期间被要求共享他们的屏幕。这使研究人员能够密切观察导航模式、参与水平以及探索期间出现的任何可用性问题。在每次会话结束时,研究人员与参与者进行了简短的汇报,以反思他们的经验,收集反馈并确定改进领域。

为了分析研究数据,我们审查了所有视频录像,转录了讨论,并提取了相关引用和行动,说明参与者如何创建示例集和测试,以及他们如何推理和反思模型。使用亲和图,我们注释并将这些洞察分类为主题组。我们迭代地分析了转录本,分组解释笔记,并从数据中识别新兴主题,使我们能够辨别参与者互动和推理中的关键模式和趋势。

5 研究发现

5.1 评估机制促进人类-AI信任

我们的研究发现表明,AIBAT的评估机制允许用户审计AI生成的评估,在培养用户自主权和对基于LLM的评估的信任方面发挥着关键作用。具体而言,参与者表示,参与AI决策的能力——而不是被动接受它们——有助于对系统输出的更大控制感。正如P13所指出的:"其他一些工具就像,好吧,我输入了这个,这个出来了,我们只能希望它是正确的,或者我们必须自己验证它。"一位参与者强调了如何在界面中直接查看AI评估并将其与自己的判断进行比较,提供了对模型决策过程的更清晰理解,指出,"看着它,就像我们谈论的关于我们如何知道信息是准确的…现在我们实际上可以在那里看到它。“此外,P5将此评估描述为与AI的"对话”,指出,"我通常喜欢这个工具…它有点显示它几乎是一个对话——就像来回。透明度在让其他任何人接受它方面也可以是超级关键的。"总体而言,我们的结果表明,评估AI评估的能力使用户能够批判性地评估模型的输出,与AI应该是协作工具而不是不容质疑的权威来源的想法保持一致。

此外,参与者强调,交互式评估模型的能力增加了他们对系统的信任。P4解释说,"被赋予测试它、移动它、训练它并了解它在寻找什么的工具给了我更强的信任,我会更有可能使用它。"同样,P11指出"它有点帮助你通过这些镜头看,如果你愿意,以获得更准确的工具并朝着信任和可靠性迈进。如果我被单独给予该工具并只是被告知使用它,我的信任会非常低。"参与者还强调了评估过程如何鼓励超越仅仅评分的积极参与和批判性思维。正如P7解释的那样:“我一直在想的一件事是,现在比以往任何时候都更重要,我们需要教学生批判性思维。如果我们现在不开始,他们将不知道该信任什么和不信任什么。这个工具中的评估是一个很好的起点。”

5.2 通过自定义主题和语言变化进行结构化评估

参与者强调,AIBAT的结构化评估方法,特别是评估不同语言变化的性能的能力,为系统评估提供了一个关键框架。拥有明确定义的结构使用户能够有效地测试和优化工具,正如P1所指出的:"它试图想出不同的方式来表达同一件事,这样你就不必创建那个详尽的官方列表。"这表明,如果没有结构化指导,用户可能很难生成多样化和有意义的示例,限制了他们彻底评估AI输出的能力。此外,参与者一致认为,AIBAT自动生成各种陈述的能力显著降低了与手动创建测试案例相关的认知负担。正如P9所观察到的:"中学生写作的方式——它变化很大,很难捕捉所有可能性。就像他们可以说同样的事情的所有不同方式,你知道,甚至他们可以用逗号说同样的事情。"同样,P3指出"不必使用我的脑力来想出所有这些陈述。"总体而言,参与者强调,AIBAT系统地捕获语言变化的能力通过减少评分所需的手工工作同时仍允许教育工作者在评估AI行为时应用他们的专业知识,加强了人类-AI协作。

5.3 评估跨语言变化的AI评分以实现包容性和情境感知的评估

AIBAT中的语言变化功能为教育工作者提供了一种结构化的方式来评估跨不同语言表达的AI评分,允许对学生响应进行更细致的评估。我们的结果表明,语言变化可能作为将评分实践与教学目标对齐的参数。具体而言,它允许教育工作者确保当学生成功传达核心概念时,不会因语言使用的偏差而受到不公平的惩罚。正如P12所描述的,该功能使得在某些条件下调整AI评分为"宽容一点"成为可能,确保严格的语言规则不会掩盖学生对材料的理解。P4还强调了这一挑战,特别是对于在写作机制方面挣扎的学生:"如果学生真的在写作方面挣扎,我可以理解他们的阅读——或者他们的写作——并且知道他们掌握了主要思想…即使他们可能没有使用所有正确的词汇,他们可能根本没有使用正确的标点符号或任何标点符号。"此外,P3认识到基于学生技能水平的灵活评分标准的需求:"当你处理某些[学生的]年龄时,有一个更公平的竞争环境。但在中学,你知道,我有可能是三年级阅读和写作水平一直到像高中写作水平的中间水平的学生…我会在不同的年级水平有不同的评分标准。"这一观点突出了AI驱动评估中的一个关键挑战——在语言准确性与教学目标之间取得平衡。AIBAT通过语言变化的可扩展性使教师能够看到AI应用"更严格"或更"宽松"评分的地方,允许他们相应地调整决策。

5.4 通过可视化解释模型偏见以增强透明度和决策制定

我们的结果表明,用于评估和意义建构的行为可视化为用户提供了识别模型偏见的直观方式,促进意义建构并鼓励对AI决策过程的更深入反思。除了检测偏见之外,可视化还积极地让用户参与审议他们在解决系统性不一致方面的作用。正如P2所反思的:"该可视化让我思考——我是否需要与工具做更多工作以获得整个范围的一致性,还是…只是接受我不会跟踪西班牙语,例如,因为它已经做得很好了?"通过以易于理解的格式显示这些差异,AIBAT的可视化功能支持了对AI信任和监督的更细致的方法。此外,P4建议重组数据以优先考虑最大分歧的领域,建议将结果"从最少同意到最不同意"排序,这强调了结构化优先级排序的实际需求,使用户能够快速识别和解决有问题的分类,简化审计和决策过程。

6 讨论与未来方向

我们介绍了AIBAT,这是一个为教育中语言模型的教师驱动情境评估而设计的迭代工作流程和工具。与强调泛化性能和定量基准的传统模型评估方法不同,AIBAT将重点转向在教学情境和教学目标中情境化模型危害。

我们的思维出声研究发现突出了AIBAT的评估机制在培养用户自主权和对AI生成评估的信任方面的作用。参与者重视参与AI决策而不是被动接受它们的能力,将该过程描述为增强透明度和控制的"对话"。这种交互式方法使用户能够批判性地评估AI输出,强化了AI应该作为协作工具而不是不容质疑的权威的想法。此外,AIBAT的结构化评估框架,特别是评估语言变化的能力,实现了系统和有效的评分评估。通过自动生成多样化的学生响应,该工具在确保全面评估的同时减少了认知努力。参与者还强调了语言变化在评分公平性中的重要性,指出它有助于避免因语言差异而惩罚学生,同时使评估与教学目标保持一致。基于学生熟练程度水平调整AI评分标准的能力允许更包容和情境感知的评估。此外,模型行为的视觉表示提供了一种直观的方式来检测AI偏见,促进明智的决策制定并加强信任。一些参与者建议优先考虑最大分歧的领域以简化审计过程。总体而言,AIBAT的评估、语言灵活性和偏见可视化功能增强了人类-AI协作,提高了透明度、信任和可用性。

AIBAT还继承了我们已确定为未来迭代领域的局限性。一个挑战是扩展超越单句测试案例以支持情境感知的评估。目前,许多AI评估方法孤立地评估响应,这可能无法完全捕捉模型输出如何与更广泛的教学结构、话语模式和课程主题保持一致。另一个关键方向是深化AIBAT的交互式反馈机制。在其当前形式中,AIBAT使教育工作者能够对AI生成的响应进行建设性评估,但未来的工作可以加强其迭代反馈循环,允许教师不仅识别问题,还可以接收模型为什么产生特定响应的解释,并动态进行调整以改善与教学期望的一致性。

总之,我们认为当前的AI评估框架为教师根据其课程中强调的特定知识、技能和价值批判性评估AI模型提供的支持有限。AIBAT通过提供一个支架评估过程来解决这一差距,该过程使教师能够自定义评估主题,显示模型输出与教学期望不一致的关键示例,并参与更深入的意义建构。这种方法使教师成为AI开发的积极参与者,而不是将他们定位为被动采用者。

致谢. 这项工作得到了威斯康星大学麦迪逊分校研究和研究生教育副校长办公室的支持,资金来自威斯康星校友研究基金会。我们感谢Nora Tseng、Lucas Anderson、Pranav Poddutoori、Aditya Anand和Daryush Ghadiali。我们还感谢Dana Gnesdilow、Ananya Ganesh、Nate Smith、Kaycie Barron、Sandra Taylor-Marshall、Kiyo White以及所有思维出声参与者的宝贵反馈。

参考文献

- Vakil, S., McKinney de Royston, M.: Youth as philosophers of technology. Mind Cult. Act. 29(4), 336–355 (2022)

- Vygotsky, L.S.: Mind in Society: The Development of Higher Psychological Processes. Harvard University Press (1978)

- Karumbaiah, S., Ocumpaugh, J., Baker, R.S.: Context matters: differing implications of motivation and help-seeking in educational technology. Int. J. Artif. Intell. Educ. 1, 1–40 (2021)

- Bommasani, R., Liang, P., Lee, T.: Holistic evaluation of language models. Ann. N. Y. Acad. Sci. 1525(1), 140–146 (2023)

- Jacovi, A., Marasović, A., Miller, T., Goldberg, Y.: Formalizing trust in artificial intelligence: Prerequisites, causes, and goals of human trust in AI. In: Proceedings of the ACM Conference on Fairness, Accountability, and Transparency, pp. 624–635 (2021)

- Reiser, B.J.: Scaffolding complex learning: the mechanisms of structuring and problematizing student work. J. Learn. Sci. 13(3), 273–304 (2004)

- Holstein, K., Aleven, V., Rummel, N.: A conceptual framework for human-AI hybrid adaptivity in education. Artif. Intell. Educ. 12163, 240–254 (2020)

- Suresh, H., et al.: Kaleidoscope: semantically-grounded, context-specific ML model evaluation. ACM Hum. Factors Comput. Syst. 1, 1–13 (2023)

- Ribeiro, M.T., Wu, T., Guestrin, C., Singh, S.: Beyond accuracy: behavioral testing of NLP models with CheckList. arXiv preprint arXiv:2005.04118 (2020)

- Baker, R.S., Hawn, A.: Algorithmic bias in education. Int. J. Artif. Intell. Educ. 1, 1–41 (2021)

- Raji, D., Denton, E., Bender, E.M., Hanna, A., Paullada, A.: AI and the everything in the whole wide world benchmark. In: Neural Information Processing Systems (2021)

- Corbett, A.T., Anderson, J.R.: Knowledge tracing: modeling the acquisition of procedural knowledge. User Model. User-Adapt. Interact. 4, 253–278 (1994)

- D’Ignazio, C., Klein, L.F.: Data Feminism. MIT Press (2020)

- Dillenbourg, P.: The evolution of research on digital education. Int. J. Artif. Intell. Educ. 26, 544–560 (2016)

- Crenshaw, K.W.: On Intersectionality: Essential Writings. The New Press (2017)

- Puntambekar, S.: Distributed scaffolding: scaffolding students in classroom environments. Educ. Psychol. Rev. 34(1), 451–472 (2022)

- Quinonero-Candela, J., Sugiyama, M., Schwaighofer, A., Lawrence, N.D. (eds.): Dataset Shift in Machine Learning. MIT Press (2008)

- Schofield, J.W., Eurich-Fulcer, R., Britt, C.L.: Teachers, computer tutors, and teaching: the artificially intelligent tutor as an agent for classroom change. Am. Educ. Res. J. 31(3), 579–607 (1994)

- van de Pol, J., Volman, M., Oort, F., Beishuizen, J.: Teacher scaffolding in small-group work: an intervention study. J. Learn. Sci. 23(4), 600–650 (2014)

- Recht, B., Roelofs, R., Schmidt, L., Shankar, V.: Do ImageNet classifiers generalize to ImageNet? In: International Conference on Machine Learning, pp. 5389–5400. PMLR (2019)

- Engelbart, D.C., English, W.K.: A research center for augmenting human intellect. In: Proceedings of the 9–11 December 1968 Fall Joint Computer Conference, Part I, pp. 395–410 (1968)

- Tabak, I.: Synergy: a complement to emerging patterns of distributed scaffolding. J. Learn. Sci. 13(3), 305–335 (2004)

- Koedinger, K.R., Corbett, A.T.: Cognitive Tutors: Technology bringing learning science to the classroom. In: Sawyer, K. (ed.) The Cambridge Handbook of the Learning Sciences, pp. 61–78. Cambridge University Press (2006)

- Karumbaiah, S., et al.: A spatiotemporal analysis of teacher practices in supporting student learning and engagement in an AI-enabled classroom. Artif. Intell. Educ. 450, 450–462 (2023)

- Blodgett, S.L., Barocas, S., Daumé III, H., Wallach, H.: Language (technology) is power: a critical survey of “bias” in NLP. arXiv preprint arXiv:2005.14050 (2020)

- Shneiderman, B.: Human-Centered AI. Oxford University Press (2022)

- Rajani, N., Liang, W., Chen, L., Mitchell, M., Zou, J.: SEAL: interactive tool for systematic error analysis and labeling. arXiv preprint arXiv:2210.05839 (2022)

- Birhane, A.: Algorithmic injustice: a relational ethics approach. Patterns 2(2), 100205 (2021)

- Patel, K., Fogarty, J., Landay, J.A., Harrison, B.: Investigating statistical machine learning as a tool for software development. In: Proceedings of the SIGCHI Conference on Human Factors in Computing Systems, pp. 667–676. ACM, New York (2008)

- Pea, R.D.: The social and technological dimensions of scaffolding and related theoretical concepts for learning, education, and human activity. J. Learn. Sci. 13(3), 423–451 (2004)

- Martin, N.D., Tissenbaum, C.D., Gnesdilow, D., Puntambekar, S.: Fading distributed scaffolds: the importance of complementarity between teacher and material scaffolds. Instr. Sci. 47(1), 69–98 (2019)

- Paquette, L., Ocumpaugh, J., Li, Z., Andres, A., Baker, R.: Who’s learning? Using demographics in EDM research. J. Educ. Data Min. 12(3), 1–30 (2020)

- Kozulin, A.: Psychological tools and mediated learning. In: Kozulin, A., Gindis, B., Ageyev, V.S., Miller, S.M. (eds.) Vygotsky’s Educational Theory in Cultural Context, pp. 15–38. Cambridge University Press (2003)

更多推荐

已为社区贡献78条内容

已为社区贡献78条内容

所有评论(0)