豆包本地文件问答下线后的打开方法

虽然官方提示2025 年 12 月 31 日功能下线本地模型能力还在本地文件问答还能通过隐藏入口访问离线 + 隐私 + 高性能的优势依然存在对我来说,这更像是一个“被藏起来的功能”。如果你平时也有本地 AI 问答、离线处理资料的需求,不妨试试这个方式,在真正下线之前,把它用到极致。

豆包本地文件问答下线后的打开方法

关键词:豆包本地文件问答、豆包离线问答、本地知识库、doubao 本地模型、RTX AI PC、本地 AI 问答

一次“功能下线”带来的意外发现

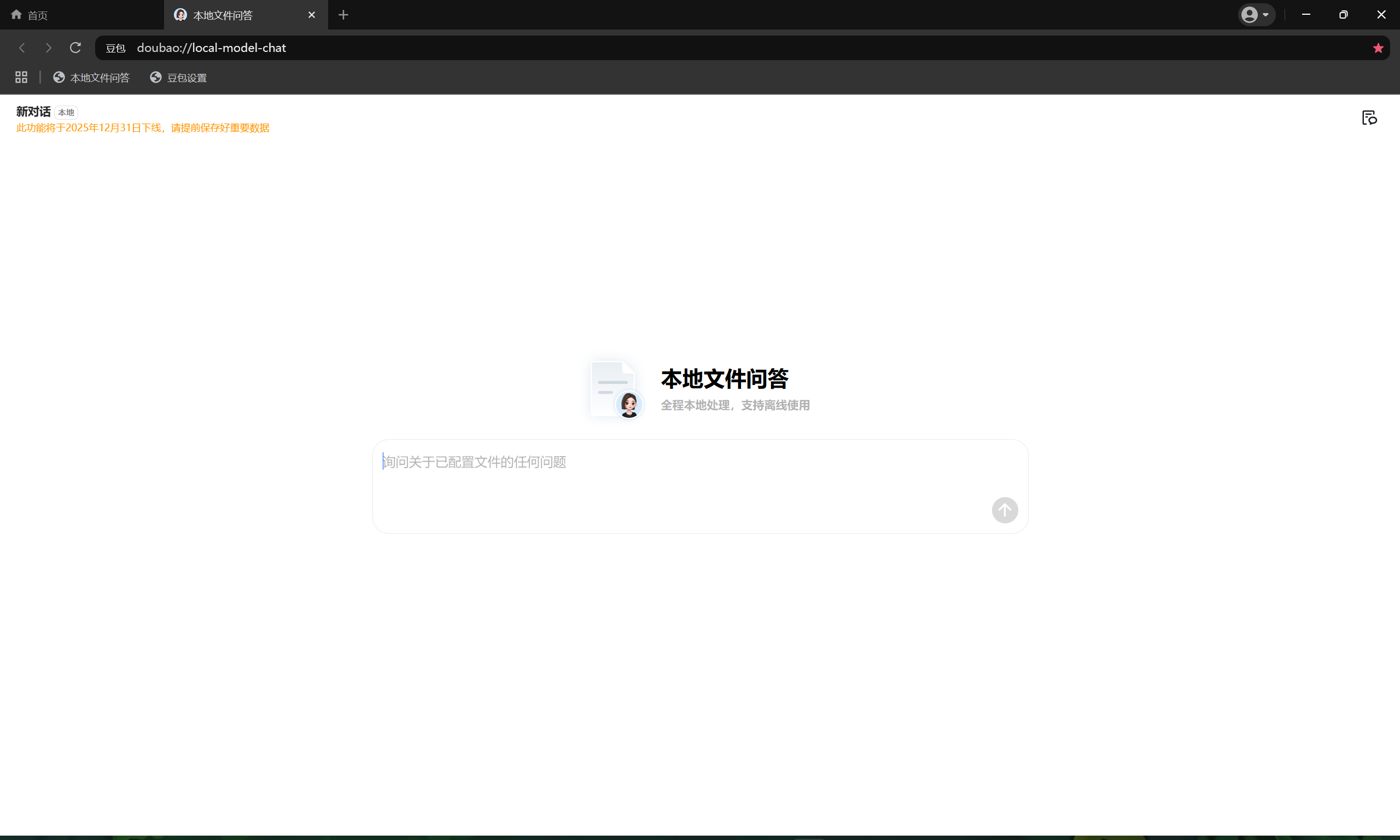

前段时间在整理本地资料的时候,我发现豆包的「本地文件问答」功能页面多了一个提示:

该功能将于 2025 年 12 月 31 日下线

说实话,这个功能我用得并不算少。

本地文档、技术资料、项目说明书,全部丢进去,断网也能直接问,不用担心隐私外传,用起来非常安心。

一开始我也以为,下线就真的“没了”。

但在一次无意中调试 URI 的过程中,我发现事情并没有那么简单。

豆包本地文件问答,真的彻底不能用了吗?

结论先不急着下。

先简单回顾一下这个功能本身👇

它原本是做什么的?

豆包本地文件问答,本质上是一个:

- 全程本地运行

- 支持离线使用

- 可指定本地文件构建专属知识库

- 基于本地大模型推理

- 由 NVIDIA RTX 提供算力加速

的本地 AI 问答能力。

也就是说:

- 文件不上传

- 对话不上传

- 推理不走云端

- 数据始终在你自己的电脑里

这点对做开发、写方案、处理敏感资料的人来说,非常关键。

核心能力到底还在不在?

在多次尝试后,我发现:

入口被“隐藏”了,但能力并没有被彻底移除

豆包内部其实仍然保留了一个本地模型问答页面。

关键在于——如何打开它。

关键入口:doubao://local-model-chat/

重点来了。

在系统支持的情况下,可以直接通过下面这个 URI 打开本地问答页面:

doubao://local-model-chat/

使用方式很简单

- 确保已安装豆包客户端

- 在浏览器地址栏 / 运行窗口中输入

doubao://local-model-chat/ - 回车确认

- 系统会自动唤起豆包,并进入本地模型问答页面

进入之后,你会发现:

- 熟悉的本地问答界面

- 支持加载本地文件

- 可基于本地资料进行提问和总结

体验和原来的本地文件问答基本一致。

为什么这个方式还能用?

从技术角度看,其实不难理解。

-

功能“下线”更多是产品层面的入口收敛

-

本地模型推理能力仍然依赖于:

- 本地大语言模型

- GPU 推理能力

- 客户端内部模块

只要这些模块还存在,本地问答能力就不会立刻消失。

借助 NVIDIA RTX AI PC 的本地优势

这个功能能顺畅运行,一个很重要的前提是:

RTX 本地加速

在 NVIDIA GeForce RTX AI PC 上,本地问答有几个非常明显的优势:

1️⃣ 高效

- 推理延迟低

- 响应快至毫秒级

- 万字文档也能快速梳理、总结

2️⃣ 安全

- 文件不出本地

- 对话不走云端

- 全流程隐私闭环处理

对隐私敏感的数据尤其友好

3️⃣ 可离线

- 断网依旧可用

- 不依赖云服务

- 出差、会议、内网环境都能直接跑

这一点,是很多云端 AI 工具做不到的。

适合哪些使用场景?

结合我自己的使用习惯,下面这些场景尤其合适:

- 📄 技术文档 / API 文档快速问答

- 🧠 本地知识库整理

- 📚 学习资料总结

- 🔒 涉及隐私或敏感信息的内容分析

- 🚫 无法联网或不方便联网的环境

如果你手上有 RTX 显卡,这个能力其实被严重低估了。

写在最后

虽然官方提示2025 年 12 月 31 日功能下线,

但至少在目前阶段:

- 本地模型能力还在

- 本地文件问答还能通过隐藏入口访问

- 离线 + 隐私 + 高性能的优势依然存在

对我来说,这更像是一个“被藏起来的功能”。

如果你平时也有本地 AI 问答、离线处理资料的需求,不妨试试这个方式,在真正下线之前,把它用到极致。

更多推荐

已为社区贡献26条内容

已为社区贡献26条内容

所有评论(0)