周六上午10点!和SAPO一作聊聊大模型 RL 算法演进

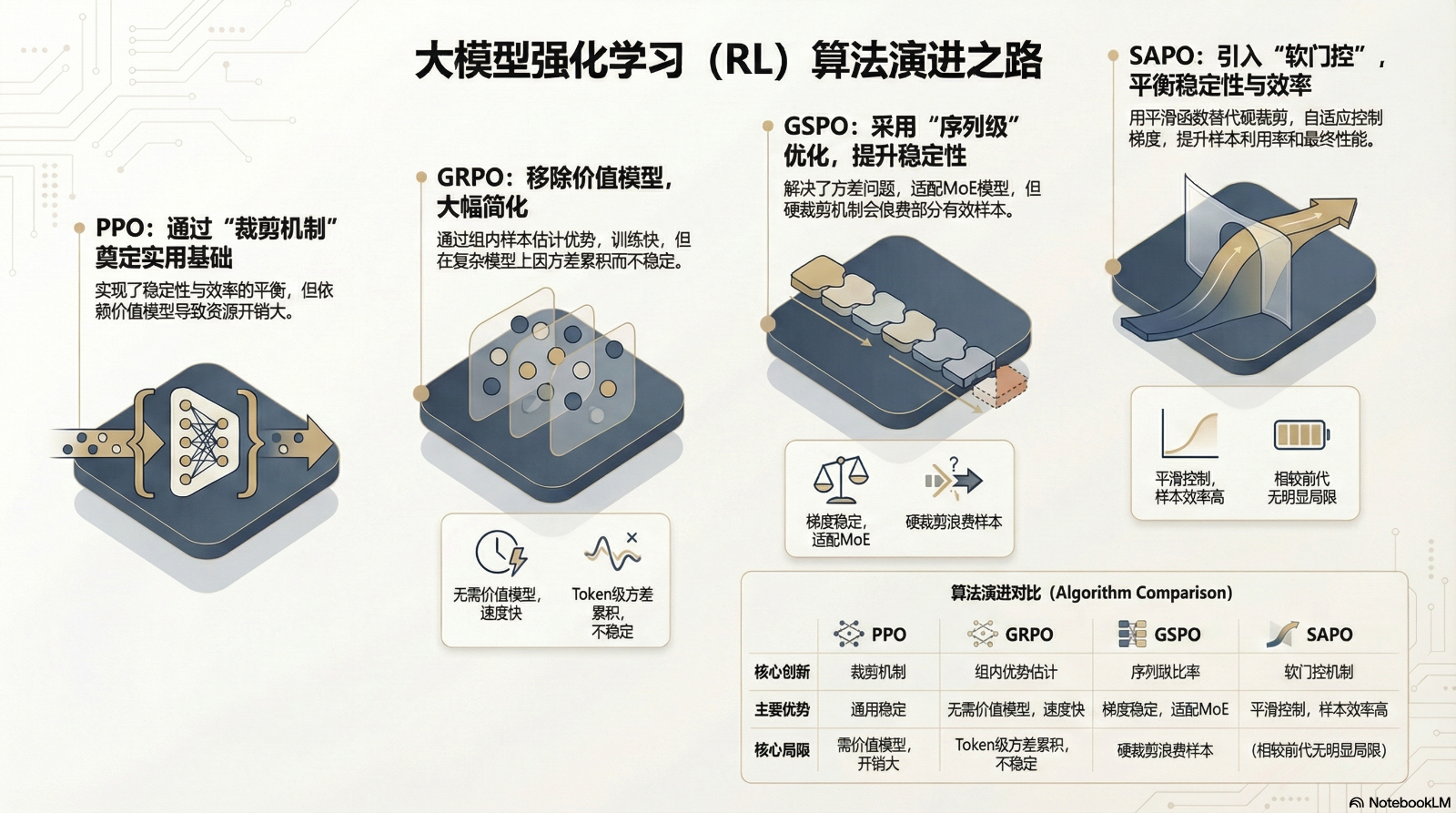

摘要:本文系统梳理了大模型强化学习(RL)算法的演进历程,从理论基石TRPO到实用算法PPO、GRPO、GSPO,再到最新融合创新算法SAPO。TRPO奠定了KL散度约束的理论基础,PPO通过裁剪机制实现平衡优化,GRPO创新性地舍弃价值模型,GSPO提升至序列级优化解决稳定性问题。SAPO则通过软门控机制和自适应温度控制,在保持稳定性的同时提升样本效率。1月10日青稞Talk第102期将邀请通义

青稞社区:https://qingkeai.online/

原文:https://mp.weixin.qq.com/s/kBjKxx0IfP3DNrgHFwrHlA

引言

在大模型后训练阶段,强化学习(Reinforcement Learning, RL)已成为提升模型性能的关键技术。从早期的PPO到最新的SAPO,算法演进始终围绕训练稳定性、样本效率和计算开销三大核心挑战展开。

1 理论基石:TRPO与策略优化基础

1.1 TRPO的核心思想

信任域策略优化(Trust Region Policy Optimization, TRPO)为现代大模型RL算法奠定了理论基础。其核心思想是通过KL散度约束控制策略更新步长,确保新策略与旧策略的差异不超过信任域范围,从而避免策略突变导致的训练崩溃。TRPO的数学形式化表示为:

max θ E s , a ∼ π θ o l d [ π θ ( a ∣ s ) π θ o l d ( a ∣ s ) A θ o l d ( s , a ) ] \max_{\theta} \mathbb{E}_{s,a \sim \pi_{\theta_{old}}} \left[ \frac{\pi_{\theta}(a|s)}{\pi_{\theta_{old}}(a|s)} A_{\theta_{old}}(s,a) \right] θmaxEs,a∼πθold[πθold(a∣s)πθ(a∣s)Aθold(s,a)]

subject to E s ∼ π θ o l d [ D K L ( π θ o l d ( ⋅ ∣ s ) ∥ π θ ( ⋅ ∣ s ) ) ] ≤ δ \text{subject to } \mathbb{E}_{s \sim \pi_{\theta_{old}}} [D_{KL}(\pi_{\theta_{old}}(\cdot|s) \parallel \pi_{\theta}(\cdot|s))] \leq \delta subject to Es∼πθold[DKL(πθold(⋅∣s)∥πθ(⋅∣s))]≤δ

其中 D K L D_{KL} DKL 表示KL散度, δ \delta δ 是信任域半径。该约束保证了策略更新的单调改进性,但计算复杂度较高(需处理二阶导数),难以直接应用于大规模模型。

1.2 重要性采样机制

TRPO和后续算法均依赖重要性采样(Importance Sampling)技术,允许使用旧策略采集的样本估计新策略的梯度。其核心公式为:

E a ∼ π θ [ f ( a ) ] = E a ∼ π θ o l d [ π θ ( a ∣ s ) π θ o l d ( a ∣ s ) f ( a ) ] \mathbb{E}_{a \sim \pi_{\theta}}[f(a)] = \mathbb{E}_{a \sim \pi_{\theta_{old}}}\left[ \frac{\pi_{\theta}(a|s)}{\pi_{\theta_{old}}(a|s)} f(a) \right] Ea∼πθ[f(a)]=Ea∼πθold[πθold(a∣s)πθ(a∣s)f(a)]

这一机制使得策略更新可复用历史数据,但需保持新旧策略分布接近,否则梯度估计将出现显著偏差。

2 实用近似算法:PPO、GRPO与GSPO

2.1 PPO:平衡效率与稳定性的开创性工作

近端策略优化(Proximal Policy Optimization, PPO)通过裁剪机制(Clipping)简化TRPO的约束优化问题,成为首个大模型RL广泛应用的算法。其目标函数设计如下:

L C L I P ( θ ) = E t [ min ( r t ( θ ) A t , clip ( r t ( θ ) , 1 − ϵ , 1 + ϵ ) A t ) ] L^{CLIP}(\theta) = \mathbb{E}_t \left[ \min\left( r_t(\theta) A_t, \text{clip}(r_t(\theta), 1-\epsilon, 1+\epsilon) A_t \right) \right] LCLIP(θ)=Et[min(rt(θ)At,clip(rt(θ),1−ϵ,1+ϵ)At)]

其中 r t ( θ ) = π θ ( a t ∣ s t ) π θ o l d ( a t ∣ s t ) r_t(\theta) = \frac{\pi_\theta(a_t|s_t)}{\pi_{\theta_{old}}(a_t|s_t)} rt(θ)=πθold(at∣st)πθ(at∣st) 为重要性比率, A t A_t At 为优势函数, ϵ \epsilon ϵ 是裁剪阈值(通常设为0.2)。PPO的训练流程包含六个关键步骤:

- 轨迹采样:使用当前策略生成响应;

- 奖励计算:通过奖励模型计算序列级奖励;

- 价值估计:价值模型预测每个token的期望收益;

- 优势计算:GAE算法分配token级优势;

- 价值模型更新;

- 策略模型更新。

PPO的主要局限性在于需同时训练价值模型,带来额外计算与内存开销,且价值模型的不稳定性会直接影响策略训练。

2.2 GRPO:去除价值模型的简化范式

组相对策略优化(Group Relative Policy Optimization, GRPO)由DeepSeek团队提出,核心创新是舍弃价值模型,直接通过样本组统计估计优势函数。对于同一提示(prompt)采样G条响应,其优势计算为:

A ^ i = r i − μ r σ r \hat{A}_i = \frac{r_i - \mu_r}{\sigma_r} A^i=σrri−μr

其中 μ r \mu_r μr 和 σ r \sigma_r σr 分别是组内奖励的均值和标准差。该设计充分利用奖励模型的相对性本质,显著降低资源消耗。GRPO的目标函数保留PPO的裁剪机制,但增加KL散度项防止奖励黑客行为(reward hacking):

L G R P O ( θ ) = E t [ min ( r t ( θ ) A ^ t , clip ( r t ( θ ) , 1 − ϵ , 1 + ϵ ) A ^ t ) ] + β D K L ( π θ ∥ π ref ) L^{GRPO}(\theta) = \mathbb{E}_t \left[ \min\left( r_t(\theta) \hat{A}_t, \text{clip}(r_t(\theta), 1-\epsilon, 1+\epsilon) \hat{A}_t \right) \right] + \beta D_{KL}(\pi_{\theta} \parallel \pi_{\text{ref}}) LGRPO(θ)=Et[min(rt(θ)A^t,clip(rt(θ),1−ϵ,1+ϵ)A^t)]+βDKL(πθ∥πref)

GRPO在中小规模模型中表现优异,但在长序列或MoE模型中易出现重要性权重方差累积问题,导致训练不稳定。

2.3 GSPO:序列级优化的稳定性突破

组序列策略优化(Group Sequence Policy Optimization, GSPO)由Qwen团队提出,核心贡献是将优化粒度从token级提升至序列级,解决GRPO的方差问题。其重要性比率定义为序列似然比:

s i ( θ ) = exp ( 1 T ∑ t = 1 T log π θ ( y i t ∣ x , y i < t ) π θ old ( y i t ∣ x , y i < t ) ) s_i(\theta) = \exp\left( \frac{1}{T} \sum_{t=1}^{T} \log \frac{\pi_{\theta}(y_i^t \mid x, y_i^{<t})}{\pi_{\theta_{\text{old}}}(y_i^t \mid x, y_i^{<t})} \right) si(θ)=exp(T1t=1∑Tlogπθold(yit∣x,yi<t)πθ(yit∣x,yi<t))

目标函数相应调整为:

L G S P O ( θ ) = E t [ min ( s i ( θ ) A ^ i , clip ( s i ( θ ) , 1 − ϵ , 1 + ϵ ) A ^ i ) ] L^{GSPO}(\theta) = \mathbb{E}_t \left[ \min\left( s_i(\theta) \hat{A}_i, \text{clip}(s_i(\theta), 1-\epsilon, 1+\epsilon) \hat{A}_i \right) \right] LGSPO(θ)=Et[min(si(θ)A^i,clip(si(θ),1−ϵ,1+ϵ)A^i)]

GSPO的优势包括:

- 梯度方向稳定性:序列级比率仅影响梯度强度,不扭曲方向;

- 长度归一化:避免长序列权重偏差;

- MoE适配性:对token级路由变化不敏感。

实验表明,GSPO在Qwen3-30B等MoE模型上训练稳定性显著优于GRPO。

2.4 算法对比概览

| 算法 | 核心创新 | 优势 | 局限性 |

|---|---|---|---|

| PPO | 裁剪机制约束更新幅度 | 基础稳定,适配通用场景 | 需价值模型,资源开销大 |

| GRPO | 组内经验优势估计 | 无需价值模型,训练速度快 | Token级方差累积,MoE不稳定 |

| GSPO | 序列级重要性比率 | 梯度稳定,适配MoE模型 | 硬裁剪浪费有效样本 |

3 融合与创新:SAPO解析

论文:Soft Adaptive Policy Optimization

链接:https://arxiv.org/abs/2511.20347

3.1 SAPO的设计哲学

软自适应策略优化(Soft Adaptive Policy Optimization, SAPO)是阿里云在GSPO基础上的进一步创新,旨在通过软门控机制平衡稳定性与样本效率。其核心洞察是:GSPO的硬裁剪机制对异策略样本采取“非黑即白”处理,导致部分有效学习信号丢失。

3.2 软门控与自适应温度控制

SAPO用连续的Sigmoid门控函数替代硬裁剪,实现梯度平滑衰减。其目标函数定义为:

L S A P O ( θ ) = E t [ f i , t S A P O ⋅ A ^ t ] L^{SAPO}(\theta) = \mathbb{E}_t \left[ f_{i,t}^{SAPO} \cdot \hat{A}_t \right] LSAPO(θ)=Et[fi,tSAPO⋅A^t]

其中软门控函数为:

f i , t S A P O = 4 τ i ⋅ σ ( τ i ⋅ ( r i , t ( θ ) − 1 ) ) f_{i,t}^{SAPO} = 4\tau_i \cdot \sigma\left( \tau_i \cdot (r_{i,t}(\theta) - 1) \right) fi,tSAPO=4τi⋅σ(τi⋅(ri,t(θ)−1))

σ \sigma σ 为Sigmoid函数, τ i \tau_i τi 为温度参数。关键创新在于正负优势非对称温度控制:

τ i = { τ p o s if A ^ i ≥ 0 τ n e g if A ^ i < 0 \tau_i = \begin{cases} \tau_{pos} & \text{if } \hat{A}_i \geq 0 \\ \tau_{neg} & \text{if } \hat{A}_i < 0 \end{cases} τi={τposτnegif A^i≥0if A^i<0

通常设置 τ n e g > τ p o s \tau_{neg} > \tau_{pos} τneg>τpos,使负优势样本的梯度衰减更快,抑制其对训练的干扰。

3.3 双特性兼顾机制

SAPO兼具序列一致性与token自适应性:

在满足小步更新( r i , t ( θ ) ≈ 1 r_{i,t}(\theta) \approx 1 ri,t(θ)≈1)和序列内低离散性条件下,SAPO退化为平滑版GSPO;

当条件不满足时,自动切换至token级优化模式,保留GRPO的灵活性。

这种设计使其在复杂任务(如数学推理)中表现优异,在Qwen3-VL等多模态模型训练中实现稳定提升。

3.4 与其他改进算法的对比

BAPO:通过动态调整裁剪边界平衡正负样本贡献,但仍依赖硬裁剪;

DeepSeek-V3.2:采用序列掩码过滤低概率负样本,避免过度惩罚;

SAPO优势:软门控提供连续控制,无需手动阈值调优。

1月10日(周六)上午10点,青稞社区和减论平台将联合组织青稞Talk 第102期,SAPO 一作、通义千问算法工程师高畅,将直播分享《从 TRPO 到 SAPO:大模型 RL 算法演进》。

分享嘉宾

高畅,通义千问算法工程师,博士毕业于香港中文大学。Qwen3、Qwen3-VL系列模型核心贡献者。研究方向为LLM RL,在NeurIPS、ACL、EMNLP等会议上发表多篇论文。

主题提纲

从 TRPO 到 SAPO:大模型 RL 算法演进

1、理论基石 TRPO

2、实用近似算法:PPO、GRPO和GSPO

3、融合与创新:SAPO 解析

4、AMA (Ask Me Anything)环节

直播时间

1月10日(周六)10:00 - 11:00

如何观看

Talk 将在青稞社区【视频号:青稞AI、Bilibili:青稞AI】上进行直播,欢迎观看~

Bilibili 直播间:

https://live.bilibili.com/32145701

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)