Qwen-Image-2512-Turbo-LoRA:20倍提速AI图像生成的终极指南

Qwen-Image-2512-Turbo-LoRA实现20倍AI图像生成速度突破。这款基于Qwen-Image-2512模型的LoRA适配器仅需4-8步推理即可生成高质量图像,5秒可输出4张2K分辨率作品。相比传统40步模型,其通过CFG蒸馏技术大幅提升效率,同时保持细节质量。最佳表现分辨率1328x1328,兼容ComfyUI和DiffSynth-Engine框架。2026年发布的V2.0版本

AI 图像生成领域正经历一场速度革命。虽然传统的文本生成图像模型通常需要 30-40 个推理步骤才能生成一张高质量图像,但 Qwen-Image-2512-Turbo-LoRA 仅需 4-8 步即可达到相同质量——实现了惊人的 20 倍速度提升。这一突破意味着您可以在大约 5 秒内生成 4 张 2K 分辨率的图像,从而彻底改变创作者、设计师和开发者的工作流程。

在这份综合指南中,我们将探讨您需要了解的关于 Qwen-Image-2512-Turbo-LoRA 的一切:它是什么,它与 Lightning LoRA v1 等替代方案相比如何,如何设置以及如何针对专业用途进行优化。无论您是经验丰富的 AI 艺术家还是初学者,都能找到实用的见解和可操作的技巧来驾驭这一强大的模型。您可以在 zimage.run 上直接试用 Qwen-Image-2512-Turbo-LoRA,无需任何设置。

什么是 Qwen-Image-2512-Turbo-LoRA?

Qwen-Image-2512-Turbo-LoRA 是由 Wuli 团队为 Qwen-Image-2512 文生图模型开发的高性能 LoRA(低秩自适应)适配器。该模型于 2025 年 12 月 31 日发布,随后于 2026 年 1 月 2 日推出了改进的 V2.0 版本,代表了高效 AI 图像生成的重大进步。

技术概览

LoRA(低秩自适应)是一种允许以最小的计算开销微调大型 AI 模型的技术。LoRA 不会重新训练整个模型,而是引入小的、可训练的权重矩阵来修改模型的行为。这种方法带来了以下优势:

- 文件更小:LoRA 适配器通常只有几百兆字节,而完整模型则高达数千兆字节。

- 训练更快:微调可以在几分钟内完成,而不是几小时。

- 易于分享:紧凑的体积使得分发和实验更加容易。

- 可叠加修改:可以组合多个 LoRA 以实现复杂的效果。

Qwen-Image-2512-Turbo-LoRA 专门通过 CFG 蒸馏(CFG-distillation) 技术优化了基础 Qwen-Image-2512 模型,消除了推理过程中对无分类器引导(classifier-free guidance)的需求。

主要特性与能力

性能指标:

- 与原始 Qwen-Image-2512 模型相比,生成速度提高 20 倍

- 4 或 8 步推理(基础模型为 40 步)

- 约 5 秒 即可生成 4 张 2K 分辨率图像

- 仅 CFG 蒸馏就带来了 2 倍加速

- 减少推理步骤带来了额外的加速

质量特征:

- 保持与原始 40 步模型相当的输出质量

- 支持高达 2512x2512 像素(2K)的分辨率

- 在 1328x1328 分辨率下性能最佳

- 兼容 ComfyUI 工作流

- 适用于 DiffSynth-Engine 框架

版本历史:

- **V1.0 (2025年12月31日)**:初始版本,兼容 ComfyUI,速度提升 20 倍。

- **V2.0 (2026年1月2日)**:增强了图像颜色准确性和更精细的细节渲染。

基础模型:Qwen-Image-2512

要了解 Turbo-LoRA 的能力,了解其构建基础非常重要。Qwen-Image-2512 于 2025 年 12 月下旬发布,被公认为最强的开源图像生成模型之一,在 AI Arena 上赢得了超过 10,000 轮盲测对比。

Qwen-Image-2512 的主要改进包括:

- 增强的真实感:大幅减少了“AI 生成感”,尤其是对于人物主体,具有改进的皮肤纹理和面部细节。

- 卓越的文本渲染:在字母和表意文字(包括中文)脚本中实现高保真文本生成,具有智能布局和对角线对齐功能。

- 更精细的自然细节:更好地渲染风景、纹理和高频细节,且没有噪点伪影。

- 稳定的 LoRA 训练:与之前的版本相比,训练过程更加一致,使得创建自定义适配器更加容易。

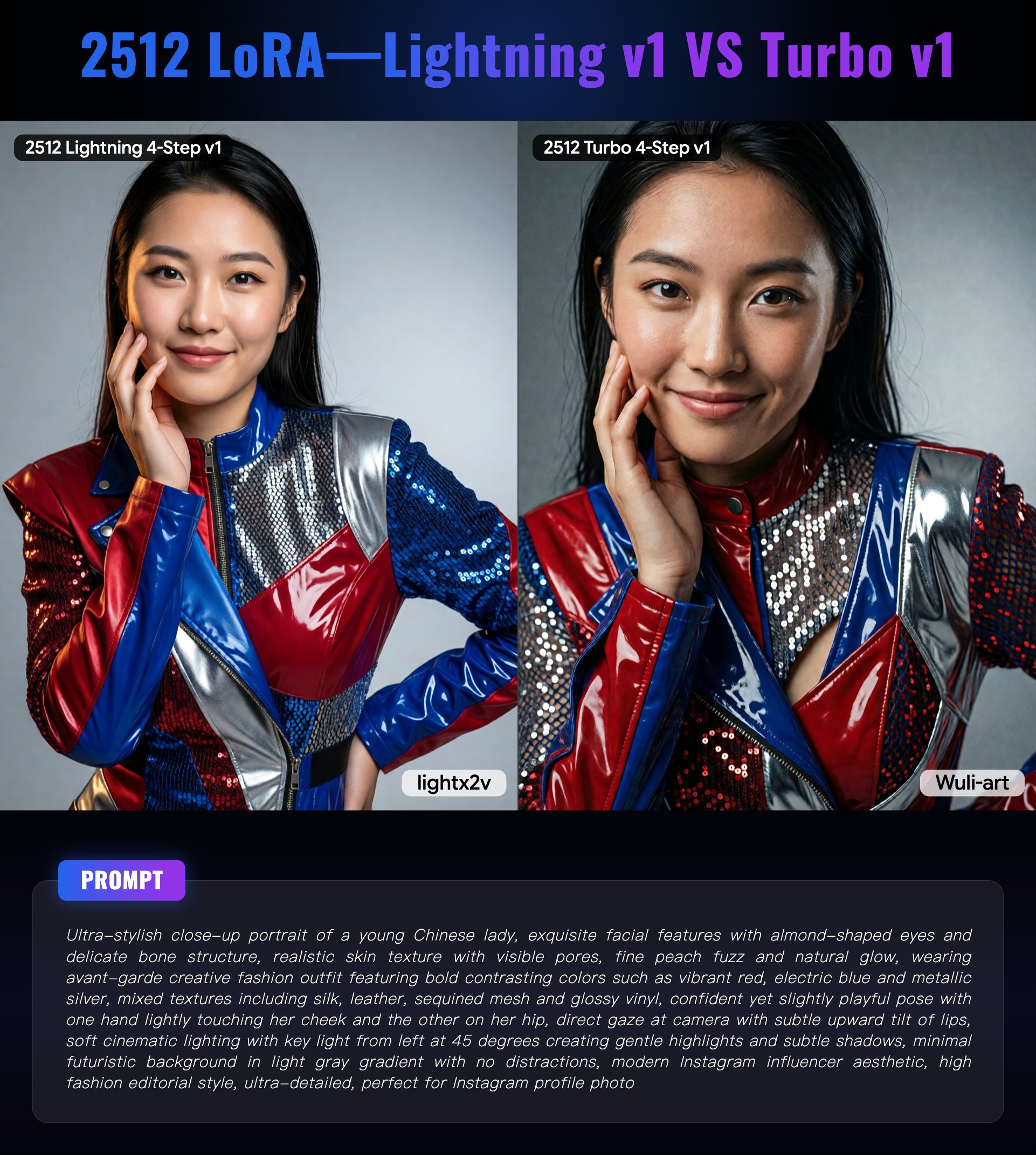

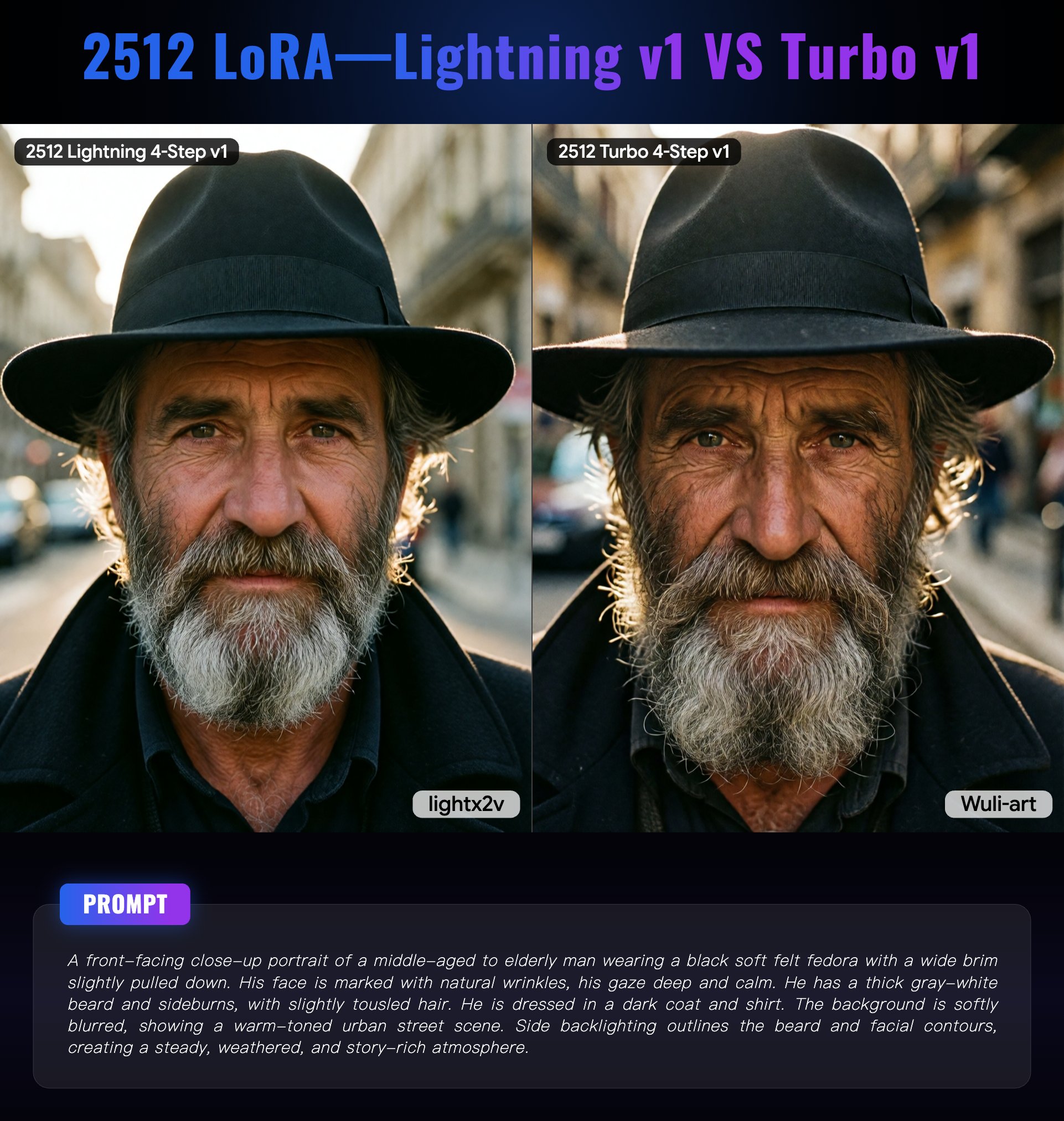

Qwen-Image-2512-Turbo-LoRA vs Lightning LoRA v1

在为 Qwen-Image-2512 选择快速推理 LoRA 时,您可能会遇到两个主要选项:Turbo-LoRA(由 Wuli-art 开发)和 Lightning LoRA v1(由 LightX2V 开发)。两者都旨在加速图像生成,但采取了不同的方法并各有取舍。

Lightning LoRA v1 专门针对 FP8 基础模型进行了优化,专注于在减少推理步骤的同时保持高保真度。它保留了原始模型约 90% 的质量,并在 4 步或 8 步推理下表现良好。Lightning 方法强调速度和质量的平衡,特别擅长宏观细节和自然皮肤纹理。它还设计用于与其他 LoRA 顺畅协作,使其在复杂工作流中具有多功能性。

Turbo-LoRA V1.0 最初优先考虑纯粹的速度,通过激进的 CFG 蒸馏实现了惊人的 20 倍加速。然而,早期版本(V1.0)因在某些场景中过度夸大对比度和产生伪影而受到批评。V2.0 版本通过改进颜色准确性和细节渲染解决了这些问题,使其更接近 Lightning LoRA 的质量标准。

您应该选择哪一个? 对于大多数用户而言,Turbo-LoRA V2.0 提供了速度和质量的最佳平衡,特别是如果您正在使用最新的 Qwen-Image-2512 模型。如果您需要与其他 LoRA 的最大兼容性,或者倾向于稍微保守一点的质量保留,请选择 Lightning LoRA v1。两者都是极佳的选择,差异足够细微,您的具体用例和工作流偏好应指导您的决定。

开始使用 Qwen-Image-2512-Turbo-LoRA

设置 Qwen-Image-2512-Turbo-LoRA 需要一些先决条件和基本配置。对于那些喜欢更简单方法的人,zimage.run 提供了访问此模型的便捷途径,通过用户友好的界面即可使用,无需任何设置。

先决条件

在开始之前,请确保您拥有:

- 系统中安装了 Python 3.8 或更高版本

- CUDA 兼容的 GPU,显存至少 8GB(建议 12GB+ 以获得最佳性能)

- 安装了 DiffSynth-Engine 框架

- 熟悉 Python 和命令行操作

安装指南

第 1 步:安装 DiffSynth-Engine

pip install diffsynth-engine 第 2 步:下载所需模型

设置需要三个组件:

- 基础 Qwen-Image-2512 Transformer 模型

- 文本编码器 (Text Encoder)

- VAE (变分自编码器)

- Turbo-LoRA 权重文件

第 3 步:基本使用示例

以下是生成第一张图像的完整示例:

import math from diffsynth_engine import fetch_model, QwenImagePipeline, QwenImagePipelineConfig # 创建管道配置 config = QwenImagePipelineConfig.basic_config( model_path=fetch_model("Qwen/Qwen-Image-2512", path="transformer/*.safetensors"), encoder_path=fetch_model("Qwen/Qwen-Image-2512", path="text_encoder/*.safetensors"), vae_path=fetch_model("Qwen/Qwen-Image-2512", path="vae/*.safetensors"), offload_mode="cpu_offload", ) # 初始化管道 pipe = QwenImagePipeline.from_pretrained(config) # 加载 Turbo-LoRA pipe.load_lora( path=fetch_model("Wuli-Art/Qwen-Image-2512-Turbo-LoRA", path="Wuli-Qwen-Image-2512-Turbo-LoRA-4steps-V2.0-bf16.safetensors"), scale=1.0, fused=True, ) # 配置调度器以获得最佳性能 scheduler_config = { "exponential_shift_mu": math.log(2.5), "use_dynamic_shifting": True, "shift_terminal": None } pipe.apply_scheduler_config(scheduler_config) # 生成图像 output = pipe( prompt="a young girl with flowing long hair, wearing a white halter dress, standing in a sunlit garden", cfg_scale=1, num_inference_steps=4, # 使用 4 或 8 步 seed=42, width=1328, height=1328 ) # 保存结果 output.save("output.png") 配置参数

了解关键参数有助于优化生成:

- cfg_scale:使用 Turbo-LoRA 时设置为 1(CFG 蒸馏消除了对更高值的需求)。

- num_inference_steps:使用 4 以获得最大速度,或使用 8 以获得稍好的质量。

- width/height:1328x1328 是最佳分辨率;其他分辨率可能会导致伪影。

- scale:LoRA 强度(默认为 1.0,可在 0.5-1.5 之间调整以进行微调)。

- seed:设置特定值以获得可复现的结果。

高级技巧与优化

一旦熟悉了基本生成,这些高级技巧将帮助您充分利用 Qwen-Image-2512-Turbo-LoRA。

推理步骤优化:4 步 vs 8 步

4 步和 8 步推理之间的选择代表了基本的速度与质量的权衡:

4 步推理:

- 速度最快(每张图像约 1.25 秒)

- 适合快速迭代和概念探索

- 最适合简单的构图和主体

- 在复杂细节上可能会显示出轻微的质量下降

8 步推理:

- 更好的细节保留,更加平衡

- 推荐用于最终生产工作

- 更可靠地处理复杂场景和精细纹理

- 仍然比原始的 40 步过程快得多

建议: 在创意探索阶段从 4 步开始,然后切换到 8 步进行最终渲染。

分辨率设置与最佳实践

Qwen-Image-2512-Turbo-LoRA 的最佳分辨率是 1328x1328 像素。这是模型训练时的分辨率,偏离此分辨率可能会导致问题:

- 使用 1328x1328:最佳质量,无伪影,生成稳定。

- 其他分辨率:可能会产生肢体畸形(例如多余的肢体)、网格伪影或平滑渐变中的条带。

- 自定义尺寸:如果必须使用不同的尺寸,请保持接近训练分辨率并保持相似的宽高比。

如果您需要不同的宽高比,建议在 1328x1328 下生成,然后进行裁剪或使用 AI 放大工具进行最终输出。

LoRA 权重调整

scale 参数控制 Turbo-LoRA 对输出的影响强度:

- scale=1.0:默认强度,推荐用于大多数情况。

- scale=0.7-0.9:效果略微减弱,如果您发现过度处理,这很有用。

- scale=1.1-1.5:效果更强,但可能会引入伪影。

尝试在 0.8 到 1.2 之间进行实验,以找到适合特定提示词和主体的最佳点。

与其他 LoRA 结合

虽然 Turbo-LoRA 本身表现良好,但您可以将其与风格或特定主体的 LoRA 结合以获得独特效果。但是,请注意:

- 当同时叠加 2-3 个 LoRA 时,质量可能会下降。

- 在进行大批量生成之前,仔细测试组合。

- 结合多个 LoRA 时,降低单个的 scale(例如,每个设为 0.7)。

- 如果您需要 LoRA 叠加功能,Lightning LoRA v1 通常表现更好。

如果您正在尝试多个 LoRA,Z-Image 允许您通过直观的界面轻松尝试不同的参数。

实际应用

Qwen-Image-2512-Turbo-LoRA 的速度优势为各种创意和专业工作流开辟了新的可能性。

专业用例

设计师的快速原型设计: 在几分钟而不是几小时内生成数十种概念变体。这对于需要快速探索多个视觉方向的客户演示非常有价值。

大规模内容创作: 社交媒体经理和内容创作者可以在一次会话中为多个帖子制作高质量的视觉效果,在满足紧迫截止日期的同时保持一致的质量。

游戏开发与概念艺术: 快速迭代角色设计、环境概念和资产变体。这种速度允许在项目时间表内进行更多的创意探索。

创意工作流

20 倍的速度提升从根本上改变了您处理创意工作的方式:

- 迭代优化:在以前生成 1-2 张图的时间内,生成 10-20 个概念变体。

- A/B 测试:创建多个版本以供受众或客户测试。

- 批量处理:在一次会话中处理整个系列或集合。

节省时间的优势

考虑一个典型的工作流比较:

- **传统(40 步)**:10 张图像 = 约 20 分钟

- **Turbo-LoRA(4 步)**:10 张图像 = 约 1 分钟

- 节省时间:生成时间减少 95%

这种效率提升在项目中不断累积,可能会为活跃的创作者每周节省数小时。

常见问题排查

即使设置最佳,您也可能会遇到一些挑战。以下是最常见的问题及其解决方案。

网格伪影和条带

问题: 平滑渐变(天空、肤色等)中出现可见的网格图案或条带。

解决方案:

- 确保您使用的是最佳的 1328x1328 分辨率。

- 尝试将推理步骤从 4 增加到 8。

- 检查您是否正在使用 V2.0 版本的 Turbo-LoRA。

- 避免激进的量化方法(坚持使用 bf16 或 fp16)。

分辨率问题和肢体畸形

问题: 生成的图像显示解剖学问题,如多余的肢体或比例失调。

解决方案:

- 始终使用 1328x1328 分辨率 —— 这一点至关重要。

- 如果您需要不同的宽高比,请在 1328x1328 下生成,然后裁剪。

- 避免使用与训练分辨率偏差很大的分辨率。

复杂细节的质量下降

问题: 具有非常复杂细节或许多元素的图像显得质量下降。

解决方案:

- 将 num_inference_steps 从 4 增加到 8。

- 简化您的提示词以专注于更少的元素。

- 对于极其复杂的场景,考虑使用基础模型(40 步)。

- 将复杂的构图分解为多次生成并进行合成。

结论

Qwen-Image-2512-Turbo-LoRA 代表了 AI 图像生成效率的巨大飞跃。通过在不牺牲质量的情况下实现 20 倍的生成速度,它从根本上改变了创意工作流的可能性。无论您是赶截止日期的专业设计师、大规模生产的内容创作者,还是探索新概念的 AI 艺术家,速度优势都为您打开了新的大门。

主要收获:

- 速度:4-8 步推理在几秒钟内提供专业结果。

- 质量:V2.0 保持了与 40 步基础模型相当的输出质量。

- 灵活性:适用于 ComfyUI 和 DiffSynth-Engine 框架。

- 优化:使用 1328x1328 分辨率和 4-8 步以获得最佳结果。

随着 AI 图像生成领域的不断发展,像 Turbo-LoRA 这样的工具证明了我们可以兼顾速度和质量。该领域即将到来的发展承诺会有更多的改进,使得高质量的 AI 艺术生成比以往任何时候都更加触手可及和高效。

准备好体验极速了吗? 立即在 https://zimage.run/qwen-image-2512 上试用 Qwen-Image-2512-Turbo-LoRA,看看 20 倍的生成速度如何改变您的创意工作流。

更多推荐

已为社区贡献25条内容

已为社区贡献25条内容

所有评论(0)