如何理解AI的token

写在前面:大家好!我是

晴空๓。如果博客中有不足或者的错误的地方欢迎在评论区或者私信我指正,感谢大家的不吝赐教。我的博客更新地址是:https://ac-fun.blog.csdn.net/。最近也开始写公众号啦【知识拆箱手记】两边会同步更新,期待大家的关注,非常感谢大家的支持。一起加油,冲鸭!

用知识改变命运,用知识成就未来!加油 (ง •̀o•́)ง (ง •̀o•́)ง

如何理解token

在使用AI尤其是各个大模型的API的时候经常会见到 token 这个单词, Spring AI 的官方文档1对 Tokens 的介绍原文节选如下:

Tokens serve as the building blocks of how an AI model works. On input, models convert words to tokens. On output, they convert tokens back to words.

In English, one token roughly corresponds to 75% of a word. For reference, Shakespeare’s complete works, totaling around 900,000 words, translate to approximately 1.2 million tokens.

Perhaps more important is that Tokens = Money. In the context of hosted AI models, your charges are determined by the number of tokens used. Both input and output contribute to the overall token count.

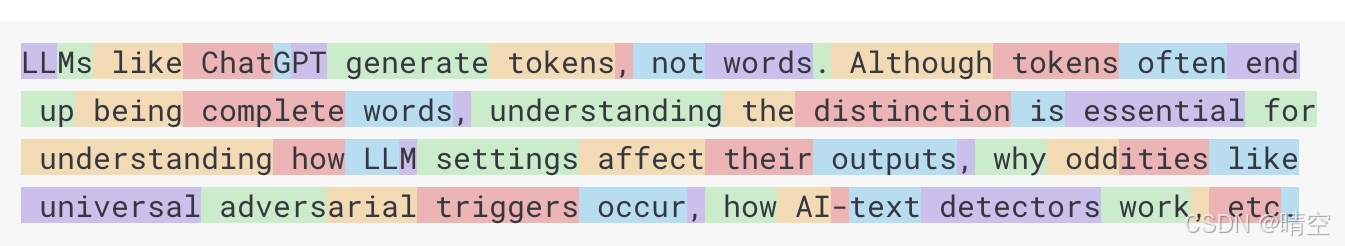

机翻把token这个单词翻译成了 代币。用代币这个翻译代入看会有点别扭,结合上下文这个单词翻译成 词元 比较合适。这个词元类似于英语里面的词根,但是两者又不完全一样。词元指的是文本被模型处理前分割成的基本单位,通常一个单词就是一个token。例如上文图片里面的:like, up 等;对于复杂的单词会被拆成多个token,例如上图的 ChatGPT 就被拆成了 Chat,G,PT。很多词元对于人类是没有意义的,是为了让机器更方便的“理解”与使用。而 词根 对于人类是有意义的,词根本身有明确的、核心的语义。两者的本质不同但又是意义相同,也许对于大模型来说token就是词根。

如何计算token用量

通过上文对于token的介绍(In English, one token roughly corresponds to 75% of a word.),我们可以知道一个token相当于一个单词的75%。对于中文DeepSeek在API文档中有 Token 用量计算 一节,里面有比较明确的换算比例,甚至有一个可以用来离线计算的工具包。所以文档中提到 Perhaps more important is that Tokens = Money. 我们在调用大模型API时消耗的费用正是基于输入和输出的“词元”总量来计算的。

DeepSeek对于计算Tokens用量的原文2如下:

Token 用量计算

token 是模型用来表示自然语言文本的基本单位,也是我们的计费单元,可以直观的理解为“字”或“词”;通常 1 个中文词语、1 个英文单词、1 个数字或 1 个符号计为 1 个 token。

一般情况下模型中 token 和字数的换算比例大致如下:

- 1 个英文字符 ≈ 0.3 个 token。

- 1 个中文字符 ≈ 0.6 个 token。

但因为不同模型的分词不同,所以换算比例也存在差异,每一次实际处理 token 数量以模型返回为准,您可以从返回结果的

usage中查看。

离线计算 Tokens 用量

您可以通过如下压缩包中的代码来运行 tokenizer,以离线计算一段文本的 Token 用量。

参考文献

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)