什么是 ‘Diagnostic Nodes’:在生产图中插入不可见的‘心跳检测’节点以实时监控 Agent 健康度

各位同仁,各位技术领域的探索者们,大家好!今天,我们齐聚一堂,共同探讨一个在构建高可用、高性能分布式系统过程中至关重要的议题:如何实时、精确地掌握系统中各个Agent的健康状况。在宏大而复杂的生产图中,数据流与处理逻辑如同神经网络般交织,任何一个节点的滞后、阻塞甚至假死,都可能引发系统层面的雪崩效应。传统的监控手段,如日志分析、指标收集、外部健康检查等,固然不可或缺,但在某些极端场景下,它们可能存

各位同仁,各位技术领域的探索者们,大家好!

今天,我们齐聚一堂,共同探讨一个在构建高可用、高性能分布式系统过程中至关重要的议题:如何实时、精确地掌握系统中各个Agent的健康状况。在宏大而复杂的生产图中,数据流与处理逻辑如同神经网络般交织,任何一个节点的滞后、阻塞甚至假死,都可能引发系统层面的雪崩效应。传统的监控手段,如日志分析、指标收集、外部健康检查等,固然不可或缺,但在某些极端场景下,它们可能存在时效性、粒度或覆盖范围的不足。

今天,我将向大家介绍一种创新且极具潜力的监控范式——Diagnostic Nodes,即在生产图中插入不可见的“心跳检测”节点,以实现对Agent健康度的实时、内联(in-band)监控。我们将深入剖析其原理、架构、实现细节、面临的挑战以及未来的发展方向。

一、 分布式系统监控的困境与 Diagnostic Nodes 的提出

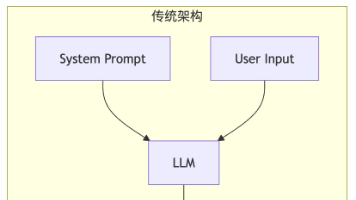

现代分布式系统往往由成百上千个微服务或Agent组成,它们通过消息队列、RPC调用等方式协同工作,共同完成复杂的业务逻辑。一个典型的生产图可能长这样:

数据源 -> Agent A -> Agent B -> Agent C -> 存储/用户

这里的每个Agent都可能是一个独立的进程、容器或服务实例,负责特定的数据处理、转换或路由任务。

传统监控手段的局限性:

- 日志分析: 能够提供详细的执行信息,但通常是事后分析,且需要聚合和检索,实时性不足。

- 指标收集(Metrics): 如CPU利用率、内存、网络IO、QPS、延迟等,通过Prometheus、Grafana等工具展现。它们能反映资源使用情况和整体性能,但很难直接定位到某个Agent“卡住”但并未崩溃的场景,也无法直接感知数据流在图中的真实进度。

- 外部健康检查: 通过HTTP探测、TCP连接等方式检查Agent是否存活,但只能判断服务是否可达,无法得知其内部处理逻辑是否正常,数据是否在流动。一个Agent可能表面上“存活”,但实际上已经停止处理消息,成为一个“僵尸”节点。

- 调用链追踪(Tracing): 如OpenTracing、Jaeger、Zipkin,能展示请求在系统中的完整路径和耗时,对于排查请求级的延迟非常有效。但对于持续运行、无明确请求边界的数据管道或流处理系统,其适用性有一定限制,并且通常是采样而非全量追踪,可能遗漏问题。

当上述手段都无法有效诊断出“Agent C 已经停止处理来自 Agent B 的消息,但它仍然存活,资源使用也正常”这类问题时,我们就需要一种更直接、更深入的方式来感知数据流的脉动。

Diagnostic Nodes (诊断节点) 应运而生。 它的核心思想是:将健康度检测机制内嵌到数据流本身,让监控信息与业务数据一同流经生产图。

二、 Diagnostic Nodes 的核心概念

Diagnostic Nodes 是指在分布式系统的生产数据流图中,以非侵入式、不可见的方式插入的特殊逻辑或虚拟节点。 它们不执行任何业务逻辑,不修改业务数据,其唯一职责是:在数据流的特定位置,生成、处理或转发一种特殊的“诊断消息”(Diagnostic Message),通常称为“心跳消息”(Heartbeat Message)或“探测消息”(Probe Message)。

这些诊断消息与业务数据共享相同的传输路径,因此,如果诊断消息能够顺利通过某个Agent,就意味着该Agent及其上游链路是通畅的;如果诊断消息在某个Agent处停止、延迟或丢失,则可以立即推断出该Agent或其上游存在问题。

关键特征:

- 不可见性 (Invisible): 对于业务逻辑而言,诊断节点是透明的。它们不影响正常的数据处理流程。

- 非侵入性 (Non-invasive): 诊断逻辑应尽可能少地修改现有Agent的代码。

- 内联监控 (In-band Monitoring): 监控信息与业务数据在同一通道传输,避免了外部检查可能存在的不同步问题。

- 实时性 (Real-time): 诊断消息的流动速度与业务数据相同,能提供接近实时的健康度反馈。

- 低开销 (Low Overhead): 诊断消息应极小,生成和处理频率可控,避免对系统性能造成显著影响。

三、 Diagnostic Nodes 的动机与优势

为什么我们要引入 Diagnostic Nodes?它能解决哪些传统监控难以处理的问题?

- 实时检测Agent“假死”或“卡顿”: 这是Diagnostic Nodes最核心的价值。当一个Agent因为内部逻辑错误、死锁、资源耗尽(如连接池耗尽)等原因停止从上游拉取或处理消息,但其进程本身依然存活时,传统健康检查会认为它正常。Diagnostic Nodes发出的心跳消息会在此处停滞,从而迅速暴露问题。

- 端到端延迟细粒度分析: 通过在不同Diagnostic Nodes处记录诊断消息的时间戳,可以精确计算数据流在图的各个阶段的传输和处理延迟,帮助定位瓶颈。

- 发现消息堆积和链路拥塞: 如果心跳消息的延迟突然增加,往往意味着其所经过的队列或Agent出现了消息堆积,预示着潜在的拥塞。

- 验证生产图的完整性和活性: 确保生产图中所有预期的Agent都在正常运行并处理数据,没有“沉默的”死角。

- 故障快速定位和隔离: 当发现心跳中断或延迟异常时,可以迅速通过定位诊断消息最后一次正常通过的节点,从而缩小故障范围。

- 减少外部监控的复杂性: 部分监控逻辑内化到数据流中,可以在一定程度上简化外部监控系统的设计。

与传统监控手段的对比:

| 特性 | 传统日志/指标/外部健康检查 | Diagnostic Nodes |

|---|---|---|

| 监控粒度 | 进程/服务级别,资源/性能指标,请求级(Tracing) | 数据流路径上的特定Agent或阶段,数据流的真实进度 |

| 实时性 | 通常有聚合延迟,外部检查有间隔 | 近乎实时,与数据流同步 |

| 问题类型 | 崩溃、资源耗尽、整体性能下降、请求级错误 | Agent假死/卡顿、消息堆积、链路中断、数据流停滞、内部延迟 |

| 开销 | 日志写入、指标收集、外部网络请求 | 额外的诊断消息传输和处理 |

| 集成方式 | 独立代理、API调用、网络探测 | 内嵌于数据流处理逻辑中 |

| 复杂性 | 配置、部署独立监控系统 | 需要修改Agent代码或注入逻辑,管理诊断消息生命周期 |

| 主要应用 | 广谱系统健康度、资源趋势、性能基线、请求级追踪 | 实时数据流活性、端到端链路健康、内部阻塞检测 |

四、 架构模式与实现策略

实现 Diagnostic Nodes 有多种架构模式,每种模式都有其适用场景和优缺点。我们将探讨两种主要模式:被动心跳发射 和 主动健康探测,以及它们的混合应用。

4.1 模式一:被动心跳发射 (Passive Heartbeat Emission)

原理: 在生产图的起始点或特定位置,一个特殊的“诊断源节点”(Diagnostic Source Node)周期性地生成并发送心跳消息。这些心跳消息沿着业务数据流的路径,经过一系列Agent,最终被一个“诊断汇聚节点”(Diagnostic Sink Node)或外部监控服务接收。如果心跳消息在预期时间内未能到达汇聚节点,或者其中包含的元数据(如时间戳)显示异常,则表明链路中存在问题。

架构图示:

[Diagnostic Source] --(Heartbeat Msg)--> [Agent A] --(Heartbeat Msg)--> [Agent B] --(Heartbeat Msg)--> [Diagnostic Sink]

^ ^

| (Business Data) | (Business Data)

[Data Source] -------------> [Agent A] -------------> [Agent B] -------------> [Agent C] -> ...实现细节:

-

诊断源节点:

- 通常是一个独立的、轻量级的进程或Agent,也可以是现有某个Agent被赋予了生成心跳消息的能力。

- 以固定频率(例如,每5秒或每分钟)生成一个包含唯一ID和时间戳的心跳消息。

- 将心跳消息注入到消息队列或数据流的入口。

-

普通Agent(Agent A, Agent B, …):

- 消息分类: 每个Agent在接收到消息时,需要判断消息是业务数据还是诊断消息。这可以通过消息头、消息类型字段或特定主题(topic)来实现。

- 诊断消息处理: 如果是诊断消息,Agent不会对其执行业务逻辑,而是简单地更新其内部状态(例如,记录收到心跳的时间),然后更新消息中的时间戳(如果需要),并将其转发给下一个Agent。

- 低开销原则: 诊断消息的处理路径应尽可能短,避免任何复杂的计算或IO操作。

-

诊断汇聚节点/监控服务:

- 接收所有到达的心跳消息。

- 心跳超时检测: 对于每个期望的心跳路径,维护一个计时器。如果在预设的超时时间内没有收到某个心跳ID的消息,则触发警报。

- 延迟计算: 如果心跳消息包含了路径上每个Agent的时间戳,监控服务可以计算出每个Agent的内部处理延迟和传输延迟。

- 状态存储: 将心跳数据(例如,最新收到时间、延迟)存储到时序数据库(如Prometheus, InfluxDB),以便进行趋势分析和可视化。

Python 示例代码 (被动心跳发射模式):

假设我们使用一个简单的消息队列(如Python的queue模块模拟,实际生产环境会是Kafka, RabbitMQ等)。

import uuid

import time

import json

import threading

import queue

from collections import deque

# 模拟消息队列

message_queues = {

"q_agent_a_in": queue.Queue(),

"q_agent_a_out": queue.Queue(),

"q_agent_b_out": queue.Queue(),

"q_sink_in": queue.Queue(),

}

# 诊断消息类型常量

MSG_TYPE_BUSINESS = "BUSINESS"

MSG_TYPE_HEARTBEAT = "HEARTBEAT"

class DiagnosticMessage:

"""诊断心跳消息结构"""

def __init__(self, heartbeat_id, source_agent_id):

self.id = heartbeat_id

self.source = source_agent_id

self.timestamps = {source_agent_id: time.time()} # 记录路径上的时间戳

self.type = MSG_TYPE_HEARTBEAT

self.payload = {} # 诊断消息通常没有业务payload

def add_timestamp(self, agent_id):

self.timestamps[agent_id] = time.time()

def to_json(self):

return json.dumps({

"id": self.id,

"source": self.source,

"timestamps": self.timestamps,

"type": self.type,

"payload": self.payload

})

@staticmethod

def from_json(json_str):

data = json.loads(json_str)

msg = DiagnosticMessage(data['id'], data['source'])

msg.timestamps = data['timestamps']

msg.type = data['type']

msg.payload = data['payload']

return msg

class BusinessMessage:

"""业务消息结构"""

def __init__(self, data_id, content):

self.id = data_id

self.content = content

self.type = MSG_TYPE_BUSINESS

def to_json(self):

return json.dumps({

"id": self.id,

"content": self.content,

"type": self.type

})

@staticmethod

def from_json(json_str):

data = json.loads(json_str)

msg = BusinessMessage(data['id'], data['content'])

msg.type = data['type']

return msg

# --- Diagnostic Source Node ---

class DiagnosticSource:

def __init__(self, agent_id, output_queue, heartbeat_interval=5):

self.agent_id = agent_id

self.output_queue = output_queue

self.heartbeat_interval = heartbeat_interval

self._running = False

print(f"[{self.agent_id}] Diagnostic Source initialized.")

def run(self):

self._running = True

while self._running:

heartbeat_id = str(uuid.uuid4())

heartbeat_msg = DiagnosticMessage(heartbeat_id, self.agent_id)

print(f"[{self.agent_id}] Emitting heartbeat: {heartbeat_msg.id}")

self.output_queue.put(heartbeat_msg.to_json())

time.sleep(self.heartbeat_interval)

def stop(self):

self._running = False

print(f"[{self.agent_id}] Diagnostic Source stopped.")

# --- Generic Agent ---

class GenericAgent:

def __init__(self, agent_id, input_queue, output_queue, process_delay=0.1):

self.agent_id = agent_id

self.input_queue = input_queue

self.output_queue = output_queue

self.process_delay = process_delay

self._running = False

print(f"[{self.agent_id}] Agent initialized.")

def _process_business_message(self, msg):

# 模拟业务处理

print(f"[{self.agent_id}] Processing business message: {msg.id} - {msg.content}")

time.sleep(self.process_delay) # 模拟处理延迟

# 业务逻辑:例如,转换数据,然后转发

msg.content = f"Processed by {self.agent_id}: {msg.content}"

return msg

def _process_diagnostic_message(self, msg):

# 诊断消息处理:更新时间戳,不执行业务逻辑

msg.add_timestamp(self.agent_id)

print(f"[{self.agent_id}] Forwarding heartbeat: {msg.id} (timestamps: {msg.timestamps})")

return msg

def run(self):

self._running = True

while self._running:

try:

msg_json = self.input_queue.get(timeout=1) # 1秒超时,以便检查_running状态

# 尝试解析为通用消息,判断类型

temp_data = json.loads(msg_json)

msg_type = temp_data.get('type')

if msg_type == MSG_TYPE_HEARTBEAT:

msg = DiagnosticMessage.from_json(msg_json)

processed_msg = self._process_diagnostic_message(msg)

elif msg_type == MSG_TYPE_BUSINESS:

msg = BusinessMessage.from_json(msg_json)

processed_msg = self._process_business_message(msg)

else:

print(f"[{self.agent_id}] Unknown message type received: {msg_json}")

continue

if self.output_queue: # 最后一个Agent可能没有输出队列

self.output_queue.put(processed_msg.to_json())

self.input_queue.task_done()

except queue.Empty:

continue

except Exception as e:

print(f"[{self.agent_id}] Error processing message: {e}")

# 实际生产中这里会有更复杂的错误处理和重试机制

if self.input_queue and not self.input_queue.empty(): # 如果有消息,尝试标记为完成,避免阻塞

self.input_queue.task_done()

def stop(self):

self._running = False

print(f"[{self.agent_id}] Agent stopped.")

# --- Diagnostic Sink Node (Monitoring Service part) ---

class DiagnosticSink:

def __init__(self, agent_id, input_queue, expected_path_agents, heartbeat_timeout=15):

self.agent_id = agent_id

self.input_queue = input_queue

self.expected_path_agents = expected_path_agents # 期望心跳经过的Agent列表

self.heartbeat_timeout = heartbeat_timeout

self.last_heartbeats = {} # {heartbeat_id: (received_time, timestamps)}

self.latest_per_source = {} # {source_agent_id: (latest_heartbeat_id, received_time)}

self._running = False

print(f"[{self.agent_id}] Diagnostic Sink initialized.")

def run(self):

self._running = True

threading.Thread(target=self._check_timeouts, daemon=True).start()

while self._running:

try:

msg_json = self.input_queue.get(timeout=1)

temp_data = json.loads(msg_json)

msg_type = temp_data.get('type')

if msg_type == MSG_TYPE_HEARTBEAT:

heartbeat_msg = DiagnosticMessage.from_json(msg_json)

self._process_received_heartbeat(heartbeat_msg)

else:

print(f"[{self.agent_id}] Received non-heartbeat message in sink: {msg_json}")

self.input_queue.task_done()

except queue.Empty:

continue

except Exception as e:

print(f"[{self.agent_id}] Error in sink: {e}")

def _process_received_heartbeat(self, msg):

received_time = time.time()

print(f"[{self.agent_id}] Received heartbeat: {msg.id} from {msg.source}")

# 检查是否经过了所有预期的Agent

path_ok = True

for expected_agent in self.expected_path_agents:

if expected_agent not in msg.timestamps:

print(f"[{self.agent_id}] ALERT: Heartbeat {msg.id} missed agent {expected_agent} in path.")

path_ok = False

break

if path_ok:

# 计算端到端延迟

end_to_end_latency = received_time - msg.timestamps[msg.source]

print(f"[{self.agent_id}] Heartbeat {msg.id} end-to-end latency: {end_to_end_latency:.3f}s")

# 存储最新心跳信息

self.last_heartbeats[msg.id] = (received_time, msg.timestamps)

self.latest_per_source[msg.source] = (msg.id, received_time)

# 可以在这里进一步计算每个Agent之间的延迟

# 例如:agent_a_processing_latency = msg.timestamps['agent_a_out'] - msg.timestamps['agent_a_in']

# 但为了简化,这里只计算了端到端。

def _check_timeouts(self):

while self._running:

current_time = time.time()

for source_id, (latest_id, last_received_time) in list(self.latest_per_source.items()):

if current_time - last_received_time > self.heartbeat_timeout:

print(f"[{self.agent_id}] !!! ALERT: Heartbeat from {source_id} (last ID: {latest_id}) timed out! Last received {current_time - last_received_time:.2f}s ago.")

# 实际生产中会触发PagerDuty, Slack通知等

# 可以在这里删除或标记为问题心跳,避免重复报警

del self.latest_per_source[source_id] # 移除以避免重复报警,直到收到新的心跳

time.sleep(1) # 每秒检查一次超时

def stop(self):

self._running = False

print(f"[{self.agent_id}] Diagnostic Sink stopped.")

# --- Main simulation ---

if __name__ == "__main__":

# 定义Agent和队列

# Diagnostic Source -> Agent A -> Agent B -> Diagnostic Sink

# 初始化组件

diag_source = DiagnosticSource("diag_source", message_queues["q_agent_a_in"], heartbeat_interval=3)

agent_a = GenericAgent("agent_a", message_queues["q_agent_a_in"], message_queues["q_agent_a_out"], process_delay=0.5)

agent_b = GenericAgent("agent_b", message_queues["q_agent_a_out"], message_queues["q_sink_in"], process_delay=0.8) # Agent B 是最后一个处理业务数据的Agent,心跳转发给sink

diag_sink = DiagnosticSink("diag_sink", message_queues["q_sink_in"], expected_path_agents=["diag_source", "agent_a", "agent_b"], heartbeat_timeout=10)

# 启动线程

source_thread = threading.Thread(target=diag_source.run)

agent_a_thread = threading.Thread(target=agent_a.run)

agent_b_thread = threading.Thread(target=agent_b.run)

sink_thread = threading.Thread(target=diag_sink.run)

source_thread.start()

agent_a_thread.start()

agent_b_thread.start()

sink_thread.start()

# 模拟发送一些业务消息

def send_business_messages():

for i in range(5):

bus_msg = BusinessMessage(f"biz_msg_{i}", f"Data {i}")

message_queues["q_agent_a_in"].put(bus_msg.to_json())

print(f"[Main] Sent business message: {bus_msg.id}")

time.sleep(2)

biz_thread = threading.Thread(target=send_business_messages)

biz_thread.start()

try:

time.sleep(30) # 运行一段时间

print("nSimulating Agent B stuck...")

agent_b._running = False # 模拟Agent B停止处理,但进程可能还在

time.sleep(15) # 等待心跳超时

except KeyboardInterrupt:

print("nStopping simulation...")

finally:

diag_source.stop()

agent_a.stop()

# agent_b.stop() # 已经模拟停止了

diag_sink.stop()

source_thread.join()

agent_a_thread.join()

agent_b_thread.join() # 即使停止了,也要join

sink_thread.join()

biz_thread.join()

print("Simulation finished.")

在上述Python示例中,我们模拟了一个简单的管道:Diagnostic Source -> Agent A -> Agent B -> Diagnostic Sink。Diagnostic Source周期性地发送心跳消息,Agent A和Agent B会接收并转发心跳,同时记录自己的时间戳。Diagnostic Sink负责接收心跳并检测超时。当模拟Agent B停止处理消息时,Diagnostic Sink会因为收不到心跳而发出警报。

4.2 模式二:主动健康探测 (Active Health Check Propagation)

原理: 一个中央监控服务或“探测器”(Probe Initiator)周期性地生成并发送一个特殊的“探测消息”(Probe Message)。这个探测消息被注入到生产图的入口,并沿着预定义的路径传播。每个经过的Agent都会在探测消息中记录自己的ID和处理时间戳,并将其转发。最终,探测消息会返回到探测器。探测器通过分析消息中携带的时间戳链,计算出端到端以及每个Agent之间的延迟。

架构图示:

[Probe Initiator] --(Probe Msg)--> [Agent A] --(Probe Msg)--> [Agent B] --(Probe Msg)--> [Agent C] --(Probe Msg)--> [Probe Initiator] (Return Path)

^ ^ ^

| (Business Data) | (Business Data) | (Business Data)

[Data Source] -------------> [Agent A] -------------> [Agent B] -------------> [Agent C] -> ...实现细节:

-

探测器 (Probe Initiator):

- 生成包含唯一探测ID、起始时间戳和预期返回路径的探测消息。

- 将探测消息发送到生产图的第一个Agent。

- 维护所有发出探测消息的状态,等待其返回。

- 一旦探测消息返回,解析其携带的时间戳,计算延迟,并检测超时。

-

普通Agent:

- 与被动模式类似,需要识别并处理诊断消息。

- 收到探测消息后,记录当前Agent的ID和时间戳到消息中。

- 根据消息中定义的返回路径(或默认规则,如反向路径),将消息转发给下一个Agent。

-

返回路径:

- 探测消息需要一个机制来返回到探测器。这可以是:

- 消息中明确指定一个“回复地址”(reply-to address)。

- 通过一个专门的“返回队列”或主题。

- 反向遍历原路径(如果系统支持)。

- 探测消息需要一个机制来返回到探测器。这可以是:

Python 示例代码 (主动健康探测模式 – 简化版):

我们将修改DiagnosticMessage结构和GenericAgent的逻辑,并添加一个ProbeInitiator。

import uuid

import time

import json

import threading

import queue

from collections import deque

# 模拟消息队列

# 增加了返回队列,模拟探测消息能够返回

message_queues = {

"q_agent_a_in": queue.Queue(),

"q_agent_a_out": queue.Queue(),

"q_agent_b_out": queue.Queue(),

"q_agent_c_out": queue.Queue(),

"q_probe_return": queue.Queue(), # 探测消息返回队列

}

# 诊断消息类型常量

MSG_TYPE_BUSINESS = "BUSINESS"

MSG_TYPE_PROBE = "PROBE" # 探测消息

class ProbeMessage:

"""探测消息结构"""

def __init__(self, probe_id, path_sequence, return_queue_name):

self.id = probe_id

self.path_sequence = path_sequence # 期望经过的Agent顺序列表

self.timestamps = {} # {agent_id: time_at_entry, agent_id_processed: time_at_exit}

self.type = MSG_TYPE_PROBE

self.return_queue_name = return_queue_name # 告知消息最终回到哪个队列

self.current_index = 0 # 记录当前消息在path_sequence中的位置

def add_timestamp(self, agent_id, stage="entry"):

self.timestamps[f"{agent_id}_{stage}"] = time.time()

def to_json(self):

return json.dumps({

"id": self.id,

"path_sequence": self.path_sequence,

"timestamps": self.timestamps,

"type": self.type,

"return_queue_name": self.return_queue_name,

"current_index": self.current_index

})

@staticmethod

def from_json(json_str):

data = json.loads(json_str)

msg = ProbeMessage(data['id'], data['path_sequence'], data['return_queue_name'])

msg.timestamps = data['timestamps']

msg.type = data['type']

msg.current_index = data['current_index']

return msg

# BusinessMessage 结构不变

class BusinessMessage:

def __init__(self, data_id, content):

self.id = data_id

self.content = content

self.type = MSG_TYPE_BUSINESS

def to_json(self):

return json.dumps({

"id": self.id,

"content": self.content,

"type": self.type

})

@staticmethod

def from_json(json_str):

data = json.loads(json_str)

msg = BusinessMessage(data['id'], data['content'])

msg.type = data['type']

return msg

# --- Probe Initiator (Central Monitoring Service) ---

class ProbeInitiator:

def __init__(self, initiator_id, first_agent_input_queue, return_queue, path_to_probe, probe_interval=5, probe_timeout=15):

self.initiator_id = initiator_id

self.first_agent_input_queue = first_agent_input_queue # 探测消息注入的第一个Agent的输入队列

self.return_queue = return_queue # 探测消息返回的队列

self.path_to_probe = path_to_probe # 期望探测消息经过的Agent ID列表

self.probe_interval = probe_interval

self.probe_timeout = probe_timeout

self._running = False

self.outstanding_probes = {} # {probe_id: (start_time, path_sequence)}

print(f"[{self.initiator_id}] Probe Initiator initialized.")

def run(self):

self._running = True

threading.Thread(target=self._send_probes, daemon=True).start()

threading.Thread(target=self._receive_probes, daemon=True).start()

threading.Thread(target=self._check_timeouts, daemon=True).start()

def _send_probes(self):

while self._running:

probe_id = str(uuid.uuid4())

probe_msg = ProbeMessage(probe_id, self.path_to_probe, self.return_queue.name) # 假设队列有name属性

probe_msg.add_timestamp(self.initiator_id, "start") # 记录探测器发出时间

self.outstanding_probes[probe_id] = (time.time(), self.path_to_probe)

print(f"[{self.initiator_id}] Sending probe: {probe_msg.id} to {self.path_to_probe[0]}")

self.first_agent_input_queue.put(probe_msg.to_json())

time.sleep(self.probe_interval)

def _receive_probes(self):

while self._running:

try:

msg_json = self.return_queue.get(timeout=1)

temp_data = json.loads(msg_json)

msg_type = temp_data.get('type')

if msg_type == MSG_TYPE_PROBE:

probe_msg = ProbeMessage.from_json(msg_json)

self._process_returned_probe(probe_msg)

else:

print(f"[{self.initiator_id}] Received non-probe message in return queue: {msg_json}")

self.return_queue.task_done()

except queue.Empty:

continue

except Exception as e:

print(f"[{self.initiator_id}] Error in probe receiver: {e}")

def _process_returned_probe(self, probe_msg):

if probe_msg.id not in self.outstanding_probes:

print(f"[{self.initiator_id}] Received unexpected probe ID: {probe_msg.id}")

return

start_time, expected_path = self.outstanding_probes.pop(probe_msg.id)

end_time = time.time()

total_latency = end_time - start_time

print(f"[{self.initiator_id}] Received probe {probe_msg.id} back. Total latency: {total_latency:.3f}s")

# 验证路径和计算阶段延迟

path_ok = True

previous_agent_exit_time = start_time

for i, agent_id in enumerate(expected_path):

entry_ts_key = f"{agent_id}_entry"

exit_ts_key = f"{agent_id}_exit"

entry_time = probe_msg.timestamps.get(entry_ts_key)

exit_time = probe_msg.timestamps.get(exit_ts_key)

if not entry_time or not exit_time:

print(f"[{self.initiator_id}] ALERT: Probe {probe_msg.id} missed timestamps for agent {agent_id}. Missing entry:{not entry_time}, exit:{not exit_time}")

path_ok = False

break

# 计算当前Agent处理延迟

processing_latency = exit_time - entry_time

# 计算上一个Agent的输出到当前Agent的输入之间的传输延迟

transfer_latency = entry_time - previous_agent_exit_time

print(f" - Agent {agent_id}: Process latency {processing_latency:.3f}s, Transfer latency (from prev) {transfer_latency:.3f}s")

previous_agent_exit_time = exit_time

if path_ok:

print(f"[{self.initiator_id}] Probe {probe_msg.id} successfully traversed the full path.")

else:

print(f"[{self.initiator_id}] ALERT: Probe {probe_msg.id} path incomplete or corrupted.")

def _check_timeouts(self):

while self._running:

current_time = time.time()

for probe_id, (start_time, path_sequence) in list(self.outstanding_probes.items()):

if current_time - start_time > self.probe_timeout:

print(f"[{self.initiator_id}] !!! ALERT: Probe {probe_id} (path: {path_sequence}) timed out! Sent {current_time - start_time:.2f}s ago.")

del self.outstanding_probes[probe_id]

time.sleep(1)

def stop(self):

self._running = False

print(f"[{self.initiator_id}] Probe Initiator stopped.")

# --- Generic Agent (Modified for Probe Messages) ---

class GenericAgent:

def __init__(self, agent_id, input_queue, output_queue, process_delay=0.1, is_last_in_path=False, return_queue_override=None):

self.agent_id = agent_id

self.input_queue = input_queue

self.output_queue = output_queue

self.process_delay = process_delay

self.is_last_in_path = is_last_in_path # 是否是探测路径中的最后一个Agent

self.return_queue_override = return_queue_override # 如果是最后一个,可能需要指定返回队列

self._running = False

print(f"[{self.agent_id}] Agent initialized.")

def _process_business_message(self, msg):

print(f"[{self.agent_id}] Processing business message: {msg.id} - {msg.content}")

time.sleep(self.process_delay)

msg.content = f"Processed by {self.agent_id}: {msg.content}"

return msg

def _process_probe_message(self, msg):

msg.add_timestamp(self.agent_id, "entry") # 记录进入Agent的时间

print(f"[{self.agent_id}] Processing probe: {msg.id}")

time.sleep(self.process_delay) # 模拟Agent自身的处理延迟

msg.add_timestamp(self.agent_id, "exit") # 记录离开Agent的时间

msg.current_index += 1

return msg

def run(self):

self._running = True

while self._running:

try:

msg_json = self.input_queue.get(timeout=1)

temp_data = json.loads(msg_json)

msg_type = temp_data.get('type')

processed_msg = None

if msg_type == MSG_TYPE_PROBE:

msg = ProbeMessage.from_json(msg_json)

processed_msg = self._process_probe_message(msg)

# 检查是否是路径中的最后一个Agent

if msg.current_index >= len(msg.path_sequence):

# 探测消息已完成路径,将其发送到返回队列

return_q = message_queues.get(msg.return_queue_name) # 从消息中获取返回队列名

if return_q:

print(f"[{self.agent_id}] Probe {msg.id} completed path. Sending to return queue: {msg.return_queue_name}")

return_q.put(processed_msg.to_json())

else:

print(f"[{self.agent_id}] ERROR: Return queue {msg.return_queue_name} not found for probe {msg.id}")

elif self.output_queue: # 否则继续转发到下一个Agent

self.output_queue.put(processed_msg.to_json())

else:

print(f"[{self.agent_id}] WARNING: Probe {msg.id} has more steps but no output queue.")

elif msg_type == MSG_TYPE_BUSINESS:

msg = BusinessMessage.from_json(msg_json)

processed_msg = self._process_business_message(msg)

if self.output_queue:

self.output_queue.put(processed_msg.to_json())

else:

print(f"[{self.agent_id}] Unknown message type received: {msg_json}")

continue

self.input_queue.task_done()

except queue.Empty:

continue

except Exception as e:

print(f"[{self.agent_id}] Error processing message: {e}")

if self.input_queue and not self.input_queue.empty():

self.input_queue.task_done()

def stop(self):

self._running = False

print(f"[{self.agent_id}] Agent stopped.")

# 给队列加上名称属性,方便ProbeMessage引用

message_queues["q_probe_return"].name = "q_probe_return"

# --- Main simulation (Active Probe) ---

if __name__ == "__main__":

# 定义Agent和队列

# Probe Initiator -> Agent A -> Agent B -> Agent C -> Probe Initiator (via return queue)

# 探测路径

probe_path = ["agent_a", "agent_b", "agent_c"]

# 初始化组件

probe_initiator = ProbeInitiator(

"probe_initiator",

message_queues["q_agent_a_in"],

message_queues["q_probe_return"],

probe_path,

probe_interval=4,

probe_timeout=12

)

agent_a = GenericAgent("agent_a", message_queues["q_agent_a_in"], message_queues["q_agent_a_out"], process_delay=0.3)

agent_b = GenericAgent("agent_b", message_queues["q_agent_a_out"], message_queues["q_agent_b_out"], process_delay=0.6)

agent_c = GenericAgent("agent_c", message_queues["q_agent_b_out"], message_queues["q_agent_c_out"], process_delay=0.2) # Agent C是路径中的最后一个

# 最后一个Agent C的输出队列实际上不会直接连接到下一个业务Agent,而是将探测消息送回探测器

# 这里我们模拟,如果output_queue是None,则该Agent是路径终点,需将探测消息送回。

# 为了简化,我们让Agent C的output_queue指向一个不存在的队列,然后让它直接将消息送回return_queue

# 实际生产中,Agent C的output_queue可能仍然是业务数据队列,但探测消息需要单独路由。

# 这里我们修改Agent C的 output_queue 为 None,并让其在处理完探测消息后,通过消息的 `return_queue_name` 属性将消息送回。

# 这需要修改GenericAgent的逻辑以支持动态路由。

# 启动线程

initiator_thread = threading.Thread(target=probe_initiator.run)

agent_a_thread = threading.Thread(target=agent_a.run)

agent_b_thread = threading.Thread(target=agent_b.run)

agent_c_thread = threading.Thread(target=agent_c.run) # Agent C的 output_queue 在这里被忽略,由其内部逻辑决定

initiator_thread.start()

agent_a_thread.start()

agent_b_thread.start()

agent_c_thread.start()

# 模拟发送一些业务消息

def send_business_messages():

for i in range(3):

bus_msg = BusinessMessage(f"biz_msg_{i}", f"Data {i}")

message_queues["q_agent_a_in"].put(bus_msg.to_json())

print(f"[Main] Sent business message: {bus_msg.id}")

time.sleep(3)

biz_thread = threading.Thread(target=send_business_messages)

biz_thread.start()

try:

time.sleep(20) # 运行一段时间,观察正常探测

print("nSimulating Agent B stuck...")

agent_b._running = False # 模拟Agent B停止处理

time.sleep(15) # 等待探测超时

except KeyboardInterrupt:

print("nStopping simulation...")

finally:

probe_initiator.stop()

agent_a.stop()

# agent_b.stop() # 已经模拟停止了

agent_c.stop()

initiator_thread.join()

agent_a_thread.join()

agent_b_thread.join()

agent_c_thread.join()

biz_thread.join()

print("Simulation finished.")

在这个主动探测的示例中,ProbeInitiator周期性发送ProbeMessage,Agent A、B、C依次接收、记录时间戳并转发。当ProbeMessage经过所有预定Agent后,它会被路由回ProbeInitiator,由其计算整个路径和各个Agent的延迟。当Agent B停止时,ProbeInitiator将无法收到完整的ProbeMessage,从而触发超时报警。

4.3 混合模式 (Hybrid Approach)

实际生产中,被动心跳发射和主动健康探测可以结合使用:

- 被动心跳 用于提供基础的、持续的、低开销的链路活性监控。当心跳中断时,可以快速发现问题。

- 主动探测 用于在心跳出现问题后,或者在需要进行更详细、更精确的延迟分析时,进行按需或周期性的深度探测。它能提供更丰富的路径和时间戳信息。

4.4 诊断节点的插入策略

- 手动编码: 开发者在编写Agent代码时,显式地加入处理诊断消息的逻辑。这种方式最直接,但可能增加开发负担和代码耦合。

- AOP (Aspect-Oriented Programming) / 字节码注入: 在编译或运行时,通过AOP框架或字节码操作工具,自动将诊断逻辑(如消息类型判断、时间戳记录、转发)织入到Agent的消息处理方法中。这种方式侵入性最小。

- 框架/库级别支持: 如果Agent是基于特定消息处理框架(如Apache Flink, Spark Streaming, Akka Streams)构建的,框架本身可以提供插件或扩展点,允许用户定义诊断消息处理器,并自动将其集成到数据流图中。

- 配置驱动: 诊断节点本身可以作为一种特殊的Agent类型,通过配置来定义其在图中的位置和行为。

五、 技术深挖:设计与实现 Diagnostic Nodes

5.1 诊断消息格式

一个健壮的诊断消息需要包含足够的信息,以便监控系统进行有效的分析。

表:诊断消息结构示例

| 字段名称 | 类型 | 描述 | 示例值 |

|---|---|---|---|

message_id |

String | 诊断消息的唯一标识符(UUID),用于追踪单个心跳或探测的生命周期。 | "a1b2c3d4-e5f6-7890-1234-567890abcdef" |

type |

String | 消息类型:HEARTBEAT (被动心跳) 或 PROBE (主动探测)。 |

"HEARTBEAT" |

source_agent_id |

String | 诊断消息的原始发起Agent的ID。 | "diag_source_1" |

path_sequence |

List | (仅限PROBE) 期望探测消息经过的Agent ID有序列表,用于验证路径完整性。 | ["agent_a", "agent_b", "agent_c"] |

timestamps |

Map<String, Double> | 记录消息在各个Agent处的时间戳。键可以是"{agent_id}_entry"和"{agent_id}_exit",值是Unix时间戳(浮点数,精确到毫秒或微秒)。 |

{"diag_source_1_start": 1678886400.123, "agent_a_entry": 1678886400.125, ...} |

return_queue |

String | (仅限PROBE) 探测消息完成路径后需要返回的队列或主题名称,以便探测器接收。 | "probe_results_topic" |

current_index |

Integer | (仅限PROBE) 记录探测消息当前已处理到path_sequence中的哪个位置,方便Agent判断下一步路由。 |

2 (表示已通过path_sequence中的前两个Agent) |

payload |

Object | 诊断消息通常没有业务负载,但可以包含一些元数据,例如序列号(用于检测乱序或丢失)、版本号等。应尽可能小。 | {} 或 {"sequence": 123} |

5.2 与消息系统的集成

诊断消息需要与业务消息共享相同的消息传输基础设施。

- Kafka:

- 可以使用单独的

diagnostic_heartbeats或diagnostic_probes主题,或者在业务主题中通过消息头或特定字段标记诊断消息。 - Agent需要消费这些主题,并根据消息类型进行分支处理。

- 为了降低对业务主题的干扰,可以考虑将其发送到低优先级的Kafka分区或主题(如果消息系统支持)。

- 可以使用单独的

- RabbitMQ/ActiveMQ:

- 可以使用不同的队列或Exchange来路由诊断消息。

- 通过消息的

type属性或routing_key进行区分。 - 可以利用消息优先级功能,确保诊断消息在队列中不会被业务消息过度延迟(但也要权衡对业务消息的影响)。

- gRPC/HTTP Streams:

- 在流协议中,诊断消息可以作为一种特殊类型的消息帧或带有特定元数据的消息。

- Agent需要解析流中的每条消息,并根据其类型进行处理。

关键考虑: 诊断消息的传输不应该因为业务消息的拥堵而受到显著影响,否则诊断信息本身就失去了实时性。可以考虑:

- 独立传输路径: 如果系统允许,为诊断消息提供独立的、低容量、高优先级的通道。

- 消息优先级: 利用消息队列的优先级机制(如RabbitMQ的优先级队列)。

- 旁路处理: Agent在处理诊断消息时,尽量避免进入业务处理路径的任何阻塞资源(如数据库连接、外部API调用)。

5.3 Agent端逻辑

Agent端的诊断逻辑必须满足“非侵入性”和“低开销”的原则。

# 核心处理逻辑伪代码

def process_incoming_message(message_json):

# 1. 解析消息,识别类型

message_obj = parse_message(message_json)

if message_obj.type == MSG_TYPE_PROBE:

# 2. 处理探测消息

probe_msg = message_obj

probe_msg.add_timestamp(AGENT_ID, "entry") # 记录进入时间

# 模拟Agent的内部处理延迟

simulate_agent_workload(probe_msg.payload) # 诊断消息的payload很小,模拟延迟可以忽略

probe_msg.add_timestamp(AGENT_ID, "exit") # 记录离开时间

# 3. 路由探测消息

if probe_msg.current_index >= len(probe_msg.path_sequence):

# 探测完成,发送到返回队列

send_to_return_queue(probe_msg.to_json(), probe_msg.return_queue)

else:

# 继续转发到下一个Agent

send_to_next_agent_queue(probe_msg.to_json(), probe_msg.path_sequence[probe_msg.current_index])

elif message_obj.type == MSG_TYPE_HEARTBEAT:

# 2. 处理心跳消息

heartbeat_msg = message_obj

heartbeat_msg.add_timestamp(AGENT_ID) # 记录经过时间

# 3. 转发心跳消息

send_to_next_agent_queue(heartbeat_msg.to_json(), next_agent_id)

elif message_obj.type == MSG_TYPE_BUSINESS:

# 2. 处理业务消息

process_business_data(message_obj.payload)

# 3. 转发业务消息

send_to_next_agent_queue(message_obj.to_json(), next_agent_id)

else:

log_warning("Unknown message type")

此伪代码展示了Agent如何基于消息类型进行分支处理。关键在于:诊断消息的处理路径应尽可能短,避免业务逻辑的任何副作用。

5.4 监控服务逻辑

监控服务(Diagnostic Sink / Probe Initiator)是诊断节点的“大脑”,负责接收、分析诊断消息并触发警报。

from collections import deque

class MonitoringService:

def __init__(self, expected_heartbeat_path, probe_timeout_seconds=15):

self.expected_heartbeat_path = expected_heartbeat_path # 例如: ["source", "agent_a", "agent_b"]

self.probe_timeout_seconds = probe_timeout_seconds

self.last_received_heartbeats = {} # {source_agent_id: (latest_heartbeat_id, received_timestamp)}

self.active_probes = {} # {probe_id: (sent_timestamp, expected_path_sequence, received_timestamps_so_far)}

# 假设有一个消息消费者,持续从诊断队列接收消息

self.message_consumer = MessageConsumer(diagnostic_queue_name, self._on_message_received)

def _on_message_received(self, message_json):

message_obj = parse_message(message_json) # 解析消息

if message_obj.type == MSG_TYPE_HEARTBEAT:

self._process_heartbeat(message_obj)

elif message_obj.type == MSG_TYPE_PROBE:

self._process_probe_return(message_obj)

else:

log_warning(f"Received unexpected message type in monitoring service: {message_obj.type}")

def _process_heartbeat(self, heartbeat_msg):

current_time = time.time()

source_id = heartbeat_msg.source_agent_id

# 1. 更新最新心跳时间

self.last_received_heartbeats[source_id] = (heartbeat_msg.message_id, current_time)

# 2. 验证路径完整性 (可选,但推荐)

for expected_agent in self.expected_heartbeat_path:

if expected_agent not in heartbeat_msg.timestamps:

self.alert(f"Heartbeat {heartbeat_msg.message_id} from {source_id} missed agent {expected_agent} in path!")

return

# 3. 计算延迟 (可选)

if len(self.expected_heartbeat_path) > 1:

first_ts = heartbeat_msg.timestamps.get(f"{self.expected_heartbeat_path[0]}_entry", heartbeat_msg.timestamps.get(self.expected_heartbeat_path[0]))

if first_ts:

end_to_end_latency = current_time - first_ts

log_info(f"Heartbeat {heartbeat_msg.message_id} E2E latency: {end_to_end_latency:.3f}s")

# 记录到时序数据库

self.metrics_client.gauge("heartbeat_e2e_latency", end_to_end_latency, tags={"source": source_id})

def _process_probe_return(self, probe_msg):

if probe_msg.message_id not in self.active_probes:

log_warning(f"Received unknown or already processed probe: {probe_msg.message_id}")

return

sent_time, expected_path_sequence, _ = self.active_probes.pop(probe_msg.message_id) # 移除活跃探测

total_latency = time.time() - sent_time

log_info(f"Probe {probe_msg.message_id} returned. Total latency: {total_latency:.3f}s")

self.metrics_client.gauge("probe_total_latency", total_latency, tags={"path": "-".join(expected_path_sequence)})

# 详细的阶段延迟分析

previous_exit_time = sent_time # 探测器发出时间作为前一个出口时间

for i, agent_id in enumerate(expected_path_sequence):

entry_ts_key = f"{agent_id}_entry"

exit_ts_key = f"{agent_id}_exit"

entry_time = probe_msg.timestamps.get(entry_ts_key)

exit_time = probe_msg.timestamps.get(exit_ts_key)

if not entry_time or not exit_time:

self.alert(f"Probe {probe_msg.message_id} missing timestamps for {agent_id}. Path might be broken.")

return # 路径不完整,直接报警

processing_latency = exit_time - entry_time

transfer_latency = entry_time - previous_exit_time

log_info(f" Agent {agent_id}: Processing {processing_latency:.3f}s, Transfer {transfer_latency:.3f}s")

self.metrics_client.gauge("agent_processing_latency", processing_latency, tags={"agent_id": agent_id})

self.metrics_client.gauge("agent_transfer_latency", transfer_latency, tags={"from_agent": expected_path_sequence[i-1] if i > 0 else "initiator", "to_agent": agent_id})

previous_exit_time = exit_time

log_info(f"Probe {probe_msg.message_id} path validation successful.")

def check_timeouts(self):

# 周期性任务,检查心跳和探测是否超时

current_time = time.time()

# 检查心跳超时

for source_id, (last_id, last_ts) in list(self.last_received_heartbeats.items()):

if current_time - last_ts > self.probe_timeout_seconds:

self.alert(f"Heartbeat from {source_id} (last ID: {last_id}) timed out! Last received {current_time - last_ts:.2f}s ago.")

del self.last_received_heartbeats[source_id] # 避免重复报警

# 检查探测超时

for probe_id, (sent_ts, _, _) in list(self.active_probes.items()):

if current_time - sent_ts > self.probe_timeout_seconds:

self.alert(f"Probe {probe_id} timed out! Sent {current_time - sent_ts:.2f}s ago. Path: {self.active_probes[probe_id][1]}")

del self.active_probes[probe_id]

def alert(self, message):

print(f"!!! ALERT: {message}")

# 实际生产中会集成到PagerDuty, Slack, OpsGenie等报警系统

self.alert_manager.send_alert(message)

# 辅助函数和类(MessageConsumer, parse_message, log_info, metrics_client, alert_manager)略这个伪代码展示了监控服务如何同时处理心跳和探测消息,进行路径验证、延迟计算和超时检测,并触发报警。

5.5 管理开销

诊断节点的开销是需要仔细权衡的关键因素:

- 频率: 心跳或探测的发送频率。过高会导致不必要的流量和CPU消耗;过低则会降低实时性。通常,几秒到一分钟的间隔是比较常见的选择。

- 消息大小: 诊断消息应尽可能小,只包含必要的信息。避免传输大对象。

- 处理路径: Agent处理诊断消息的逻辑必须极简,避免任何重量级操作,例如数据库写入、复杂的计算、网络请求等。

- 专用资源: 考虑为诊断消息分配单独的、容量较小的消息队列或主题分区,以避免与业务数据争抢资源。

- 采样: 对于非常大的系统,可以考虑只对部分链路或部分时间段激活诊断节点,或者对诊断消息进行采样。

- 动态控制: 允许在运行时动态开启/关闭诊断节点,或调整其频率,以便在需要时进行深入诊断,在平时保持低开销。

六、 挑战与考量

尽管 Diagnostic Nodes 提供了强大的监控能力,但在实施过程中也面临一些挑战:

- 开销与粒度的权衡: 更频繁、更细粒度的诊断会带来更高的资源消耗。需要根据业务对实时性和故障容忍度的要求进行仔细平衡。

- 错误报警(False Positives)与漏报(False Negatives):

- False Positives: 暂时的网络抖动、Agent瞬时负载高峰可能导致诊断消息延迟,但并非真正的故障。需要通过合理的超时阈值、重试机制和聚合判断来减少误报。

- False Negatives: 如果诊断消息本身被特殊处理,绕过了某些真正的阻塞点,或者采样率过低,可能导致漏报。

- 安全性: 诊断消息可能暴露系统内部拓扑和Agent ID。在传输和存储时需要进行适当的加密和访问控制。

- 复杂性: 引入 Diagnostic Nodes 增加了系统的整体复杂性,包括开发、部署和维护。需要确保其实现足够健壮,不会成为新的故障点。

- 与现有监控体系的整合: 如何将 Diagnostic Nodes 产生的数据(如延迟、超时)无缝集成到现有的监控仪表盘、告警系统和APM工具中,是需要考虑的。

- 动态拓扑管理: 对于拓扑结构频繁变化的系统(如弹性伸缩、服务发现),如何动态地注入、管理和移除 Diagnostic Nodes 及其配置,是一个复杂的问题。

- 状态管理: 主动探测模式下,探测器需要维护所有未返回探测消息的状态,这可能涉及持久化和故障恢复机制。

七、 实际应用场景

Diagnostic Nodes 在以下场景中表现尤为出色:

- 金融交易系统: 对延迟极其敏感,任何微秒级的延迟都可能造成巨大损失。Diagnostic Nodes 可以提供超低延迟的链路健康度感知。

- 物联网 (IoT) 数据管道: 确保海量传感器数据从边缘设备到云端处理的各个环节连续、实时流动,及时发现数据中断。

- 实时推荐系统: 监测用户行为数据从收集、处理、模型推理到推荐结果生成的端到端延迟,保证推荐结果的时效性。

- 复杂 ETL 工作流: 在多阶段数据转换和加载任务中,识别数据积压、处理缓慢的阶段,确保数据按时可用。

- 视频流处理: 确保视频帧从采集、编码、转码到分发的整个链路的流畅性,避免卡顿和延迟。

八、 演进与未来方向

Diagnostic Nodes 作为一个强大的监控工具,未来仍有广阔的演进空间:

- 结合 AI/ML 进行异常检测: 利用诊断数据(如延迟趋势、心跳频率)训练机器学习模型,自动识别不寻常的模式,实现更智能的预警,而非简单的阈值告警。

- 与自愈系统集成: 当 Diagnostic Nodes 发现特定 Agent 或链路出现问题时,可以自动触发系统的自愈机制,例如重启 Agent、切换到备用路径、动态调整资源分配等。

- 标准化诊断协议: 随着微服务和分布式系统的普及,定义一套通用的诊断消息格式和协议,有助于不同厂商和系统之间的互操作性。

- 服务网格 (Service Mesh) 集成: 利用服务网格的 Sidecar 代理能力,可以更透明、非侵入地注入和管理 Diagnostic Nodes,而无需修改业务 Agent 代码。Sidecar 可以拦截所有出入流量,实现诊断消息的自动处理和转发。

- 可视化和拓扑重建: 结合 Diagnostic Nodes 收集到的路径和延迟信息,实时动态地绘制出数据流的拓扑图,并在图上直观地展示各节点的健康状态和性能指标。

九、 结束语

Diagnostic Nodes 并非要取代传统的监控工具,而是作为一种强有力的补充,弥补了在实时、内联、细粒度数据流健康度监控方面的空白。它提供了一种深入系统“脉络”的能力,让我们能够更早、更准确地感知系统内部的“心跳”与“血流”,从而在问题爆发前进行干预,或在问题发生时迅速定位并解决。在构建和维护高可靠、高性能分布式系统的征程中,Diagnostic Nodes 值得每一位架构师和开发者深入探索与实践。

更多推荐

已为社区贡献48条内容

已为社区贡献48条内容

所有评论(0)