【论文精读】深度理解DanceGRPO:稳定性训练 + 大一统框架

生成式AI革新了视觉内容创作,但是在保持人类偏好方面仍有不足。尽管RL是微调生成模型的一种有前景的方法,但现有方法如DDPO和DPOK存在根本性局限性——扩展到大规模、多样化提示词集时,它们。

DanceGRPO 证明:不需要复杂的价值网络,仅靠组内博弈与 SDE 噪声修正,视觉模型也能“涌现”出令人惊叹的对齐能力。让我们一起阅读一下相关的这篇论文。

原文链接:https://arxiv.org/pdf/2505.07818

0.【摘要】

生成式AI革新了视觉内容创作,但是在保持人类偏好方面仍有不足。尽管RL是微调生成模型的一种有前景的方法,但现有方法如DDPO和DPOK存在根本性局限性——扩展到大规模、多样化提示词集时,它们无法保持稳定的优化。

DanceGRPO针对上述问题,提出一个解决方案,用GRPO固有的稳定性机制克服问题,并取得了进展:1. 在包括扩散模型(diffusion models)和修正流( rectified flows)在内的多种现代生成范式中,都一致且稳定。2. 扩展到涵盖三个关键任务和四个基础模型的复杂现实场景时,它保持了强大的性能。 3. 它在针对由五个不同奖励模型所捕获的多样化人类偏好进行优化方面表现出显著的通用性。

实验表明,在包括HPS-v2.1、CLIP分数、VideoAlign和GenEval在内的多个成熟基准测试中,DanceGRPO优于基线方法的幅度最高可达181%。研究结果确立了DanceGRPO作为视觉生成中扩展RLHF的稳健且通用的解决方案,并为协调RL与视觉合成提供了新的见解。

1.【引言】

生成模型的最新进展——特别是扩散模型和整流流——通过提升图像与视频生成的质量和多样性,革新了视觉内容创作。但是在训练中融入人类反馈使得输出结果与人类偏好及审美标准对齐方面,现有方法各有不足。

ReFL依赖于可微分的奖励模型,显存消耗大,工程投入大;DPO的变体对视觉质量提升有限;

基于强化学习的方法将奖励作为黑盒目标进行优化,提供了潜在的解决方案,但也引入了三个未解决的挑战:(1)整流流模型基于常微分方程的采样与马尔可夫决策过程的形式化存在冲突;(2)先前的策略梯度方法在小规模数据集之外的扩展中表现出不稳定性;(3)现有方法在视频生成任务上尚未得到验证。

DanceGRPO使用随机微分方程重新表述扩散模型和整流流的采样过程,这样可以统一框架,使得RL可以和马尔可夫决策过程不冲突。同时GRPO的组间比较,会解决不稳定性的问题。同时,该方法的可扩展性良好,可以用奖励模型兼容、Best-N推理扩展等方法优化训练,用初始化噪声等方法防止模型训练时“钻空子”。最终取得了非常良好的效果。

2.【方法】

2.1 前置知识

扩散模型 (Diffusion Model)

扩散过程通过将数据与噪声混合,在时间步长 t内逐渐破坏观测到的数据点 x。扩散模型的前向过程可以定义为:

其中 和

表示噪声进度表(noise schedule)。噪声进度表的设计使得

接近干净数据,而

接近高斯噪声 1。

为了生成一个新样本,我们初始化样本 ,并根据在时间步

的去噪模型输出

,定义扩散模型的采样方程为:

修正流(Rectified Flow)

在修正流(Rectified Flow)中,我们将前向过程视为数据 与噪声项

之间的线性插值:

其中通常定义为高斯噪声。我们定义

为“速度”或“向量场” 。

与扩散模型类似,给定去噪模型在时间步 的输出

,我们可以通过以下方式到达更低的噪声水平

:

尽管扩散模型和整流流有不同的理论基础,但在实践中,它们就像硬币的两面。通过引入变换后的变量 和

,可以将它们的采样过程统一为以下公式:

这种统一的形式也方便后续的建模。

2.2 DanceGRPO

将去噪过程建模为马尔可夫决策过程

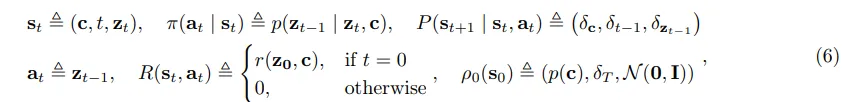

遵循 DDPO 的方法,我们将扩散模型与修正流的去噪过程形式化为一个马尔可夫决策过程:

状态 :

-

定义:

-

这是智能体在每一刻所持有的“全量信息”。它包含三部分:

-

(Condition):提示词(Prompt),即“我们要画什么”,在整个过程中保持不变。

-

(Timestep):当前时间步,即“现在进行到哪一步了”。

-

(Latent):当前的带噪图像/潜变量,即“现在的画布长什么样”。

-

动作 :

-

定义:

-

智能体的动作是直接生成下一时刻的图像状态。简单来说,动作就是模型预测出的“去噪后的下一步结果”。

策略 :

-

定义:

-

策略即生成模型本身(如 UNet 或 Transformer)。它的任务是接收当前状态(Prompt + 噪声图),输出下一个去噪状态的概率分布。强化学习的目标正是优化这个参数化的分布,使其采样的轨迹能获得更高分。

状态转移 :

-

定义:

-

这是一个确定性(Deterministic)的过程,而非概率性的。

-

提示词 c 恒定不变。

-

时间步 t 严格减 1。

-

新的图像状态

完全由智能体的动作

决定。

-

-

这意味环境本身不含随机性,所有的随机性都来自于智能体的策略(Policy)或 SDE 采样过程。

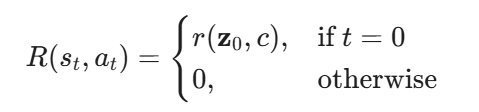

奖励函数 :

这是一个稀疏奖励设置,为了解决稀疏性导致的训练困难,DanceGRPO 在实际算法中会将这个最终奖励回传分摊给路径上的每一个步骤。

初始状态分布 :

-

定义:

-

描述了任务是如何开始的。

-

从提示词库 p(c) 中随机抽取一个 Prompt。

-

时间步重置为最大值 T(完全噪声阶段)。

-

初始图像

从标准高斯分布

中随机采样。

-

采样随机微分方程的形式化

由于GRPO需要通过多条轨迹样本进行随机性探索,且其策略更新依赖于轨迹概率分布及其关联的奖励信号,我们将扩散模型和修正流的采样过程统一为随机微分方程的形式。

对于扩散模型,其前向SDE由以下公式给出:

相应的反向SDE则可表达为:

整流流的前向 ODE 为: 。生成过程是在时间上反转该 ODE。

为了加入随机性,作者参考了随机插值(Stochastic Interpolants)理论,加了两项:加噪声:(引入随机扰动)。修正漂移:

(修正项)。这样实现了SDE形式:

于是实现了扩散模型和整流流在SDE形式上的相对统一。

相关的细节与思考:

1. 目前最先进的视觉生成模型(如 FLUX, HunyuanVideo)中 Rectified Flows 通常使用 ODE 采样器,为什么我们这里要变成SDE形式?

ODE(常微分方程)通常是确定性的——给同样的起点,永远走出同样的路径。相比于传统的扩散模型(往往需要弯弯曲曲的去噪路径),ODE 求解器可以用更少的步数(Steps)从噪声走到图像,极大提升了推理速度 。但是GRPO 是一种RL算法,它需要对同一个提示词(Prompt)生成一组(Group)不同的结果,然后对比哪些结果好,哪些结果差。为了生成不同的结果,模型必须具有随机性(Stochasticity)。把确定性的 ODE 变成带有随机噪声的 SDE,这样一来,对于同一个 Prompt,模型可以生成出微小差异的多种图片/视频。GRPO 就可以在这些差异中探索“更符合人类审美”或“动态更好”的轨迹,并强化它。这也解决了Rectified Flow(整流流)通常使用的ODE(常微分方程)采样是确定性的,与强化学习(RL)所依赖的马尔可夫决策过程(MDP)存在根本性冲突的问题。

2. 从ODE转用 SDE 会有负面影响吗?

会有影响,主要在训练阶段,为了使用 GRPO,必须引入随机性,让模型针对同一个 Prompt 产出不同的结果供比较,所以必须引入 SDE 。其中噪声水平很关键: 论文在消融实验中发现,如果噪声太小,模型性能会显著下降(因为探索不够);如果噪声太大(>0.3),生成的图像会变得嘈杂 。因此,SDE 的引入是对画面质量和探索能力的一个权衡(Trade-off)。推理阶段可以切回 ODE: 值得注意的是,论文中的图表和评估通常使用 ODE 采样器来进行可视化 。也就是说,训练时用 SDE 来“练功”,一旦模型参数(权重)更新好了,推理时依然可以用高效的 ODE 来生成高质量图像。

3. 对公式的一些细节的理解:

扩散模型:增加了一个系数 。

:这是Score Function(分数函数),可以理解为“去噪的方向”,指引图像从模糊变清晰。

:这是噪声项。关键点: 如果

,这就退化成了确定性的 ODE 采样;如果

,采样过程就会带有随机性,生成的图像每次都会有细微不同。这正是 RL 训练需要的。

整流流:整流流的 SDE 化(本文亮点)这是本文的一个重要贡献点。噪声项使得其生成具有随机性,但如果只加噪声而不修改前面的漂移项,生成的图像就会偏离正确的分布(变糊或失真)。修正漂移项 利用“分数函数”把因为加噪声而偏离的轨迹“拉”回来,保证在增加随机性的同时,图像依然是合理的。从数学上讲,这是为了让加入噪声后的 SDE 的边缘概率分布,依然能和原本的 ODE 保持一致(或者说和扩散模型的分布匹配) 。

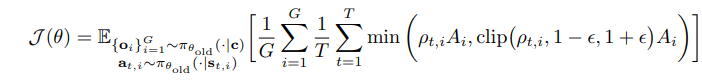

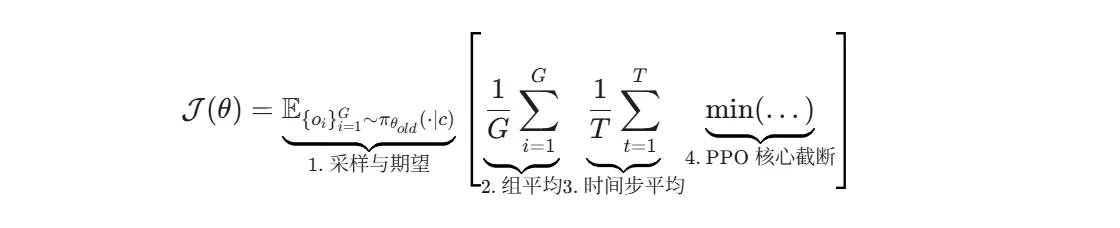

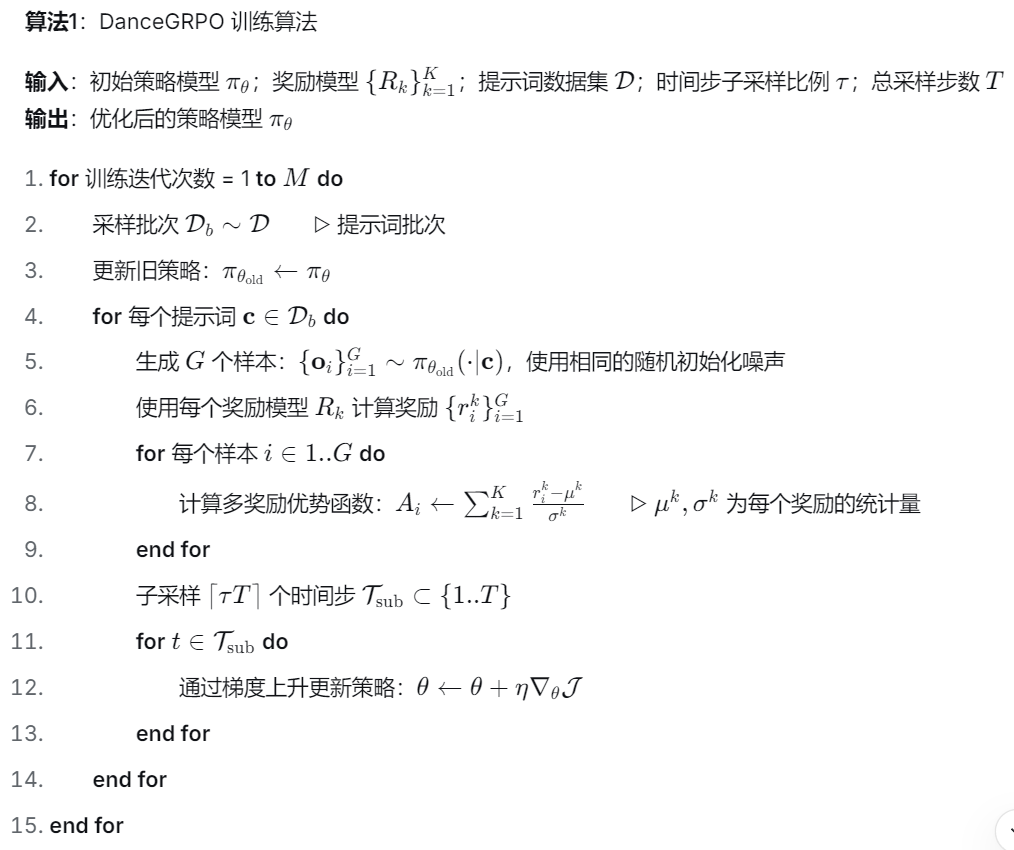

算法

具体解释:

针对给定的提示词(Prompt),使用旧的策略模型( ,即更新前的模型参数)生成 一组(Group) 输出结果, 最大化的是这些采样样本的平均表现。 对组取平均,对时间步去平均,最后加上类似PPO的裁剪。

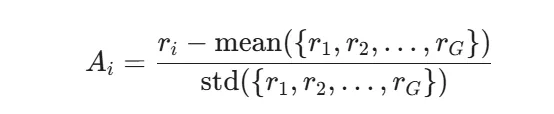

优势函数如下:

文章附录 C 中介还绍了如何使用无分类器引导进行训练。总而言之,将扩散模型和整流流的采样过程形式化为 MDP,使用 SDE 采样方程,采用 GRPO 风格的目标函数,并将其推广到文本生成图像、文本生成视频和图像生成视频任务。

一些trick:

初始噪声 (Initialization Noise)

论文指出(见 Figure 8),在视频生成中,如果同一组 Prompt 下的样本使用不同的初始噪声,会导致 Reward Hacking(奖励黑客)。模型会去记忆“哪个噪声运气好”,而不是学习“怎么画好”。

解决:共享初始噪声 (Shared Initialization Noise)。

对于同一个 Prompt 生成的一组(G个)样本,强制它们使用完全相同的初始噪声 z_T。样本之间的差异完全来自于 SDE 采样过程中的随机项(我们在前几轮讨论的 epsilon_t)。这迫使模型去优化生成路径,而不是依赖初始的运气。初始噪声一样,生成结果的差异完全来自于采样过程中的随机漂移(SDE 的 ϵ_t)

时间步选择 (Timestep Selection)

问题:每张图都要反向传播 T 步(比如 50 步),计算量太大了,显存吃不消。

解决:随机丢弃。经验表明,不需要训练所有的时间步。随机挑选一部分(Subset)时间步进行梯度更新,既能保证效果,又能大幅提升训练效率。

多奖励模型 (Multiple Reward Models)

问题:如果只优化“美学评分”(HPS),模型生成的图会很奇怪(文中称为 "oily",油腻感)。

解决:结合多个奖励模型(例如 HPS + CLIP Score)。

技巧:不直接把分数加起来(因为不同模型的分数范围不同,比如 0.1 和 100 没法加)。

做法:把它们的优势函数加起来。因为已经被归一化了(均值为0,方差为1),所以可以直接相加。这让优化更平稳。

Best-of-N 推理扩展

这是一个进阶策略。先生成一大堆样本(比如 N 个),然后只挑出最好的 k 个和最差的 k 个来训练模型 。

逻辑:最好的样本提供了正向信号,最差的样本提供了关键的负向信号(告诉模型绝对不要这样做),这样训练效率最高 。

省略 KL 正则化 (Dropping KL)

常规做法:通常 RL 会加一个 KL 散度惩罚,防止模型偏离原始模型太远。

作者发现:在他们的设置下,加不加 KL 效果差不多(minimal performance differences)。

相关的细节与思考:

1. 同样是RL,GRPO 跟 DDPO 的不同?

GRPO 比 DDPO 更适合视觉生成。DDPO需要一个critic, 因为要维护和更新额外的 Critic 网络,所以显存占用更高,在大规模数据集上稳定性差, 对 Rectified Flow 不兼容。DanceGRPO 实际上是把 DeepSeek-R1 在大语言模型中使用的“去 Critic”思路,成功移植到了视觉生成领域,并通过推导正确的 SDE 公式解决了数学上的兼容性问题。

2.为什么组内平均会是有效的?不会丢失全局信息吗?不会出现过拟合吗?

丢弃全局 Critic 网络,只在组内(Group)做比较,看起来确实像是“管中窥豹”,容易丢失全局视野。 但在强化学习(特别是针对大模型微调)的语境下,这边论文证明这种做法不仅有效,反而是解决方差(Variance)和训练稳定性的关键。

1. 为什么“组内平均”是有效的?(它是如何指引方向的?)在强化学习中,我们的核心目标是算出优势函数(Advantage):即“当前的动作比‘平均水平’好多少?”。传统方法 (DDPO/PPO) 的痛点:传统方法试图训练一个 Critic 网络来预测这个“平均水平”(全局基线)。但在高维空间(如视频/图像生成)中,训练一个能准确预测所有 Prompt 对应分数的 Critic 非常困难且昂贵。如果 Critic 估值不准,Actor 就会学歪。GRPO 的逻辑:Prompt 自身的难度是最大的干扰项。不同的 Prompt 天生难度不同。Prompt A(简单):"一只猫" -> 模型随便画都能得 0.9 分。Prompt B(极难):"赛博朋克风格的猫在火星骑车" -> 模型画得很好可能也才得 0.6 分。如果是全局比较: 模型会认为 Prompt A 的样本比 Prompt B 的样本好得多。但实际上,我们在 Prompt B 上取得的 0.6 分可能已经是巨大的进步了。

组内平均的妙处:去基线(De-biasing)。GRPO 对同一个 Prompt 生成一组结果 。通过计算 ,它实际上是在问:“在这个具体的 Prompt 下,这张图是不是比这一批里的其他图更好?”这消除了 Prompt 难度带来的方差,让模型专注于在当前语境下做得更好。

2. 不会丢失全局信息吗?(为什么不需要知道“历史最好水平”?)结论:梯度更新只需要“相对方向”,不需要“绝对数值”。梯度的本质: 策略梯度只需要知道“往哪个方向更新参数能增加奖励”。只要组内有优劣之分(即方差不为 0),就能计算出梯度方向。SDE 保证了局部有多样性:这就是为什么论文花了很大篇幅推导 SDE 。如果使用ODE,组内所有样本都一样,优势函数全为 0,模型就学不到东西。引入 SDE 后,即使是同一个 Prompt,生成的轨迹也有细微差别。GRPO 只需要抓住这些细微差别中好的那个方向,推一把即可。

全局信息在 Reward Model 里:全局的“好坏标准”并不是由 Critic(基线)提供的,而是由 Reward Model(奖励模型) 提供的。无论你在组内怎么比,Reward Model 给出的分数(如 HPS 或 VideoAlign)是基于全局标准的绝对分数。模型就会不断向全局最优逼近。

3. 总结算法是怎么搭配马尔可夫过程和SDE工作的?

马尔可夫过程定义状态和转移过程,SDE使得每一步转移充满多样性,GRPO通过组内比较使得模型更符合人类偏好,同时通过裁剪防止变化过大。

2.3 应用于不同奖励的不同任务

在两种生成范式(扩散模型/整流流)和三种任务(文生图、文生视频、图生视频)中验证了我们算法的有效性。为此,我们选择了四个基础模型进行实验:Stable Diffusion(扩散模型,文生图)、HunyuanVideo(整流流,文生视频)、FLUX(整流流,文生图)和 SkyReels-I2V(整流流,图生视频)。 所有这些方法的采样过程都可以被精确地构建在 MDP(马尔可夫决策过程) 的框架内。这使我们能够统一这些任务的理论基础,并通过 DanceGRPO 对其进行改进。这是首个将统一框架应用于如此多样的视觉生成任务的工作 。

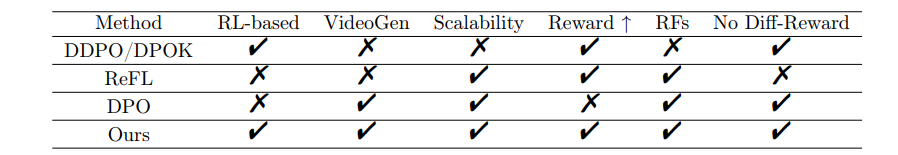

对齐方法的关键能力对比 (Table 1 Comparison)

DanceGRPO 是唯一的“全能选手”,特别是在视频生成和Rectified Flows (RFs) 支持上,同时解决了 RL 方法通常面临的扩展性差的问题

2.4 对比 DDPO, DPOK, ReFL, DPO

我们的方法在所有评估维度上实现了全方位优势:(1)无缝视频生成能力,(2)大规模数据集可扩展性,(3)显著的奖励提升,(4)与整流流的原生兼容性,以及(5)不依赖可微分的奖励函数。这一综合能力特征(任何单一基线方法DDPO/DPOK/ReFL/DPO均无法实现)使得我们能够在保持训练稳定性的同时,在多个生成领域进行同步优化。

3.【实验】

DanceGRPO在文生图、文生视频和图生视频三大战场同时开火。在最考验稳定性的视频任务中,DanceGRPO 不仅跑通了训练,更让 HunyuanVideo 的动作流畅度(MQ)暴涨 181%,实现了画质与动态的双重飞跃。更重要的是,通过引入 Best-of-N Scaling 和时间步剪枝策略,该算法证明了强化学习在视觉生成中同样遵循 Scaling Law——只要算力足够,效果还能更好。

4.【相关工作】

大语言模型对齐:

通常,大模型(LLM)通过 RLHF 进行对齐。标准流程是:先训练一个“奖励模型”来模仿人类喜好,然后用强化学习算法(如 PPO)来优化生成策略 。相关的,策略梯度方法 (Policy Gradient, 如 PPO): 效果很好,但计算贵,且超参数很难调 。DPO (Direct Policy Optimization): 省钱省事,它不需要训练奖励模型,直接在数据上优化。但它 “始终不如策略梯度方法表现”(consistently underperforms)。

而DeepSeek-R1 证明了,只要给大规模强化学习(使用 GRPO 算法)设定简单的规则奖励(比如格式对不对、答案对不对),模型就能 “涌现” (self-emergence) 出像人类一样的思维链(Chain-of-Thought)。以此为灵感,DanceGRPO 试图在视觉模型里发挥大模型的”自涌“能力。

扩散模型与整流流的对齐:

扩散模型和整流流也能从与RLHF显著受益,但与LLMs相比,这方面的探索仍处于初级阶段。

DPO 类 (DPO-style): 如 Diffusion-DPO。虽然流行,但效果一般。

直接反向传播 (Direct Backpropagation): 如 ReFL。它计算奖励对图像的梯度。缺点是显存消耗大,且必须要求奖励模型是可微的(Differentiable)。

策略梯度类 (Policy Gradient): 如 DDPO 和 DPOK。这本来应该是最强的(类似 LLM 里的 PPO),但它们有一个致命弱点——不稳定。特别是在大规模数据集上训练时,这些方法很容易崩溃 。

DanceGRPO 的贡献: 它解决了策略梯度方法(Policy Gradient)在大规模视觉生成中的 “不稳定性” (instability) 和 “扩展性” (scalability) 问题 。它实现了优化和“大一统”。

5.【结论与展望】

DanceGRPO 将 GRPO 算法成功整合到视觉生成领域的,打破语言模型和视觉生成模型的壁垒。

它统一了框架, 既支持 扩散模型 (Diffusion Models),也支持 整流流 (Rectified Flows)。 覆盖了 文生图 (text-to-image)、文生视频 (text-to-video) 以及图生视频 (image-to-video) 三大主流任务。同时解决了之前方法(如 DDPO、ReFL)不稳定性、显存消耗大等问题 ,在视觉保真度、 运动质量、 图文一致性上有了实质进步。

未来方向:多模态领域应用GRPO、在生成式的AI领域,统一优化范式。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)