改造残差链接,DeepSeek开年新作开启架构新篇章

AI科技圈最近一周又发生了啥?

AI科技圈最近一周又发生了啥?

智元机器人发布Q1人形机器人,全球首款小尺寸全身力控机型,可塞入书包

智元机器人推出全球首款小尺寸全身力控人形机器人Q1,体积小到可放入书包,采用模块化设计,支持头部整体更换与零门槛动作编排。Q1基于QDD(准直驱)关节技术,将高性能力控执行器压缩至鸡蛋大小,在保持全尺寸人形机器人能力的同时显著降低科研成本与交互门槛。该机器人面向高校、创业团队开放开发接口,并支持3D打印定制外观,适用于科研与硬核潮玩场景。公司已实现5000台机器人量产下线,产品覆盖工业、服务与消费三大系列

https://mp.weixin.qq.com/s/9r5lAhuH0UPMNqbPb1E1xg

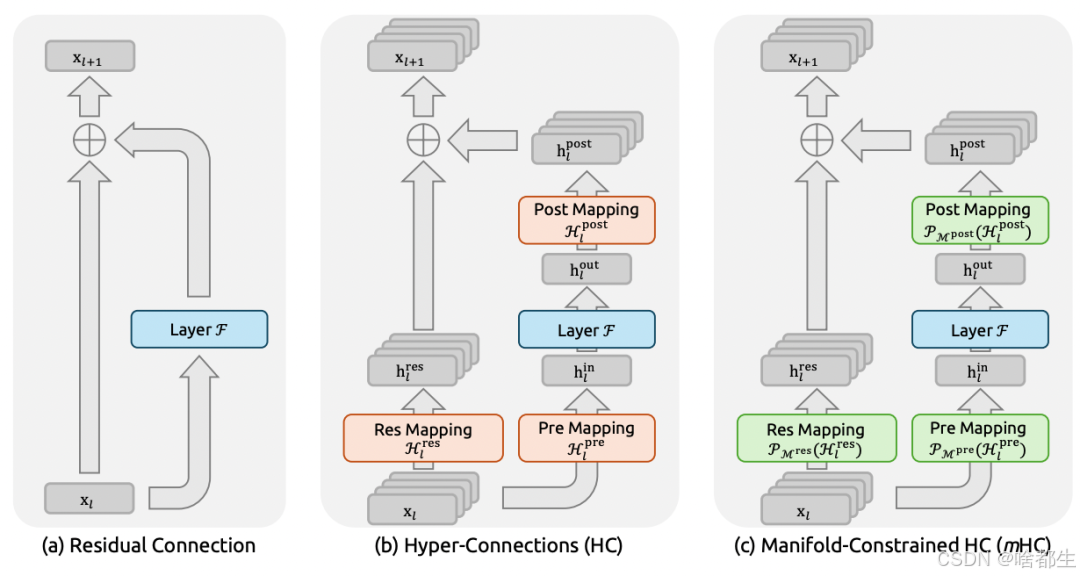

DeepSeek提出mHC新架构

DeepSeek团队提出名为mHC(Manifold-Constrained Hyper-Connections,流形约束超连接)的新架构,在保留超连接(HC)性能优势的同时,通过将残差连接矩阵约束在双随机矩阵流形(Birkhoff多胞形)上,恢复恒等映射属性,有效缓解信号爆炸与梯度不稳定问题。该方法结合Sinkhorn-Knopp算法实现流形投影,并配套内核融合、选择性重计算和扩展DualPipe通信策略,使27B模型在4倍通道扩展下仅增加6.7%训练时间开销。实验显示,mHC在训练损失、梯度范数稳定性及下游任务性能(如BBH和DROP分别提升2.1%和2.3%)上均优于基线与原始HC,且在3B至27B规模及不同Token量下保持良好扩展性

https://arxiv.org/pdf/2512.24880

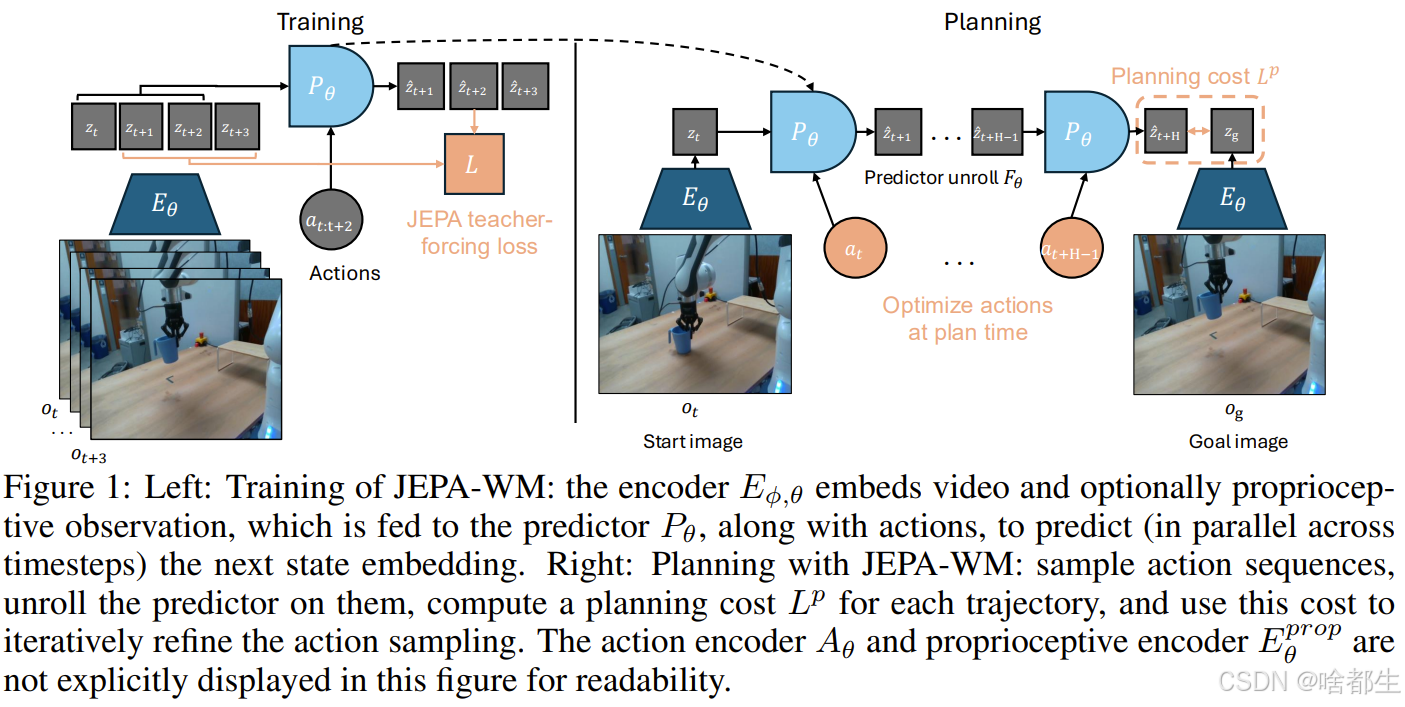

LeCun在Meta还有论文:JEPA物理规划的「终极指南」

Yann LeCun参与的Meta FAIR团队提出JEPA-WM(联合嵌入预测世界模型)框架,系统研究驱动物理规划成功的核心要素。该模型在抽象表征空间而非像素级进行预测,采用预训练ViT(如DINOv2/v3)作为视觉编码器,结合本体感受编码器、动作编码器和多步预测器,在Metaworld、Push-T、PointMaze及真实机械臂数据集DROID上验证有效性。实验表明:引入本体感受信息可提升规划成功率;DINO系列编码器显著优于视频编码器;AdaLN动作调节方式性能最强;上下文窗口W=2为最佳起点,过长反而有害;模型规模在简单任务中无益,但在DROID等复杂现实场景中越大越好

https://arxiv.org/abs/2512.24497

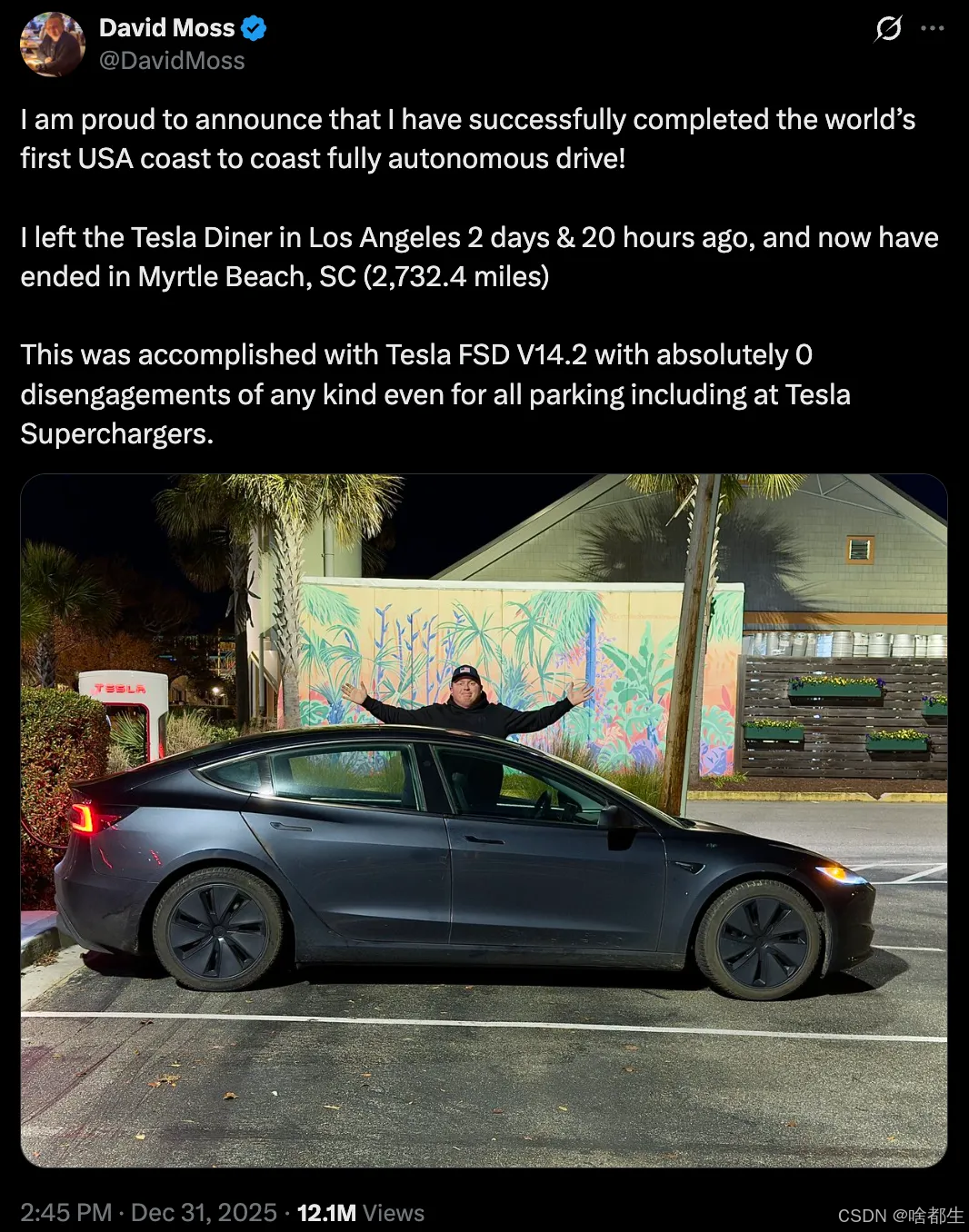

特斯拉FSD V14.2实现首次横跨美国零干预驾驶,全程2732英里无接管

David Moss驾驶搭载FSD V14.2的2025款Model 3,完成全球首次从洛杉矶到南卡罗来纳州Myrtle Beach的全自动驾驶穿越,全程2732.4英里(约4400公里),耗时2天20小时,包括超级充电站停车与充电在内的所有操作均未进行人工干预。其FSD累计行驶里程已超1万英里且从未手动驾驶,相关数据可通过Whole Mars数据库公开验证。特斯拉AI主管Ashok Elluswamy确认这是世界首例全自动海岸到海岸驾驶,马斯克转发称“Cool”。FSD V14.2在复杂路口、无保护左转等场景表现更果断,虽仍属L2级系统,但真实道路完成度显著提升

https://x.com/DavidMoss/status/2006255297212358686

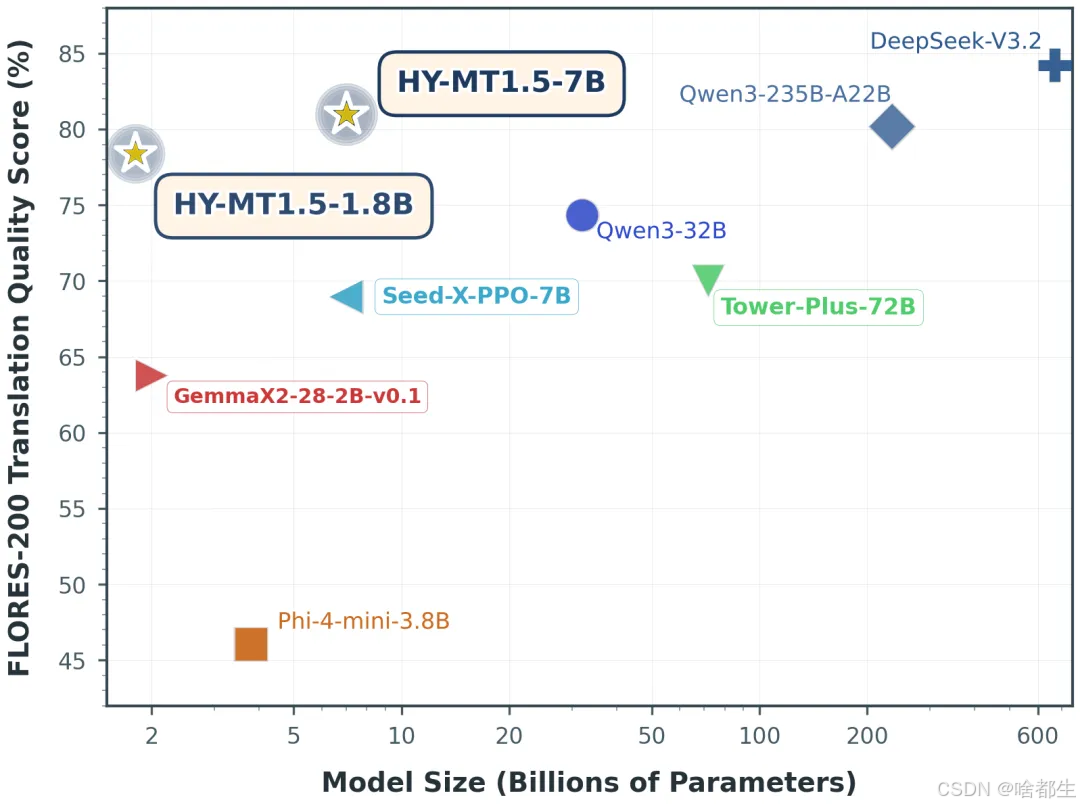

腾讯混元开源翻译模型1.5

腾讯混元开源HY-MT1.5系列翻译模型,包含1.8B和7B两个版本,支持33种语言互译及5种民汉/方言。其中HY-MT1.5-1.8B经量化后仅需1GB内存即可在手机等端侧设备流畅运行,处理50个tokens平均耗时0.18秒,在Flores200、WMT25等测试中全面超越主流商用API,达到Gemini-3.0-Pro约90%的水平;HY-MT1.5-7B为WMT25比赛30个语种冠军模型的升级版,显著减少译文夹杂注释和语种混杂问题。两模型均支持术语库自定义、长上下文对话翻译及带格式文本(如网页)的精准转换,并已在GitHub、Hugging Face及混元官网开放下载

https://github.com/Tencent-Hunyuan/HY-MT

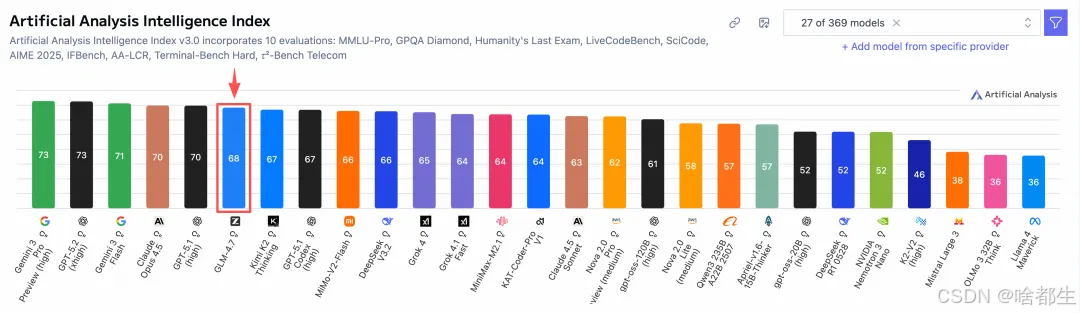

智谱GLM-4.7登顶Artificial Analysis全球开源模型榜首

智谱AI推出的GLM-4.7在Artificial Analysis Intelligence Index(AA智能指数)评测中以68分的综合成绩,位居全球开源模型与国产模型双料第一、全球第六。该榜单重点评估模型在知识储备、逻辑推理、代码生成及Agent(智能体)等核心能力,被业界视为衡量大模型综合实力的重要风向标。GLM-4.7已在智谱开放平台bigmodel.cn上线

https://artificialanalysis.ai/models/glm-4-7

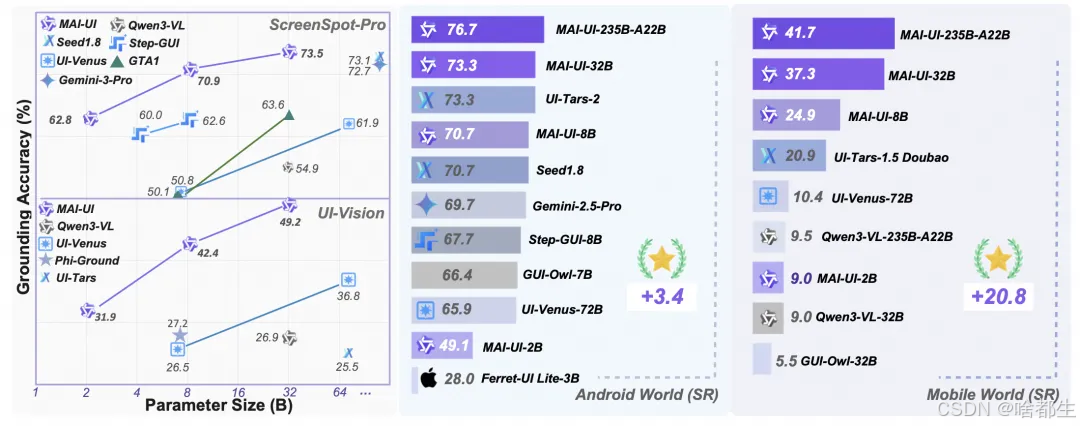

通义实验室开源MAI-UI,登顶5项GUI智能体评测

通义实验室发布并开源通用GUI智能体基座模型MAI-UI,提供2B、8B、32B和235B-A22B等多尺寸版本,在ScreenSpot-Pro、AndroidWorld、MobileWorld等5个权威评测集上全部刷新SOTA。其中MAI-UI-32B在ScreenSpot-Pro准确率达73.5%,在MobileWorld的Agent–User Interaction子任务成功率51.1%(领先最佳端到端模型18.7个百分点),MCP工具调用子任务成功率37.5%(提升32.1个百分点)。模型原生集成用户主动提问、MCP结构化工具调用和端云协同架构,支持跨App操作、模糊指令澄清与隐私敏感任务本地执行,并同步推出高难度真实场景评测基准MobileWorld,包含平均27.8步长程任务、60%以上需跨App协作,以及首创的交互式与MCP-GUI混合任务

https://github.com/Tongyi-MAI/MAI-UI

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)