企业数据仓库设计踩坑实录:AI应用架构师花300万买的教训,全分享

面向主题:围绕“销售”“库存”“用户”等业务主题组织数据,而不是按“ERP系统”“CRM系统”等源系统划分;集成性:把不同源系统的异构数据(比如Excel的订单、MySQL的用户、POS的支付)清洗、转换后,统一成一致的格式;稳定性:数据一旦存入,就不会被修改(比如2023年的订单数据,永远是2023年的样子);随时间变化:保留历史数据(比如近3年的订单),支持“趋势分析”(比如对比今年和去年的双

企业数据仓库设计踩坑实录:AI应用架构师花300万买的教训,全分享

一、引言:300万学费换回来的“清醒时刻”

2022年的夏天,我坐在客户会议室里,手心全是汗——面前的PPT上,项目超支312万、延期187天的红色数字格外刺眼。作为主导这家零售企业数据仓库重构的AI应用架构师,我刚经历了职业生涯最崩溃的时刻:

- 业务部门说“报表加载要5分钟,根本没法用”;

- 数据分析师发现15%的订单缺失“支付时间”,导致复购率分析完全错误;

- 老板拍着桌子问:“花了这么多钱,为什么AI模型连最基本的库存预测都做不准?”

那一刻我突然明白:数据仓库不是“技术人的玩具”,而是连接业务与数据的“桥梁”——桥没搭对,再厉害的AI模型也会“踩空”,再完美的技术方案也会变成“摆设”。

这篇文章,我会把当时踩过的5个致命坑、交过的300万学费,拆成“场景+决策+后果+修复方案”,一字一句讲给你听。如果你正在做企业数据仓库设计,或打算启动相关项目,这篇文章能帮你避开90%的“不必要代价”。

1.1 为什么数据仓库设计容不得“试错”?

在AI时代,企业的核心竞争力早已从“技术”转向“数据驱动的决策能力”——而数据仓库,就是这个能力的“底层基建”:

- 它是数据的“集散地”:把分散在ERP、CRM、POS等系统的零散数据,整合为“可分析的结构化数据”;

- 它是AI的“燃料库”:AI模型需要的“历史订单数据”“用户行为数据”“库存变动数据”,都得从数据仓库里取;

- 它是业务的“指挥棒”:CEO要看的“月度营收报表”、运营要做的“促销活动分析”、供应链要调的“库存策略”,都依赖数据仓库的输出。

但数据仓库的设计,错一步就是“牵一发而动全身”:比如schema设计失误,会导致查询性能暴跌;数据质量没管控,会让分析结果误导决策;需求没对齐,会让整个项目变成“无用功”。

我当年的300万学费,恰恰栽在这三个“没做好”上。

1.2 本文能给你什么?

读完这篇文章,你会明白:

- 如何避免“需求 mismatch”:不再听业务部门的“表面需求”,而是挖到“核心痛点”;

- 如何设计“好用的schema”:平衡“规范化”与“查询性能”,不再为“冗余数据”纠结;

- 如何管控“数据质量”:从“事后救火”到“事前预防”,不让错误数据流入业务;

- 如何规划“性能与成本”:避免“临时扩容”的尴尬,用“弹性架构”应对数据增长;

- 如何让AI“赋能”而不是“添乱”:不再为了“AI”而AI,而是用AI解决真实业务问题。

二、基础铺垫:先搞懂数据仓库的“底层逻辑”

在讲踩坑之前,先补几个必懂的基础概念——这些概念没搞清楚,后面的坑你一定会踩。

2.1 数据仓库的核心定义:Inmon的“四个特征”

数据仓库之父Bill Inmon对数据仓库的定义,至今仍是行业共识:

- 面向主题:围绕“销售”“库存”“用户”等业务主题组织数据,而不是按“ERP系统”“CRM系统”等源系统划分;

- 集成性:把不同源系统的异构数据(比如Excel的订单、MySQL的用户、POS的支付)清洗、转换后,统一成一致的格式;

- 稳定性:数据一旦存入,就不会被修改(比如2023年的订单数据,永远是2023年的样子);

- 随时间变化:保留历史数据(比如近3年的订单),支持“趋势分析”(比如对比今年和去年的双11营收)。

2.2 关键概念对比:别再混淆这些“易错题”

(1)OLTP vs OLAP:数据仓库是“分析用的”,不是“交易用的”

- OLTP(在线交易处理):比如电商的“下订单”“支付”功能,要求“快”(毫秒级响应)、“准”(不能丢数据),用的是MySQL、Oracle等关系型数据库;

- OLAP(在线分析处理):比如“分析近3个月的用户复购率”“对比不同区域的库存周转”,要求“支持多维度查询”“处理大量数据”,用的是Snowflake、BigQuery、ClickHouse等数据仓库工具。

踩坑预警:很多企业用OLTP数据库做OLAP分析(比如用MySQL查近1年的订单),结果就是“查询慢到崩溃”——这是最基础的“用错工具”错误。

(2)星型schema vs 雪花schema:选对结构,性能提升80%

数据仓库的核心结构是“事实表+维度表”:

- 事实表:存储“业务事件”的详细数据(比如订单表:订单ID、用户ID、商品ID、金额、时间);

- 维度表:存储“描述性信息”(比如用户表:用户ID、姓名、性别、地域;商品表:商品ID、名称、分类、价格)。

两种常见的schema设计:

- 星型schema:事实表直接关联维度表(比如订单表→用户表、订单表→商品表),像“太阳+行星”,查询快(关联少),但数据冗余(比如商品分类会重复存到每个订单里);

- 雪花schema:维度表再拆分成子维度表(比如商品表→商品分类表→分类类型表),像“太阳+行星+卫星”,冗余少,但查询慢(关联多)。

结论:企业数据仓库优先选星型schema——因为分析场景更看重“查询性能”,冗余的存储成本远低于“业务等待的时间成本”。

(3)ETL vs ELT:云时代,ELT才是趋势

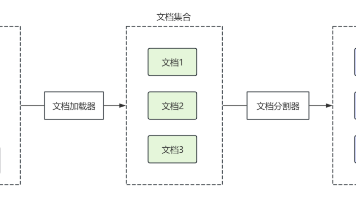

- ETL:Extract(提取)→Transform(转换)→Load(加载):先把数据从源系统提取出来,做清洗、转换(比如把“性别”从“男/女”转成“1/0”),再加载到数据仓库;

- ELT:Extract→Load→Transform:先把原始数据加载到数据仓库,再用数据仓库的计算能力做转换(比如用Snowflake的SQL做清洗)。

踩坑预警:传统ETL适合“小数据量”,但云时代数据量暴增,ETL的“转换阶段”会成为瓶颈——现在主流的数据仓库(比如Snowflake、BigQuery)都用ELT,因为云的计算资源是弹性的,能轻松处理大规模数据转换。

三、核心踩坑实录:5个致命错误,300万学费

接下来,我会用“场景还原+错误决策+后果+修复方案”的结构,讲我当年踩过的5个最痛的坑——每个坑都有具体的数字、具体的业务影响,绝对不是“泛泛而谈”。

3.1 坑1:需求洞察“浮于表面”,做了个“业务不用的仓库”

场景还原

客户是一家连锁零售企业,有100家线下门店+线上商城。业务部门说:“我们需要一个数据仓库,支持多维度分析,比如按地域、时间、商品分类看营收。”

我当时的决策:按“常规维度”设计——地域(省/市)、时间(年/月/日)、商品分类(一级/二级),然后开发ETL流程,把ERP、POS、电商的数据整合进来。

后果

上线1个月后,业务部门反馈:“这仓库根本没用!”——因为他们的核心痛点是**“商品生命周期管理”(比如新品的“动销率”、旧品的“清仓率”)和“用户分层运营”**(比如“高频用户”的复购率、“沉睡用户”的唤醒效果),但我们的维度表没有“商品生命周期阶段”(新品/成长期/成熟期/衰退期)和“用户分层标签”(高频/中频/低频/沉睡)这两个关键维度。

结果:不得不重新修改维度表,增加了2个月的开发时间,额外花了50万——更惨的是,业务部门对我们失去了信任,后面的需求沟通变得异常艰难。

修复方案:用“5Why+双漏斗”挖到需求本质

后来我学会了**“需求挖掘的两步法”**:

-

第一步:用5Why问出“底层需求”

比如业务部门说“要多维度分析”,我会接着问:- “为什么需要多维度分析?”(答:“想知道哪些商品卖得好”)

- “为什么想知道哪些商品卖得好?”(答:“想优化库存,避免滞销”)

- “为什么优化库存这么重要?”(答:“去年因为滞销,积压了1000万的库存”)

- 最终挖到:核心需求是“通过商品生命周期分析,降低库存积压”。

-

第二步:用“双漏斗”筛选需求优先级

- 业务需求漏斗:收集所有需求→筛选“和核心KPI挂钩的需求”(比如“商品生命周期分析”挂钩“库存周转天数”)→排序“高价值、高频率”的需求;

- 技术需求漏斗:评估需求的“可行性”(能不能拿到数据?)→“成本”(需要多少开发时间?)→“收益”(能帮业务提升多少KPI?)。

总结:数据仓库的需求,永远是“业务驱动”的——不是“技术能做什么”,而是“业务需要什么”。

3.2 坑2:schema设计“过度规范化”,查询慢到业务崩溃

场景还原

为了“减少数据冗余”,我把“商品维度”拆成了4张表:

- 商品基础信息表(商品ID、名称、规格);

- 商品分类表(商品ID、一级分类、二级分类);

- 商品供应商表(商品ID、供应商ID、供应商名称);

- 商品库存状态表(商品ID、库存数量、库存预警线)。

结果:查询“某地区某分类商品的营收”需要关联5张表(订单表→商品基础信息表→商品分类表→地域表→时间表),导致OLAP查询的响应时间从“1秒”变成了“30秒”——业务部门的报表加载要5分钟,根本没法用。

后果

客户的运营总监直接发邮件给我老板:“如果下周还解决不了查询慢的问题,我们就终止合同。”——我不得不连夜修改schema,把商品分类、供应商、库存状态的常用字段合并到“商品主维度表”,变成星型schema。

修改后,查询时间从30秒降到了3秒,但额外花了30万的开发成本(重新跑ETL流程、修改报表),而且因为数据冗余,存储成本增加了20%——但业务部门终于满意了。

修复方案:schema设计的“三原则”

后来我总结了星型schema的设计原则,避免再犯“过度规范化”的错误:

- 维度表要“宽”:把常用的描述性字段都放到主维度表(比如商品表包含“分类”“供应商”“库存状态”),哪怕有冗余;

- 事实表要“细”:颗粒度尽可能小(比如订单表要到“单条订单”,而不是“每日汇总”),这样才能支持多维度钻取(比如从“月度营收”钻取到“某门店某商品的小时营收”);

- 避免“维度爆炸”:维度表的字段不要太多(控制在50个以内),否则会增加查询复杂度——不常用的字段可以放到“扩展维度表”,需要时再关联。

3.3 坑3:忽视数据质量,让错误数据“误导决策”

场景还原

我们把精力都放在了ETL流程的开发上,没做数据质量监控——结果上线3周后,数据分析师发现:15%的订单缺失“支付时间”字段。

原因是:线上商城的支付系统升级时,漏掉了“支付时间”的字段传递,而我们的ETL流程没有做“非空检查”,导致这些数据直接流入了数据仓库。

后果

业务部门用这些数据做了“用户复购率分析”:因为缺失支付时间,系统把“未支付的订单”也算成了“复购”,导致复购率被高估了2倍。基于这个错误结果,业务部门推出了“针对高频用户的满减活动”,但实际上这些“高频用户”大部分是未支付的无效用户——活动损失了200万的营收。

我永远记得客户CFO说的话:“你们的错误,让我们白扔了200万——这比项目超支更让我生气。”

修复方案:搭建“数据质量闭环”

后来我们搭建了数据质量平台,覆盖“数据采集→处理→存储→使用”全流程,核心做了4件事:

-

定义质量规则:针对每个字段,制定“完整性”“准确性”“一致性”“及时性”规则:

- 完整性:支付时间“非空”;

- 准确性:订单金额“大于0”;

- 一致性:用户ID“必须在用户表中存在”;

- 及时性:POS数据“必须在1小时内加载到仓库”。

-

实时监控与告警:用工具(比如Great Expectations、Apache Griffin)实时检查数据质量,一旦违反规则,就触发邮件/钉钉告警,通知运维人员修复。

-

数据溯源:记录每条数据的“来源”(比如来自线上商城的支付系统)、“处理流程”(比如经过了哪些ETL步骤),这样出问题时能快速定位原因。

-

定期审计:每月做一次“数据质量报告”,统计“错误数据占比”“修复率”“影响的业务场景”,倒逼源系统优化(比如让支付系统修复“支付时间”的字段传递问题)。

总结:数据质量是数据仓库的“生命线”——没有“可信的数据”,再漂亮的分析报表都是“垃圾”。

3.4 坑4:性能规划“只看当前”,数据增长导致“系统崩溃”

场景还原

项目启动时,客户的月数据量是50GB,我们用了10个节点的Hadoop集群——结果上线3个月后,数据量增长到了150GB,查询性能暴跌70%:

- 原来1秒的查询,变成了7秒;

- 高峰时段(比如早上9点业务部门查报表),集群CPU利用率达到90%,经常出现“查询超时”。

我们不得不临时扩容,增加了10个节点,花了100万——而且扩容过程中,系统 downtime了2天,影响了业务部门的正常使用。

后果

客户的IT总监说:“你们连最基本的容量规划都没做,这是低级错误。”——我当时脸通红,因为确实没考虑到“数据增长”的问题。

修复方案:用“弹性架构+数据分层”解决性能与成本

后来我学会了**“性能规划的三维度”**:

-

容量规划:按“未来1年”设计

- 问业务部门:“未来1年,数据量会增长多少?”(比如客户说“每月增长10%”);

- 按“未来1年的峰值数据量”设计资源(比如当前50GB/月,1年后是150GB/月,所以初始资源要按150GB设计)。

-

采用“弹性云架构”

- 放弃传统的Hadoop集群,改用云原生的数据仓库(比如Snowflake、BigQuery)——这些工具能“自动扩容”,根据数据量和查询量动态调整计算资源,不用手动加节点。

- 比如Snowflake的“虚拟仓库”(Virtual Warehouse),可以设置“自动暂停”(闲置10分钟后暂停)和“自动缩放”(查询量增加时自动增加节点),既能保证性能,又能降低成本。

-

数据分层:热数据存“高速存储”,冷数据存“低成本存储”

- 把数据分成“热数据”(最近3个月,常用)、“温数据”(3-6个月,偶尔用)、“冷数据”(6个月以上,很少用);

- 热数据存放在SSD等高速存储(比如Snowflake的“Standard”层),保证查询速度;

- 冷数据存放在对象存储(比如AWS S3、阿里云OSS),成本只有高速存储的1/10。

总结:性能优化不是“事后救火”,而是“事前规划”——要为“未来的增长”留有余地,用弹性架构应对变化。

3.5 坑5:AI赋能“盲目跟风”,为了AI而AI

场景还原

作为AI应用架构师,我想“证明自己的价值”,所以在数据仓库里集成了一个“自动异常检测”的AI模型——这个模型需要实时处理所有订单数据,检测“异常订单”(比如金额远超均值的订单)。

结果:模型占用了40%的计算资源,导致正常的查询性能下降;而且业务部门根本不用这个功能——他们说:“我们更需要的是‘准确的历史数据统计’,而不是‘实时的异常检测’。”

后果

客户说:“你们加的AI功能,不仅没用,还拖慢了系统——赶紧拆掉!”——我不得不连夜拆除模型,花了20万的开发成本,而且又一次失去了业务部门的信任。

修复方案:AI赋能的“场景化原则”

后来我明白了:AI不是“加分项”,而是“解决问题的工具”——只有当AI能解决“高价值的业务问题”时,才值得集成到数据仓库里。

我总结了AI与数据仓库融合的三个原则:

-

选对场景:聚焦“高价值、高频率”的问题

- 比如“库存异常预测”(提前预测哪些商品会滞销)、“用户 churn 预测”(提前唤醒即将流失的用户)、“促销效果预测”(预测某场促销活动的营收)——这些场景能直接提升业务KPI,值得投入AI。

-

用“轻量级”集成:避免影响核心流程

- 不要把AI模型直接嵌入数据仓库的核心流程(比如ETL),而是放到“数据集市”层(Data Mart)——数据集市是“面向具体业务部门的小仓库”(比如销售数据集市、库存数据集市),可以针对特定场景做AI处理。

- 比如“库存异常预测”模型,只需要从数据仓库取“商品库存数据”“销售数据”,在数据集市里做离线训练和预测,不会占用数据仓库的核心资源。

-

做“效果验证”:用业务结果说话

- 在上线AI模型前,先做“AB测试”:比如选10个门店用AI模型预测库存,另外10个门店用传统方法,对比“库存周转天数”“滞销金额”——如果AI模型能降低20%的滞销金额,再全面推广。

总结:AI的价值,在于“解决业务问题”,而不是“展示技术能力”——别为了“AI”而AI,否则只会“添乱”。

四、进阶:数据仓库设计的“最佳实践”

踩过这些坑后,我总结了企业数据仓库设计的“10条黄金法则”——这些法则是用300万学费换回来的,每一条都经过了实战验证:

4.1 需求阶段:“业务对齐”是第一优先级

- 永远用**“业务KPI”**驱动需求(比如“降低库存周转天数”“提升用户复购率”),而不是“技术指标”(比如“支持100并发查询”);

- 需求调研时,要找**“业务一线人员”**(比如门店店长、运营专员),而不是“管理层”——一线人员最清楚真实的痛点;

- 用**“原型验证”**代替“口头承诺”:比如先做一个简单的维度表和报表,让业务部门试用来确认需求。

4.2 schema设计:“星型优先,冗余可控”

- 维度表要“宽”:把常用的描述性字段都放进去,比如商品表包含“分类”“供应商”“库存状态”;

- 事实表要“细”:颗粒度到“单条业务事件”(比如订单、支付、点击),这样才能支持多维度钻取;

- 避免“维度嵌套”:比如不要把“用户地址”拆成“省表”“市表”“区表”,直接放到用户表作为“省”“市”“区”字段。

4.3 数据质量:“全流程监控,闭环管理”

- 定义**“可量化的质量指标”**:比如“支付时间非空率≥99.9%”“订单金额准确性≥99.8%”;

- 用**“自动化工具”**代替“人工检查”:比如Great Expectations(开源)、Talend Data Quality(商业);

- 建立**“数据质量问责制”**:如果源系统(比如支付系统)导致数据质量问题,要倒逼源系统修复,而不是数据仓库“背锅”。

4.4 性能与成本:“弹性+分层”是关键

- 优先选云原生数据仓库(Snowflake、BigQuery、阿里云AnalyticDB),放弃传统的Hadoop集群;

- 做数据分层:热数据(最近3个月)存高速存储,冷数据(6个月以上)存对象存储;

- 优化查询语句:避免“全表扫描”,用“预计算”(比如用Apache Kylin做Cube)提升常用查询的速度。

4.5 AI赋能:“场景化+轻量级+可验证”

- 选**“高ROI”的场景**:比如库存预测、用户 churn 预测、促销效果预测;

- 用**“离线处理”**代替“实时处理”:大部分AI场景不需要实时,离线处理更省资源;

- 做**“效果评估”**:用业务结果(比如“降低了多少滞销金额”)验证AI的价值,而不是“模型准确率”。

五、结论:数据仓库的本质,是“业务与数据的桥梁”

回顾这300万的学费,我最深刻的体会是:数据仓库不是“技术项目”,而是“业务项目”——它的价值,在于帮业务部门“用数据做决策”,而不是“展示技术有多厉害”。

最后,我想给正在做数据仓库设计的你三个建议:

- 慢一点,想清楚需求:不要急于写代码,先花2周时间做需求调研,挖到业务的核心痛点;

- 简单一点,别过度设计:星型schema比雪花schema好用,宽维度表比拆分的维度表好用;

- 务实一点,用业务结果说话:数据仓库的成功,不是“技术指标达标”,而是“业务KPI提升”(比如库存周转天数降低了30%,用户复购率提升了20%)。

最后的话:未来的数据仓库趋势

现在,数据仓库的趋势是**“湖仓一体”**(Data Lakehouse)——把数据仓库的“结构化分析能力”和数据湖的“非结构化存储能力”结合起来,支持“结构化数据(订单、用户)+非结构化数据(图片、视频)”的统一分析。

比如,零售企业可以把“商品图片”(非结构化)存到数据湖,把“商品销售数据”(结构化)存到数据仓库,然后用湖仓一体的工具(比如Databricks、Snowflake Iceberg)分析“商品图片的点击率”和“销售数据”的关联——这就是未来的数据驱动决策。

行动号召:从“梳理问题”开始

如果你正在做数据仓库设计,或打算启动项目,建议你先做三件事:

- 梳理当前的问题:比如有没有“查询慢”“数据质量差”“业务不用”的问题?

- 对齐业务需求:找业务部门聊,挖到“核心KPI”对应的需求;

- 参考本文的最佳实践:比如用星型schema、搭建数据质量平台、选云原生工具。

如果有疑问,欢迎在评论区留言——我会把我知道的都告诉你,帮你避开我踩过的坑。

附:参考资源

- 《数据仓库工具箱》(Kimball著,数据仓库领域的“圣经”);

- Snowflake官方文档(云原生数据仓库的最佳实践);

- Great Expectations(开源数据质量工具);

- Databricks湖仓一体白皮书(未来数据仓库的趋势)。

作者注:这篇文章写的是我真实的踩坑经历,没有半点虚构。希望我的教训能帮你少走弯路——毕竟,用别人的教训成长,比用自己的代价成长,划算多了。

更多推荐

已为社区贡献87条内容

已为社区贡献87条内容

所有评论(0)