MCP五种架构设计模式全面解析:探索AI智能体应用的新思路!

MCP 协议为 AI 应用提供了标准化的交互方式,但在企业级落地过程中,我们面临着诸多挑战,比如:认证鉴权受限、部署模式复杂多样以及技术债务风险等诸多问题。目前,MCP Server 主要有五种架构模式,每种架构各有其独特的优势和劣势,适用于不同的业务场景。

MCP 协议为 AI 应用提供了标准化的交互方式,但在企业级落地过程中,我们面临着诸多挑战,比如:认证鉴权受限、部署模式复杂多样以及技术债务风险等诸多问题。目前,MCP Server 主要有五种架构模式,每种架构各有其独特的优势和劣势,适用于不同的业务场景。

本文详细剖析之。

—1—

MCP 五种架构设计模式

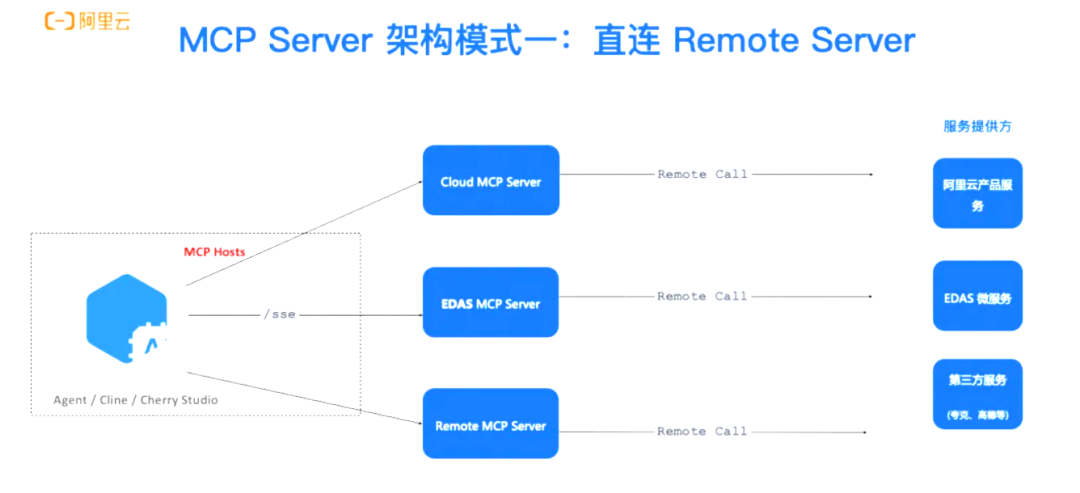

架构设计模式一:MCP Client 直连 Remote Server (SSE)

这种架构设计模式类似于直接给专家打电话咨询问题–MCP Client 通过 SSE 方式与远程 MCP Server 建立直接连接,并保持 HTTP 长连接。

优点:

- 简单高效:无需中间层,部署和维护成本极低;

- 实时性强:模型的流式输出体验极佳,响应迅速;

- 管理便捷:集中化管理使得监控和运维轻松高效;

缺点:

- 网络依赖高:一旦网络不稳定,用户体验将大打折扣;

- 数据隐私问题:所有数据需传输至云端,敏感信息存在泄露风险;

- 安全风险:服务端点直接暴露,容易成为攻击目标;

适用场景:

如果你的应用场景是 SaaS 应用、轻量级客户端或公共云服务,且对安全性的要求相对不高,那么这种架构是一个不错的选择。

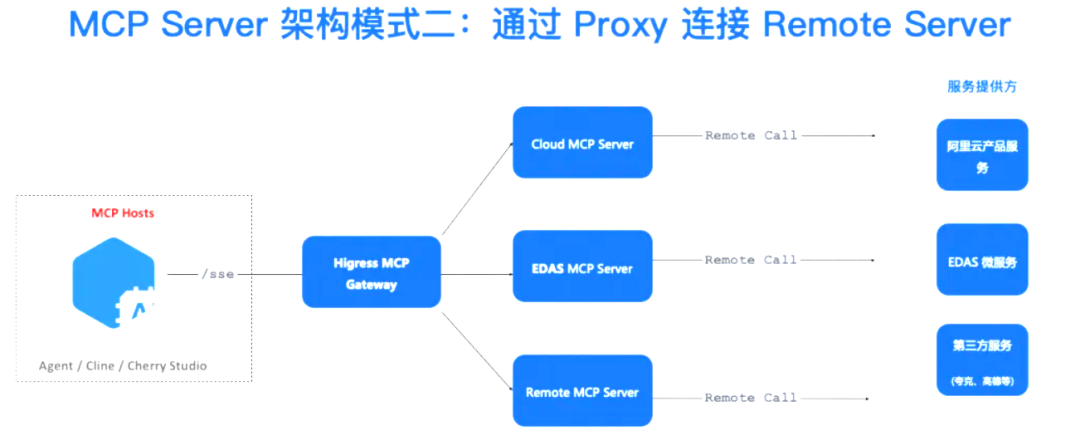

架构设计模式二:MCP Client 通过 Proxy 连接 Remote Server (SSE)

这种架构就好像有一个“翻译”在中间帮助你沟通–MCP Client 首先连接到 Proxy Server,再由 Proxy Server 转发到 Remote Server。

优点:

- 安全可靠:通过代理层可以实现多种安全防护措施,进一步提升安全性;

- 灵活调度:支持智能路由和负载均衡,流量调度更加灵活高效;

- 接口整合:能够聚合多个后端服务,通过一个接口即可访问所有服务;

缺点:

- 架构复杂:引入代理层后,整体架构变得复杂,维护成本相应增加;

- 性能影响:多一层转发可能会增加延迟,对用户体验有一定影响;

- 单点风险:代理层可能成为新的故障点,需要额外关注其高可用性;

适用场景:

如果你处于多租户环境、需要进行企业网关集成,或者需要调用多种模型的场景,这种架构将非常适用。

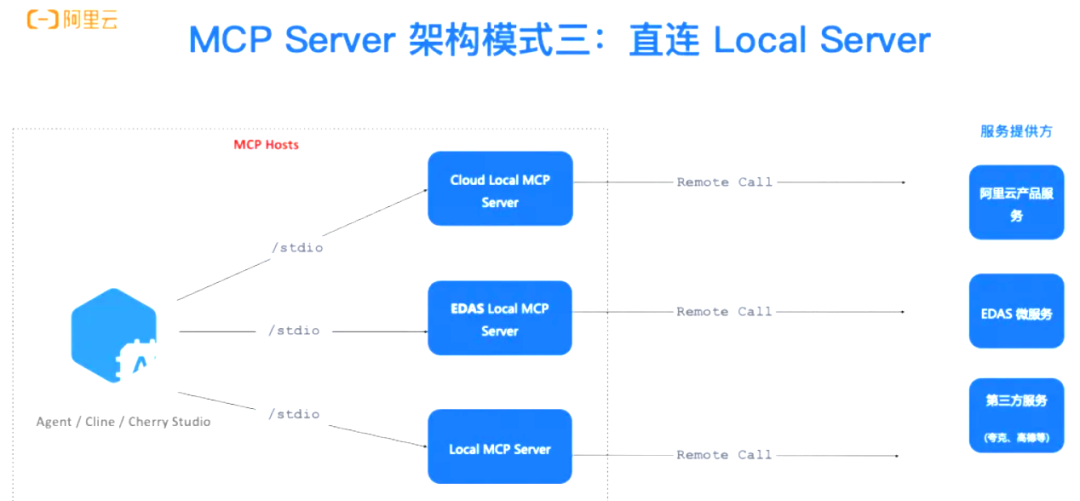

架构设计模式三:MCP Client直连Local Server (STDIO)

这种架构就好比你在家里有了一位私人助理–MCP Client 通过 STDIO 方式直接与本地 MCP Server 连接,实现进程间直接通信。

优点:

- 数据安全无忧:敏感数据完全保留在本地,数据安全性极高;

- 超低延迟:几乎不存在网络延迟,响应速度极快;

- 离线可用:完全支持离线环境,无需依赖外部网络;

缺点:

- 对本地资源要求高:需要强大的本地计算资源才能运行;

- 部署复杂:每个环境都需要单独部署和维护,运维成本较高;

- 更新困难:模型和服务更新需要逐个环境手动操作,维护起来较为繁琐;

适用场景:

如果你的业务涉及金融核心系统、医疗数据分析、工业现场系统等对数据安全和隐私有极高要求的场景,这种架构将是一个理想的选择。

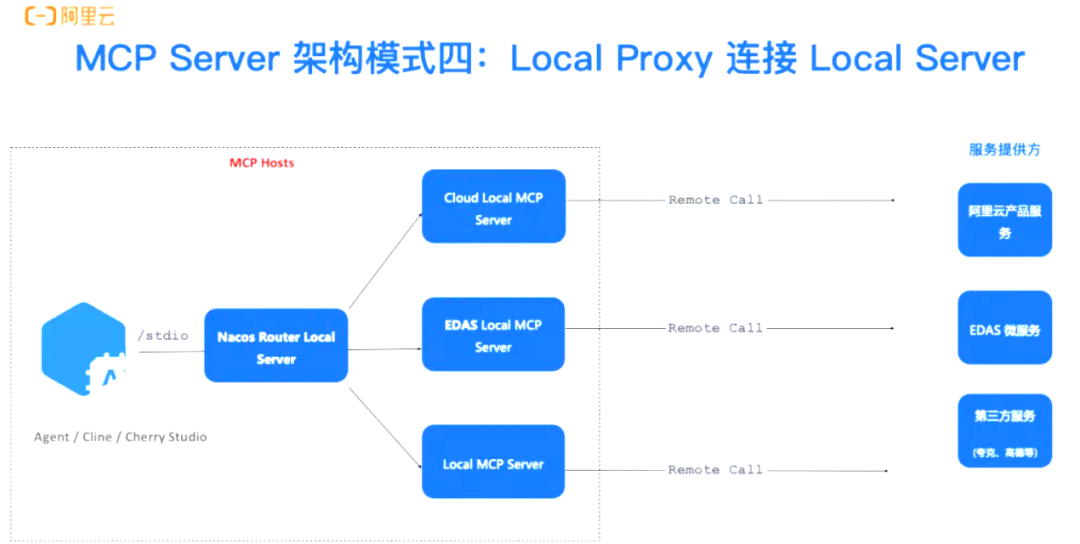

架构设计模式四:MCP Client 通过 Local Proxy 连接 Local Server (STDIO)

这种架构就好比你有一个私人秘书帮你协调多个本地专家–MCP Client 首先连接到 Local Proxy,再由 Proxy 连接到 Local Server。

优点:

- 服务抽象完善:客户端无需关心底层实现细节,使用起来更加便捷;

- 高可用性:支持本地多实例部署,并可自动实现故障转移,确保服务的连续性;

- 资源隔离:能够实现不同业务线或部门之间的资源隔离,保障数据和功能的独立性;

缺点:

- 本地环境复杂:引入代理层后,本地环境的复杂度增加,维护难度也随之上升;

- 资源开销:本地代理需要额外的计算资源来维持运行;

- 问题排查困难:多层架构使得问题定位和调试变得更加复杂;

适用场景:

如果你的业务属于大型企业内部平台、对高可用性有较高要求的场景,或者需要统一管理本地 AI 资源的场景,这种架构将非常合适。

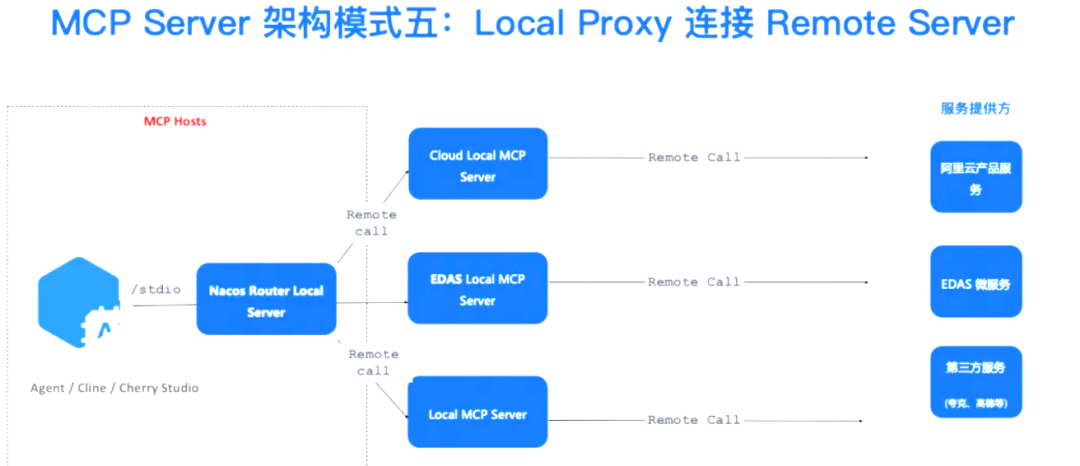

架构设计模式五:MCP Client 通过 Local Proxy 连接 Remote Server (STDIO+SSE)

这种架构就好比你拥有一个超级助手,既能处理本地事务,又能无缝对接外部专家–MCP Client 通过 STDIO 连接到 Local Proxy,而 Local Proxy 再通过 SSE 连接到 Remote Server。

优点:

- 混合云战略的理想选择:能够灵活切换本地和云端资源,满足多样化需求;

- 平滑的云迁移方案:为企业提供从本地到云端的无缝过渡,降低迁移成本;

- 一致的用户体验:客户端无需关心服务的具体位置,始终获得一致的体验;

缺点:

- 架构复杂度高:作为最复杂的架构,维护和故障排查难度极大;

- 服务一致性要求高:需要确保本地和云端服务的高度一致性,否则容易出现兼容性问题;

- 性能依赖网络:整体性能受网络状况影响较大,可能导致体验波动;

适用场景:

如果你的业正在实施混合云战略,或者需要弹性扩展的业务,又或者是需要在全球多区域部署的大型企业,这种架构将是一个强有力的解决方案。

在大模型时代,我们如何有效的去学习大模型?

现如今大模型岗位需求越来越大,但是相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

一直在更新,更多的大模型学习和面试资料已经上传带到CSDN的官方了,有需要的朋友可以扫描下方二维码免费领取【保证100%免费】👇👇

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,下面是我整理好的一套完整的学习路线,希望能够帮助到你们学习AI大模型。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF书籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型各大场景实战案例

结语

【一一AGI大模型学习 所有资源获取处(无偿领取)一一】

所有资料 ⚡️ ,朋友们如果有需要全套 《LLM大模型入门+进阶学习资源包》,扫码获取~

更多推荐

已为社区贡献188条内容

已为社区贡献188条内容

所有评论(0)