【2025年技术总结】从现在到未来,我的全年技术探索日志

2025年技术探索总结:作者回顾了全年60多篇技术文章,呈现出一条从基础工具到AI落地的完整学习路径。上半年聚焦SQL、Python基础和机器学习算法解析,下半年转向深度学习与大模型实践,并深入工程化部署(包括昇腾NPU适配)。通过RAG和AI Agent等新方向探索,实现了从"记结论"到"追根源"的思维转变。展望2026年,计划深耕大模型工程化和AI技术,

2025年过得真快,翻了翻博客后台,不知不觉今年都写了60多篇技术文章了,从最基础的SQL语法到复杂的大模型部署,从Python小玩具到NPU硬件实践,一路踩坑一路总结,回头看竟形成了一条完整的技术探索路径。这一年没有宏大的目标,只是在慢慢的稳步前进,现在回头梳理,竟也有了不少值得回味的收获,当然最让我感到意外的是也从萌新突破成为了万粉博主,在这里也感谢各位的支持。

一、技术路线:从开始到现在

从头捋了一下我的文章,如果用一条线串起今年的文章,大概是“基础工具→机器学习→深度学习→大模型→工程化部署”的递进,每一步都踩在“解决实际问题”的节点上,大致也可以分为以下几个部分:

1. 基础技能

年初的几个月,我把精力放在了“每天都能用但容易踩坑”的基础技能上。SQL系列写了随机取数、数据合并、表字段删除,看似简单的操作,不同数据库(MySQL、PostgreSQL、SQL Server)的实现差异巨大,比如合并数据的GROUP_CONCAT和STRING_AGG,踩了一圈坑才整理出通用方案;还有Python相关的烟花代码、NumPy/Pandas实用指南,甚至补了Git、Docker的基础教程,这些文章的初衷很简单——自己总忘,不如写下来当“电子笔记”,这也为我一直写博客埋下了伏笔。

2. 机器学习

上半年的核心是讲解机器学习算法拆解。从无监督学习的K-Means入手,顺着聚类算法一路深挖,写了凝聚式/分裂式聚类、DBSCAN、OPTICS、HDBSCAN,甚至偏冷门的BIRCH、Mean Shift,每篇都带着实战代码和数据集,慢慢发现“聚类不是调参玄学”——比如HDBSCAN的密度自适应特性,在非结构化数据分类中比DBSCAN更抗噪;然后转向集成学习,把Bagging、Boosting、Stacking拆成三篇,结合直方图梯度提升的实战,让看的人能够搞懂“为什么Boosting容易过拟合”“Stacking的权重分配逻辑”。这部分文章写得最累,但收获最大,让读者从“只会调用sklearn”变成“能解释算法决策过程”,这也是我的第一个专栏(机器学习修仙之旅),也希望可以以后不断的完善,变的更好更完备,能够帮助到更多的初学者。

3. 深度学习与大模型

下半年的重心则完全转向了大模型和深度学习。DeepSeek系列是绝对的主角,从各版本优缺点分析、论文翻译解读,到提示词技巧、蒸馏技术、微信接入,甚至不同参数(1.5B到671B)的差异对比,几乎把这个模型扒了个遍。印象最深的是写蒸馏技术那篇,为了搞懂“小模型如何继承大模型能力”,翻了很多的技术分享文章,也把官方的论文看了又看,才明白“蒸馏不是简单压缩,而是知识迁移的艺术”,写DeepSeek的文章也是我篇阅读量破十万的文章,所以让我也有了更多写下去的勇气;接下来大模型微调系列,从Lora/QLora到LLaMA Factory框架实战,解决了“CUDA非法内存访问”这类实际部署问题,慢慢摸清“微调的核心是数据质量,而非参数数量”。

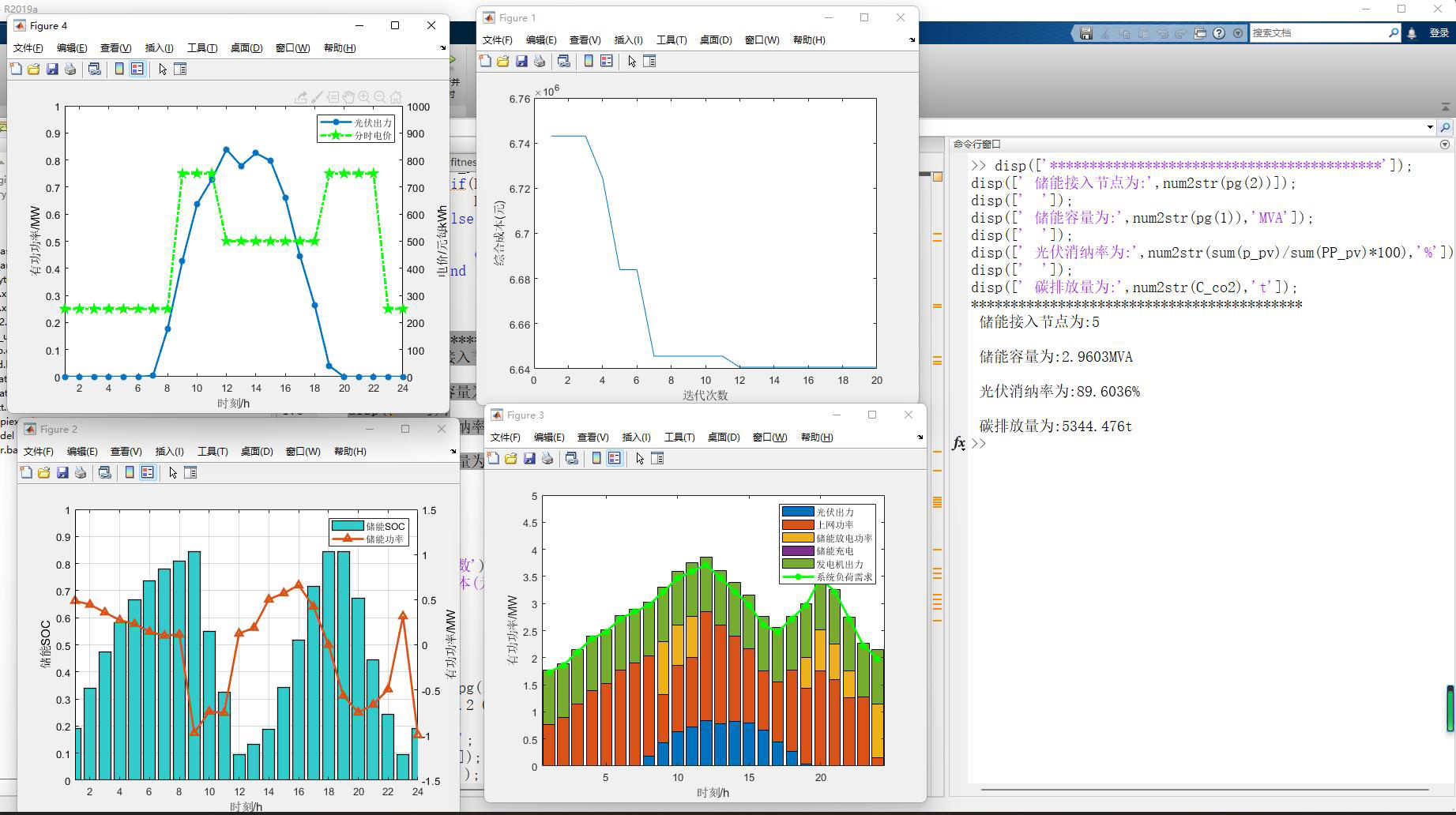

4. 工程化部署

如果说算法是“大脑”,部署就是“让大脑落地走路”。今年写了不少部署相关的文章:RAGFlow、Dify的Windows本地部署,Docker镜像路径修改,云服务器微调模型,还有昇腾NPU的三篇实践(Rnj-1、DeepSeek-OCR、Qwen-Image-Edit-F2P)。最有意思的是昇腾NPU的测试,第一次接触硬件适配,踩了“算子不支持”“显存溢出”的坑,慢慢学会“用bfloat16精度平衡性能与显存”“批量生成提升NPU利用率”,才发现“部署不是末端环节,而是决定模型落地效果的关键”——比如DeepSeek-OCR在NPU上的推理速度,比CPU快了50倍,这是纯算法优化做不到的。

5. 新方向探索

年底尝试写了两个新方向:RAG和AI Agent。拆解了多个开源项目,也慢慢的形成了一个GitHub爆火项目解读的专栏,希望后面可以探索更多的工具分享给大家,后面慢慢喜欢上RAG的简单快捷比微调来说可控性还是很高;最后又开始聚焦解读LangChain v1.0的学习笔记,在今年这个Agent元年随着“Agent”一同爆火的有很多项目,LangChain 无疑是其中最耀眼的,让大家接受“Agent不是简单的‘工具调用’,而是‘任务拆解+决策优化’的闭环”,这可能也是明年的重点方向,现在这部分也想做一个专栏,慢慢写下去,希望会一直坚持到最后。

二、对于成长

今年最大的变化,不是写了多少篇文章,而是心态的转变:

1. 从“记结论”到“追根源”

以前学技术,满足于“知道怎么用”,比如调用DBSCAN时,调参eps和min_samples全靠试;现在会追问“为什么这两个参数重要”“密度阈值的计算逻辑是什么”,写文章时会主动跑对比实验,比如测试不同聚类算法在噪声数据中的表现,用数据说话,而不是照搬文档。

2. 转变工程化思维

以前写代码只关心“能不能跑通”,现在会考虑“能不能部署”“能不能复用”。比如写大模型微调文章时,不仅提供源码,还补充了数据预处理、日志记录、模型保存的规范;部署RAGFlow时,特意加了“连接本地模型”“解决端口冲突”的细节,因为自己踩过“部署成功却无法调用”的坑,知道实际应用中这些“小问题”最磨人。

三、关于未来:继续“慢下来,挖深一点”

2025年的技术探索是“广度优先”,2026年想试试“深度优先”:

1. 聚焦大模型工程化

打算深挖大模型的“端到端落地”,比如AI Agent的任务拆解逻辑、RAG与大模型的融合优化、低代码平台(如Dify)的二次开发,目标是“让非专业开发者也能搭建实用的AI应用”。

2. 深耕AI方面的技术

在AI方向大模型性能优势在大模型推理、边缘计算中很明显,明年想写更多AI的实践,比如用大模型如何优化模型推理速度、开发轻量级部署工具,甚至尝试贡献开源项目。

2025年的技术写作,就像一场自导自演的修行——没有KPI,没有 deadlines,只是凭着兴趣一点点探索。回头看,那些熬夜写的论文解读、跑的实验数据、踩的坑,都变成了自己的“硬实力”。未来不想追求“写得多”,只想“写得深”,希望每篇文章都能解决一个实际问题,每一次探索都能让自己多懂一点“技术背后的逻辑”。

技术之路没有捷径,慢慢来,反而比较快。2026,继续加油~

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)