2025年度技术学习总结:从基础到前沿的全栈成长之路

2025年是技术成长与突破的一年,围绕编程基础、Web开发、算法能力和AI探索四个维度展开。系统学习了Java核心、Python多范式编程,完成前后端分离项目实践,并深入LeetCode算法训练。重点转向NLP和LLM领域,研究Transformer架构、预训练微调等核心技术。全年产出93篇技术博客,涵盖Java、Web、算法和AI内容。展望2026年,计划深耕大模型应用、分布式系统,并参与开源贡

2025,对我而言,是关键词为“沉淀”与“突破”的一年。

这一年,我用一行行代码、一篇篇博文,记录下从 Java 工程基础到 NLP 智能边界的成长轨迹,从巩固核心编程语言,到独立完成完整前后端项目,再到算法刷题与模型架构的进阶研究,每一段学习轨迹,都是对技术热爱的见证。

年终之际,我将这一年的学习历程、项目实践与思维突破,从四个维度进行系统梳理与总结:编程基础构建 | Web 实战开发 | 算法能力提升 | 前沿 AI 技术探索。

一、编程基础构建

1.1 Java

我从 Javase 入门开始,分为三个阶段系统学习:

- 入门篇:掌握数据类型、控制流、

OOP三大基石(继承、封装、多态)、异常处理 - 强化篇:深入集合框架与泛型、高效处理文件IO、掌握多线程与网络编程基础

- 提升篇:着眼并发控制机制(线程池、锁机制、

CAS)、掌握反射与注解的元编程技巧、深入理解 Stream 流与函数式编程思维背后的原理

我不仅关注语法与机制,更注重应用场景与设计理念的落地。例如:在学习线程池时,我探究了其参数调优的工程实践;在理解 Java I/O 结构时,从装饰器设计模式深入分析其背后的选择逻辑。贯穿整个过程,我将笔记博文化,构建出“知识可查、思考可溯”的学习体系。

1.2 伯克利CS61A

我系统学习了加州大学伯克利 CS61A Python 课程,这不仅仅是一门语言课程,更是一次程序设计范式的洗礼。

课程涵盖高阶函数、数据抽象、面向数据驱动的思维模式、多范式整合(函数式、面向对象、逻辑编程等),甚至使用 Scheme 语言推演编程语言的语法解析与计算属性,为我后续理解编译原理与人工智能推理机制打下了扎实基础。

此外,我也撰写了 C/C++ 快速入门内容,为将算法部署在嵌入式或高性能场景中打下基础。

二、 Web 实战开发

2.1 前端开发

从 HTML/CSS/JavaScript 掌握语义化、布局到响应式页面设计,再到 Vue.js 构建组件化界面响应、单页路由与 Ajax 异步数据通信,我逐步构建起前端完整知识体系。

更重要的是,在实战项目中巩固了“前后端分离”的实际开发模式,体会到了用户体验与系统架构的密切关联。

2.2 后端开发

后端方面,我以 SpringBoot 为主线,构建了包含 SSM(Spring + SpringMVC + MyBatis)、JWT 鉴权、AOP 切面日志、数据持久化管理、事务传播机制等完整后端技术体系。

- 数据库:深入掌握了 MySQL 查询优化、事务隔离级别控制、索引设计技巧

- 框架:熟悉

SpringBoot注解驱动开发模式,掌握IoC容器、Bean生命周期管理; - 安全认证:实现

JWT无状态登录认证机制,结合拦截器与统一异常处理

代表性项目包括完整的“员工管理系统”与“部门管理模块”,涉及文件上传下载、前后端路由对接、权限控制、数据一致性处理等典型企业开发场景。我逐步从“功能开发者”转变为“系统思维实践者”,深入体会中大型项目的架构分层与职责解耦。

三、LeetCode 能力提升

今年,我高频聚焦 LeetCode Hot 100 刷题,采用“专题式归类 + 模型化总结”的方式,从题解中提炼算法本质,不只是为了解题,更是为建立一套长效的算法解题思维模型。

覆盖算法模块详情如下:

- 基础数据结构:数组、链表、哈希表、多指针技巧(双指针、滑动窗口)

- 非线性结构:树(层次/前中后遍历)、图(

DFS、BFS、并查集) - 算法

paradigms:动态规划、贪心、回溯、递归、分治 - 实用技巧:位运算、前缀和、状态压缩、

LRU缓存

刷题之外,我强调“解法归纳”与“变式训练”,例如将多个动态规划题归纳为“状态 + 转移 + 初始条件”三维模型,让算法学习从“战术突破”走向“战略掌控”。

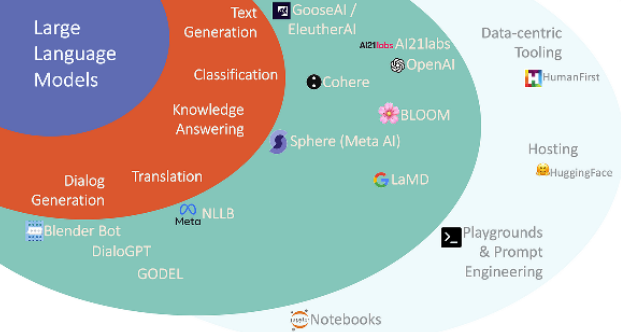

四、前沿 AI 领域探索

4.1 大语言模型理论体系

今年后半年,我将重心转移到 NLP 与大型语言模型(LLM)的理论与实践学习上,这是今年最激动人心的学习内容,我系统学习了LLM的核心技术和模型训练全流程。

系统学习了大型语言模型发展的三阶段,包括无监督预训练(Self-Supervised Learning)、微调策略(Supervised Fine-tuning - SFT)、强化学习人类反馈(RLHF)。学习的内容横跨多个重点模块,包含模型能力评估指标(BLEU/ROUGE/Perplexity)、幻觉控制与可信输出方向研究、语言模型如何进行“推理”,即深入 In-Context Learning,理解 emergence(涌现能力)。还包括安全性维度的数据对抗攻击与隐私泄露防范策略、多模态生成(文生图、图修复等)及 Diffusion 模型初步研究。

通过理论学习与实践调研,我初步构建起从模型构建 → 参数调优 → 安全审查 → 应用部署的闭环认知视角,为未来深入参与 LLM 项目研发与落地打下基础。

4.2 Transformer 架构

我聚焦分析 Transformer 模型的架构模块:

Tokenization:对比BPE、WordPiece、Unigram等子词划分策略Embedding:从One-hot到Word2Vec / GloVe / FastText的语义向量演进Attention:自注意力(Self-Attention)、多头注意力(Multi-Head Attention)Positional Encoding:绝对位置编码、相对位置编码、旋转位置编码

通过代码阅读、框图解析、论文笔记等方式,我进一步理解了为何 Transformer 能成为新一代通用 AI 架构的底座。

五、答卷 · 记录 · 展望

技能树

├── 编程语言

│ ├── Java(精通)

│ └── Python(熟练)

├── Web开发

│ ├── 前端(HTML/CSS/JavaScript/Vue)

│ └── 后端(Spring/MyBatis/SpringBoot)

├── 数据库

│ └── MySQL(设计与优化)

├── 算法

│ └── LeetCode(HOT100)

└── AI前沿

└── LLM理论与Transformer架构

回首 2025 年,我的技术博客累计发布 93 篇,其中,Java 基础与进阶博文占比 35%,Web 全栈项目开发博文占比 30%,算法与面试笔记占比 20%,LLM 与前沿科技梳理占比 15%。

展望 2026 年,我将重点方向聚焦在以下几个核心上。第一,在大模型领域继续深挖,尝试多模态模型、微调实战;第二,全面学习分布式系统原理,补全后端中间件技术栈(消息队列、网关等);第三,可能参与开源项目,向社区贡献文档与代码;第四,准备算法/工程岗位面试,同时保持持续输出知识博文的习惯。

我相信,每一篇认真书写的技术博客,都是成长的注脚,是与更好自己的对话。

代码改变世界的过程,也同样在改变着我。

感谢 CSDN 博客之星给予的平台,也感谢每一位读我博文的朋友。

愿我们在技术这条路上,永远脚踏实地,也心向远方。

2026,我们不见不散!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)