Manus AI技术架构深度解析,CPU与GPU的异构协作革命

《Manus AI技术架构解析:CPU与GPU的异构协作逻辑》 摘要: 本文深入剖析了Manus AI的技术架构,揭示其CPU与GPU的协同工作机制。研究发现,Manus AI采用"云端虚拟机+智能引擎"的异构架构:CPU构建的Firecracker微虚拟机提供安全的执行环境,支持文件系统、网络访问等操作系统功能;GPU集群则专注大模型推理,负责意图理解、任务规划等高阶认知任务

在生成式AI飞速迭代的浪潮中,自治代理(Autonomous Agent)的崛起标志着AI从“对话响应”向“任务执行”的关键跨越。Manus AI作为这一领域的代表性产品,其底层技术架构始终笼罩着一层神秘面纱。用户最关心的核心疑问集中在两点:其标榜的“云端虚拟机”究竟依托何种硬件实现,中央处理器(CPU)与图形处理器(GPU)在复杂任务中又如何分工协作。本文将结合技术文档、架构白皮书及基础设施供应商的核心规格,全面解构Manus AI的技术架构,揭开CPU与GPU异构协作的核心逻辑,同时探讨Meta收购后这一架构的演进方向。

与早期生成式AI专注于“文本输入-文本输出”的交互模式不同,Manus AI实现了从信息生成到任务执行的质的飞跃。它不仅能回答用户的疑问,还能独立编写代码、运行脚本、浏览网页、管理文件系统甚至部署应用程序。这种能力的升级背后,是计算范式的根本性转变,也对底层硬件架构提出了全新要求。AI不再仅仅需要强大的推理能力,更需要一个能够持久化状态、运行复杂逻辑、具备网络访问权限的“数字环境”。而支撑这个环境的硬件选择,以及不同硬件之间的协作模式,正是Manus AI技术架构的核心竞争力所在。

一、云端虚拟机的本质:CPU构筑的执行基石

Manus AI的“云端虚拟机”是其实现任务执行能力的核心载体,诸多用户误以为这一虚拟机可能依托GPU构建,但事实恰恰相反,其底层本质是基于CPU的计算架构。这一设计选择并非技术限制,而是由任务特性、安全性需求与成本效益共同决定的最优解。

Manus AI为每个任务会话都提供了一个独立的“沙箱”环境,这个沙箱必须满足三大核心要求:具备完整的操作系统功能,支持文件系统、网络栈和包管理器,确保代理能像人类程序员一样安装依赖组件;拥有极强的隔离性,防止恶意代码逃逸到宿主机,保障不同用户环境的物理隔离;启动速度极快,需在毫秒级完成初始化,避免用户长时间等待。要满足这些苛刻条件,传统的虚拟化技术或容器技术都存在明显短板。

研究表明,Manus AI的沙箱环境直接构建在E2B平台之上,而E2B的底层核心技术是AWS开源的Firecracker微虚拟机(MicroVM)。Firecracker是一种基于Linux KVM(内核级虚拟机)的轻量级虚拟机监视器,其设计哲学以“极简主义”为核心,这也直接决定了其对CPU的高度依赖性。Firecracker运行在宿主机的用户空间,通过CPU的硬件虚拟化扩展(如Intel VT-x或AMD-V)执行客户机代码,当Manus的虚拟机运行Python代码等任务时,这些指令会直接在物理CPU核心上运行,仅当需要进行特权操作(如I/O请求)时,CPU才会触发“VM Exit”陷阱,将控制权交还给Firecracker。这种硬件级的虚拟化机制,既保证了执行效率,又实现了严格的隔离性。

值得注意的是,Firecracker并不支持GPU直通(GPU Passthrough)。其设计初衷是为无服务器计算场景服务,剥离了所有非必要的设备模拟,如PCI总线、USB控制器、显卡等。若要支持GPU访问,就需要完整的PCI模拟和复杂的IOMMU管理,这会极大增加启动时间和内存开销,与微虚拟机的设计初衷背道而驰。因此,Manus AI的虚拟机在物理上无法直接访问GPU资源,其核心算力来源必然是CPU。

为了更清晰地说明CPU虚拟化为何是最优选择,我们可以对比三种主流技术方案:Docker容器、gVisor沙箱容器与Firecracker微虚拟机。Docker容器采用进程级隔离,共享宿主机内核,安全性较低,容易受到内核漏洞攻击,无法满足运行不受信任AI生成代码的需求;gVisor通过系统调用拦截实现隔离,攻击面较小,但在执行密集型系统调用(如文件I/O)时性能损耗较大;而Firecracker采用硬件级虚拟化,拥有独立内核,隔离级别极高,同时借助CPU指令透传实现较低的性能损耗,启动时间约125ms,完美平衡了安全性、性能与启动速度,是Manus AI这类需要运行任意代码的自治代理的唯一可行解。

Manus AI的“持久化文件系统”同样依托CPU实现,这也是其核心竞争力之一。在Firecracker架构中,虚拟机内部看到的“硬盘”实际上是宿主机上的一个文件,CPU通过virtio-blk驱动程序处理所有的读写请求。当Manus Agent执行文件写入操作时,虚拟机的CPU会触发中断,Firecracker进程捕获该请求后,通过宿主机的CPU将数据写入后端存储介质(如NVMe SSD或网络存储)。根据E2B的文档,沙箱数据可保留14天,这意味着在沙箱休眠时,CPU会负责将虚拟机的文件系统快照上传到对象存储(如AWS S3),并在下次唤醒时快速拉取并挂载,整个过程都是典型的CPU密集型I/O调度任务。

Manus团队提出的“文件系统即上下文”理念,更凸显了CPU在状态管理中的核心作用。由于GPU的上下文窗口有限且使用成本高昂,Manus AI不会将所有历史信息保留在GPU显存中,而是将其序列化为文件存储在持久化文件系统中。此时CPU便充当了“海马体”的角色,负责将短期记忆(内存数据)转录为长期记忆(文件系统数据),当需要检索信息时,CPU会运行检索脚本(如grep或向量搜索),仅将最相关的信息提取出来发送给GPU,极大地降低了GPU的推理负担。

从经济性角度来看,选择CPU作为虚拟机核心算力也具有决定性意义。云端CPU实例(如AWS T3/Graviton)的成本约为每小时0.05-0.50美元,而配备GPU的实例(如NVIDIA A10G)成本起步价约为每小时1.50美元,且大部分时间GPU会处于空闲状态,等待网络响应或用户输入,造成资源浪费。此外,Manus AI虚拟机内运行的任务,如安装Python包、解析CSV文件、抓取HTML内容、编译代码等,均为整数运算和分支逻辑密集型任务,现代CPU的乱序执行和强大的分支预测器专门为此设计,执行效率远超GPU。GPU专为大规模并行浮点运算设计,处理这类串行逻辑的效率极低,用GPU运行虚拟机不仅成本高昂,还会导致性能瓶颈。

二、认知推理的核心:GPU主导的智能引擎

如果说CPU构成了Manus AI的“躯体”,那么GPU就是其“灵魂”。Manus AI理解、规划、生成代码的核心能力,完全依赖于GPU集群的强大算力支撑。GPU在架构中扮演着“离岸大脑”的角色,专注于大语言模型(LLM)的推理与规划,与CPU形成高度解耦的异构协作循环。

Manus AI的智能来源于大语言模型,其早期版本集成了Anthropic的Claude 3.5 Sonnet和Alibaba的Qwen模型,被Meta收购后,极有可能迁移至Llama 4架构。这些大模型的运行对GPU的特定架构特性有着极强的依赖性,CPU根本无法替代。大模型基于Transformer架构,其核心计算负载是矩阵乘法和Softmax操作,这类运算需要大规模的并行计算能力,而GPU在这方面具有绝对优势。

以一个70B参数的模型为例,其推理一个Token时需要进行约1400亿次浮点运算。NVIDIA H100 GPU拥有14592个CUDA核心和专用的Tensor Core,能够在一个时钟周期内完成巨大的矩阵运算块,而即便是最顶级的服务器CPU(如AMD EPYC),核心数也仅在100左右,浮点吞吐量与GPU相差两个数量级。此外,推理速度的瓶颈往往在于内存带宽,H100配备的HBM3显存带宽高达3.35 TB/s,而CPU的DDR5内存带宽仅为200-300 GB/s,若用CPU运行Manus AI的模型,生成速度将慢如蜗牛,每秒生成的Token不足1个,严重破坏用户体验。

在Manus AI的工作流中,GPU有着明确的职责边界,它并不处理文件存储或操作系统维护,而是专注于“概率计算”,承担着意图理解、任务规划、代码生成和自我反思四大核心任务。在意图理解阶段,GPU接收CPU预处理后的提示词(Prompt),将其转化为向量(Embedding),在高维空间中匹配用户的真实意图,比如用户要求“制作一个贪吃蛇游戏”,GPU会快速精准地捕捉这一核心需求。

Manus AI采用多Agent架构,其中负责任务规划的Planner Agent运行在GPU上。它利用模型的推理能力,将复杂任务分解为有序的子步骤(形成DAG图),以“分析50个Excel表格并生成图表”这一任务为例,GPU会将其分解为“创建项目文件夹、读取Excel表格数据、数据清洗与聚合、生成可视化代码、绘制图表并保存”等具体步骤。代码生成是GPU最繁重的工作,它需要根据上下文一次性生成数百行Python代码,这一过程对显存和算力的消耗极大,只有GPU才能高效完成。当CPU反馈代码执行报错时,GPU还会承担自我反思的职责,分析错误日志,推理bug原因,并生成修复代码,确保任务顺利推进。

Manus AI的GPU资源并不位于用户的虚拟机沙箱中,而是集中部署在远程的推理集群(Inference Cluster)中,这种架构设计带来了极高的扩展性和灵活性。GPU推理服务采用无状态设计,每次请求都是独立的,包含完整的上下文信息,这意味着Manus AI可以通过负载均衡器将请求分发到数千张GPU上,实现大规模并发处理。为了优化成本,Manus AI还采用了模型路由策略,根据任务难度动态选择合适的模型和硬件:简单任务(如格式化文本)会路由到运行在NVIDIA A10G或L4上的小模型(如Qwen-7B),而复杂任务(如架构设计)则会路由到运行在NVIDIA H100集群上的大模型(如Claude 3.5或Llama 4 405B)。

Meta的收购将给Manus AI的GPU推理架构带来深远影响。Meta正在大力推广Llama Stack,这一标准化的Agent开发接口将可能全面接管Manus AI的模型层和协议层,使Manus AI原有的多模型架构被统一替换为Llama 4系列。Llama 4的多模态能力(原生支持图像和代码理解)将让GPU在协作中承担更多角色,比如直接理解CPU生成的图表截图,无需借助OCR技术,进一步提升协作效率。此外,Meta自研的MTIA(Meta Training and Inference Accelerator)芯片可能会取代通用的NVIDIA GPU,该芯片专为推荐系统和Llama模型优化,能够提供比H100更高的性价比和更低的Token延迟,大幅降低推理成本。

三、异构协作的精髓:CPU与GPU的协同流程解析

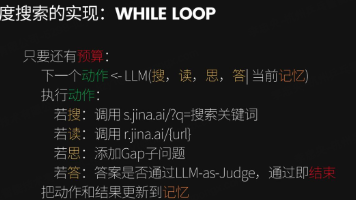

Manus AI的核心技术壁垒并非单一的硬件选择或模型能力,而是CPU(执行环境)与GPU(推理环境)之间高效的协调机制,这一机制被称为Agent Loop(代理循环)。通过CodeAct(代码即行动)范式,Manus AI建立了“GPU负责思考、CPU负责行动”的二元协作模式,成功解决了大模型上下文窗口限制、推理成本高昂以及缺乏副作用能力的根本矛盾。

为了清晰理解两者的分工与协作,我们可以将Manus AI系统抽象为三个核心组件:控制器(Controller)、大脑(Brain)和效应器(Effector/Sandbox)。控制器运行在后端服务器的CPU上,负责状态管理和消息路由;大脑运行在推理集群的GPU上,承担决策重任;效应器运行在E2B微虚拟机的CPU上,负责具体行动执行。这三个组件通过高效的数据流和控制流交互,形成闭环协作。

以用户要求“读取data.csv并绘制销量趋势图”为例,我们可以完整拆解CPU与GPU的协作链条。第一步是感知阶段,控制器(CPU)接收用户提示词后,会读取data.csv的前5行作为元数据,将其与用户需求整合为系统提示词,完成数据预处理。第二步是思考阶段,控制器将整合后的提示词发送给大脑(GPU),GPU通过Transformer模型进行注意力计算,规划任务执行步骤,并生成包含pandas和matplotlib调用的Python代码。第三步是传输阶段,控制器(CPU)解析GPU返回的文本,提取出标签内的Python代码块,完成指令转换。第四步是执行阶段,控制器将代码注入到E2B沙箱的微虚拟机中,CPU启动Python解释器,加载CSV数据到内存,执行数据聚合运算,生成plot.png并写入虚拟磁盘。第五步是观察阶段,效应器(CPU)捕获代码执行的标准输出、标准错误以及新文件生成事件,将这些执行结果打包反馈给控制器。第六步是反馈阶段,控制器将执行结果追加到对话历史中,为后续决策提供上下文。第七步是验证阶段,控制器将包含“执行成功”或“报错信息”的新提示词发送给大脑(GPU),GPU判断任务是否完成,若完成则生成总结回复,若报错则生成修复代码。第八步是展示阶段,前端利用用户本地设备的CPU和GPU渲染最终回复和图片,呈现给用户。

在这一协作流程中,有三个关键技术点决定了协作效率。其一便是异步I/O与并发模型,在代码执行阶段,沙箱内的CPU可能需要运行数分钟(如抓取100个网页),此时GPU资源会被完全释放,用于服务其他用户。控制器(CPU)通过异步回调机制等待沙箱完成,这种异步解耦设计是Manus AI能够支持大规模并发且成本可控的关键,若GPU在代码执行期间空转等待,成本将提高10倍以上。其二是上下文压缩与管理,沙箱执行结果可能非常冗长(如df.head(100)输出100行数据),直接发送给GPU会消耗大量Token,还容易导致模型“幻觉”。控制器(CPU)会对这些结果进行截断或摘要处理,如仅保留前5行和列名,或将长文本写入文件并仅向GPU发送文件路径,这种数据清洗工作完全由CPU完成,大幅降低了GPU的推理负担。其三是错误处理与自我修复,当CPU执行代码报错(如ModuleNotFoundError)时,会原样捕获错误堆栈并反馈给GPU,GPU负责分析错误类型,若为缺少库则生成!pip install xxx的代码,触发下一轮协作循环,实现自我修复。

尽管协作机制高效,但仍存在两处主要效率瓶颈。一是网络延迟,控制器与推理集群、控制器与沙箱之间的网络RTT(往返时间)是主要延迟来源,直接影响协作流畅度。二是冷启动问题,虽然Firecracker微虚拟机启动仅需125ms,但Python环境初始化、库加载(如import pandas)可能需要数秒,这会影响用户体验。对此,Manus AI大概率采用了预热池(Warm Pool)技术,让CPU沙箱保持“待机”状态,从而消除这部分启动延迟,提升任务响应速度。

四、战略演进:Meta收购后的架构变革与展望

Meta对Manus AI的收购不仅是一次商业布局,更将引发其底层技术架构的深度整合。Meta在AI模型、硬件芯片和数据中心基础设施领域的深厚积累,将推动Manus AI的架构向标准化、专用化方向演进,但“CPU主控执行、GPU主控思考”的核心异构计算范式在可预见的未来不会改变。

Llama Stack的全面接管将是架构演进的核心方向之一。Meta正在大力推广Llama Stack这一标准化的Agent开发接口,未来Manus AI原有的多模型架构(Claude/Qwen)极有可能被统一替换为Llama 4系列。Llama 4的多模态能力将显著提升GPU的协作价值,使其不仅能处理文本信息,还能直接理解CPU生成的图表、图像等内容,无需额外的格式转换步骤,进一步简化协作流程。同时,Llama Stack定义了标准的Tool Calling接口,这将简化Manus AI目前复杂的Prompt Engineering,使CPU与GPU的交互协议更加高效,降低协同成本。

硬件层的垂直整合将成为Manus AI降本增效的关键。Meta拥有庞大的数据中心基础设施,且是Linux内核的主要贡献者之一,其自研的MTIA推理加速芯片可能会逐步取代通用的NVIDIA GPU,成为Manus AI模型运行的核心硬件。MTIA芯片针对推荐系统和Llama模型进行了特定优化,在性价比和Token延迟上均优于H100,能够大幅降低推理成本,提升响应速度。此外,Meta可能会将E2B的沙箱技术内化到其私有云中,结合自身在Linux内核领域的积累,进一步优化Firecracker微虚拟机在其服务器上的调度策略,甚至开发定制化的MicroVM,提升CPU执行环境的性能和稳定性。

数据飞轮的构建将赋予Manus AI持续进化的能力。Manus AI最大的价值不仅在于为用户提供服务,更在于其产生的轨迹数据(Trajectory Data),沙箱中CPU的每一次执行记录、每一个错误修复的CodeAct对,都是训练下一代AI(如V-JEPA或Llama 5)理解“因果关系”和“工具使用”的宝贵数据。未来的架构可能会增加一个旁路数据管道(Data Pipeline),将CPU沙箱的日志实时清洗并存入数据湖,用于模型的持续预训练(Continuous Pre-training)。这种“执行-数据-训练-优化”的闭环,将让Manus AI的智能水平不断提升,进一步强化其核心竞争力。

五、总结:异构协作引领AI自治时代

通过对Manus AI技术架构的全面解析,我们可以明确回答用户的核心疑问:其云端虚拟机确实是基于CPU构建的,依托AWS Firecracker微虚拟机技术,通过CPU的硬件虚拟化实现了安全、低成本、高响应的执行环境;CPU与GPU的异构分工界限清晰,CPU负责确定性的计算,运行操作系统、文件系统和工具代码,是系统与外部环境交互的唯一接口,而GPU负责概率性的计算,运行Transformer模型,承担意图理解、任务规划和代码生成等核心智能任务。

Manus AI的强大之处,在于其构建了高效的CodeAct Agent Loop协作协议,成功将GPU的高维推理能力“降维”为CPU可执行的线性代码,又将CPU的执行结果“升维”为GPU可理解的语义反馈,实现了数字世界的闭环控制。这种异构协作模式,既发挥了CPU在串行逻辑执行和I/O调度上的优势,又凸显了GPU在大规模并行计算和智能推理上的特长,为自治代理AI的发展提供了可借鉴的架构范式。

Meta的收购将加速这一架构的标准化和硬件专用化进程,Llama Stack的整合将提升协作效率,MTIA芯片的应用将降低运行成本,数据飞轮的构建将推动智能进化。可以预见,在CPU与GPU异构协作的核心逻辑支撑下,Manus AI将不断突破性能瓶颈,在任务执行的准确性、效率和场景适配性上实现更大提升,引领AI进入真正的自治时代。而这种“各司其职、高效协同”的异构计算理念,也将成为未来AI架构设计的核心趋势,为更多智能应用的落地提供坚实支撑。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)