2026 避坑指南:Gemini CLI 配置 MCP 的真相,配合智谱 AutoGLM 效率起飞!

《AI工具配置新思路:GeminiCLI与AutoGLM的完美搭配》本文分享了GeminiCLI的正确配置方法和效率提升技巧。作者澄清了常见的配置误区,指出MCP配置只需通过settings.json文件完成,并推荐用户级和项目级两种配置方式。同时介绍了智谱AI的AutoGLM输入法作为Prompt优化工具,通过自定义人设功能将口语快速转化为专业指令。文章展示了编程重构和文案撰写两个典型场景,说明

🌊 数字风云录 | 飞鹰四海带你洞悉AI浪潮

大家好,我是**飞鹰四海**。

最近全在问:“我看你用 Gemini CLI 跑得飞起,但我连配置都搞不定,文档里的 .mcp.json 到底在哪?”

不瞒你说,我第一次配置的时候也差点把键盘砸了。

网上各种“野路子”教程满天飞,有人说要建 .mcp.json,有人说要去改系统变量,还有人说要手动去 .gmail 文件夹里改代码。

全是坑! 根本就没有什么 .mcp.json,也没有什么神秘的 .gmail 文件夹。

今天,我必须得把这个谣给辟了。

结合 Google 官方最新文档(2026 年版)和我的踩坑经验,给大家好好扒一扒 Gemini CLI 正确的 MCP 配置姿势。

并且,这次我还带了个“新外挂”——智谱 AI 的 AutoGLM 输入法。

新注册用户免费使用7天,可以自定义人设。

案例一

比如这里的自动翻译,我们设置好提示词之后,向大模型说一句话,它可以自动给我们翻译成英语,这样呢更好的可以让大模型去输出内容。

案例二

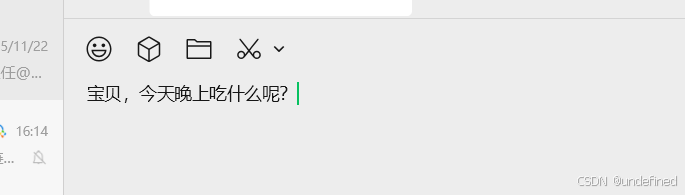

目标是:把任何“原始大白话”,稳定改写成 亲密、体贴、不油腻、不过火、真实可信 的伴侣沟通文本。

我原话是:今天晚上吃什么。

怎么样,还不错吧?

接下来我们说说怎么配置 MCP。

避坑指南:Gemini MCP 配置的真相

首先,咱先把最要命的配置问题解决了。

很多兄弟在群里吐槽:“Gemini CLI 启动太慢了!”、“加载 20 多个 MCP,Token 哗哗地流!”

其实,这都是因为配置姿势不对。

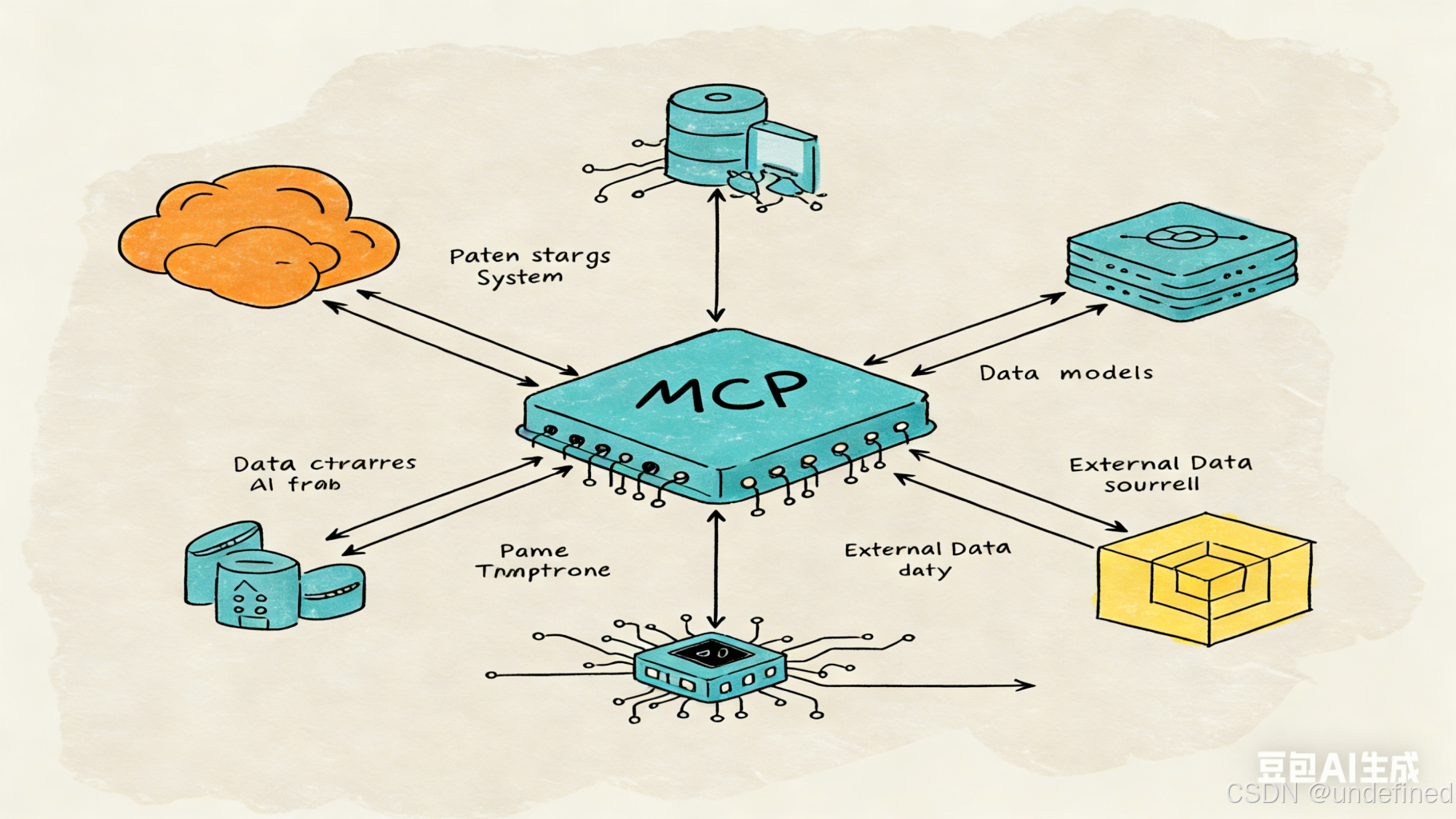

官方文档(我翻烂了 geminicli.com/docs 和 GitHub 源码)说得清清楚楚:MCP 配置完全基于 settings.json。

没有别的。什么 .mcp.json、citizen 文件,统统是幻觉。

而且,官方提供了两种极其实用的配置方式,学会这招,你的 Gemini CLI 启动速度至少提升 10 倍。

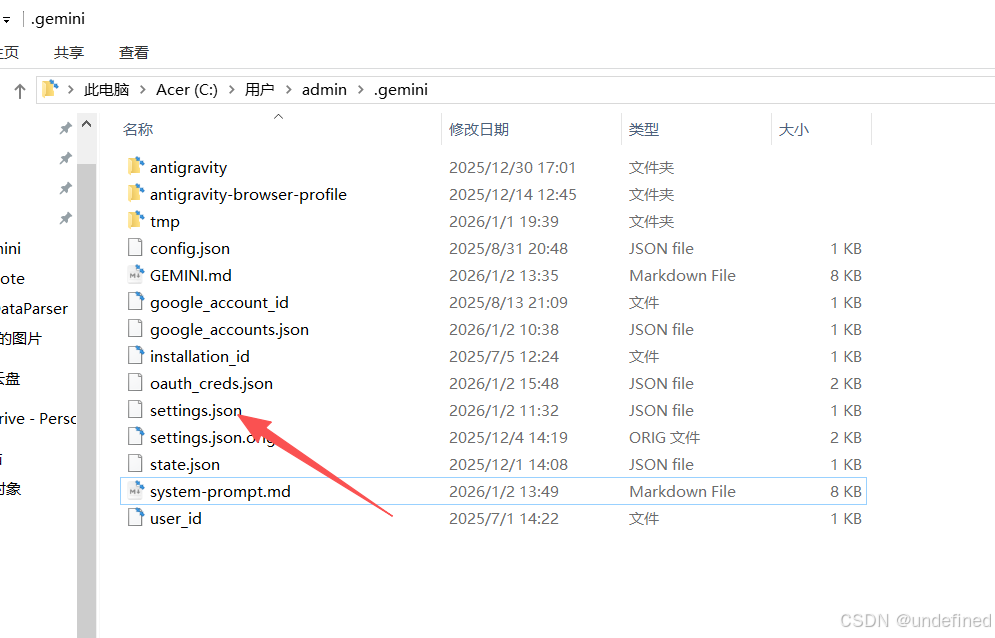

1. 用户级配置(全局共享)

这招适合“日常高频工具”。

文件位置(Windows):C:\Users\你的用户名\.gemini\settings.json

注意:.gemini 是隐藏文件夹,找不到就自己手动建一个。

在这里,我们只放最常用的那几个 MCP,比如文件系统、Google 搜索。这样无论你在哪个目录下启动 Gemini,它都能秒开,还省 Token。

这里以 sequential-thinking 为例。

配置代码(直接抄):

{

"ide": {

"hasSeenNudge": true

},

"mcpServers": {

"sequential-thinking": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"@modelcontextprotocol/server-sequential-thinking"

]

}

},

"general": {

"preferredEditor": "vscode",

"previewFeatures": true,

"enablePromptCompletion": true

},

"security": {

"auth": {

"selectedType": "oauth-personal"

}

},

"ui": {

"theme": "Dracula"

}

}

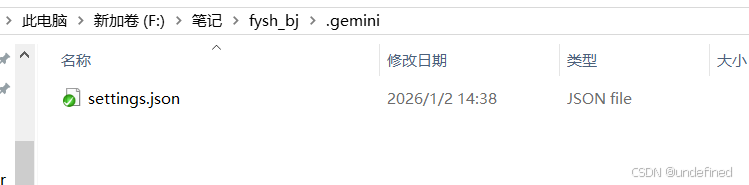

2. 项目级配置(特定任务专用)

这才是“高效率”的精髓。

如果你在写代码,你需要 GitHub MCP、Postgres MCP;如果你在写文章,你需要 Gmail MCP、Notion MCP。

没必要一次性全加载进来!

你只需要在具体的项目根目录下,再建一个 .gemini\settings.json。

Gemini CLI 会非常智能地把项目级配置覆盖到全局配置上。

比如,我在 F 盘建了个“笔记”文件夹,里面的配置只加了 必应搜索 工具:

{

"ide": {

"hasSeenNudge": true

},

"mcpServers": {

"bingcn": {

"args": [

"bing-cn-mcp"

],

"command": "npx"

}

},

"general": {

"preferredEditor": "vscode",

"previewFeatures": true,

"enablePromptCompletion": true

},

"security": {

"auth": {

"selectedType": "oauth-personal"

}

},

"ui": {

"theme": "Dracula"

}

}

这样,当我在这里运行 Gemini 时,它就是个“搜索专家”;回到普通目录,它又变回了轻量级的“全能助手”。

既快,又省钱,还专业。 这才是打开 Gemini CLI 的正确方式。

终极组合:AutoGLM + Gemini CLI

搞定了配置,咱们聊聊怎么“开挂”。

2026 年了,还在用键盘一个字一个字敲复杂的 Prompt?那确实有点慢了。

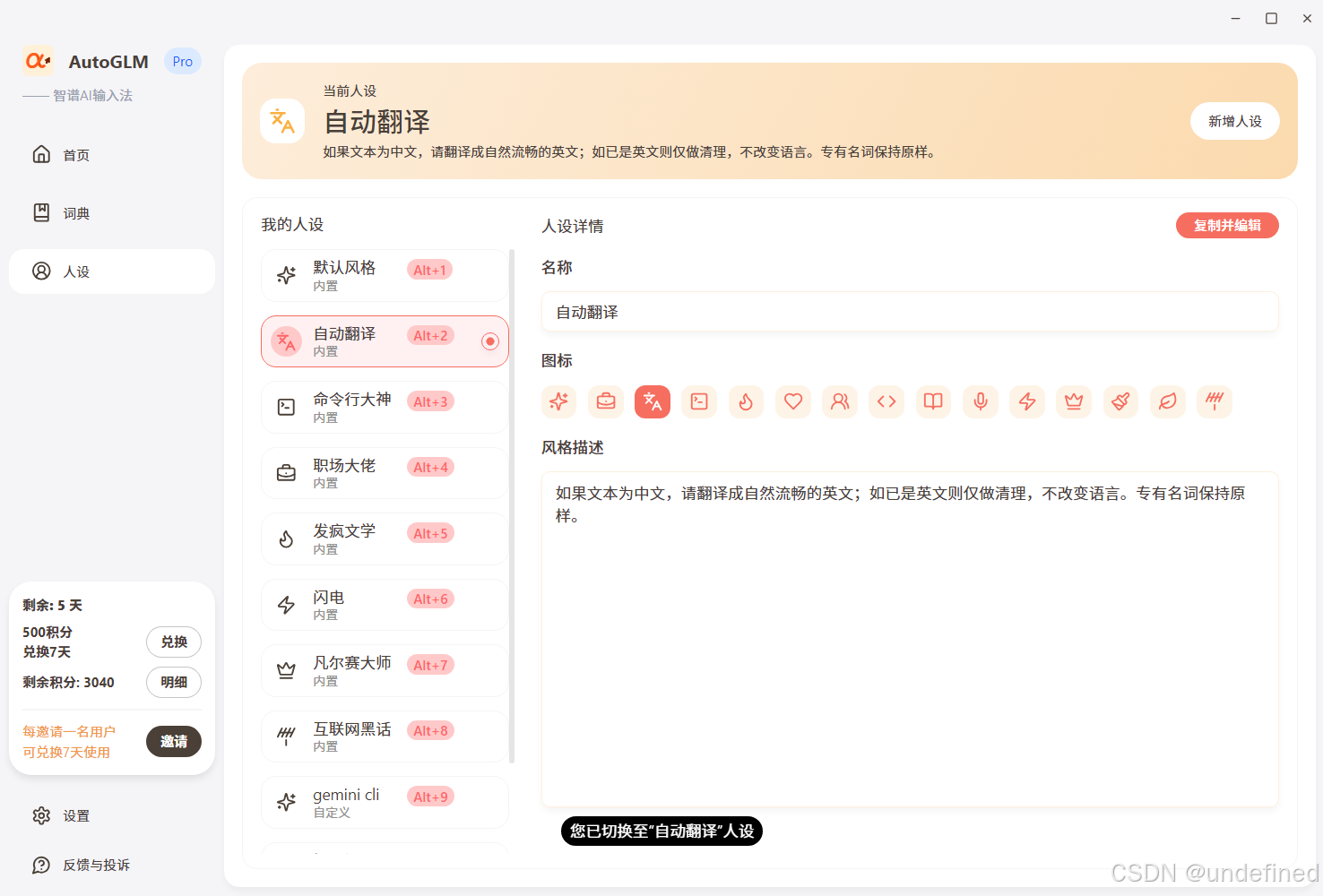

智谱 AI 的 AutoGLM 输入法(PC版),其实是个被低估的“效率神器”。

很多营销号把它吹得神乎其神,说能“自动操控电脑”、“看懂屏幕写代码”,其实没那么玄乎,咱不整那些虚的。

它的核心功能很简单,但非常实用:自定义人设(Custom Persona)。

简单来说,它就是一个带有“预设指令”的智能输入框。你输入“大白话”,它根据你设定的规则,瞬间帮你改写成“专业指令”。

这跟 Gemini CLI 简直是绝配。

为什么?因为 Gemini CLI 的输出质量,由你的 Prompt 质量决定。

而 AutoGLM,就是那个能帮你把“废话”变成“金句”的超级嘴替。

场景一:编程指令“光速”生成

以前我想让 Gemini 重构代码,得在终端里敲半天:

“请读取当前目录下的 main.py,分析其中的类结构,然后用策略模式重构...”

敲完这行字,灵感都断了。

现在配合 AutoGLM,流程是这样的:

- 设置人设:在 AutoGLM 里建一个“Gemini 指令官”人设。

- 预设提示词:你是一个资深技术专家。将用户的口语化需求,转化为 Gemini CLI 能精准理解的英文 Prompt,并明确指定需要使用的 MCP 工具(如 filesystem, git)。

- 实际操作:

- 我在 VS Code 终端里,按住 AutoGLM 快捷键。

- 直接说(或打字):“重构代码,用策略模式。”

- 瞬间效果:

- 输入框里瞬间自动生成了:@codebase Refactor the current file using Strategy Pattern. Use 'filesystem' tool to read and write files. Ensure backward compatibility.

- 我只需要按一下回车。

原本要敲 30 秒的字,现在 1 秒搞定。 这才是 AutoGLM + Gemini CLI 的真实威力——把你的意图,无损传输给 AI。

场景二:文案风格“一键”切换

写周报、写文章也是同理。

Gemini 写东西虽然快,但如果你只给它一句“写个周报”,它写出来的东西肯定像机器人。你得给它加一堆限定词:“语气正式点”、“突出数据”、“参考OKR格式”...

每次都敲这些限定词?太累。

AutoGLM 的解法:

- 设置人设:建一个“周报扩写师”人设。

- 预设提示词:将用户输入的简短工作项,扩展为一段符合互联网大厂风格的周报摘要,语气专业,突出量化成果。

- 实际操作:

- 输入:“修了两个bug,优化了首页加载速度。”

- 瞬间效果:

- AutoGLM 自动替换为:“1. 修复核心业务逻辑缺陷,提升系统稳定性;2. 深度优化首页渲染性能,FCP 降低 30%,显著提升用户体验。”

然后你再把这段话发给 Gemini CLI,让它归档或者生成最终报告。

总结一下这个组合的逻辑:

- AutoGLM (输入端):负责“翻译”。把你随口说的话,翻译成 AI 最爱听的、高质量的 Prompt。

- Gemini CLI (执行端):负责“干活”。接收高质量指令,通过 MCP 调动工具,精准执行。

这才是“动口不动手”的真相:用最少的嘴皮子,换来最精准的执行力。

下载地址

[!todo]

我发现 智谱AI输入法 太丝滑了,工作效率翻倍,强烈推荐!https://autoglm.zhipuai.cn/autotyper 邀请码:NTNSQA2P(注册咱俩都可获得积分哦)

折腾完这一套,我最大的感受是:工具变了,生产力的底层逻辑也就变了。

以前我们是去“适应”机器,学习复杂的命令;现在机器在“适应”我们,通过 MCP 连接万物,通过 AutoGLM 识别意图。

Gemini CLI 是那个强悍的引擎,而 AutoGLM 就是那个懂你的方向盘。

别再纠结那些过时的 .mcp.json 了,赶紧按这套配置跑起来,把时间花在更有价值的创造上。

我是飞鹰四海,一个爱折腾、不将就的开发者。

如果这篇文章帮到了你,点个赞、转给需要的朋友,咱们下期见!

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)