【GitHub项目推荐--Apache Airflow:工作流编排与调度平台】

是一个开源的工作流编排平台,用于以编程方式编写、调度和监控工作流。作为Apache软件基金会的顶级项目,Airflow采用Python编写,允许用户将工作流定义为代码,从而实现更好的可维护性、版本控制、测试性和协作性。该项目自2015年创建以来,已成为数据工程和数据处理领域的事实标准工具。核心价值代码即工作流:工作流以Python代码定义(DAGs),支持版本控制和协作开发灵活调度:基于依赖关系的

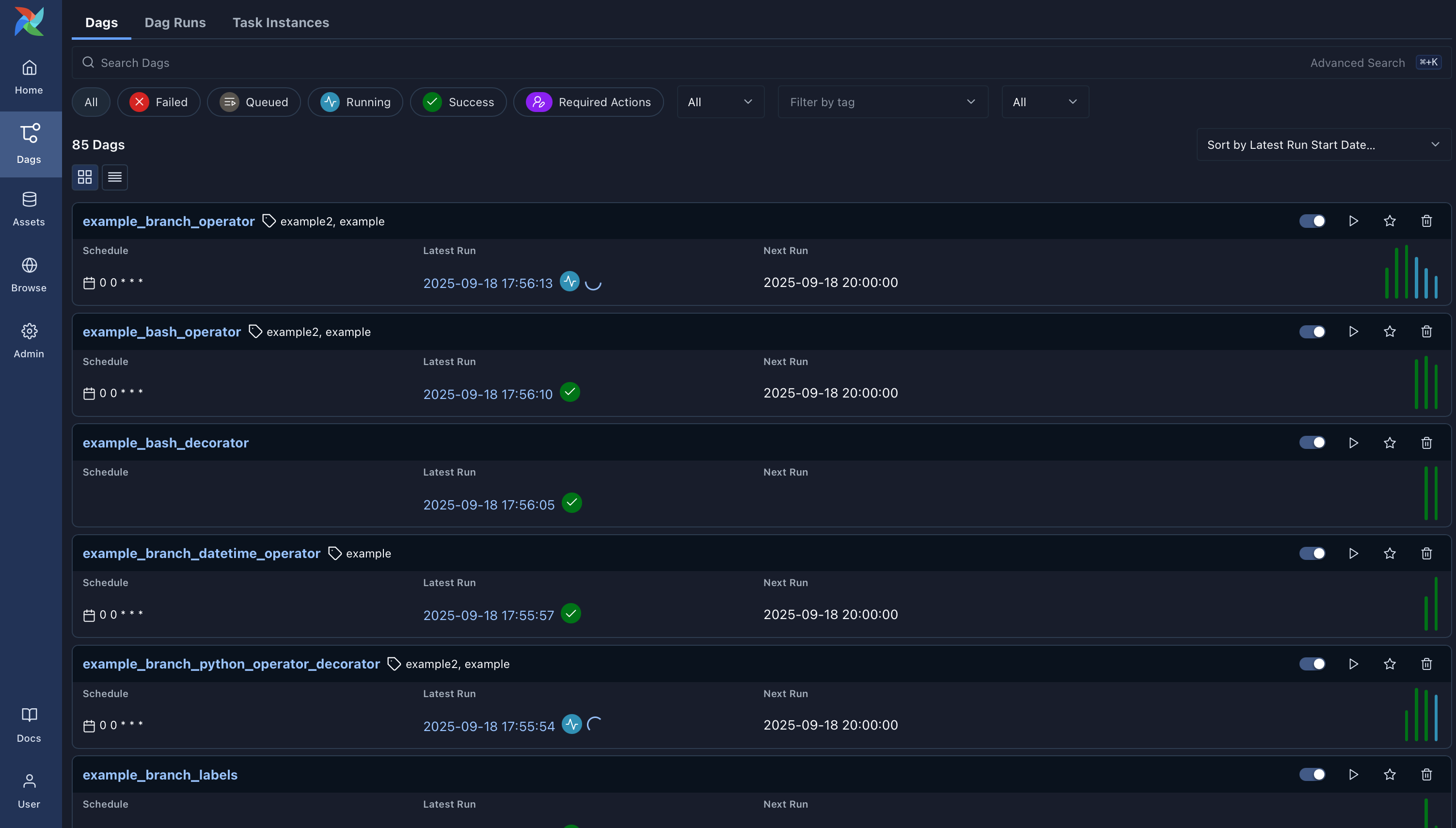

User Interface 用户界面

-

Dags: Overview of all Dags in your environment.

Dags:你环境中所有 Dags 的概览。 -

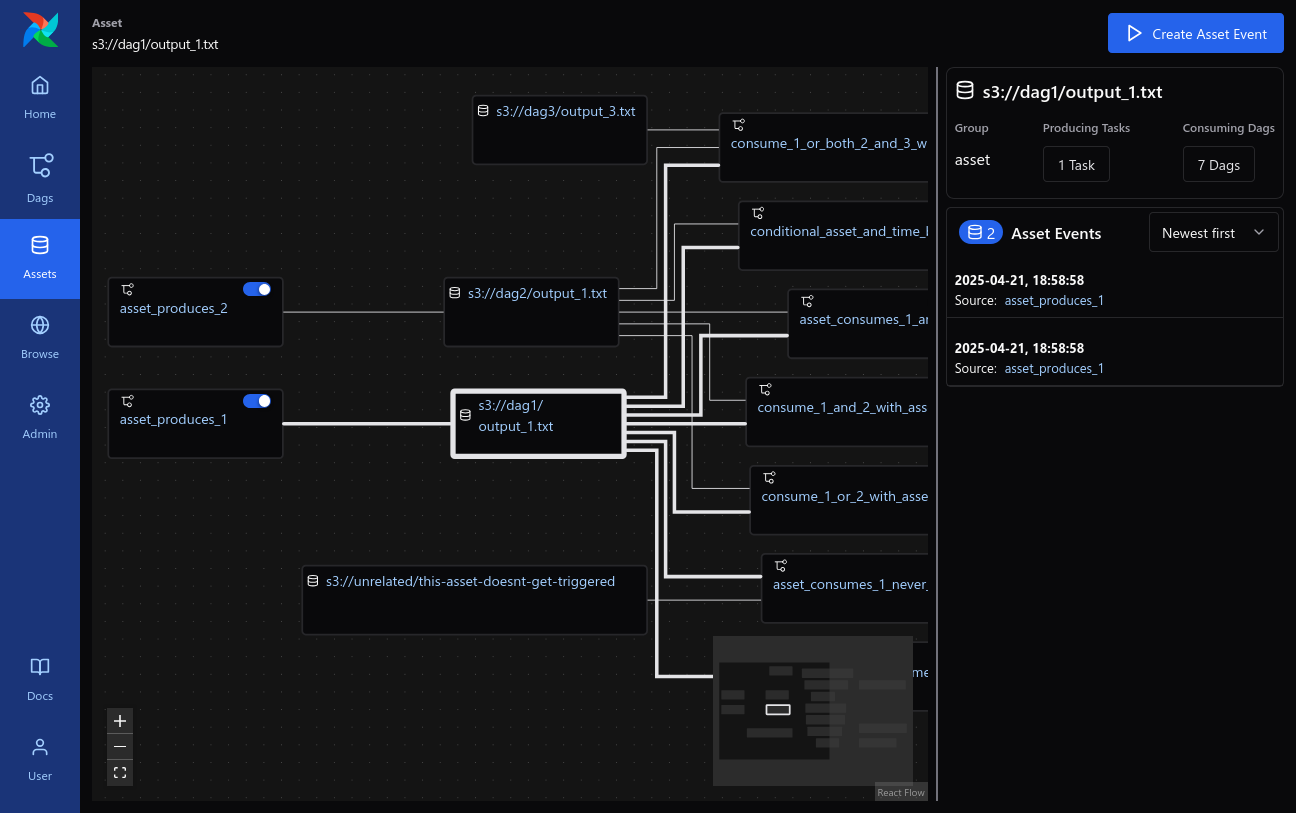

Assets: Overview of Assets with dependencies.

资产 :带有依赖关系的资产概览。 -

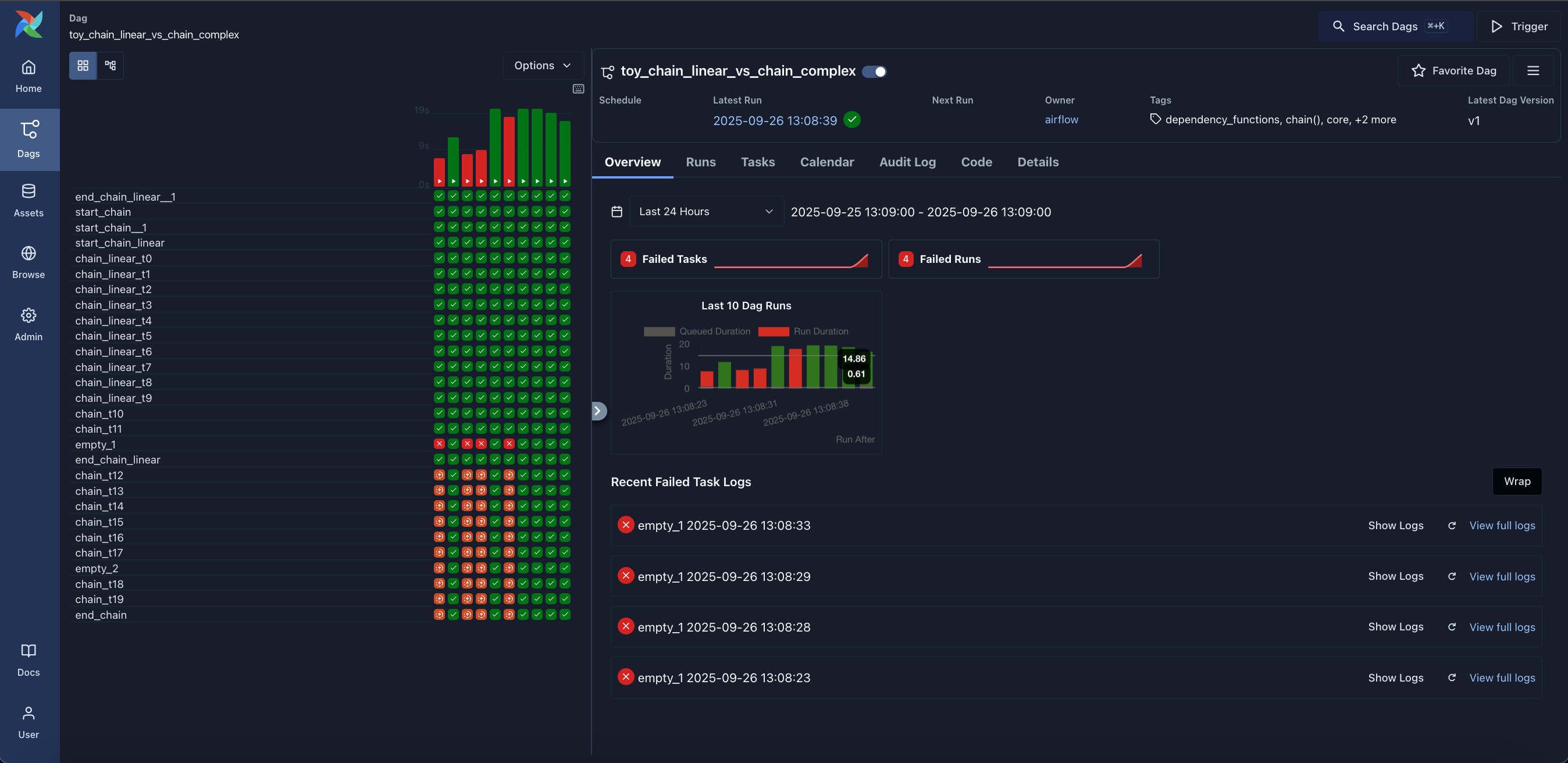

Grid: Grid representation of a Dag that spans across time.

网格 :跨越时间的达格网格表示。 -

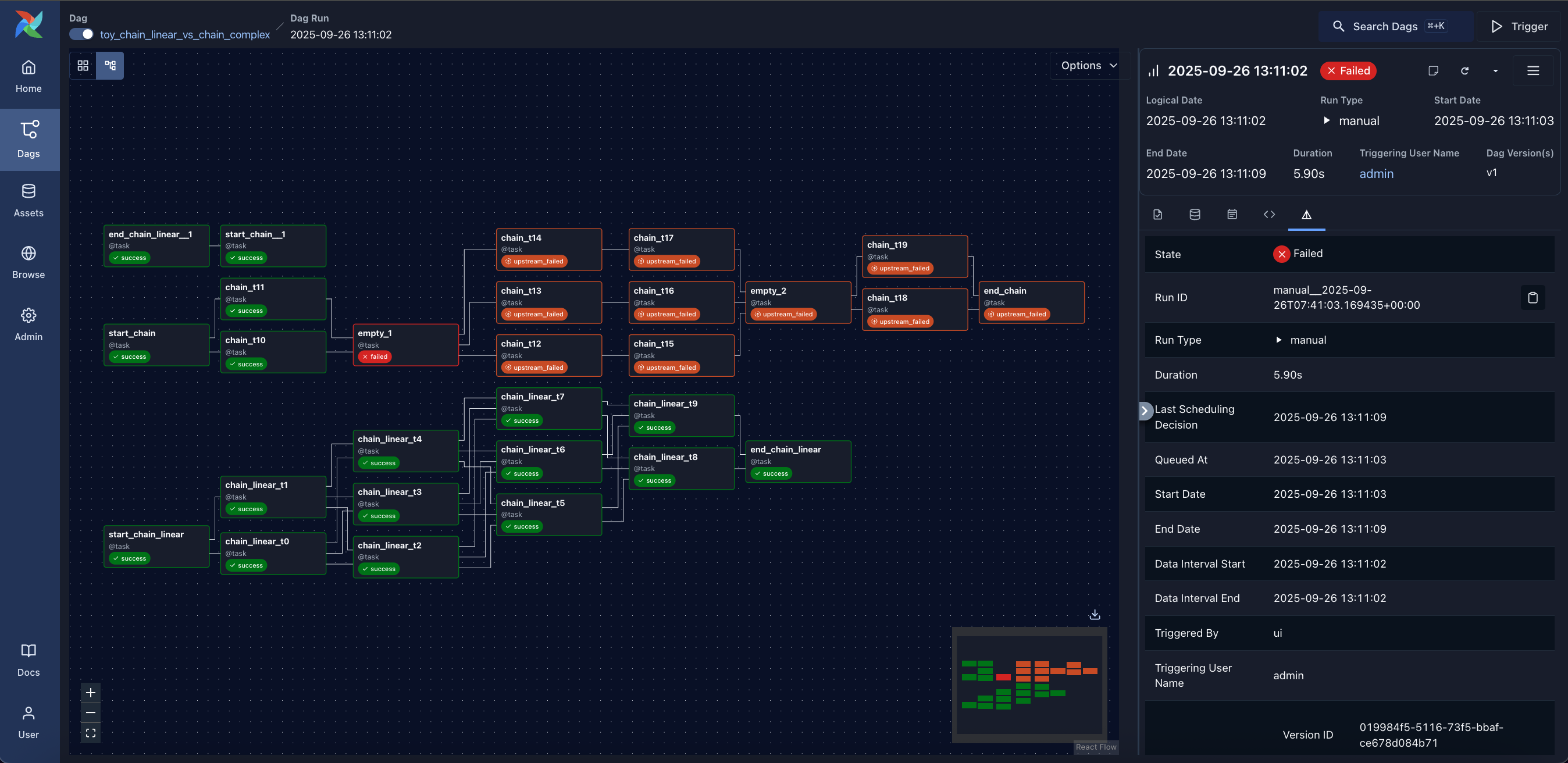

Graph: Visualization of a Dag's dependencies and their current status for a specific run.

图表 :可视化 Dag 的依赖关系及其在特定运行中的当前状态。 -

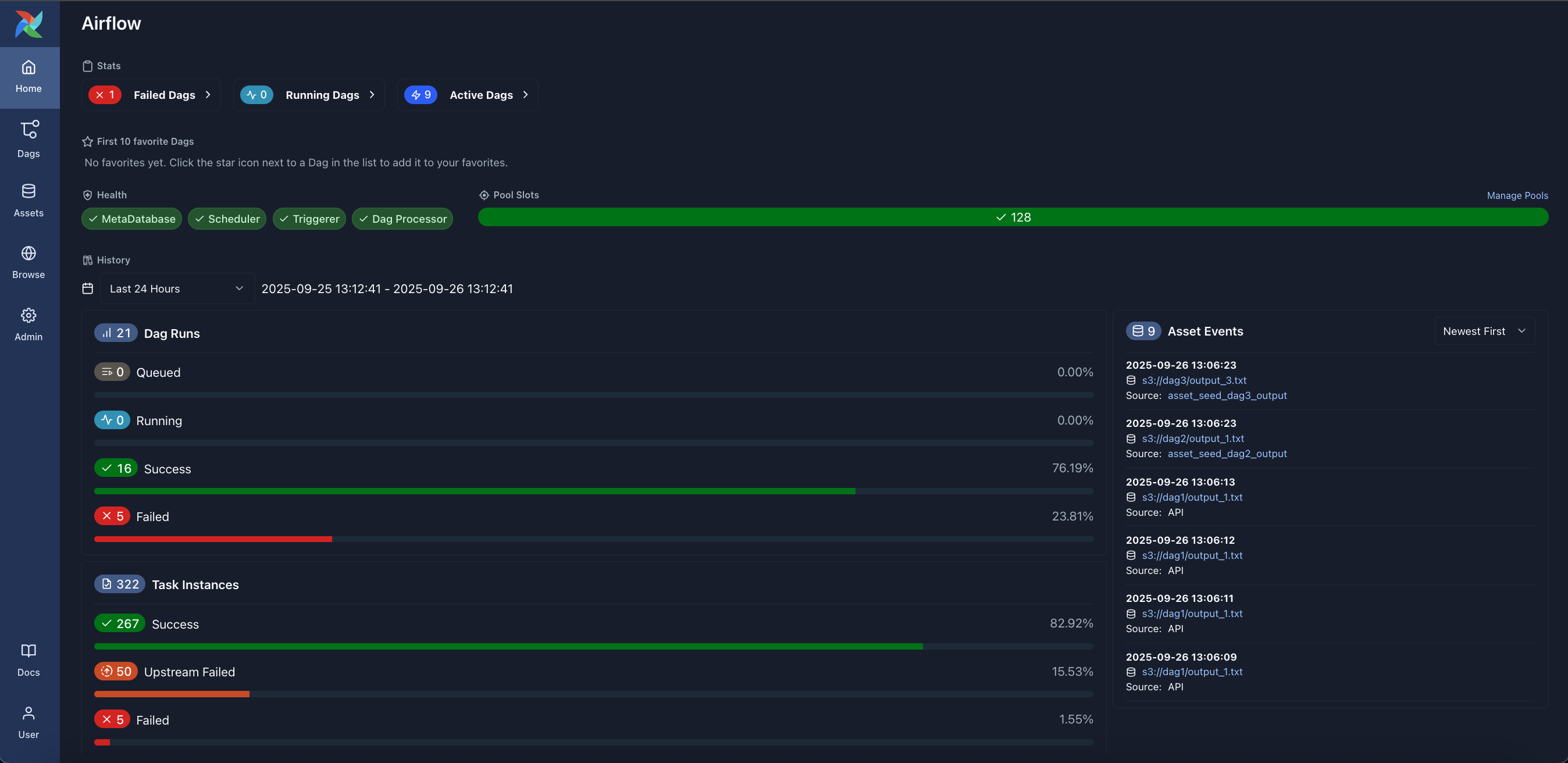

Home: Summary statistics of your Airflow environment.

首页 :您的气流环境统计摘要。 -

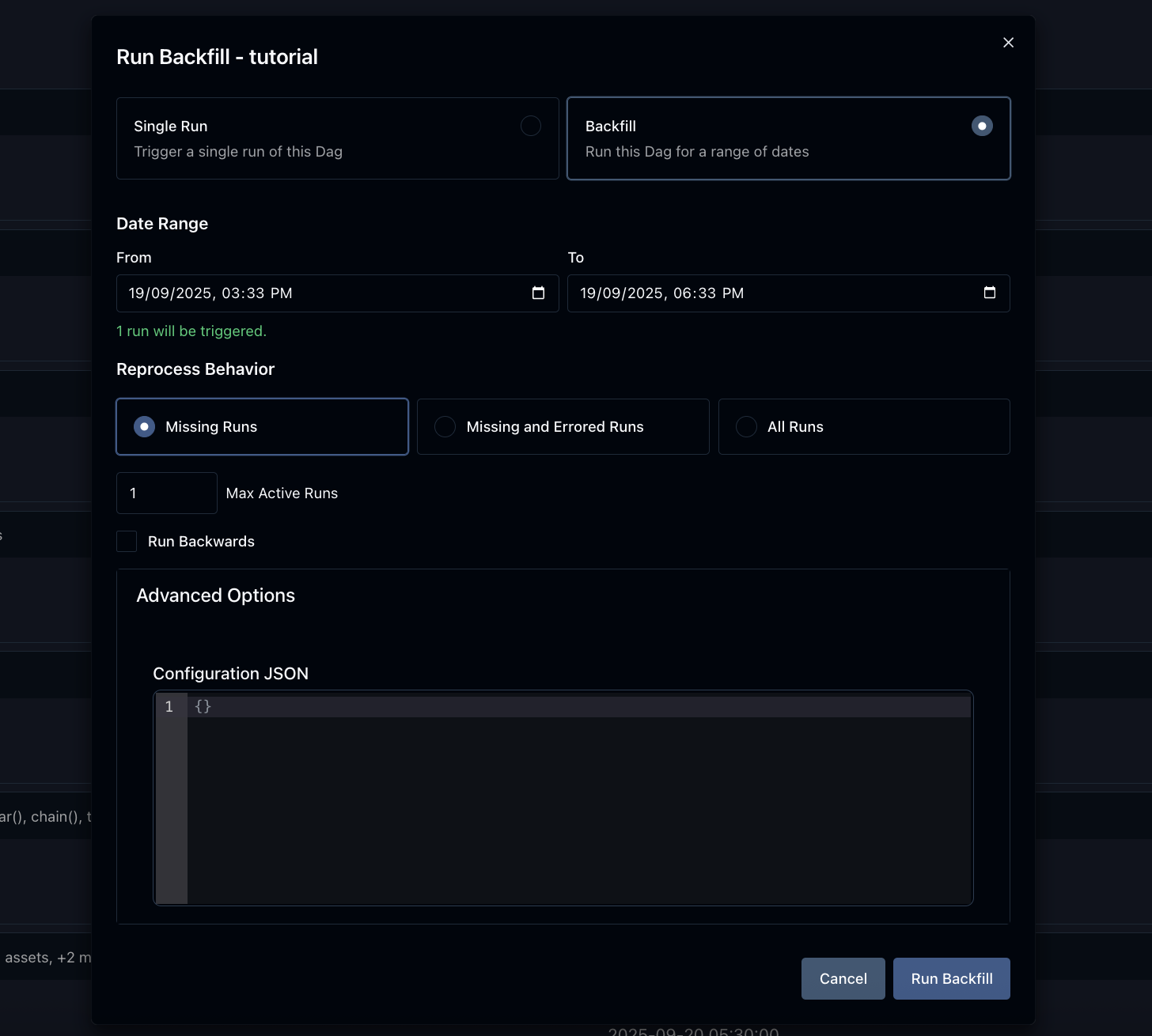

Backfill: Backfilling a Dag for a specific date range.

回填 :为特定日期范围的 Dag 回填。 -

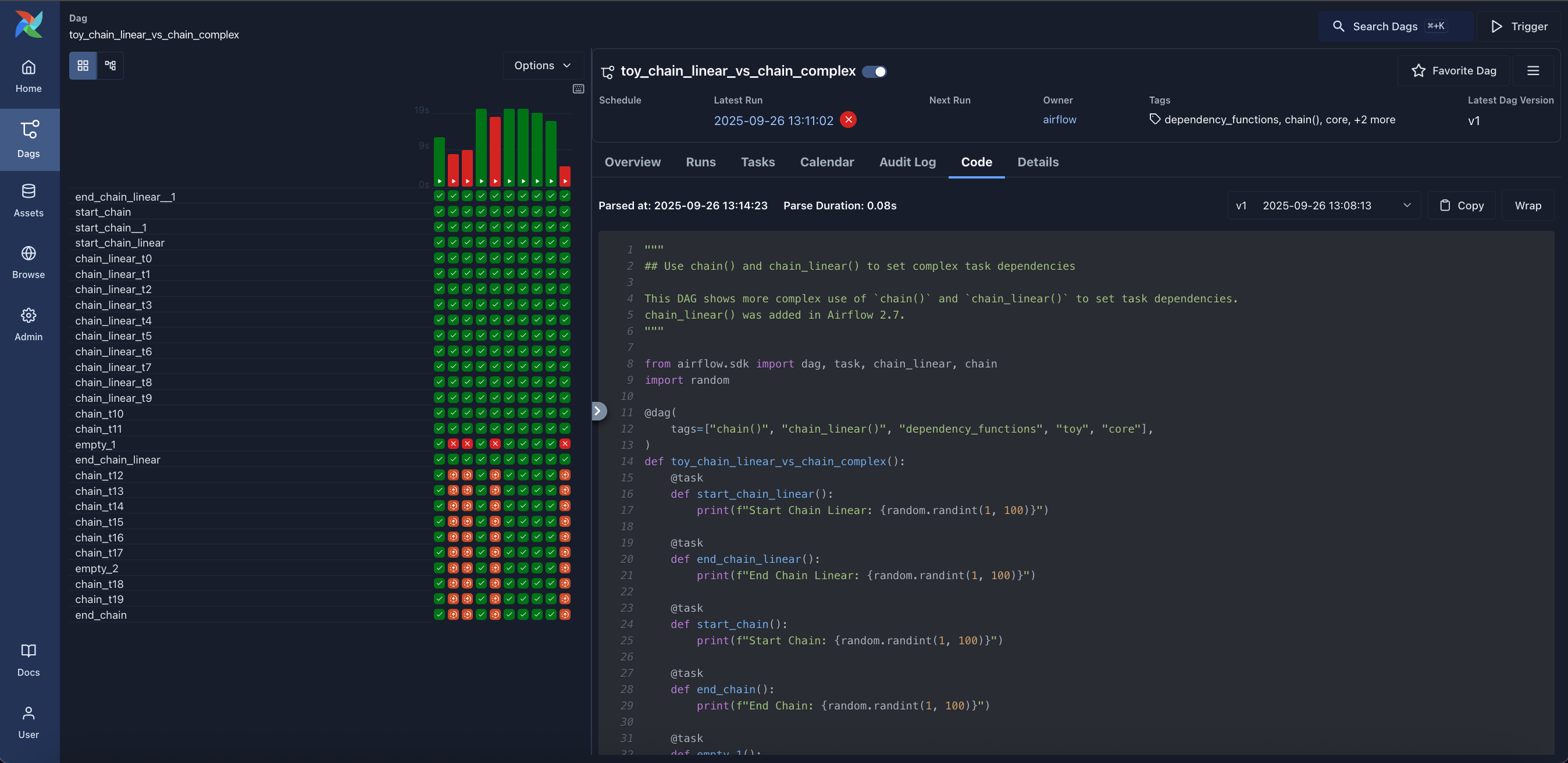

Code: Quick way to view source code of a Dag.

代码 :快速查看 Dag 源代码的方法。

简介

Apache Airflow是一个开源的工作流编排平台,用于以编程方式编写、调度和监控工作流。作为Apache软件基金会的顶级项目,Airflow采用Python编写,允许用户将工作流定义为代码,从而实现更好的可维护性、版本控制、测试性和协作性。该项目自2015年创建以来,已成为数据工程和数据处理领域的事实标准工具。

核心价值:

-

代码即工作流:工作流以Python代码定义(DAGs),支持版本控制和协作开发

-

灵活调度:基于依赖关系的智能任务调度,确保执行顺序正确

-

强大监控:丰富的用户界面实时监控管道状态和故障诊断

-

企业级可靠性:经过大规模生产环境验证,支持高可用部署

技术定位:Airflow专为静态或缓慢变化的工作流设计,特别适合数据处理、ETL管道和批量作业编排。它不是一个流处理解决方案,但可以用于处理实时数据的批量处理。项目采用模块化架构,支持丰富的扩展和集成。

主要功能

1. 工作流编排引擎

基于有向无环图(DAG)的工作流定义,可视化任务依赖关系。支持复杂的执行逻辑,包括分支、合并和条件执行。动态管道生成,允许参数化工作流定义。任务重试和故障处理机制,提高系统韧性。

2. 智能调度系统

基于时间或外部事件的灵活触发机制。支持 cron 式调度表达式,满足复杂调度需求。回填功能,重新处理历史数据。依赖感知调度,确保任务按正确顺序执行。

3. 可扩展架构

丰富的操作器库,支持与各种系统集成(数据库、云服务、消息队列等)。自定义操作器开发框架,适应特定业务需求。插件系统,轻松扩展平台功能。REST API支持,便于外部系统集成。

4. 监控与管理

Web UI提供管道状态、任务日志和性能指标的实时视图。命令行工具支持批量操作和自动化管理。警报和通知系统,及时发现问题。详细的执行历史和分析报告。

5. 多环境支持

本地开发到生产环境的无缝迁移。容器化部署支持(Docker、Kubernetes)。多云平台兼容(AWS、GCP、Azure等)。多种执行器选择(本地、Celery、Kubernetes等)。

6. 企业级特性

基于角色的访问控制(RBAC),确保安全性。高可用配置,支持故障转移。性能优化,处理大规模工作流。审计日志,满足合规要求。

安装与配置

环境要求

基础环境:

-

操作系统:Linux、macOS(Windows通过WSL2或容器支持)

-

Python版本:3.10、3.11、3.12、3.13

-

数据库:PostgreSQL(推荐)、MySQL、SQLite(仅开发)

-

内存:建议4GB以上,生产环境需要8GB+

-

存储:至少10GB可用空间

可选组件:

-

消息代理:Redis、RabbitMQ(用于Celery执行器)

-

容器平台:Docker、Kubernetes

-

云服务:AWS、GCP、Azure集成

安装步骤

PyPI安装(推荐):

使用pip包管理器安装官方Apache Airflow包。指定版本号和约束文件确保依赖兼容性。基础安装仅包含核心功能,按需添加额外组件(如数据库支持、云提供商集成)。验证安装完整性,测试基本功能。

容器化部署:

使用官方Docker镜像快速部署。配置持久化存储,确保元数据安全。编排多服务架构(Web服务器、调度器、执行器)。集成监控和日志收集系统。

源码安装:

适合开发和定制需求。克隆GitHub仓库,安装开发依赖。配置开发环境,支持调试和测试。构建自定义扩展和插件。

配置说明

核心配置:

设置元数据数据库连接,配置连接参数和池大小。选择执行器类型,平衡性能与复杂度。配置时区和日志设置,确保一致性。安全配置,设置认证和授权参数。

环境优化:

调整并行参数,优化资源利用率。配置任务重试策略,提高可靠性。设置资源限制,防止系统过载。缓存配置,提升重复查询性能。

集成配置:

配置外部系统连接(数据库、API、存储等)。设置警报通道(邮件、Slack、PagerDuty等)。监控集成,连接Prometheus、Grafana等工具。密钥管理,安全存储敏感信息。

如何使用

基础使用流程

项目初始化:

创建Airflow项目结构,组织DAG文件和插件。配置环境变量和连接信息。初始化数据库,创建元数据表。启动核心服务(调度器、Web服务器、执行器)。

DAG开发:

定义DAG对象,设置调度间隔和默认参数。创建任务实例,使用内置或自定义操作器。建立任务依赖关系,定义执行顺序。添加错误处理和重试逻辑。

测试验证:

使用CLI工具测试DAG语法和任务执行。在开发环境运行完整工作流。验证数据流和输出结果。性能测试,确保满足SLA要求。

部署上线:

将DAG文件部署到生产环境。配置生产级参数(资源限制、警报规则)。监控初始运行,确保稳定性。建立变更管理流程。

高级功能使用

动态DAG生成:

基于配置或外部数据源动态创建DAG。参数化模板,支持多环境部署。条件逻辑,适应不同业务场景。元数据驱动,实现自描述工作流。

自定义组件开发:

创建领域特定操作器,封装业务逻辑。开发传感器,等待外部条件满足。构建钩子,统一外部系统访问。设计插件,扩展平台功能。

流水线优化:

任务并行化,提高执行效率。资源管理,优化集群利用率。数据分区,处理大规模数据集。增量处理,减少不必要的重复计算。

最佳实践

开发规范:

DAG设计原则,保持简洁和可维护性。代码审查,确保质量和一致性。版本控制,跟踪所有变更。文档化,便于团队协作。

运维管理:

监控策略,实时掌握系统状态。容量规划,提前应对增长需求。备份恢复,确保业务连续性。安全审计,定期检查配置和权限。

性能调优:

数据库优化,提高调度性能。任务优化,减少执行时间。资源调整,平衡成本与性能。缓存策略,提升响应速度。

应用场景实例

实例1:电商数据管道

场景描述:大型电商平台需要每日处理数百万订单数据,包括销售统计、库存更新和用户行为分析。传统手动处理效率低,错误率高,需要自动化数据管道。

解决方案:使用Airflow构建完整的数据处理流水线。每日定时触发数据抽取任务,从多个源系统收集数据。数据清洗和转换任务确保数据质量。并行执行多个分析任务,生成销售报告和库存预警。自动推送结果给相关团队,支持业务决策。

实施效果:

-

数据处理时间从小时级降到分钟级,效率提升10倍

-

数据准确性达到99.9%,减少人工错误

-

实时监控异常情况,及时发现问题

-

资源利用率优化,成本降低30%

实例2:金融风险监控系统

场景描述:银行需要实时监控交易风险,传统批量处理无法满足实时性要求。需要能够快速响应可疑交易的工作流系统。

解决方案:部署Airflow风险监控平台。流式数据接入,实时处理交易事件。多层风险检测模型,识别不同级别风险。自动预警和处置工作流,快速响应风险事件。合规报告生成,满足监管要求。

实施效果:

-

风险检测响应时间从分钟级降到秒级

-

漏报率降低70%,风险控制能力显著提升

-

自动化处置流程,减少人工干预

-

审计轨迹完整,合规性100%满足

实例3:媒体内容处理平台

场景描述:视频流媒体公司需要处理大量用户上传内容,包括转码、水印添加和内容审核。处理流程复杂,需要高效的任务编排。

解决方案:基于Airflow构建媒体处理流水线。智能任务调度,优化资源利用。并行转码任务,支持多种格式和分辨率。集成AI内容审核,自动识别违规内容。质量检查工作流,确保输出质量。

实施效果:

-

内容处理吞吐量提升5倍,支持业务增长

-

人工审核工作量减少80%,成本显著优化

-

处理质量一致性确保,用户体验提升

-

平台扩展性增强,轻松应对流量峰值

实例4:物联网数据聚合

场景描述:智能制造企业有数万台设备持续生成数据,需要实时聚合分析,支持预测性维护和优化生产。

解决方案:实施Airflow物联网数据管道。设备数据实时采集和缓存。流式处理任务,计算关键指标。机器学习模型批量训练和实时推理。预警系统自动触发维护工单。

实施效果:

-

设备停机时间减少40%,生产效率提升

-

维护成本降低25%,资源利用优化

-

数据洞察实时可用,支持快速决策

-

系统稳定性提高,故障快速定位

实例5:科研数据处理工作流

场景描述:研究机构需要处理大量实验数据,流程复杂且涉及多个专业工具。研究人员需要可重复的计算流程。

解决方案:创建科学计算工作流平台。标准化数据处理流程,确保结果可重现。集成专业分析工具和库。并行计算任务,加速研究进程。结果自动归档和分享。

实施效果:

-

研究周期缩短60%,加速科学发现

-

结果可重复性100%,研究质量提升

-

协作效率提高,跨团队合作更顺畅

-

计算资源利用率优化,成本降低

实例6:客户数据平台

场景描述:营销科技公司需要整合多个客户数据源,构建统一客户视图,支持个性化营销活动。

解决方案:构建客户数据管道。多源数据抽取和融合。身份解析任务,构建统一客户档案。实时细分更新,支持精准营销。合规检查确保数据使用符合法规。

实施效果:

-

客户数据整合时间从天级降到小时级

-

营销活动响应率提升35%,ROI显著改善

-

数据质量全面提升,决策更准确

-

合规风险降低,避免法律问题

GitHub地址

项目地址:https://github.com/apache/airflow

项目信息:

-

⭐ Stars:超过20,000+,持续增长

-

📄 许可证:Apache License 2.0

-

💻 主要语言:Python

-

📅 最新版本:3.1.5(活跃维护)

资源内容:

-

完整文档:详细的用户指南、API参考和部署说明

-

示例代码:丰富的示例DAG和集成案例

-

社区支持:活跃的邮件列表和问题讨论

-

提供商生态:300+官方和社区维护的集成组件

快速开始:

-

准备Python环境,安装Airflow核心包

-

初始化数据库和配置

-

创建第一个DAG文件

-

启动服务并测试运行

-

逐步添加复杂工作流和集成

生态系统:

Airflow拥有完整的生态系统:

-

官方提供商:支持主流云服务和大数据平台

-

第三方插件:社区贡献的扩展功能

-

工具集成:与流行DevOps工具链无缝集成

-

托管服务:各大云平台提供托管Airflow服务

Apache Airflow通过其强大的工作流编排能力和丰富的生态系统,已成为现代数据工程的核心工具。其开源特性和活跃的社区确保技术的持续创新,为各种规模的组织提供可靠的工作流自动化解决方案。

更多推荐

已为社区贡献291条内容

已为社区贡献291条内容

所有评论(0)