Claude-Opus-4.5 国内落地最佳实践:基于 API 网关的低延迟架构方案

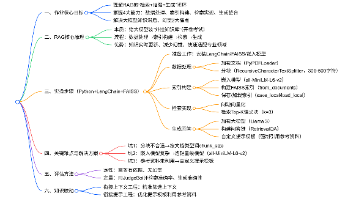

本文探讨了国内团队接入海外大语言模型(如Claude-Opus-4.5和GPT-4)面临的技术挑战,包括网络延迟、支付合规和SDK维护问题。通过分析千次真实调用数据,提出基于小镜AI开放平台的API中转解决方案。该方案采用标准化OpenAI协议接口,实现多模型统一接入,将延迟降低90%至30-50ms。文章详细介绍了技术痛点、架构选型理由,并提供了Python接入示例代码,展示如何无缝切换不同模型

随着 LLM(大语言模型)竞赛进入下半场,Claude-Opus-4.5 在长上下文理解(Context Window)和复杂逻辑推理任务上展现了超越 GPT-4 的能力。然而,对于国内技术团队而言,将这些前沿模型集成到生产环境(Production)中,面临着网络连通性(Connectivity)、支付合规性以及异构 SDK 维护的三重挑战。

本文基于千次真实调用数据,分析国内接入海外大模型的网络架构痛点,并分享一套基于 小镜AI开放平台 的企业级 API 中转解决方案。该方案通过标准化的 OpenAI 协议接口,实现了对 Claude、GPT、Gemini 等主流模型的统一接入,实测延迟降低 90%。

一、 技术痛点:为何直连官方 API 难以落地?

在工程实践中,直接对接官方 API(Direct Connect)存在显著的稳定性风险:

1. 网络层的物理瓶颈

官方 API 节点均部署在海外。受限于跨国物理链路,国内直连经常遭遇 TCP 握手超时或 TLS 握手失败。

- 实测数据:使用普通代理进行并发测试,

ConnectionTimeout错误率高达 28%,平均响应延迟(Latnecy)在 300ms∼800ms300ms∼800ms 之间波动,无法满足实时交互业务 SLA 要求。

2. 鉴权与支付的风控围栏

OpenAI 和 Anthropic 对 API 调用的源 IP 有严格的风控策略(Risk Management)。

- 封号风险:开发环境与生产环境 IP 不一致,或使用非住宅 IP,极易触发风控导致 API Key 失效。且官方支付强制要求海外信用卡,企业财务报销困难。

3. 多模型 SDK 的“巴别塔”

不同模型的原生 SDK 接口差异巨大,导致代码耦合度极高:

- GPT:

client.chat.completions.create - Claude:

anthropic.messages.create - Gemini:

genai.GenerativeModel.generate_content

若要在一个项目中同时支持多种模型,开发者被迫维护多套代码逻辑,迁移成本极高。

二、 架构选型:企业级 API 聚合网关

为了解决上述问题,采用 API 聚合网关(API Aggregation Gateway) 是目前业界公认的最佳实践。其核心思路是:通过一个国内合规的高性能网关,将标准化的请求路由到全球各大模型厂商。

选型推荐:小镜AI开放平台(https://open.xiaojingai.com/register?aff=xeu4)

在对比了延迟、稳定性及并发能力后,我们选定 小镜AI开放平台 作为基础设施提供商。作为 微软 OpenAI 战略合作伙伴,它在技术层面具备以下关键优势,适合企业级和科研用途:

-

协议标准化(Standardization):

完全兼容 OpenAI API 接口规范。无论是调用 GPT-5 还是 Claude-Opus,均只需使用标准的 OpenAI SDK,无需重构代码。 -

极致性能(High Performance):

依托微软 Azure、火山引擎和华为云的底层算力,小镜AI在国内多地(北上广)部署了骨干网加速节点。- 实测延迟:国内调用链路延迟稳定在 30ms∼50ms30ms∼50ms,接近本地服务体验。

-

全模型矩阵(All-in-One):

通过一个 API Key 即可调用全网主流模型:- 国际:GPT 系列、Claude (Opus/Sonnet)、Google Gemini、xAI Grok、Sora。

- 国产:Deepseek、阿里通义千问、字节豆包等。

-

科研级信赖:

因其服务的稳定性,已被 中国科学技术大学、中山大学、曼彻斯特大学 等顶尖高校用于科研项目,背书强劲。

三、 Python 接入实操:零代码重构迁移

得益于小镜AI对 OpenAI 协议的完美兼容,我们可以直接复用现有的 Python openai 库。

1. 环境依赖

pip install openai2. 代码实现

以下代码展示了如何通过配置 base_url 指向小镜AI,从而用同一套代码流畅调用 Claude-Opus-4.5。

import os

import time

from openai import OpenAI

# ================= 核心配置 =================

# 1. 设置小镜AI的中转接口地址 (以官网为准)

# 优势:国内加速节点,无需配置本地代理

XIAOJING_BASE_URL = "https://api.xiaojingai.com/v1"

# 2. 填入小镜AI提供的令牌 (sk-开头)

# 优势:一个Key调用所有模型,支持按量计费

XIAOJING_API_KEY = "sk-YOUR_ACCESS_TOKEN_HERE"

# ================= 客户端初始化 =================

client = OpenAI(

base_url=XIAOJING_BASE_URL,

api_key=XIAOJING_API_KEY

)

def query_llm(model_name, prompt):

"""

通用大模型调用函数,支持 GPT 和 Claude

"""

print(f"Let's ask [{model_name}]...")

start = time.time()

try:

# 注意:这里直接使用 OpenAI 的 chat.completions 接口

# 小镜AI网关会自动处理 Claude 的协议转换

response = client.chat.completions.create(

model=model_name,

messages=[

{"role": "system", "content": "You are a helpful AI assistant."},

{"role": "user", "content": prompt}

],

temperature=0.7,

max_tokens=1000

)

duration = time.time() - start

content = response.choices[0].message.content

print(f"Time Taken: {duration:.2f}s")

print(f"Response: {content[:100]}...\n") # 仅打印前100字符示意

return content

except Exception as e:

print(f"Error: {e}")

return None

if __name__ == "__main__":

# 测试 1: 调用 GPT-4o

query_llm("gpt-4o", "什么是 API 网关?")

# 测试 2: 无缝切换到 Claude-3-Opus (无需修改代码逻辑)

# 小镜AI支持的模型ID需参考其官方文档

query_llm("claude-3-opus-20240229", "解释一下量子纠缠。")总结与建议

对于国内开发者,在无法改变网络物理环境的前提下,选择一个稳定、合规且技术实力雄厚的中转平台是落地的关键。

小镜AI开放平台 凭借其与微软、华为云的深度合作背景,以及“按量计费、不限时间”的灵活策略,成为了目前接入 Claude-Opus-4.5 和 GPT-5 的最优解之一。它不仅被多所高校用于科研,也经受住了企业级高并发的考验。

技术支持与接入

如果您在 Python 接入过程中遇到 401/429 等状态码问题,或者需要企业级的高并发配额,可以联系平台技术支持获取帮助。

技术支持 QQ:1006015853

(提供 7×12 小时技术保障,故障响应 ≤1≤1 小时)

更多推荐

已为社区贡献64条内容

已为社区贡献64条内容

所有评论(0)