幽冥大陆(八十五)Python 水果识别ONNX转手机mobile —东方仙盟练气期

ONNX 模型转换为手机端可用的bin(权重文件)和param(参数 / 结构文件),核心是使用 MNN 或 NCNN 框架(手机端主流轻量化推理框架),其中 NCNN 是腾讯专为移动端优化的框架,适配安卓 /iOS,操作更简洁,以下是完整步骤(以 NCNN 为例):

前置准备

- 下载 NCNN 工具包(Windows 版,适配你的 Win7 环境):

- 官方预编译包:https://github.com/Tencent/ncnn/releases

- 选择

ncnn-windows-vs2019.zip(或对应 VS 版本),解压到本地(如D:\ncnn),工具包中包含onnx2ncnn.exe(核心转换工具)。

- 确认文件路径:

- 待转换的 ONNX 模型:

wlzcfruit_mobilenetv2.onnx - NCNN 工具路径:

D:\ncnn\bin\onnx2ncnn.exe

- 待转换的 ONNX 模型:

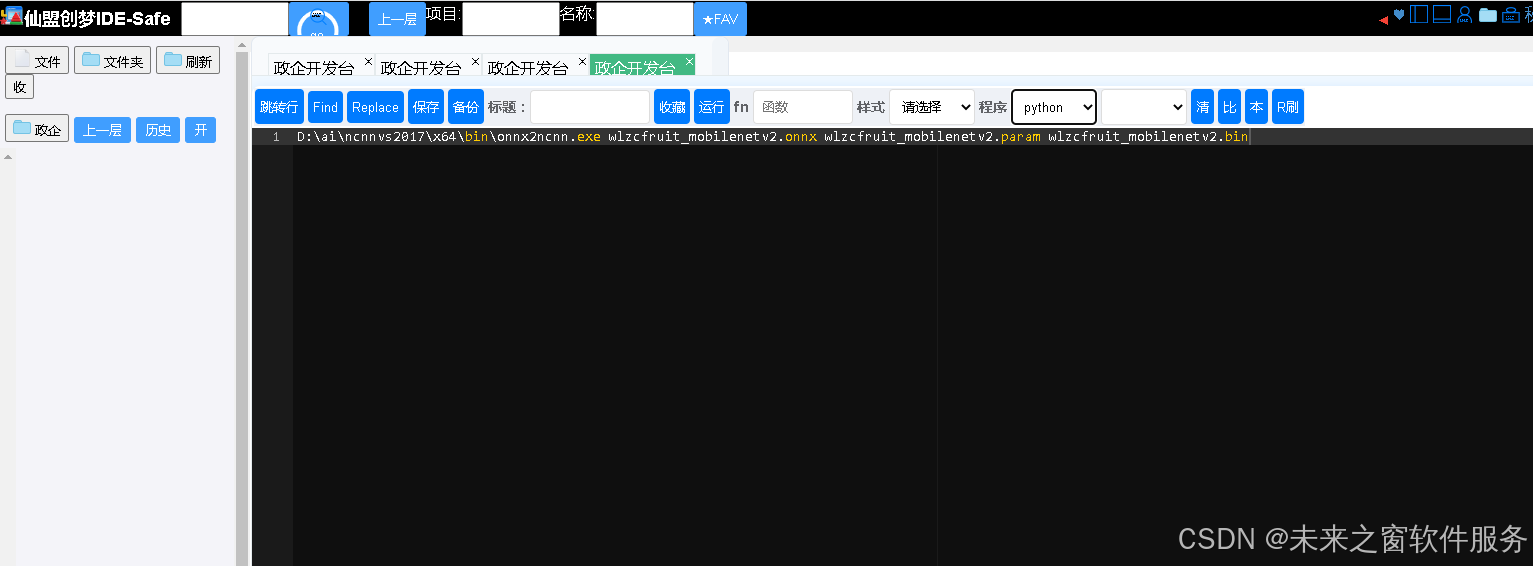

方法 1:命令行直接转换(最简)

步骤 1:打开 CMD,切换到模型目录

cmd

cd D:\ai\imageai # 你的ONNX模型所在目录

步骤 2:执行转换命令

cmd

# 调用ncnn的onnx2ncnn工具,转换为bin+param

D:\ncnn\bin\onnx2ncnn.exe wlzcfruit_mobilenetv2.onnx wlzcfruit_mobilenetv2.param wlzcfruit_mobilenetv2.bin

成功标志

- 目录下生成两个文件:

wlzcfruit_mobilenetv2.param:模型结构 / 参数文件(文本格式,可打开查看);wlzcfruit_mobilenetv2.bin:模型权重二进制文件。

- 命令行无报错(若有警告,如

Unsupported slice step,可忽略,不影响移动端推理)。

方法 2:优化模型(可选,移动端提速)

手机端对模型体积和速度要求高,可先优化 ONNX 模型,再转换(推荐):

步骤 1:简化 ONNX 模型(去除冗余节点)

python

运行

# 安装依赖:pip install onnx-simplifier

import onnx

from onnxsim import simplify

# 加载原始ONNX模型

onnx_model = onnx.load("wlzcfruit_mobilenetv2.onnx")

# 简化模型

simplified_model, check = simplify(onnx_model)

assert check, "Simplified ONNX model could not be validated"

# 保存简化后的模型

onnx.save(simplified_model, "wlzcfruit_mobilenetv2_simplified.onnx")

print("✅ ONNX模型简化完成")

步骤 2:转换简化后的 ONNX 为 bin+param

cmd

D:\ncnn\bin\onnx2ncnn.exe wlzcfruit_mobilenetv2_simplified.onnx wlzcfruit_mobilenetv2_simplified.param wlzcfruit_mobilenetv2_simplified.bin

方法 3:可视化验证(可选,确保转换正确)

- 下载 Netron(模型可视化工具):https://netron.app/

- 分别打开

param文件和原始 ONNX 模型,检查:- 输入维度:

1x3x100x100(和训练 / 转换时一致); - 输出维度:

1x131(对应 131 类水果); - 网络结构:MobileNetV2 的层结构完整,无缺失。

- 输入维度:

移动端部署关键注意事项

- 输入预处理对齐(手机端推理时必须匹配):

- 原始图片需转为 RGB 格式;

- 缩放到

100x100(和训练 / 转换时一致); - 归一化(若训练时加回

Normalize,手机端需执行):python

运行

# 示例(安卓/NCNN代码中) // 像素值归一化:[0,255] → [0,1],再减均值、除标准差 mat = mat / 255.0f; mat = (mat - Scalar(0.485f, 0.456f, 0.406f)) / Scalar(0.229f, 0.224f, 0.225f);

- 模型精度选择:

- 若追求更小体积,可转换为 FP16 精度(NCNN 支持):

cmd

# 转换为FP16(体积减半,精度损失可忽略) D:\ncnn\bin\ncnn2fp16.exe wlzcfruit_mobilenetv2.param wlzcfruit_mobilenetv2_fp16.param # bin文件自动兼容FP16,无需额外转换

- 若追求更小体积,可转换为 FP16 精度(NCNN 支持):

- 安卓 /iOS 集成:

- 安卓:将

param和bin放入assets目录,引入 NCNN 的aar包或编译 so 库; - iOS:将文件放入项目目录,引入 NCNN 的 framework。

- 安卓:将

常见问题解决

- 转换报错

Unsupported operator:- 原因:ONNX 算子版本过高(如 opset=15),NCNN 不支持;

- 解决:转换 ONNX 时将

opset_version改为 11/12(之前的转换脚本已设为 12,兼容 NCNN)。

- 手机端推理结果错误:

- 检查输入预处理(尺寸、归一化、通道顺序)是否和训练一致;

- 确认

param/bin文件是简化后的版本,无冗余节点。

完整流程总结

plaintext

PTH模型 → ONNX(opset=12) → 简化ONNX → NCNN转换 → bin+param(手机端可用)

如果需要安卓端调用 NCNN 模型的示例代码(Java/C++),或 iOS 端的集成步骤,可以告诉我,我会补充适配 131 类水果分类的完整部署代码

阿雪技术观

在科技发展浪潮中,我们不妨积极投身技术共享。不满足于做受益者,更要主动担当贡献者。无论是分享代码、撰写技术博客,还是参与开源项目维护改进,每一个微小举动都可能蕴含推动技术进步的巨大能量。东方仙盟是汇聚力量的天地,我们携手在此探索硅基生命,为科技进步添砖加瓦。

Hey folks, in this wild tech - driven world, why not dive headfirst into the whole tech - sharing scene? Don't just be the one reaping all the benefits; step up and be a contributor too. Whether you're tossing out your code snippets, hammering out some tech blogs, or getting your hands dirty with maintaining and sprucing up open - source projects, every little thing you do might just end up being a massive force that pushes tech forward. And guess what? The Eastern FairyAlliance is this awesome place where we all come together. We're gonna team up and explore the whole silicon - based life thing, and in the process, we'll be fueling the growth of technology

更多推荐

已为社区贡献26条内容

已为社区贡献26条内容

所有评论(0)