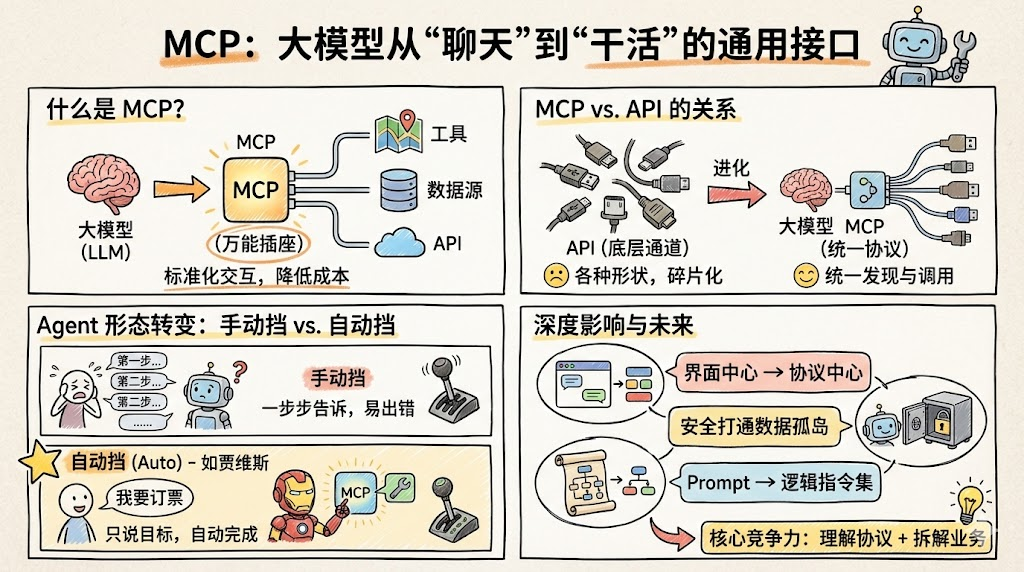

LLM - MCP 实战指南 : N×M → N+M 架构革命

摘要 Model Context Protocol(MCP)是一种开放标准协议,旨在解决大模型与外部工具、数据源集成困难的问题。MCP通过统一接口连接AI应用(如LLM、Agent)与各类服务,降低集成复杂度,促进开放生态。核心包括基于JSON-RPC的协议层、工具调用、资源访问和提示模板三大能力,支持多种传输方式。相比传统插件或手写集成,MCP将N×M的定制集成简化为N+M的标准协议,实现解耦复

文章目录

引言:大模型的“有思无行”困境

过去两年,大模型在理解语言、生成文本上的能力突飞猛进,却始终面对一个关键缺陷:它们缺乏稳定、统一的方式去调用真实世界中的工具和数据。模型可以写代码、解释日志,却没法直接“查订单、批量改价、跑财务报表”。

传统做法是:为每个模型、每个系统写一套专用集成代码,结果就是集成成本爆炸、维护困难、难以复用。**Model Context Protocol(MCP)**的出现,正是要解决这一“最后一公里”:用一个开放协议,把各种模型、Agent 和外部工具、数据源统一接起来。

一、MCP 是什么:给 AI 装上标准化“神经末梢”

1.1 官方定义与设计目标

MCP 由 Anthropic 在 2024 年末提出,是一个连接 AI 应用(如 LLM、Agent)与外部工具和数据源的开放标准协议。它定义了一个通用的通信方式,让模型可以通过统一的接口发现、调用各种服务,而不需要为每个服务写定制适配层。

协议规范给出了几个核心构件:

- 基于 JSON-RPC 2.0 的基础协议层,统一消息结构与错误处理

- 生命周期管理:初始化、能力协商、会话管理、版本协商

- 服务器特性:以“工具(tools)”、“资源(resources)”、“提示(prompts)”的形式暴露能力

- 客户端特性:如采样(sampling)、根目录列表等,让客户端也能向 Server 宣告自身能力

其核心目标可以概括为三点:

- 降低集成复杂度:把 N×M 的定制集成变成 N+M 的标准协议集成

- 开放生态:让任意 MCP Server 可以被任意支持 MCP 的模型/客户端复用

- 安全可控:在标准里内建认证、授权、能力协商和可观测性挂钩点。

1.2 MCP vs 传统插件 / 手写集成

从工程视角看,MCP 与以往“插件”“扩展点”的核心差异在于:它是一个跨平台的协议标准,而不是某家平台的私有机制。

典型对比:

- 传统 ChatGPT 插件 / 平台自带 tools:协议细节由平台控制,其他平台不可复用

- 手写 API 集成:每接一个系统就要写一次 glue code,迁移模型时需要重写

- MCP:只要模型侧支持 MCP,就可以统一通过 MCP Server 暴露的工具/资源交互,不再与具体模型厂商绑定。

很多人用“USB‑C 比喻 MCP”:过去每台设备一个奇形怪状的充电口,而 MCP 想做的是“给 AI 一个统一 Type‑C 口”,任何符合规范的工具/数据源都能插上就用。

1.3 四个核心角色与消息流

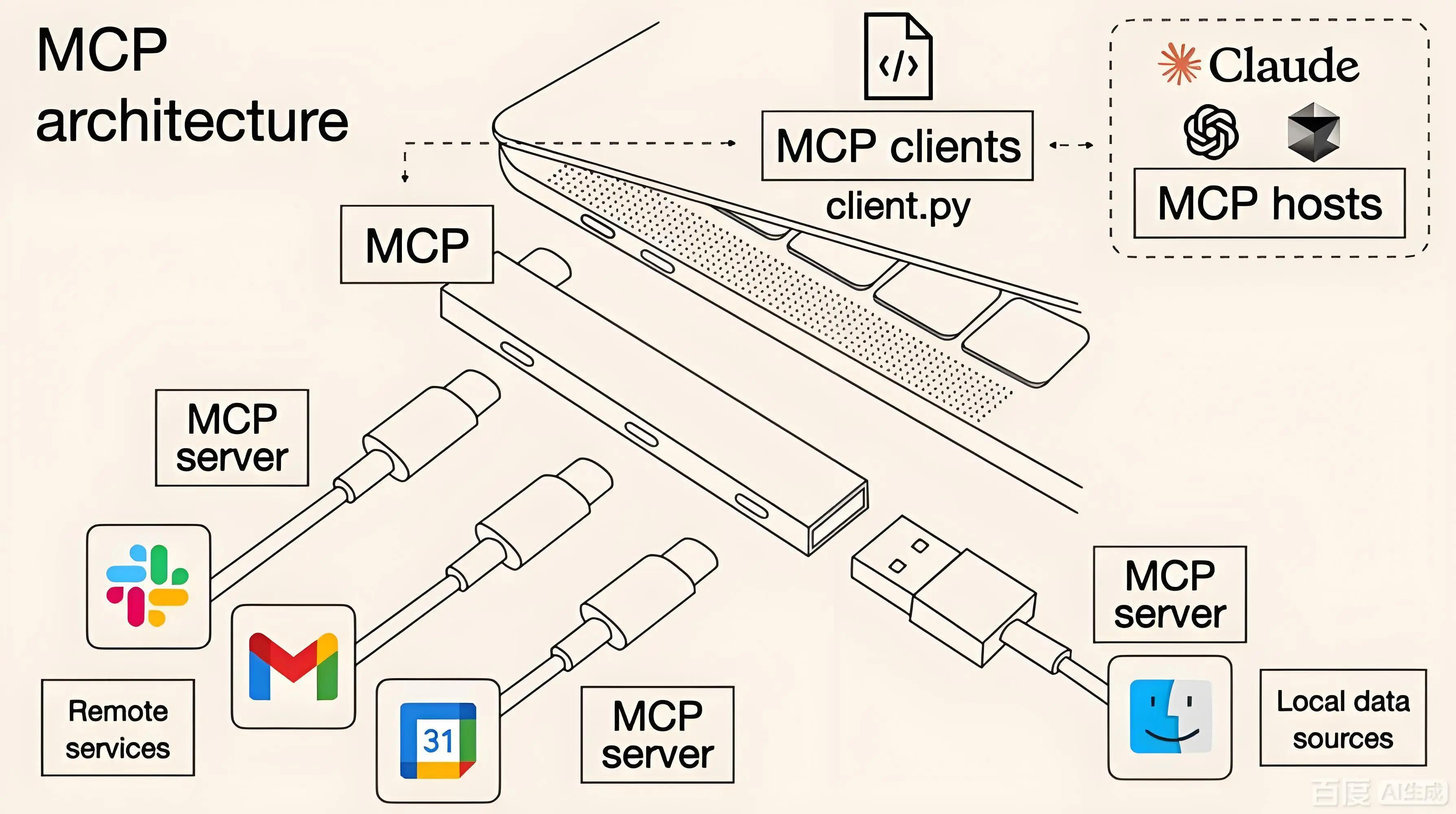

一个最简 MCP 体系包含三大组件和一条通信通道:

- MCP Client / Host:运行模型或 Agent 的一端,例如 IDE、聊天应用或后端服务

- MCP Server:包装具体业务能力或数据源的服务,向外暴露 tools/resources/prompts

- 传输层:STDIO、本地进程通信或 HTTP+SSE

- JSON-RPC 消息协议:定义请求/响应的格式、错误码和通知机制

典型调用流程:

- 客户端发起初始化请求(initialize),双方协商协议版本与可用特性

- Server 返回自身支持的工具、资源和提示模板列表,客户端更新内部“能力图谱”

- 模型在推理过程中决定调用某个工具,Client 发起 JSON-RPC 请求到 Server

- Server 调用内部 API 或服务,返回结构化结果,写入模型上下文

- 会话结束时通过 shutdown/exit 等流程干净关闭连接。

二、为什么需要 MCP:从 N×M 地狱到 N+M 的优雅

2.1 “烟囱式开发”的典型痛点

在 MCP 出现之前,大多数 AI 集成项目是这样展开的:

- 每个业务系统面向特定模型写一套专用 API 封装层

- 每家模型厂商又有自己的一套工具描述格式和调用协议

- 当企业希望接入第二家模型、或引入多 Agent 协作时,原有集成逻辑几乎无法复用。

这会导致典型的 N×M 问题:

- N 个系统 × M 个模型 / Agent,理论上需要维护 N×M 条集成链路

- 任何一端的变更(模型版本升级、API 改版)都可能引发全局连锁修改。

这种“烟囱式”工程模式极大限制了 AI 在企业内的规模化落地,因为每做一个新集成都要付出高昂的工程与治理成本。

2.2 协议化之后:解耦、复用与生态效应

MCP 把问题重新拆分成更可控的 N+M:

- 对系统/工具方:只要做一次 MCP Server 封装,就能同时被所有支持 MCP 的模型/客户端复用

- 对模型/客户端方:只要实现一次 MCP Client,就能访问生态里的所有 MCP Server。

这种协议化带来三个工程收益:

- 解耦:工具和模型之间只依赖 MCP 协议,不关心对方具体实现

- 复用:一个高质量 MCP Server 可以被 IDE、聊天助手、企业 Agent 平台等多种消费者共享

- 网络效应:MCP Client 越多,Server 越愿意接入;Server 越多,Client 越有价值,形成正反馈生态。

某种意义上,MCP 正在尝试成为“AI 时代的 HTTP+REST”,把原本封闭的“AI 插件生态”改造成开放的协议互联世界。

2.3 与 Function Calling、OpenAPI 的关系

很多开发者会问:已经有 Function Calling 和 OpenAPI,为何还需要 MCP?可以简要对比一下:

| 维度 | Function Calling(厂商私有) | OpenAPI/REST | MCP 协议 |

|---|---|---|---|

| 标准属性 | 各家模型私有实现 | 通用 HTTP 规范 | 专为“模型 ↔ 工具”设计的开放标准 |

| 调用发起方 | 模型侧 | 任意客户端 | 模型/Agent 通过 MCP Client |

| 能力表达 | 函数/参数描述 | 路径/方法/Schema 描述 | tools+resources+prompts 三合一 |

| 生命周期管理 | 弱(单次调用) | API 层连接管理 | 有初始化、能力协商、会话控制 |

| 跨模型复用 | 较差 | 需手写适配 | 一次实现,多端复用 |

可以把 MCP 看作 在 Function Calling 之上,又往下打通到 OpenAPI/内部服务 的“中间协议层”:

- 上接:模型内部的工具调用 / Function Calling 语义

- 下接:已有 REST/gRPC/OpenAPI/数据库等实际实现。

三、MCP 协议的核心能力与技术细节

3.1 工具调用(tools):标准化的函数接口

在 MCP 中,“工具”是一等公民,Server 用结构化元数据描述每个工具的:名称、用途说明、输入参数 Schema、输出结构等。

工具调用的几个要点:

- 工具描述通常采用 JSON Schema 风格,让客户端可以自动生成参数表单、校验输入

- 模型在推理时会根据工具元信息自动决定是否调用、如何填参,客户端负责把调用意图转成具体 JSON-RPC 请求

- 返回结果是结构化 JSON,可以直接写回模型上下文或被下游组件消费。

这种统一抽象让“写工具”变成一种标准工程工作,而非每个平台都要写一套私有插件协议。

3.2 资源访问(resources):打通外部数据视图

除了“做事”的工具,MCP 还引入了“资源(resources)”概念,用于表示可以被读取或查询的外部数据视图,例如文档、数据库查询结果、配置项等。

资源机制带来两个好处:

- 服务端可以按需暴露数据视图,而不是把整个数据库直接塞给模型

- 客户端可以用统一接口浏览、检索、分页获取数据,实现类似“文件系统 + 查询 API”的体验。

例如公共数据集 MCP Server,可以通过资源接口将全球统计数据以可查询、可组合的方式暴露出来,让分析师用自然语言提问并得到结构化结果。

3.3 提示模板(prompts):把 Prompt 工程产品化

Prompt 在 MCP 中也被提升为协议层概念:Server 可以暴露一组带变量占位符的“提示模板”,供客户端在不同场景下复用。

意义在于:

- 将成熟的提示工程成果封装为可复用构件,而不是散落在代码或文档里的“魔法咒语”

- 客户端只需填充变量并选择合适模板,就能保证不同 Agent 在同一任务上的行为一致性。

对大型团队来说,这使得 Prompt 工程可以像 API 设计一样纳入版本控制和评审流程,真正成为工程资产。

3.4 传输层与协议栈:JSON-RPC、STDIO、HTTP+SSE

在传输层,MCP 采用 JSON-RPC 2.0 作为数据层格式,再在其上允许多种传输方式。

典型组合:

- 本地工具 / IDE 插件:偏向 STDIO 或本地进程通信,部署简单,延迟低

- 远程服务 / 云端工具:使用 HTTP+SSE 或 WebSocket,支持长连接与流式结果返回。

协议生命周期包含:

- 初始化:客户端发送 initialize 请求,双方协商协议版本与能力

- 能力协商:双方声明支持的特性(工具、资源、采样能力等),只在交集范围内工作

- 会话管理:包括关闭、错误恢复、版本不匹配处理等。

3.5 安全模型与权限控制:Who can do what?

围绕 MCP,社区逐步形成了基于“最小权限”和“策略驱动”的安全模型:

- 授权框架:在 HTTP 传输上引入基于 Token/OIDC/mTLS 的认证与授权机制,确保只有合法客户端可以访问 MCP Server

- 工具级别的访问控制:为每个工具、资源设定角色和策略,只允许特定 Agent / 业务域调用

- 能力协商中的“能力裁剪”:Server 可以根据客户端身份下发不同子集的工具列表,从源头控制可见面板。

这使得 MCP 不仅是“能接得上”,而且是“接得安全、可审计”,适合进入对合规性要求极高的企业环境。

四、从 LLM 到 Agent:MCP 驱动的“自动档工作流”

4.1 “手动挡”指令 vs “自动档”意图驱动

在没有 MCP 的年代,大多数“AI 自动化”是人工主导、模型辅助:

- 人类拆解任务,逐步指挥模型:“先查库存,再生成 SQL,再调接口……”

- 每一步都要人工 glue,不仅麻烦,而且难以复用。

MCP 把这个过程变成“自动档”:

- 用户只需要表达意图(例如“帮我查一下过去一周华北大区的销售情况并生成总结报告”)

- 模型在内部完成:理解 → 规划 → 选择工具 → 调用 → 整合 → 复述整个闭环。

此时,人类从“脚本驱动者”变成“目标设定者”,具体步骤由 Agent 在 MCP 提供的工具宇宙中自行探索和执行。

4.2 Agent 决策回路:感知 → 规划 → 工具调用 → 反思

结合 MCP 的 Agent 通常遵循类似的决策回路:

- 感知:接收用户指令和当前上下文

- 规划:基于内置或学习到的策略,决定完成任务所需的子任务序列

- 工具选择与调用:

- 通过 MCP 的工具清单挑选合适工具

- 构造参数,发起 JSON-RPC 调用

- 结果整合:解析返回结果,更新内部“世界状态”

- 反思与迭代:判断是否达到目标,若未达到,则调整计划或调用新的工具

- 输出:给出最终结果或中间反馈。

MCP 在其中扮演的是“神经末梢接口”:它不负责 Agent 的大脑逻辑,但负责大脑与外界之间每一次可靠、标准化的“伸手”。

五、实战思路:用 MCP 搭一个智能行程规划 Agent

以社区常见教学案例为例,可以通过 MCP 接入地图、天气等服务,构建一个“智能行程规划 Agent”。

设计思路大致如下:

- 工具集:

- 地图工具(如高德 MCP Server):路线规划、距离估算、实时路况查询

- 天气工具:指定城市/时间段天气预报

- 模板工具:根据结果生成 Markdown/HTML 行程单

- 业务流程:

- 用户输入出发地、目的地和时间约束

- Agent 通过 MCP 调用地图工具获取多条可行路线

- 再调用天气工具过滤掉极端天气路线

- 生成一份包含路程耗时、票价、天气提示的行程建议

在实现层面:

- 每个第三方服务只需实现一次 MCP Server,就能被 IDE、聊天助手和内部运营 Agent 统一复用

- Agent 逻辑主要集中在 Prompt 设计与任务分解,而不是数据抓取细节上。

六、工程视角:如何在你的系统中引入 MCP

6.1 你是否真的需要一个 MCP Server?

引入 MCP 前,工程团队应先判断:

- 是否有多系统、多模型协同的需求?如果只是单一模型 + 单一系统,小规模 Function Calling 可能更简单

- 是否希望同一套工具接口在多模型、多客户端之间长期复用?

- 是否有明确的数据安全、权限分级需求,希望为模型划定可控的“观察窗口”?

如果这些问题中有多项回答为“是”,那就很适合将关键业务能力 MCP 化;否则可以先通过一个 Demo 场景试水,评估收益与成本。

6.2 常见系统如何 MCP 化

可以按“由外到内、由简到繁”的顺序推进改造:

- 第一步:挑选适合作为工具的能力

- 优先纯查询、计算、报表类能力,输入输出清晰、无强副作用

- 暂缓复杂长事务、多步审批类流程,先通过现有工作流抽象成上层 API 再接入 MCP

- 第二步:在现有系统旁增加 MCP Server 适配层

- 暴露工具/资源/提示模板定义

- 将 MCP 调用转发为内部 REST/gRPC 调用

- 嵌入鉴权、审计和限流逻辑

- 第三步:建设统一的 MCP Client / Agent 接入层

- 集中管理 MCP Server 列表和配置

- 基于业务线、环境和角色分发不同的工具集

- 统一采集调用日志和指标,纳入监控体系

从架构上看,MCP Server 更像是“面向 LLM 的 BFF(Backend for Frontend)”,而现有微服务和中台基本可以保持不动,减少对存量系统的侵入性。

6.3 安全、治理与可观测性要点

企业级落地时,安全与治理往往比“是否能调通”更重要:

- 安全:

- 工具分级 + 最小权限 + 环境隔离

- 与现有 IAM / API Gateway / 零信任体系打通

- 对高风险工具增加审批或人工确认环节

- 治理:

- 建 MCP Registry / 目录服务,统一登记所有工具与 Server

- 用策略引擎管理“谁能在什么上下文下调什么工具”

- 管理版本、废弃、Owner 和 SLO

- 可观测性:

- 细粒度审计日志(调用原因、参数摘要、结果摘要)

- 指标监控与异常告警(调用量、错误率、延迟、异常模式)

- 与自动化防护联动,发现异常行为时限流、熔断或暂时下线某些工具

这些实践让 MCP 不只是“一个好用的开发协议”,而是能在真实生产环境中承载关键任务的企业级基础设施。

结语:如果 MCP 成为事实标准,世界会怎样?

如果 MCP 最终像 HTTP 一样成为事实标准,开发者编写的将不再是“一次性的 AI 集成脚本”,而是可以在任意 MCP 兼容平台上复用的“AI 能力模块”。

对个人开发者而言,这意味着:一个优秀的 MCP Server,可以像今天的开源库一样被广泛复用;对企业而言,MCP 则提供了一条可控、安全、可治理的路径,把已经建设多年的数字化资产真正“接上 AI 的大脑和神经末梢”。

更多推荐

已为社区贡献70条内容

已为社区贡献70条内容

所有评论(0)