Lux 上手指南:让 AI 直接操作你的电脑

Lux 是一款能直接操作计算机的AI基础模型,通过视觉理解与动作预测,实现自然语言指令下的自动化任务。它无需依赖API,可像真人一样点击、输入、滚动,完成浏览器操作等复杂工作,准确率超越主流模型,是迈向“意图即执行”的重要突破。

Lux 要是一个专门用于计算机操作的基础模型。和那些只会生成文字的 AI 不同,Lux 能看懂屏幕内容并理解自然语言描述的任务目标,然后实时操控计算机完成工作。

比如说你对电脑说"打开浏览器,访问 xxx",然后它就真的执行了:鼠标移动、图标点击、网址输入、页面滚动,整个过程和真人操作没什么区别。

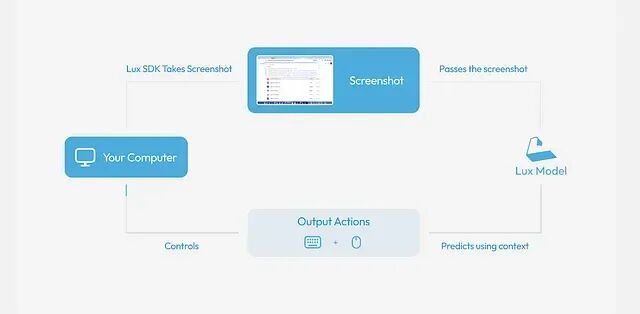

Lux 的技术实现

Lux 不依赖 API 接口所以能在任何应用中工作:浏览器、编辑器、邮件客户端、表格软件都行。它的核心技术是计算机视觉配合动作预测:

- 捕获屏幕截图

- 解析 UI 组件

- 预测下一步操作(点击、输入、滚动)

- 循环执行直到任务结束

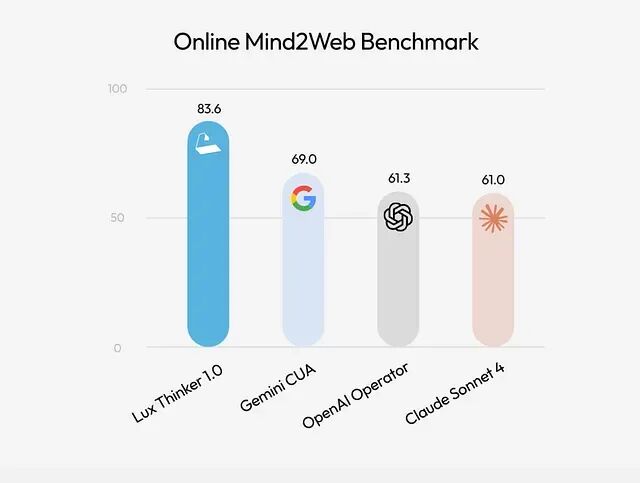

在 300 个实际场景的测试中,Lux 的表现超过了 Google Gemini CUA、OpenAI Operator 和 Anthropic Claude。

工作机制

Lux 运行在一个持续的动作-观察循环里:

目标 → 视觉分析 → 执行动作 → 获取反馈 → 循环

用户用自然语言下达指令,比如:“打开浏览器并打开 xxx”,然后Lux 会截取当前屏幕画面并根据截图内容判断下一步该做什么:

- 点击某个按钮

- 输入文字

- 移动光标

- 滚动页面

- 触发快捷键

然后执行相应的动作并捕获新的屏幕状态。

这个循环会一直跑下去直到任务完成,可以把它想象成一个坐在你电脑前干活的 AI 助手。

环境配置

在使用 Lux 之前需要完成安装和权限设置。

步骤 1:权限授予

Lux 需要的权限和普通自动化工具一样:屏幕录制权限和辅助功能权限。

执行命令:

oagi agent permission

macOS 系统系统会弹出权限请求:

- 辅助功能

- 屏幕录制

在 系统设置 — 隐私与安全 里批准这些权限,完成后重启终端。

步骤 2:API 认证

打开 agiopen生成新的 API 密钥。新注册用户有 $10 免费额度,够跑几十次代理任务了。

配置环境变量

export OAGI_API_KEY=sk-...

export OAGI_BASE_URL=https://api.agiopen.org

步骤 3:桌面环境准备

Lux 直接读取屏幕内容,所以工作区越干净UI 元素识别就越准确。

推荐配置如下

- 单个大窗口的浏览器

- 空白起始页

- 桌面整洁

- 背景简洁

不推荐的配置

- 窗口又小又乱

- 多个程序互相遮挡

- 复杂的桌面壁纸

环境混乱的话Lux 可能会重试操作或者点错位置。

步骤 4:第一次运行

oagi agent run "Go to https://agiopen.org" --model "lux-actor-1"

你会看到鼠标自己动、键盘自己敲字,整个过程完全自动化。

实际案例

假设要让 Lux 完成这样一个任务:

启动浏览器,搜索 “OpenAGI Lux model documentation” 浏览搜索结果

命令是:

oagi agent run "Open a browser, search for OpenAGI Lux model documentation, and scroll through the results." --model "lux-actor-1"

Lux 会依次:

- 识别浏览器图标

- 点击启动

- 找到搜索框

- 输入关键词

- 按回车

- 检测页面可滚动区域

- 逐步向下翻页

全程靠视觉理解和动作预测完成。

总结

Lux 不只是个模型,它代表了一个方向:让计算机能直接响应人的意图,而不是通过一系列点击来间接表达。

如果你曾经希望电脑能"替你把事情做了"Lux 把这个想法变成了现实。

https://avoid.overfit.cn/post/084c91d2d2df493f8daa93b25268a6c8

作者:Civil Learning

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)