算力狂飙,散热告急:两相冷板为何成为AI数据中心的“救命稻草”?

摘要:随着AI芯片功耗突破1.5千瓦,传统散热技术面临极限,两相冷板液冷技术凭借相变传热优势成为关键解决方案。该技术能处理500W/cm²以上的热流密度,显著降低能耗(PUE 1.08-1.12),并保持芯片温度均匀。中国冷泉能控等企业已实现规模化商用,采用可调沸点工质和智能控制系统。尽管存在成本高、标准缺失等挑战,两相冷板液冷仍是AI算力持续增长的必要选择,未来或向智能化工质、芯片集成等方向发展

当单颗AI芯片功耗突破1.5千瓦,机柜功率密度逼近100kW,传统风冷早已力竭,单相液冷也接近天花板。 唯有两相冷板液冷——这项利用液体沸腾吸热、蒸汽冷凝放热的相变技术,正从实验室加速走向真实战场。 而在中国,已有企业悄然完成从样机到规模化部署的关键一跃。

一、AI算力爆炸,散热成了最大瓶颈

过去五年,AI训练算力需求年均增长超300%。以NVIDIA最新Blackwell架构为例,单卡TDP已突破1000W,若采用多芯片模组(MCM)设计,整卡功耗可达1.5kW以上。当数十张这样的卡密集部署于单机柜,芯片局部热流密度已普遍超过300 W/cm²,部分热点甚至逼近600 W/cm² [1]。

作为对比

-

传统风冷:可靠处理上限约 0.1 W/cm²;

-

单相液冷:工程化应用上限通常在 80–120 W/cm²;

-

两相冷板液冷:可稳定应对 500 W/cm² 以上 的热负荷。

更严峻的是,AI训练任务常需连续满载运行数周甚至数月,对散热系统的长期稳定性、温度均匀性、能耗效率提出极致要求。

散热,不再是配套工程,而是决定AI基础设施上限的核心变量。

二、为什么是两相冷板?

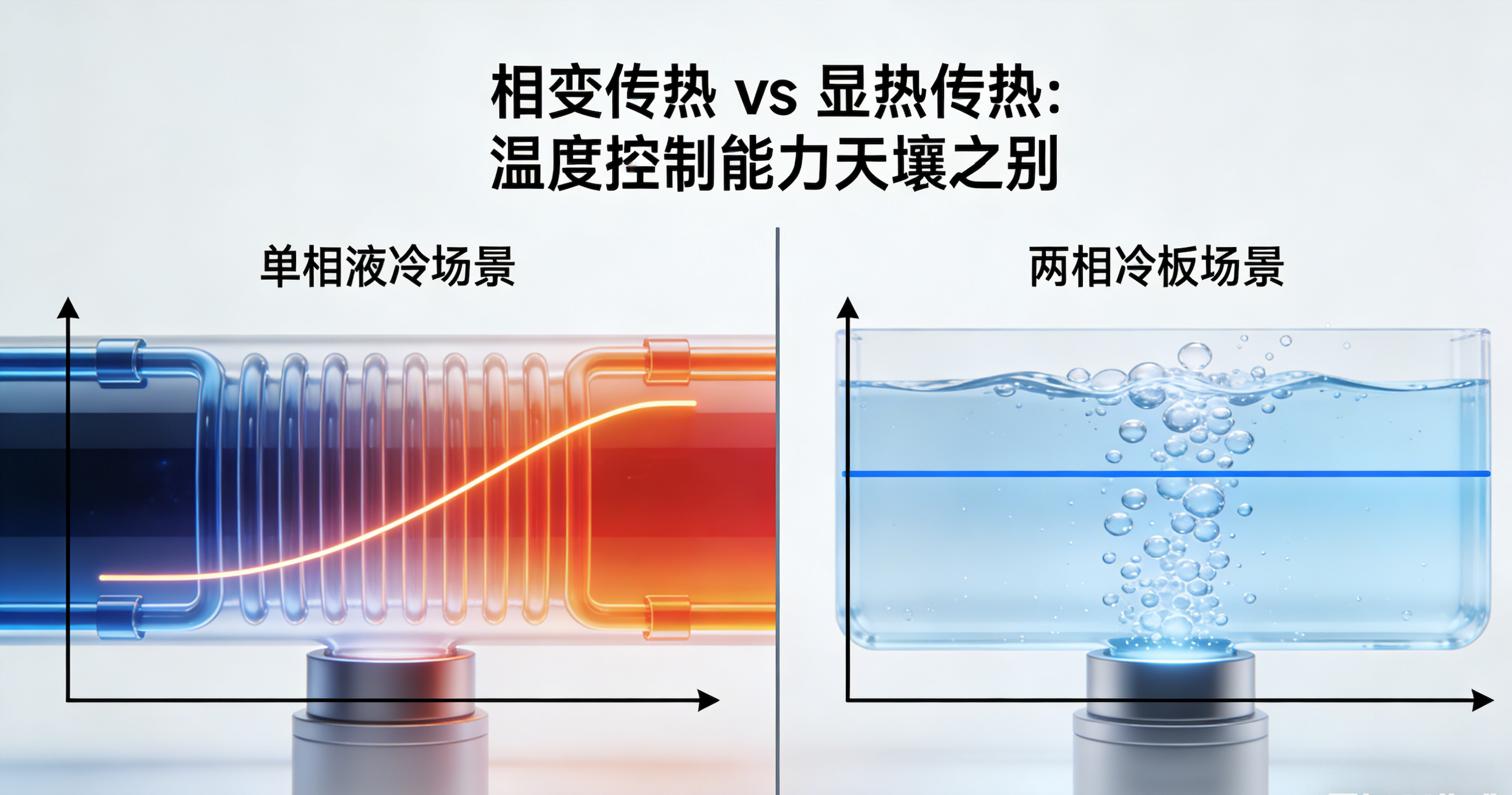

两相冷板液冷的核心原理,是在紧贴芯片的微通道内注入低沸点工质,使其受热后沸腾汽化(吸收大量潜热),蒸汽被导出至冷凝器液化放热,再回流至冷板,形成闭环。

【图2:两相 vs 单相传热对比示意图】

三大不可替代优势:

-

超高热流密度处理能力 实测CHF(临界热流密度)可达 500–800 W/cm²,足以覆盖当前及下一代AI芯片需求。

-

极低泵功与系统PUE 相变传热效率高,所需流量小,泵功比单相方案低30%~60%。实测数据中心PUE可稳定在 1.08–1.12 区间 [2]。

-

芯片温度高度均匀 沸腾过程维持近恒温,避免局部热点,延长GPU寿命并提升计算稳定性。

三、全球落地者寥寥,中国已有实践突破

目前,真正将两相冷板用于商业AI/HPC场景的企业屈指可数。国际上,Vertiv、Fujitsu、Submer等凭借多年积累率先布局。

而在中国,冷泉能控成为首个公开披露规模化商用案例的公司。据中国信通院《高密度液冷技术应用案例集(2024)》记载,其已完成H100的实机连续测试完成 [3]。

冷泉能控的技术路径亮点:

-

可调沸点定制氟化液 采用自研环保型合成工质,沸点可在40°C至60°C范围内按需调配。这一设计巧妙匹配不同数据中心的冷却水温条件——在南方高温地区选用高沸点配方,在北方或冬季可切换低沸点模式,最大化相变效率。

-

微通道冷板 + 智能控制 冷板内部采用微柱阵列增强成核,提升沸腾均匀性;系统集成压力、温度、液位多维传感,实现动态调节充注量与冷凝强度。

-

封闭但本地化 工质配方虽未公开,但由国内化工企业协同开发,确保供应链安全,并针对国产铝材优化兼容性。

四、国际玩家如何选择?

• Vertiv(美国)

采用R1234ze(HFO类),沸点约−19°C,环保性能优异,但属微燃物质,需复杂安全设计。

• Fujitsu(日本)

坚持使用R245fa(HFC类),不燃、稳定,但环保性差,面临政策淘汰风险。

• Submer(荷兰)

基于Asperitas技术,使用高沸点氟化液(~50°C),支持无泵被动回流,但工质封闭、成本高昂。

可见,无论开放还是封闭,工质与系统深度耦合已成为行业共识。

五、挑战犹存:成本、标准与生态

尽管优势显著,两相冷板仍未大规模普及,原因在于:

-

初期成本高:冷板加工精度要求高,工质价格是水的百倍以上;

-

运维门槛高:需专业人员处理充注、排气、泄漏;

-

缺乏统一标准:接口、工质、安全规范尚未形成行业共识;

-

用户习惯滞后:多数客户仍倾向“够用就好”的单相方案。

尤其在中国,如何平衡技术先进性、供应链安全、成本可控性,仍是产业界共同课题。

六、未来已来:两相冷板将如何演进?

-

工质智能化 未来工质或可根据负载动态调整沸点,实现“芯片-工质”协同优化。

-

冷板与封装融合 如Intel、AMD探索的“chiplet + 内嵌冷板”一体化设计,将散热通道直接集成到芯片基板。

-

AI驱动的控制系统 利用机器学习预测热负荷变化,提前调节工质流量与冷凝强度,提升瞬态响应能力。

结语:散热革命,才刚刚开始

两相冷板液冷不是炫技,而是AI时代基础设施的必然选择。当算力竞赛进入深水区,谁能在散热上领先一步,谁就握住了通往下一阶段的钥匙。

而中国的实践表明:我们不仅有能力跟进,更有机会在特定场景实现差异化突破。

📌 互动讨论:

在当前成本与技术条件下,两相冷板是否值得在普通AI集群中推广?

沸点可调的工质设计,是技术亮点还是过度复杂?

你更信任“开放标准工质”还是“封闭优化系统”?欢迎留言激辩!

参考文献(公开可查):

[1] NVIDIA. Blackwell Architecture Technical Brief, 2024. [2] 中国信息通信研究院. 《高密度液冷技术应用案例集(2024)》. [3] 同上,第35页. [4] Kandlikar S G. Critical Heat Flux in Flow Boiling, Heat Transfer Engineering, 2020. [5] Vertiv. Two-Phase Liquid Cooling for AI Workloads, White Paper, 2022.

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)