惊到了,硅谷工程文化真相研究:真正的工程师,根本没有vibe coding,他们在控制!全自动软件工程,并不符合工程现实!

vibe coding”作为一种热炒的概念,很好传播;但这项论文研究表明:作为一种工程方法,它并不成立。所以,开发者们可以放心了。真正的职业工程师,并没有把方向盘交给 AI,他们只是换了一种方式来控制代码的输出。“凭感觉”编程中的“感觉”,实际上更多是实际积累的“开发经验”。这,或许才是 AI 编程真正进入工程世界的标志。如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你

“vibe coding”作为一种热炒的概念,很好传播;但这项论文研究表明:作为一种工程方法,它并不成立。所以,开发者们可以放心了。

Vibe Coding 又被证明被“吹得的有点过了”!

过去一年,“Vibe Coding” 自前 OpenAI 创始成员 Karpathy 大神引燃之后,

整个 AI Coding 赛道十倍速地热闹了起来。LLM 厂商们以“肉眼都快分不清”的速度在编程能力上进行疯狂代际提升。智能编程也从最初的“超级自动补全”已经进化到了 Agentic 的自主编程时代。

如今 Vibe Coding的流行叙事变成了:只要“跟着感觉走就行了”,把需求丢给 AI,剩下的交给模型自动完成。

然而回到真实环境中,AI Coding 到底有多强?真正做软件开发的人,真的是这么干的吗?

最近,一项针对职业软件工程师的研究,给出了一个非常不“网感”的答案:几乎没有。工程师在意的,从来不只是快!

同时,在 HackerNews 上,也引起了热议。

一项不太“酷炫”,但很硬核的研究

这项研究的论文标题上来就点名主题:《Professional Software Developers Don’t Vibe, They Control》。

专业软件开发者们从不Vibe,他们控制!

这项研究来自加州大学圣地亚哥分校与康奈尔大学的软件工程与人机交互研究团队,作者中包括 Sorin Lerner——软件工程与程序分析领域的资深教授,也包括长期研究“工程师如何真实工作”的开发者工具学者。

这些软工正统学派们,打算从工程实践出发,让AI编程工具做了两件更难、也更有价值的事:

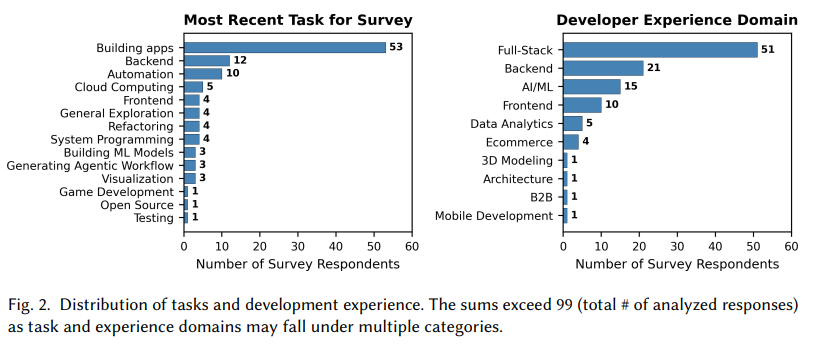

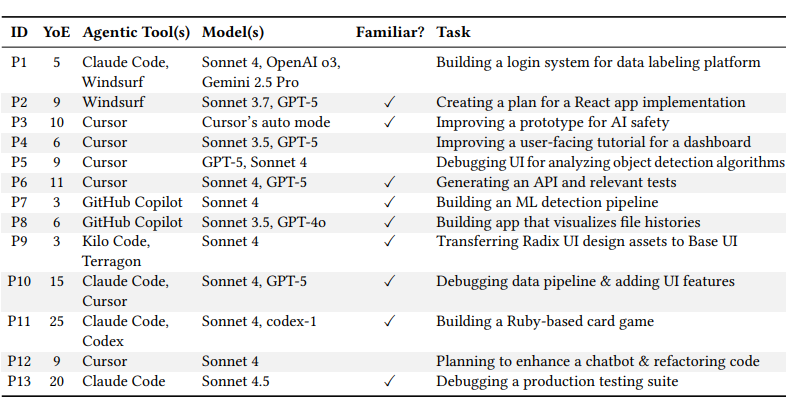

- 观察 13 位资深工程师 在真实项目中如何使用 AI 编程工具

- 调研 99 位职业开发者 的实际使用习惯与决策逻辑

PS:

这些工程师可都是货真价实的3~25年经验在职专业人士,不是学生,不是做 demo 的博主。他们用的也不是实验题,而是正在维护、随时可能出问题的真实代码库。

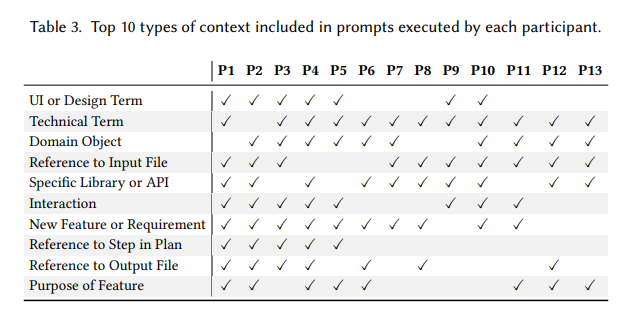

调查方面,每次研究会话包括两个部分:45 分钟的观察和 30 分钟的半结构化访谈。研究者通过 Zoom 进行研究,记录参与者的屏幕和音频以供分析。会话时间从 2025 年 8 月 1 日到 10 月 3 日。

调研的Agentic 工具覆盖了主流 AI Coding 工具,比如:Claude Code、Codex、Cursor、Windsurf、GIthub Copilot、Kilo Code、Terragon 等。有意思的事,可以看出 Sonnet 和 GPT-5 是最主流的选择。(因为论文研究时间是在8月-10月,当时并没有推出最新一代的前沿模型。)

一句话,研究真正想回答的,其实只有一个问题:

当“写代码”这件事真的交给 AI,职业工程师是如何保持控制的?

第一个结论:他们几乎不“放手”

如果你期待看到“工程师已经完全交给 AI”的画面,这篇论文可能会让你失望。

论文在 Results 部分关于“控制软件设计与实现”的分析中指出,工程师极少让 AI 智能体长时间自主执行任务。即便智能体给出了完整的多步计划,开发者通常也只允许其逐步执行,并在每一步之后检查代码变更、运行测试,再决定是否继续,从而始终将节奏与决策权掌握在人类手中。

研究中观察到的真实情况是:

- 工程师 很少让 AI 自己往下跑

- 即便有一个 50、70 步的完整计划,他们也通常只让 AI 一次执行 1–2 步

- 每一步执行完,都会停下来:看代码、对比 diff、运行测试、判断是否继续。

也就是说,AI 在干活,但节奏掌握在人手里。

在与智能体协作时,资深开发者通过在提示与规划中提供清晰的上下文和明确的指令,来掌控软件的设计与实现,并且一次只让智能体处理少量任务

除了提示工程之外,资深开发者还会借助既有的软件开发最佳实践(例如验证与版本控制),并结合自身的工程经验,在监督之下将智能体生成的改动纳入代码库。

研究者直接点破了“vibe coding”的误区:那种完全不看实现、只等结果的用法,在职业开发中几乎不存在。

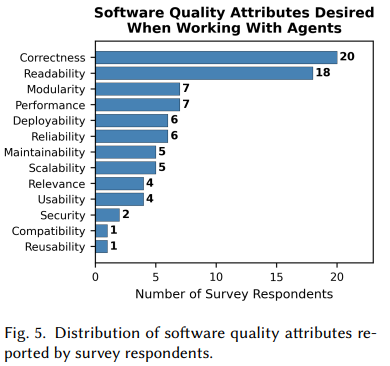

工程师在意的,从来不只是“快”

这项研究里一个非常反直觉的数据是:在问卷中,提到“软件质量”的工程师,比提到“效率提升”的还多。

论文在 Results 的 RQ1(使用动机)部分指出,在问卷调查中,有 67 位工程师在使用 AI agent 时首先关注软件质量属性,而只有 37 位提到效率提升等非质量因素,这与“agent 主要用于提效”的直觉认知形成反差。

他们反复提到的关键词包括:

- correctness(正确性)

- maintainability(可维护性)

- readability(可读性)

- architectural clarity(架构清晰)

换句话说,AI 能不能写得快,并不是第一位的。

能不能写得“对”,才是。

这也解释了为什么工程师会频繁打断 AI 的自动执行——因为一旦代码偏离预期,后续成本会指数级上升。

在职业工程里,“之后再改”从来不是一个轻松的选项。

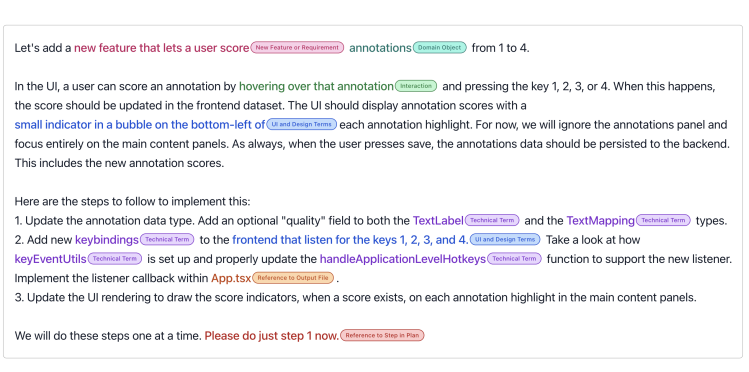

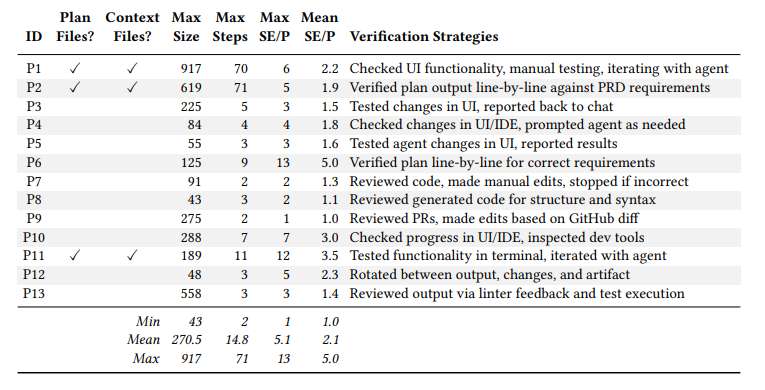

Prompt 不是聊天,是“规格说明”

此外,论文还揭露了一个关于开发者控制 agent 行为中被很多人低估的事实:

资深工程师写的 prompt,看起来一点也不“自然”。

prompt 样本示例

他们的 prompt 往往很长,包含大量上下文:

- 文件路径

- 接口定义

- 现有模块结构

- 明确的输入输出约束

- 清晰的边界说明

他们做这些的目的,并不是教AI怎么写代码,目的其实只有一个:把不确定性压到最低。

研究者给了一个很到位的总结:

Prompt engineering,本质上就是一种软件工程沟通能力。

这也意味着,AI 并没有消灭工程经验,而是把工程经验转移到了“如何描述问题”这一步。

AI 最擅长的,并不是“思考”

在对近 200 个真实开发任务的分析中,研究给出了一个非常清晰的任务适配的分界线。

适合交给 AI 的任务:

- 样板代码生成

- 明确规则下的实现

- 测试代码

- 小范围重构

- 已有方案的翻译与扩展

不适合交给 AI 的任务:

- 系统架构设计

- 复杂业务建模

- 跨模块决策

- 高风险变更

一句话总结就是:AI 擅长执行清楚的事情,不擅长判断复杂的事情。而后者,恰恰是职业工程师最核心的价值所在。

所谓“全自动写软件”,并不符合工程现实

这项研究可以说从实践工程的角度戳破了“AI全自动开发”的幻想。

在流行叙事中,AI Agent 往往被描述为“自主工程师”:能规划、能执行、能自我修正。

但在真实工程场景中,工程师更希望的是:可控的、可暂停的、可验证的、可随时推翻的 Agent。

换句话说,他们要的是“工具”,不是“替代者”。

其二,这篇论文还隐含了一个判断,其实非常值得注意:

AI 没有让工程师变得多余,而是迫使工程师回到更“负责”的位置。

未来更有价值的工程师,可能不再是:写代码最快的,API 最熟的。

变成了:能拆解问题的、能定义清晰规格的、能判断代码是否“值得合并”的。

最重要的是,能对系统结果负责的。

可以确定的是——AI 写得再多,责任也不会自动消失。

写在最后

“vibe coding”作为一种热炒的概念,很好传播;但这项论文研究表明:

作为一种工程方法,它并不成立。

所以,开发者们可以放心了。

真正的职业工程师,并没有把方向盘交给 AI,他们只是换了一种方式来控制代码的输出。“凭感觉”编程中的“感觉”,实际上更多是实际积累的“开发经验”。

这,或许才是 AI 编程真正进入工程世界的标志。

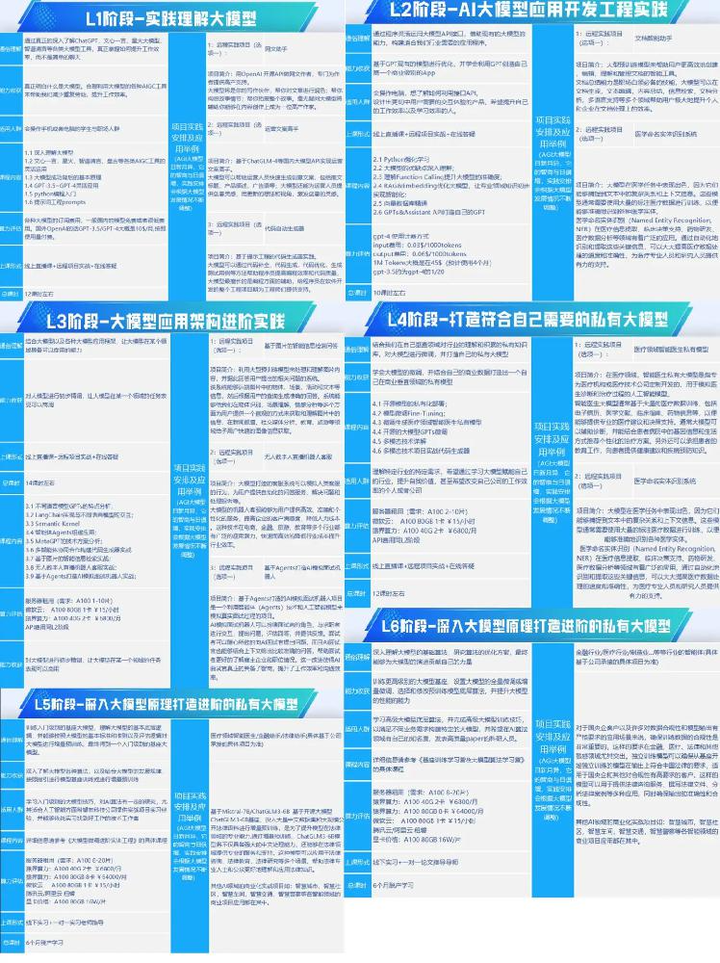

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献99条内容

已为社区贡献99条内容

所有评论(0)