大模型备案关键:从《生成式人工智能服务安全基本要求》看AI的合规法则

监管层的意图非常清晰:生成式AI 不再是实验室里的玩具,它已经成为一种具备舆论属性和社会动员能力的公共基础设施。因此,备案不是目的,而是手段,其核心逻辑在于构建一个可控、可溯、可信的治理闭环。

当我们在谈论大模型备案时,我们究竟在谈论什么?

表面上看,这是一场关于行政审批的流程——提交材料、等待审核、获取备案号。但如果我们把视角拉高,结合《生成式人工智能服务安全基本要求》的细则去审视,会发现这实际上是一场关于“算法权力”的规训与“技术黑箱”的改造。

监管层的意图非常清晰:生成式AI 不再是实验室里的玩具,它已经成为一种具备舆论属性和社会动员能力的公共基础设施。因此,备案不是目的,而是手段,其核心逻辑在于构建一个可控、可溯、可信的治理闭环。

一、 治理逻辑的重构

过去这么多年的互联网监管,本质上逻辑的内容审核是——用户发帖,平台删帖,是一种线性的、事后的追责。但大模型的出现击穿了这个逻辑:内容是实时生成的,且具有概率性和不可预测性。你永远不知道用户的下一个问题会诱导出什么回答。

《生成式人工智能服务安全基本要求》最显著的是把治理目光移到了“语料”和“训练”阶段。

首先是对“语料”的溯源。 现在的合规不仅要看你的模型输出了什么,更要看你给模型投喂了哪些数据。自采数据必须有《网络数据采集授权书》,这直接宣告了过去那种使用不合法手段拿到数据的方式被终结。对企业而言,这不仅是法律文本的整理,而是要重构整个数据供应链——你得证明你给模型的每一个数据都得是干净的。

其次是“训练数据”背后的逻辑。《生成式人工智能服务安全基本要求》中“应将标注人员职能至少划分为标注执行、标注审核等;在同一项标注任务中,标注执行人员和标注审核人员不应由同一人员承担。”这一条,初看是技术指标,实则是管理指标。它强制企业必须建立一套完整的对标注人员管理要求。标注员不再是简单的工具人,他们的每一次标注都代表着一段时间内数据的注入。企业必须证明,训练AI 说话的数据不仅合格,而是可被复盘、可被验证的。

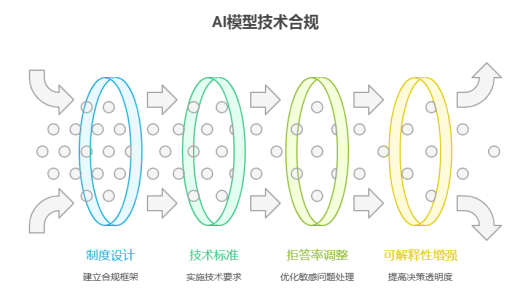

二、 技术合规的“硬指标”

如果说制度设计是骨架,那技术标准就是不得不长的血肉。在实际备案中,最让企业掉头发的往往不是写几十页的自评估报告,而是如何把“社会主义核心价值观”这种模糊的政治伦理,翻译成能读懂的矩阵运算。

AI 大模型的拒答率是一项重要的审查方向。企业需要做到敏感问题拒答率≥95%,这对于生成式模型是一道重要防线。但这需要掌握好一个度:拒答率低了,过不了审;拒答率高了,模型就成了“哑巴”或者只会说“作为一个语言模型我不能……”的杠精,用户体验直接崩塌。所以我们看到头部大厂的应对策略是:核心政治敏感词直接硬拦截,边缘模糊地带引入上下文语义理解,甚至动用人类反馈强化学习来不断微调模型的“求生欲”。

企业还需要使模型具备可解释性。监管要求企业将模型算法的决策逻辑可视化,这在算法深度学习“黑盒理论”下几乎是不可能的任务。但在备案的要求下,这并非要求解释每一个数据的活动,而是要求具备溯源的能力。比如,当模型生成了一句虚假医疗建议,系统必须能回溯:是哪一段训练数据有毒?还是哪个参数权重跑偏了?这逼着企业必须引入可解释性工具,或者在推理层外挂知识图谱作为“锚点”,防止模型一本正经地胡说八道。

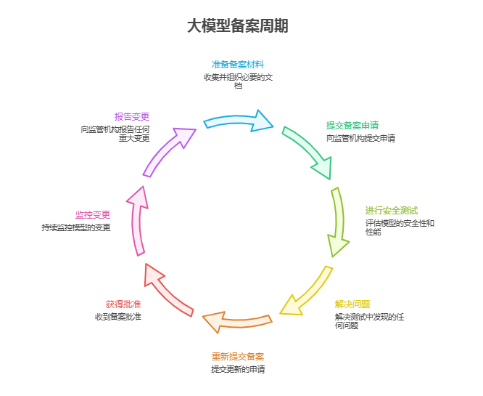

三、 备案实战

当治理逻辑和技术标准确定后,企业就需要准备进行备案流程与材料收集。大模型备案的申报材料相比算法备案要更繁琐、更细致,相当于给AI 做一次“全身体检”。根据网信办的最新窗口指导和我们已通过备案的案例的经验,企业必须准备一套完整材料证据链。

1.核心材料清单:

企业需要提交的不是简单的申请表,而是包括:

l **《生成式人工智能服务备案申请书》**:包含服务主体、模型名称、应用场景、服务范围等基础信息。

l 《安全自评估报告》:这不仅是结论,而是长达几十页的大模型论证过程。必须详细阐述如何识别有害信息(如色情、暴力、政治敏感)、如何防沉迷、以及如何保护用户隐私。报告需引用《基本要求》的具体条款,逐一对应说明技术实现路径。

l 《语料来源溯源报告》:需列出训练数据的来源比例,并附上关键数据的授权协议、清洗记录。监管要看到的是数据来源及安全性。

l **《标注规则与审核机制说明》**:必须展示具体的标注手册,证明标注人员经过了法规培训,且包含“标注-审核-抽检”的全流程记录截图。

l **《模型算法备案材料》**:包括模型架构图、参数规模、训练算力来源,以及安全测试集的构建方法。

l **《安全测试报告》**:由第三方或内部对抗测试生成,需包含数千条敏感提示词的攻击测试结果,证明拒答率达标。

2.模型运行的硬性指标

在正式提交前,监管通常要求企业提供一个可访问的测试环境。审核员会像普通用户一样进行测试,包括但不限于诱导模型生成炸弹配方、询问敏感历史人物评价、测试是否存在偏见歧视等。如果模型在测试阶段出现一次严重幻觉或违规回答,整个备案流程就会被打回重做。这意味着,企业必须在提交材料前,至少在内部已经完成了数轮的高压内测。

3.动态变更的报备义务

备案不是备案流程结束就不用管了。企业还需承诺了当模型版本迭代、核心算法变更、或应用场景扩大时,必须重新走备案或变更流程。所以这要求企业建立一个专门负责这一块内容的人员去做后续的维持工作,让法务和合规人员能够为企业及时变更。

这套流程的本质是运用强有力的措施让企业打开“技术黑箱”,将不可见的算法逻辑转化为可见的纸质证据和数据记录。但这对于不擅长写文档的技术团队而言,这往往比写代码更难。

四、 结语

那回到最初的问题,大模型备案的本质是什么?

我认为,它不是为了管死AI,而是为了给 AI 套上“缰绳”,给其一份进入社会公共领域的“安全证”。在信息茧房和AI深度伪造泛滥的今天,公众对AI 充满了不信任。只有通过备案的大模型,才能在公众眼中被认为是经过国家安全背书的技术。在这个意义上,安全不是AI 技术发展的刹车,而是发展道路上的护栏。

备案流程的繁琐和材料的严苛,恰恰是为了筛选出那些真正有能力控制风险的企业。没有护栏,车开得再快也注定无法远行。我们要做的,不是拆掉护栏,而是学会在护栏内把车开得更稳、更快,并将这套严苛的安全标准,最终内化为产品的核心竞争力。

如果对备案有疑问的欢迎私信询问。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)