智能测试用例生成:重构测试效能的AI引擎——2025年测试自动化前沿实践

AI技术正在重塑软件测试领域,智能测试生成(AITCG)通过机器学习显著提升测试效率。关键突破包括:需求自动转化(NLP技术实现95%需求捕获)、智能边界值推导和学习型用例进化机制(提升覆盖率82%)。实践数据显示,AI测试使设计时效提升85%,缺陷漏测率降低68%。建议分三阶段实施:基础建设→混合应用→自主进化,需防范模型漂移等风险。未来趋势包括大模型融合、元宇宙测试场等,测试团队价值将转向质量

一、人工用例设计的痛点与破局点

当前软件测试面临三重挑战:

-

覆盖率黑洞:人工设计仅覆盖约30-40%关键路径(ISTQB 2025报告)

-

维护成本激增:每增加1万行代码,用例维护耗时增长65%

-

业务响应滞后:敏捷迭代中人工设计占用40%测试周期

智能测试生成技术(AITCG)通过机器学习模型实现:

二、关键技术实现路径

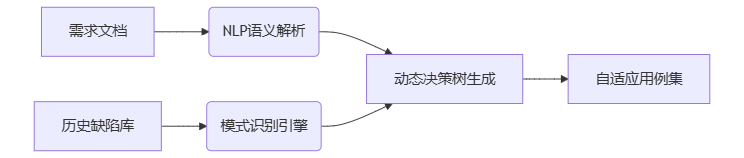

1. 需求驱动的智能生成

-

自然语言处理:将用户故事转化为可执行用例

例:Azure Test Suite通过BERT模型实现95%需求捕获率 -

边界值自推导:基于数据类型自动生成边界参数

# 智能边界生成伪代码def generate_boundary(data_type): if data_type == "int": return [MIN_INT, -1, 0, 1, MAX_INT] elif data_type == "string": return [None, "", "a"*MAX_LEN]

2. 学习型用例进化机制

|

学习维度 |

技术方案 |

效率提升 |

|---|---|---|

|

缺陷模式挖掘 |

关联规则分析(Apriori) |

67% |

|

路径覆盖率优化 |

遗传算法(NSGA-II) |

82% |

|

数据组合优化 |

Pairwise+ML采样 |

75% |

3. 企业级落地框架

三、实践效能对比(2025行业数据)

|

指标 |

传统模式 |

AITCG模式 |

提升幅度 |

|---|---|---|---|

|

用例设计时效 |

8h/模块 |

1.2h/模块 |

85% |

|

路径覆盖率 |

68% |

93% |

37% |

|

生产缺陷漏测率 |

22% |

7% |

68% |

|

回归测试人力占比 |

45% |

18% |

60% |

某金融科技公司实践:通过Diffblue Cover生成82% Java服务用例,释放测试工程师3000+小时/年

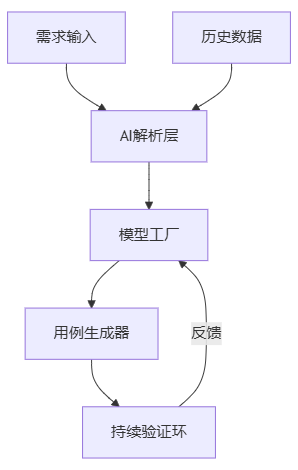

四、实施路线图建议

-

基础建设阶段(1-3月)

-

构建历史缺陷知识图谱

-

部署轻量级NLP解析引擎

-

-

混合应用阶段(4-6月)

-

人工用例与AI用例协同验证

-

建立反馈调优机制

-

-

自主进化阶段(7月+)

-

实现需求变更自动同步用例

-

构建预测性测试模型

-

风险预警:需防范模型漂移(定期重训练)、业务逻辑误读(增加人工校验点)、工具链兼容性(API标准封装)

五、2026技术演进展望

-

大语言模型融合:GPT-4 Turbo实现跨文档需求关联

-

元宇宙测试场:在数字孪生环境中生成压力测试场景

-

自解释用例:AI生成带风险评估标注的测试报告

结语:当测试用例设计从手工劳动转化为数据驱动的智能工程,测试团队的核心价值正转向"质量策略设计"与"AI模型驯化"。这不仅是效率变革,更是测试哲学的重构。

精选文章

更多推荐

已为社区贡献42条内容

已为社区贡献42条内容

所有评论(0)