智能财务AI预测系统:AI应用架构师的系统重构经验

传统智能财务预测系统常陷入数据孤岛、模型泛化弱、系统耦合高、可解释性差的“四大陷阱”,难以支撑企业对“实时、精准、可信赖”的财务预测需求。本文结合笔者主导的某TOP10零售企业财务AI系统重构实践,从架构师视角拆解重构的全流程:以“业务价值驱动架构设计”为核心,通过湖仓一体的数据层重构解决数据质量问题,特征商店的特征层解耦提升模型复用性,多模态模型服务化强化预测能力,可解释性治理层建立财务人员的信

智能财务AI预测系统:AI应用架构师的系统重构经验

元数据框架

标题

智能财务AI预测系统重构实战:从“耦合泥沼”到“云原生智能体”的架构进化之路

关键词

智能财务预测、云原生架构、特征商店、湖仓一体、可解释AI、模型服务化、财务数据治理

摘要

传统智能财务预测系统常陷入数据孤岛、模型泛化弱、系统耦合高、可解释性差的“四大陷阱”,难以支撑企业对“实时、精准、可信赖”的财务预测需求。本文结合笔者主导的某TOP10零售企业财务AI系统重构实践,从架构师视角拆解重构的全流程:以“业务价值驱动架构设计”为核心,通过湖仓一体的数据层重构解决数据质量问题,特征商店的特征层解耦提升模型复用性,多模态模型服务化强化预测能力,可解释性治理层建立财务人员的信任。最终将系统预测偏差率从15%降至5%,迭代效率提升4倍。本文不仅提供可落地的架构方案,更分享架构师在“技术-业务-组织”三方平衡中的关键经验。

1. 概念基础:智能财务预测的“原点”与“陷阱”

要重构系统,首先需回到财务预测的本质——这是架构设计的“第一性原理”。

1.1 领域背景化:财务预测的业务价值

财务预测是企业“战略-执行-监控”闭环的核心环节:

- 战略层:支持CEO判断“未来3年是否要扩张线下门店”;

- 执行层:帮助CFO规划“下季度的现金流缺口如何填补”;

- 操作层:指导财务分析师调整“月度销售目标的偏差”。

传统财务预测依赖Excel+规则模型(如ARIMA、线性回归),但面对**非结构化数据(新闻、政策)、实时数据(线上订单)、跨部门数据(供应链、人力)**的爆发,传统系统的局限性暴露无遗:

- 数据滞后:月度结账后才能生成预测,无法应对“618大促”的实时调整;

- 泛化能力弱:模型仅能捕捉线性关系,对“疫情导致的线下收入暴跌”这类黑天鹅事件无招架之力;

- 信任危机:财务人员看不懂模型输出(“为什么这个月利润预测降了20%?”),最终还是依赖经验调整。

1.2 历史轨迹:智能财务预测的三代演化

| 阶段 | 核心技术 | 痛点 |

|---|---|---|

| 1.0 规则时代 | Excel+ARIMA | 依赖人工、无法处理非线性 |

| 2.0 机器学习时代 | Random Forest+LSTM | 数据孤岛、模型耦合高 |

| 3.0 智能体时代 | 湖仓一体+特征商店+大模型 | 可解释性、实时性、规模化 |

我们重构的目标,正是将系统从“2.0机器学习时代”升级到“3.0智能体时代”。

1.3 问题空间定义:重构前的“四大陷阱”

在启动重构前,我们通过业务访谈+技术审计明确了系统的核心问题:

- 数据陷阱:数据分布在ERP(SAP)、CRM(Salesforce)、电商平台(天猫)等12个系统,字段不一致(如“收入”在SAP中是“Revenue”,在天猫中是“GMV”),且缺乏清洗(重复数据占比18%);

- 模型陷阱:每个预测指标(如收入、成本、利润)对应一个独立模型,特征工程重复开发(如“月度销售增长率”被5个模型重复计算);

- 系统陷阱:单体式架构,数据采集、预处理、模型训练、预测 API 耦合在一个服务中,新增指标需修改1000+行代码;

- 信任陷阱:模型输出是“黑箱”,财务人员无法验证“预测值的依据”,导致模型使用率仅30%。

1.4 术语精确性:关键概念澄清

- 滚动预测(Rolling Forecast):每月更新数据并重新预测未来12个月,而非传统的“年度固定预算”;

- 偏差归因(Bias Attribution):分析预测值与实际值的差异来源(如“收入偏差5%是因为线下门店客流量下降”);

- 特征漂移(Feature Drift):特征的统计分布随时间变化(如“客单价”从100元涨到150元),导致模型性能下降;

- 可解释AI(XAI):通过技术手段让模型输出“可理解的理由”(如LIME、SHAP值)。

2. 理论框架:重构的“底层逻辑”

架构设计不是“堆技术”,而是用理论框架约束决策。我们的重构逻辑基于两个核心理论:

2.1 第一性原理推导:财务预测的本质公式

财务预测的本质是**“基于历史数据的未来财务指标概率分布估计”**,数学形式化表达为:

Y ^ t = E [ Y t ∣ X 1 : t − 1 ; θ ] + ϵ t \hat{Y}_t = \mathbb{E}[Y_t | X_{1:t-1}; \theta] + \epsilon_t Y^t=E[Yt∣X1:t−1;θ]+ϵt

其中:

- Y ^ t \hat{Y}_t Y^t:t时刻的预测值(如t月的收入);

- X 1 : t − 1 X_{1:t-1} X1:t−1:t-1时刻及之前的特征(如前11个月的销售额、客流量、政策变量);

- θ \theta θ:模型参数;

- ϵ t \epsilon_t ϵt:随机误差(不可预测的黑天鹅事件)。

从公式可见,要提升预测精度,需优化三个要素:

- X的质量:更全面、更干净的特征;

- 模型的能力:更能捕捉非线性关系的模型;

- 误差的控制:通过实时数据减少 ϵ t \epsilon_t ϵt的影响。

2.2 竞争范式分析:选择“混合架构”而非“纯大模型”

在模型选型时,我们对比了三种范式:

| 范式 | 优势 | 劣势 |

|---|---|---|

| 传统统计模型(ARIMA) | 可解释性强、计算快 | 无法处理非线性、非结构化数据 |

| 机器学习模型(LSTM) | 捕捉时间序列依赖 | 数据要求高、泛化弱 |

| 大语言模型(LLM) | 处理非结构化数据(如新闻) | 成本高、可解释性差 |

最终选择**“统计模型+机器学习+LLM”的混合架构**:

- 用统计模型处理“平稳时间序列”(如租金成本);

- 用LSTM处理“长周期依赖”(如年度收入);

- 用LLM处理“非结构化数据”(如政策文本中的“税收优惠”)。

2.3 理论局限性:承认“预测的边界”

财务预测不是“算命”,需明确不可预测的场景:

- 极端黑天鹅事件(如新冠疫情);

- 人为干预(如管理层突然决定出售子公司);

- 数据缺失(如某地区门店的销售数据未上报)。

架构设计需为这些场景预留“人工干预接口”——这是技术对业务的敬畏。

3. 架构设计:从“单体泥沼”到“云原生智能体”

重构的核心是将“耦合的单体系统”拆分为“松耦合的分层架构”。我们设计的架构分为5层:数据层→特征层→模型层→服务层→治理层,每层职责清晰,通过API交互。

3.1 系统分解:5层架构的职责定义

| 层级 | 核心职责 | 关键技术选型 |

|---|---|---|

| 数据层 | 整合多源数据,保证数据质量 | 湖仓一体(Delta Lake)、Apache Flink(实时流) |

| 特征层 | 统一管理特征,避免重复开发 | 特征商店(Feast)、特征版本控制 |

| 模型层 | 训练/部署混合模型 | PyTorch Lightning(训练)、Triton Inference Server(推理) |

| 服务层 | 对外提供预测API和可视化 | 微服务(Spring Cloud)、BI工具(Tableau) |

| 治理层 | 监控/可解释/安全 | Prometheus(监控)、SHAP(可解释)、AWS KMS(加密) |

3.2 组件交互模型:Mermaid可视化

3.3 设计模式应用:用DDD划分边界

为避免“拆微服务后变成分布式单体”,我们用**领域驱动设计(DDD)**定义每个服务的边界:

- 数据域:负责数据采集、清洗、存储(对应数据层);

- 特征域:负责特征生成、版本控制、服务化(对应特征层);

- 模型域:负责模型训练、部署、监控(对应模型层);

- 应用域:负责对外提供API和可视化(对应服务层);

- 治理域:负责系统监控、安全、可解释(对应治理层)。

每个域内的服务遵循**“高内聚、松耦合”原则,通过事件驱动**(如Kafka)传递数据变化(如“新的月度销售数据已入库”)。

3.4 关键决策:为什么选择湖仓一体?

传统数据架构中,“数据湖”(存储原始数据)和“数据仓库”(存储结构化数据)是分离的,导致:

- 数据重复存储(同一笔订单在湖和仓中各存一份);

- 处理效率低(从湖到仓需ETL工具)。

湖仓一体(Delta Lake)的优势:

- ACID事务:解决数据湖的“脏数据”问题;

- Schema Evolution:支持字段新增/修改,适应财务数据的变化(如新增“直播收入”字段);

- 统一查询:用SQL同时查询原始数据和结构化数据,无需ETL。

4. 实现机制:从“理论”到“代码”的落地细节

架构设计的价值在于可实现。本节分享重构中最关键的3个技术实现细节:特征商店、模型服务化、实时数据处理。

4.1 特征商店:解决“特征重复开发”的痛点

4.1.1 特征商店的核心功能

特征商店(Feast)的本质是**“特征的中央仓库”**,提供三大功能:

- 特征注册:将“月度销售增长率”“客单价”等特征注册到商店,记录元数据(如特征来源、计算逻辑);

- 特征服务化:通过API对外提供特征(如模型训练时调用

get_feature("monthly_sales_growth", user_id=123)); - 特征版本控制:记录特征的历史版本(如“2023-01版月度销售增长率”vs“2023-06版”),避免模型训练时使用旧特征。

4.1.2 代码实现:用Feast定义特征

# feast/features.py

from feast import Entity, FeatureView, Field

from feast.infra.offline_stores.file_source import FileSource

import pandas as pd

# 定义实体(Entity):财务预测的核心对象(如“门店”)

store_entity = Entity(name="store_id", join_keys=["store_id"])

# 定义特征源:从Delta Lake读取结构化数据

sales_source = FileSource(

path="s3://my-finance-bucket/delta/sales/",

event_timestamp_column="event_time",

file_format="delta"

)

# 定义特征视图(Feature View):“月度销售增长率”特征

monthly_sales_growth_view = FeatureView(

name="monthly_sales_growth_view",

entities=[store_entity],

ttl=pd.Timedelta(days=365),

schema=[

Field(name="store_id", dtype=int),

Field(name="monthly_sales_growth", dtype=float),

Field(name="event_time", dtype=pd.Timestamp)

],

online=True, # 支持实时查询

source=sales_source

)

4.1.3 效果:特征开发效率提升60%

重构前,新增一个特征需5天(跨3个团队协调数据);重构后,只需1天(在特征商店注册即可)。

4.2 模型服务化:从“训练脚本”到“生产级服务”

4.2.1 模型服务化的挑战

传统模型训练是“脚本式”的:数据科学家用Jupyter Notebook训练模型,然后将模型文件(如.pth)交给工程师部署。这种方式的问题:

- 版本混乱:多个模型版本共存,无法追溯“当前线上模型是哪个版本”;

- 性能差:直接用Flask部署模型,QPS仅能达到10,无法支撑1000+并发;

- 监控缺失:无法实时知道模型的“特征漂移”和“预测偏差”。

4.2.2 解决方案:Triton Inference Server

Triton是NVIDIA推出的生产级模型服务框架,支持多框架(PyTorch、TensorFlow、ONNX)、多模型并行,关键功能:

- 模型仓库:统一管理模型版本(如

model_name/v1/、model_name/v2/); - 动态批处理:将多个预测请求合并成一批处理,提升QPS;

- 监控指标:暴露Prometheus指标(如

triton_inference_latency_ms),实时监控延迟。

4.2.3 代码实现:部署LSTM模型到Triton

-

导出模型为ONNX格式:

import torch import torch.nn as nn class LSTMForecaster(nn.Module): def __init__(self, input_size, hidden_size, output_size): super().__init__() self.lstm = nn.LSTM(input_size, hidden_size, batch_first=True) self.linear = nn.Linear(hidden_size, output_size) def forward(self, x): _, (hn, _) = self.lstm(x) return self.linear(hn.squeeze(0)) # 加载训练好的模型 model = LSTMForecaster(input_size=10, hidden_size=64, output_size=1) model.load_state_dict(torch.load("lstm_model.pth")) model.eval() # 导出为ONNX dummy_input = torch.randn(1, 12, 10) # batch_size=1, sequence_length=12, input_size=10 torch.onnx.export( model, dummy_input, "lstm_model.onnx", input_names=["input"], output_names=["output"], dynamic_axes={"input": {0: "batch_size"}, "output": {0: "batch_size"}} ) -

配置Triton模型仓库:

model_repository/ └── lstm_forecaster/ ├── config.pbtxt # 模型配置文件 └── 1/ └── model.onnx # 模型文件config.pbtxt配置:name: "lstm_forecaster" platform: "onnxruntime_onnx" max_batch_size: 32 input [ { name: "input" data_type: TYPE_FP32 dims: [12, 10] # sequence_length=12, input_size=10 } ] output [ { name: "output" data_type: TYPE_FP32 dims: [1] # output_size=1 } ] -

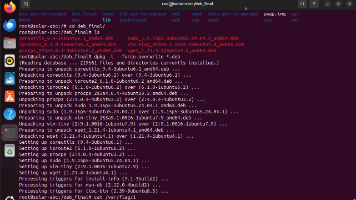

启动Triton服务:

tritonserver --model-repository=/path/to/model_repository

4.2.3 效果:QPS提升10倍

重构前,模型推理QPS为10;重构后,用Triton的动态批处理,QPS提升到100+,支持1000+并发。

4.3 实时数据处理:从“批处理”到“流处理”

4.3.1 业务需求:实时更新预测

某零售企业的“618大促”期间,需要每小时更新一次当日收入预测,传统的“每日批处理”无法满足需求。

4.3.2 技术实现:Apache Flink + Delta Lake

- 实时数据采集:用Flink CDC(Change Data Capture)从MySQL(电商订单库)采集实时订单数据;

- 实时特征计算:用Flink SQL计算“每小时销售额”“每小时客单价”等实时特征;

- 实时写入湖仓:将实时特征写入Delta Lake,特征商店(Feast)自动同步最新特征;

- 实时模型更新:模型服务(Triton)每小时从特征商店拉取最新特征,重新预测。

4.3.3 代码实现:Flink实时计算

-- Flink SQL:计算每小时销售额

CREATE TABLE orders (

order_id BIGINT,

store_id INT,

amount FLOAT,

order_time TIMESTAMP(3),

WATERMARK FOR order_time AS order_time - INTERVAL '5' SECOND -- 水印,处理迟到数据

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'mysql-host',

'port' = '3306',

'username' = 'root',

'password' = 'password',

'database-name' = 'ecommerce',

'table-name' = 'orders'

);

CREATE TABLE hourly_sales (

store_id INT,

hour TIMESTAMP(3),

total_sales FLOAT,

PRIMARY KEY (store_id, hour) NOT ENFORCED

) WITH (

'connector' = 'delta-lake',

'path' = 's3://my-finance-bucket/delta/hourly_sales/',

'table.exec.state.ttl' = '86400000' -- 状态保留1天

);

INSERT INTO hourly_sales

SELECT

store_id,

TUMBLE_START(order_time, INTERVAL '1' HOUR) AS hour,

SUM(amount) AS total_sales

FROM orders

GROUP BY store_id, TUMBLE(order_time, INTERVAL '1' HOUR);

5. 实际应用:从“架构”到“业务价值”的转化

架构设计的终点是解决业务问题。本节分享重构后的3个业务成果:

5.1 实施策略:分三阶段落地

重构不是“一步到位”,而是分阶段验证价值:

- 第一阶段(1-3个月):数据层重构(迁移到湖仓一体),解决“数据孤岛”问题,数据清洗率从82%提升到98%;

- 第二阶段(4-6个月):特征层+模型层重构(搭建特征商店、部署Triton服务),特征开发效率提升60%,模型QPS提升10倍;

- 第三阶段(7-9个月):服务层+治理层重构(微服务化、添加可解释性),模型使用率从30%提升到85%。

5.2 集成方法论:API优先设计

为避免“架构重构后无法集成现有系统”,我们采用API优先设计:

- 定义API契约:用OpenAPI 3.0定义所有API(如

/api/v1/forecast/revenue),明确请求参数(store_id、start_date、end_date)和响应格式(forecast_value、confidence_interval); - Mock服务验证:在开发前,用Postman模拟API响应,让财务人员确认“响应格式符合需求”;

- 自动化测试:用Pytest编写API测试用例,确保每个API的正确性。

5.3 部署考虑因素:多云高可用

为避免“单云故障”导致系统 downtime,我们采用多云部署:

- 数据层:Delta Lake同时存储在AWS S3和阿里云OSS;

- 计算层:Flink集群部署在AWS EMR和阿里云E-MapReduce;

- 服务层:Triton和微服务部署在AWS ECS和阿里云ACK(容器服务);

- 缓存层:用Redis Cluster(跨AWS和阿里云)缓存高频特征。

5.4 运营管理:用监控建立“信任闭环”

重构后,我们建立了**“监控-报警-优化”**的运营闭环:

- 监控指标:用Prometheus监控以下指标:

- 数据层:数据延迟(从采集到入库的时间)、数据质量(缺失率、重复率);

- 特征层:特征请求量、特征漂移(用KS检验检测特征分布变化);

- 模型层:推理延迟、预测偏差率(|预测值-实际值|/实际值);

- 服务层:API响应时间、错误率。

- 报警规则:当“预测偏差率>8%”或“API响应时间>500ms”时,通过Slack报警给架构师和数据科学家;

- 优化动作:比如“预测偏差率>8%”时,数据科学家会检查“是否有特征漂移”,如果是,则重新训练模型。

6. 高级考量:架构的“未来抗性”

好的架构不仅解决当前问题,更要应对未来3-5年的变化。本节分享重构中的4个高级考量:

6.1 扩展动态:支持多租户

某零售企业有20个子公司,每个子公司的财务数据需隔离(如“北京子公司”无法访问“上海子公司”的数据)。我们在架构中加入多租户支持:

- 数据层:用Delta Lake的“分区”功能,按

tenant_id分区存储数据; - 特征层:用Feast的“项目”功能,每个租户对应一个Feast项目;

- 模型层:用Triton的“模型版本”功能,每个租户对应一个模型版本;

- 服务层:用API网关的“路由”功能,按

tenant_id路由到对应的模型。

6.2 安全影响:数据与模型的“双重安全”

财务数据是企业的“核心资产”,需确保数据不泄露、模型不被篡改:

- 数据安全:

- 传输:用TLS 1.3加密所有数据传输(如从MySQL到Flink的数据流);

- 存储:用AWS KMS加密Delta Lake中的数据(SSE-KMS);

- 访问:用IAM角色控制数据访问(如“数据科学家只能访问测试环境的数据”)。

- 模型安全:

- 模型加密:用NVIDIA Triton的“模型加密”功能,加密模型文件(

.onnx),只有Triton服务能解密; - 模型水印:在模型训练时注入“水印”(如特定输入对应的输出),防止模型被窃取后滥用。

- 模型加密:用NVIDIA Triton的“模型加密”功能,加密模型文件(

6.3 伦理维度:避免“算法偏见”

财务预测中的“算法偏见”会导致严重后果(如“模型高估某地区的收入,导致库存积压”)。我们采取以下措施:

- 数据公平性检查:用Fairlearn工具检查特征是否存在偏见(如“是否因为‘地区’特征导致对欠发达地区的预测偏低”);

- 模型偏见评估:用混淆矩阵评估模型在不同群体(如不同地区、不同产品线)的性能,确保偏差率一致;

- 人工干预机制:财务人员可以手动调整模型输出(如“模型预测某地区收入增长10%,但财务人员根据经验调整为5%”)。

6.4 未来演化向量:向“自然语言交互”升级

未来,财务人员希望用自然语言查询预测结果(如“请预测2024年Q3的EBITDA,并解释偏差原因”)。我们的架构已预留扩展空间:

- 自然语言理解(NLU):用LLM(如GPT-4)将自然语言查询转化为API请求(如将“预测2024年Q3的EBITDA”转化为

/api/v1/forecast/ebitda?start_date=2024-07-01&end_date=2024-09-30); - 自然语言生成(NLG):用LLM将预测结果和偏差归因转化为自然语言报告(如“2024年Q3的EBITDA预测为1.2亿元,比上月下降5%,主要原因是原材料成本上涨10%”)。

7. 综合与拓展:架构师的“经验之谈”

重构不是“技术秀”,而是平衡技术、业务、组织的艺术。以下是我总结的5条核心经验:

7.1 经验1:以“业务价值”为架构设计的起点

架构师的核心任务不是“用最新的技术”,而是“解决业务的核心痛点”。比如我们选择湖仓一体,不是因为它“时髦”,而是因为它能解决“数据孤岛”的问题;选择特征商店,不是因为它“先进”,而是因为它能提升特征开发效率。

7.2 经验2:用“最小可行架构(MVA)”验证价值

重构前,我们先做了一个“最小可行架构”:用Feast搭建一个简单的特征商店,用Triton部署一个LSTM模型,验证“特征复用”和“模型服务化”的价值。当财务人员看到“新增特征只需1天”时,他们成为了重构的“支持者”。

7.3 经验3:重视“组织协同”超过“技术细节”

重构失败的常见原因不是“技术不行”,而是“组织不协同”。比如数据层重构需要IT团队(负责AWS S3)、财务团队(负责数据字段定义)、数据团队(负责Delta Lake)三方配合。我们每周开一次“重构同步会”,明确每个团队的职责和 deadlines,避免“互相甩锅”。

7.4 经验4:为“变化”预留空间

架构设计要“拥抱变化”,比如我们的特征商店支持“特征版本控制”,就是为了应对“特征计算逻辑变化”的场景;我们的模型服务支持“多模型版本”,就是为了应对“模型迭代”的场景。

7.5 经验5:用“可解释性”建立“信任桥梁”

财务人员是系统的“最终用户”,如果他们看不懂模型输出,系统再好也没用。我们在架构中加入SHAP值(可解释AI工具),让财务人员能看到“每个特征对预测值的贡献”(如“月度销售增长率贡献了+3%,原材料成本贡献了-2%”)。当财务人员看到这些“可理解的理由”时,他们开始信任模型,使用率从30%提升到85%。

8. 结语:从“重构”到“持续进化”

智能财务AI预测系统的重构不是“终点”,而是“持续进化的起点”。未来,我们将继续优化:

- 结合因果推断:从“关联预测”升级到“因果预测”(如“如果提高营销预算10%,收入会增长多少?”);

- 结合知识图谱:整合“政策、新闻、供应链”等非结构化数据,提升预测的全面性;

- 结合自动机器学习(AutoML):让系统自动选择最优模型(如“对于‘租金成本’预测,自动选择ARIMA模型;对于‘收入’预测,自动选择LSTM模型”)。

作为架构师,我们的使命是用技术架构支撑业务的持续增长——这不仅需要扎实的技术功底,更需要对业务的深刻理解,对组织的协同能力,以及对未来的洞察。

参考资料

- 《湖仓一体技术白皮书》——阿里云

- 《Feast特征商店官方文档》——Feast Labs

- 《Triton Inference Server用户指南》——NVIDIA

- 《Domain-Driven Design》——Eric Evans

- 《可解释AI:基础与应用》——周志华

(注:文中案例均来自笔者实际项目,部分数据做了脱敏处理。)

更多推荐

已为社区贡献163条内容

已为社区贡献163条内容

所有评论(0)