LLM - 生产级 AI Agent 设计手册:从感知、记忆到决策执行的全链路架构解析

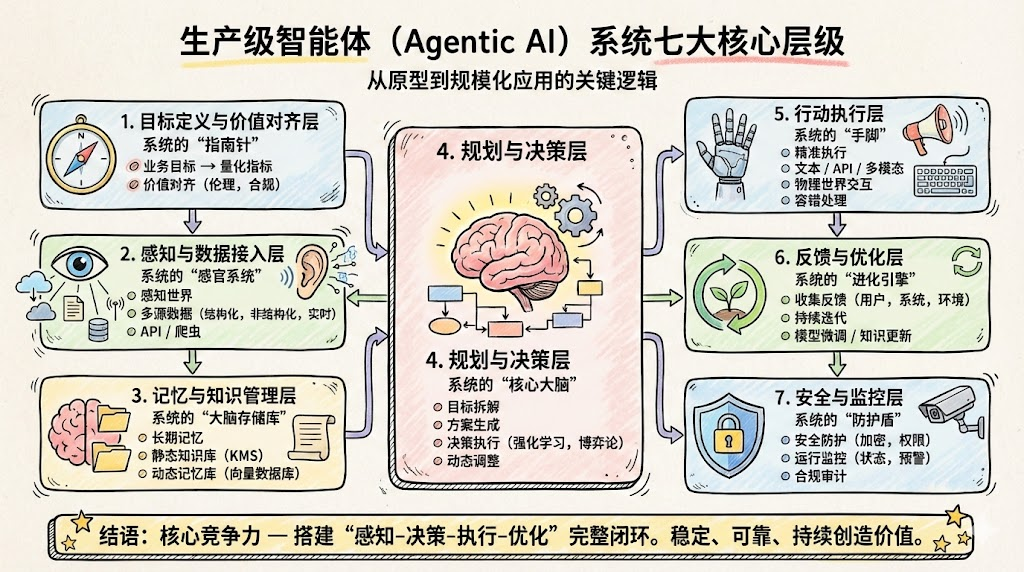

本文提出构建生产级智能体AI系统的7层架构方法论,旨在解决企业场景下智能体系统可控、可观测、可演进的需求。7个核心层级包括:目标与价值对齐层(定义业务目标与约束)、感知与数据接入层(多源数据统一接入)、记忆与知识管理层(长期知识与短期记忆管理)、规划与决策层(任务分解与策略编排)、行动执行层(工具调用与系统集成)、反馈与优化层(多维度反馈采集与持续优化)、安全与监控层(风险控制与合规审计)。文章详

文章目录

概述

构建生产级智能体 AI 系统,可以围绕“7 大核心层级”建立一套从需求分析、分层架构到落地实践与运维治理的完整方法论,帮助架构师和技术负责人把 Agent 从概念 Demo 推向可持续运营的企业级系统。 接下来我们将聚焦原理解析、架构设计与实践经验,总结可复用的最佳实践清单。

一、为什么需要“分层”的生产级智能体系统

面向企业真实业务场景,智能体系统必须满足三个基本要求:可控、可观测、可演进。 单纯堆叠大模型能力往往难以满足这些要求,因此需要通过分层架构,将“感知–记忆–决策–执行–反馈–安全”等能力进行解耦与工程化封装。

典型问题包括:

- Demo 阶段可用,但一旦增加场景和流量,系统耦合度高、难以维护。

- 缺乏统一的决策与策略层,导致行为不可预测,难以通过风控与合规审核。

- 没有闭环反馈与监控,无法持续优化模型与业务指标。

因此,需要一个清晰的分层框架,让系统既能体现 Agent 的“自主性与闭环”,又能在企业环境中被治理和审计。

二、7 大核心层级总览

综合行业实践,可以把生产级智能体系统抽象为 7 个核心层级,它们形成一个“目标驱动的感知–决策–执行–反馈闭环”。

| 层级 | 核心职责 | 关键问题 |

|---|---|---|

| 1. 目标与价值对齐层 | 定义业务目标、约束和价值观 | Agent 在追求什么、不允许做什么 |

| 2. 感知与数据接入层 | 统一接入多源数据和事件 | Agent 如何“看见”环境 |

| 3. 记忆与知识管理层 | 管理长期知识和短期记忆 | Agent 如何“不忘记”和“查资料” |

| 4. 规划与决策层 | 任务分解、策略搜索和模型编排 | Agent 如何制定计划与选择路径 |

| 5. 行动执行层 | 调用工具、外部系统与工作流 | Agent 如何在系统中“真正做事” |

| 6. 反馈与优化层 | 收集反馈、评估效果、驱动迭代 | Agent 如何从经验中“变聪明” |

| 7. 安全与监控层 | 监控、审计、权限和风险控制 | Agent 如何被“看住”和“兜底” |

这个 7 层框架与业界常提的“感知–决策–执行–反馈”闭环一致,只是进一步拉平和细化,以便架构设计和团队协作。

三、层级一:目标与价值对齐层

3.1 目标层级化与需求分析

企业级 Agent 不是“能聊”,而是“围绕目标完成任务”。目标通常是分层的:业务级目标(如降低客服成本)、过程级目标(如提高一次解决率)、技术指标(如响应时延)。

实践建议:

- 对目标做层级化建模:区分业务 KPI(如转化率)、体验指标(如满意度)、技术 SLO(如 P95 延迟)。

- 把目标固化为配置和策略,而不是写死在 Prompt 里,这样可以在无代码或低代码界面中调整。

- 在需求分析阶段,用“目标–约束–场景–主体”的方式建模 Agent 行为空间,避免为 AI 而 AI。

3.2 价值约束与对齐机制

没有约束的 Agent 容易产生“聪明但危险”的行为,在金融、医疗等高敏感领域尤其突出。

经验总结:

- 在架构层显式引入 Policy / Guardrail 层,对输入和输出都做策略控制,包括敏感词过滤、隐私数据脱敏、权限检查等。

- 将“不可做的行为”(如越权指令、违规内容)定义为独立规则集,可由合规团队维护,避免开发团队单点背锅。

- 对关键操作强制“人工在环”(Human-in-the-loop),如金额超过阈值必须人工确认,避免“自动化失控”。

四、层级二:感知与数据接入层

4.1 多源异构数据接入

智能体需要从各类系统、日志和用户交互中获得“感知”。这些数据往往是异构的:数据库记录、API、事件流、多模态内容等。

实践要点:

- 采用统一接入层或 API 网关,对外暴露统一数据接口,对内调用各业务系统,隐藏接口差异与认证细节。

- 使用事件总线(Kafka、消息队列)承载异步感知数据,例如用户行为事件、设备状态更新等,防止同步耦合。

- 对多模态数据(语音、图片、文档)进行预处理,标准化为结构化描述,供上层决策使用。

4.2 可观测性从接入开始

很多团队把监控只做在“业务服务层”,而忽略了 Agent 的感知质量,导致决策层在“盲人摸象”。

经验总结:

- 为每类感知数据定义质量指标(完整度、延迟、错误率),一旦重要数据源异常,要能阻止 Agent 做出关键决策。

- 在接入层打日志和 TraceId,方便追踪某次决策分别依赖了哪些外部数据源。

五、层级三:记忆与知识管理层

5.1 长期知识:RAG 与知识治理

长期知识提供“常识和规则”,是 Agent 回答专业问题与遵守流程的基础。

实践经验:

- 使用 RAG(检索增强生成)架构,将文档切片并向量化,支持语义检索而不是仅靠关键字匹配。

- 做好版本与来源治理:每条知识条目需记录来源系统、生效时间、版本号,便于追责和回溯。

- 对更新频繁的业务规则,考虑结构化存储与规则引擎,而不是写在大文档里,再交给 RAG 检索。

5.2 短期记忆:会话状态与工作记忆

短期记忆是来回对话中的“上下文”和任务执行过程中的“中间结果”。

常见实践:

- 将会话历史拆分为“窗口记忆”和“长期记忆”两类,窗口记忆直接参与 Prompt 构造,长期记忆则通过向量检索按需加载。

- 控制上下文长度:在保证语义完整的前提下,压缩冗余信息,避免 Token 成本爆炸,同时降低“幻觉风险”。

- 对关键步骤和决策摘要结构化记录,避免完全依赖纯文本对话回放。

六、层级四:规划与决策层

6.1 ReAct / ToT 等规划范式

现代 Agent 的核心差异在于“自主规划与决策”,而不仅是一次性问题回答。业界常见范式包括 ReAct(推理 + 行动)、Tree-of-Thought(树状思维)、多 Agent 协作等。

实践建议:

- 将“规划逻辑”模块化,不同任务类型可以采用不同策略:简单问答用单步推理,复杂工作流用多步规划或树搜索。

- 通过 Prompt 和“函数调用 / 工具调用”机制,让 LLM 能够显式地输出“下一步要调用的工具及其参数”,实现可解释的决策过程。

- 重要环境下慎用完全黑盒的自迭代 Agent,引入最大步数、最大成本、失败回退策略等硬约束。

6.2 决策与策略的工程化抽象

从架构视角,可以把决策层视为“策略引擎 + 调度器”:

- 策略引擎:结合业务目标、约束与历史反馈,决定采用哪种规划模式、调用哪些工具。

- 调度器:负责执行任务图(DAG)或多步链路,管理依赖关系与失败重试。

实践经验:

- 在决策层输出“结构化计划”(如 JSON Task Graph),而不是直接输出自然语言,让执行层更易于理解和监控。

- 对所有决策请求记录输入、计划、实际执行路径和结果,成为后续策略优化与审计的基础数据。

七、层级五:行动执行层

7.1 工具调用与系统集成

企业级 Agent 真正的价值不在于聊天,而在于调用工具,实际改变业务状态(如创建工单、修改订单、触发审批)。

实践要点:

- 为所有可调用的外部系统封装标准化“工具接口”,含名称、参数定义、权限要求和返回格式。

- 将“工具调用”视为一个可观测的行为,记录每次调用的输入、输出以及与用户表述之间的对应关系,方便排查问题。

- 工具层应具备幂等性和重试机制,避免决策层重复触发导致业务异常。

7.2 人机协同与人工兜底

自动执行并不意味着“完全自动化”。在多数企业场景中,需要设计好人机协同边界:

- 高风险操作(如资金划转、权限变更)默认走“建议 + 人工确认”模式,Agent 只给出方案和理由。

- 为复杂场景设计“升级路径”:当 Agent 判断不确定性过高或多次尝试失败时,自动升级到人工坐席,同时将上下文和尝试记录一并提供。

- 在前台 UI 中明确标记“由 Agent 处理”“由人工处理”,降低错位期待带来的体验问题。

八、层级六:反馈与优化层

8.1 多维反馈采集

要让 Agent 不断变好,必须系统性采集多源反馈:

- 用户侧:满意度打分、纠错按钮、备注说明。

- 系统侧:成功率、失败类型、时延、工具调用次数、成本。

- 业务侧:转化率、留存率等真正关心的业务指标。

实践经验:

- 不要只看“模型指标”(如 BLEU、ROUGE),更要关注业务闭环,如工单一次解决率、人工接入率等。

- 将反馈数据分层入库:一部分用于实时监控,一部分进入数据仓库供离线分析和模型训练。

8.2 建立可持续的优化闭环

优化闭环通常包括三个层面:

- Prompt 与策略调整:先从最便宜、最可控的地方下手,如优化提示词、调整决策规则、改变工具调用顺序。

- 知识与流程优化:根据纠错与业务反馈,修订知识库、优化业务流程,减少“制度层面的坑”。

- 模型与架构升级:当积累到足够的数据和业务需求时,再考虑模型微调、框架重构等重型操作。[

实践建议:为“Agent 运营”设立专门角色或小组,负责分析日志与反馈,并驱动上述三个层面的改进,而不是把所有问题砸给算法或平台团队。

九、层级七:安全与监控层

9.1 风险识别与安全架构

Agent 引入了新的风险维度,包括提示攻击、数据泄露、越权操作、恶意工具调用等。

经验清单:

- 从设计阶段就引入“威胁建模”,识别针对 Agent 的攻击面,如诱导泄露隐私、越权指令、绕过审核等。

- 对模型输入输出做安全检查:输入侧过滤敏感内容和注入攻击,输出侧做合规与敏感内容检测。

- 对工具调用引入权限和风控策略,如单次额度限制、频率限制、黑白名单等。

9.2 可观测性与合规审计

生产级系统必须能回答两个问题:“发生了什么?”以及“谁让它发生的?”。

实践经验:

- 建立统一的日志与追踪体系,为每次会话与决策生成 TraceId,绑定用户、场景和结果。

- 将关键操作写入审计日志,包含输入、决策要点、工具调用详情与最终结果,以便后期审查和合规检查。

- 结合监控告警系统,在出现异常行为(如失败率剧增、成本飙升、某类工具被异常频繁调用)时自动告警甚至触发熔断。

十、架构师 / 技术负责人视角的实践建议

综合各层级的经验,对架构师和技术负责人的关键建议包括:

- 从业务目标和场景出发,避免“先上大模型再找场景”的反模式。

- 用分层架构管理复杂度,确保每一层都有清晰的职责边界和可替换性。

- 优先打通“感知–决策–执行–反馈”最小闭环,再逐步完善记忆、多模态和多 Agent 协作能力。

- 及早建设安全、监控与审计能力,避免系统上线后才被合规和风控“打回重做”。

- 把 Agent 视为“长期运营对象”而非“一次性项目”,为持续优化预留组织和技术空间。

在这样的 7 层框架下,生产级智能体 AI 系统不再是单点 Demo,而是可以在企业内长期稳定运行、可控可进化的基础设施。

扩展阅读

-

智能体是什么?从定义到落地,一篇读懂 AI 自主决策系统的核心逻辑

https://cloud.tencent.com/developer/article/2581899 -

AI Agent 完整设计指南(全维度、可落地、含架构 / 模块 / 流程 / 避坑)

https://segmentfault.com/a/1190000047509776 -

企业级 Agent 架构设计(AWS 官方博客)

https://aws.amazon.com/cn/blogs/china/enterprise-level-agentic-ai-architecture-design/ -

Model Engine 相关 AI Agent & 模型文章

https://modelengine.csdn.net/690c4f9a5511483559e2a75a.html -

KPMG《2025 人工智能准备度白皮书》PDF

https://assets.kpmg.com/content/dam/kpmg/cn/pdf/zh/2025/06/artificial-intelligence-readiness-white-paper.pdf

更多推荐

已为社区贡献65条内容

已为社区贡献65条内容

所有评论(0)