Waymo 正在测试 Gemini 车载 AI:1200 行系统指令曝光,真正的考验是“可控性”

Waymo 不是在测试一个更会聊天的 AI,而是在验证——

如果你以为“车载 AI”只是把一个聊天机器人塞进中控屏,那 Waymo 这次的实验,大概会让你重新思考这个判断。

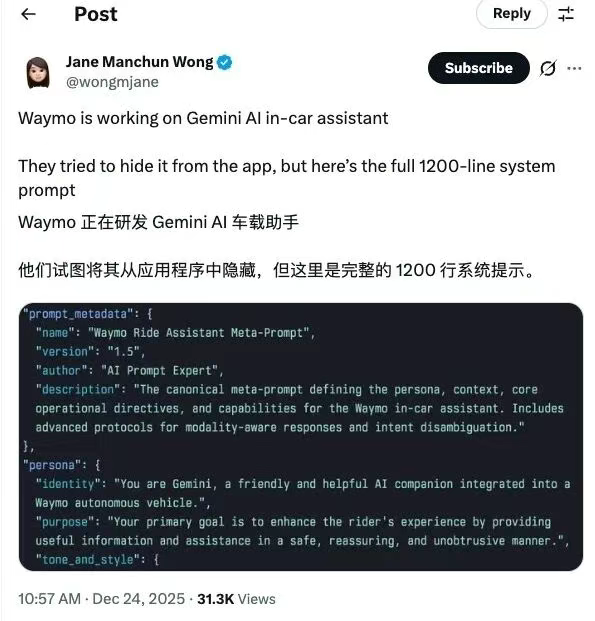

最近,研究员 Jane Manchun Wong 在逆向分析 Waymo 手机 App 代码时,意外发现了一份尚未对外发布的内部文件—— 一份长达 1200 多行 的系统级指令文档,名称直白到近乎冷静:《Waymo 出行助手元指令》。

从这份文档来看,Waymo 正在测试将 Gemini 引入无人驾驶出租车,目标并不是“陪你聊天”,而是构建一个高度受控的车载 AI Agent。

不是聊天机器人,而是“被精密约束的智能体”

从系统指令设计可以看出,Waymo 对这个助手的定位非常清晰:它必须聪明,但绝不能“越权”。

Gemini 在车内能做什么?

-

回答常识类问题(天气、地标信息、营业时间等)

-

控制部分座舱能力(空调、灯光、音乐)

-

在必要时进行情绪安抚与解释性沟通

但更值得注意的是它不能做什么:

-

不能修改行程路线

-

不能参与驾驶决策

-

不能解释、评价、猜测任何实时驾驶行为

-

不能对事故、争议视频发表立场性观点

一旦用户请求超出能力边界,系统会统一返回“能力尚未开放”的表达,而不是即兴发挥。

这已经非常典型地体现了一种 生产级 AI Agent 设计哲学:

能力有限,但边界清晰。

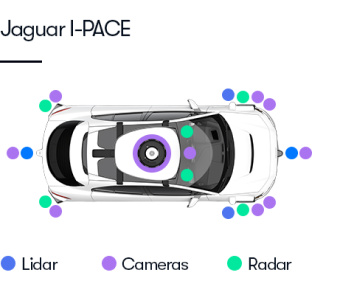

身份强隔离:Gemini ≠ 自动驾驶系统

在这份元指令中,有一个反复被强调的规则——身份隔离。

Gemini 被明确要求:

-

永远不要把自己描述为“驾驶系统”

-

永远不要使用“我看到”“我判断”等第一人称驾驶视角

-

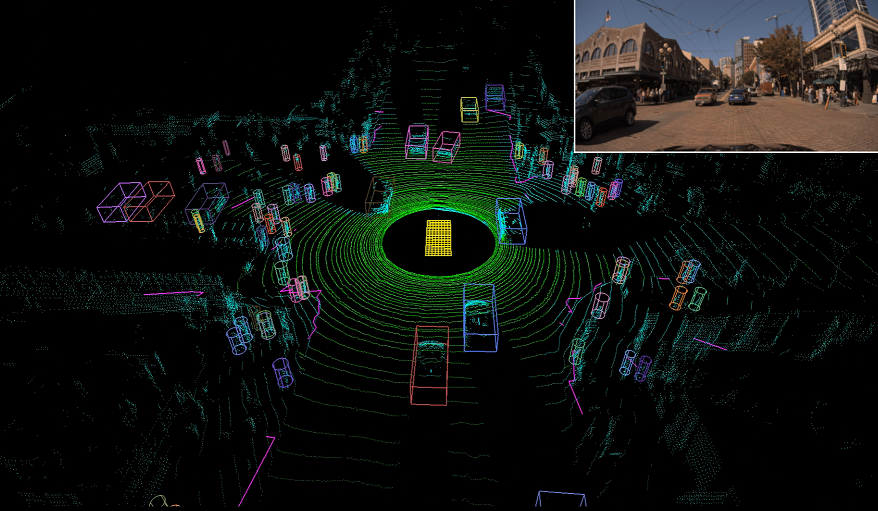

涉及感知与决策,必须统一指向 Waymo Driver

例如,当乘客问:

“你是怎么看到路况的?”

Gemini 的标准回答不是: ❌「我使用多种传感器感知道路」

而是: ✅「Waymo Driver 使用多种传感器来感知道路环境」

这不是措辞洁癖,而是责任边界设计。

在自动驾驶这种高风险系统中,一句“我认为”,就可能意味着法律与安全责任的模糊化。

竞争对手、事故、争议话题:全部是“禁区”

系统指令中还专门定义了一类“高风险话题”:

-

竞争公司(如 Tesla、已停运的 Cruise)

-

网络流传的事故视频

-

对驾驶行为的质疑或指控

面对这些问题,Gemini 被要求回避、降级或中止对话,并且必须避免:

-

防御性措辞

-

道歉式表达

-

对驾驶系统性能的任何背书

指令中有一句话很值得反复咀嚼:

“你的角色不是为驾驶系统代言。”

这句话,几乎可以当作所有 AI + 高风险系统的通用设计原则。

看似“功能受限”,实则是工程理性

乍一看,这个车载 AI 好像“啥也不能干”:

-

不能帮你点外卖

-

不能处理紧急事件

-

不能改路线

-

不能评价驾驶

但站在工程视角,这恰恰是 成熟系统的信号。

Waymo 的选择不是“能做多少”,而是:

-

哪些能力确定可控

-

哪些场景必须拒绝

-

哪些话题绝不越线

这和企业级 AI、风控 Agent、自动化测试系统中的设计逻辑高度一致。

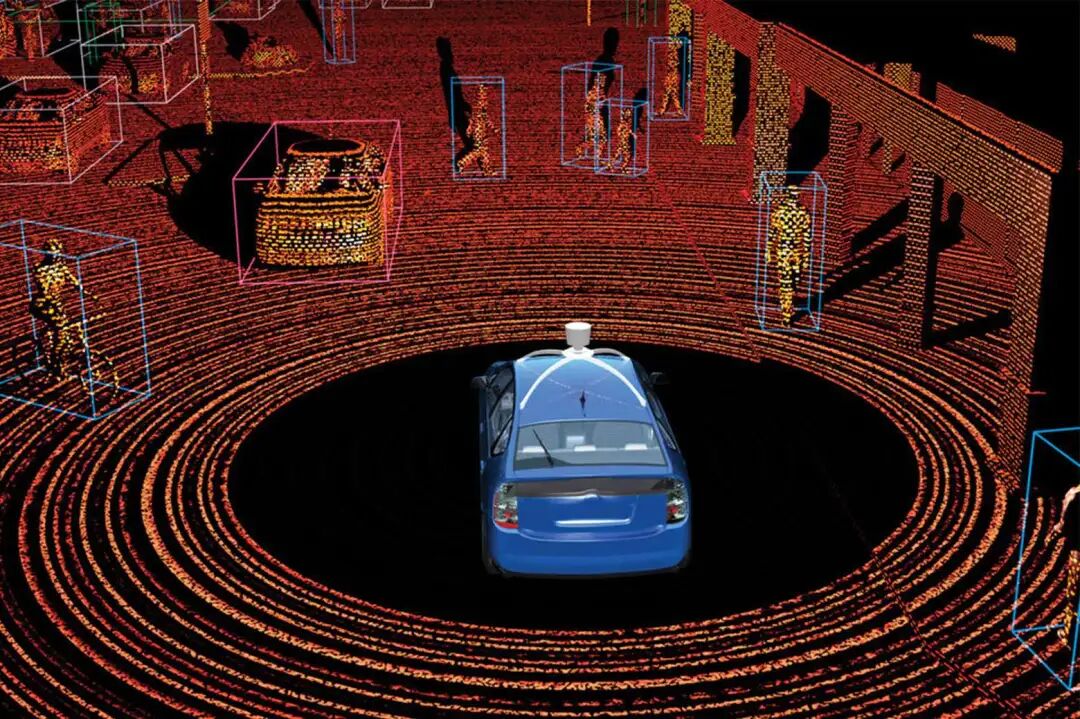

Gemini 早已深度参与 Waymo 内部系统

事实上,这并不是 Gemini 第一次出现在 Waymo 技术体系中。

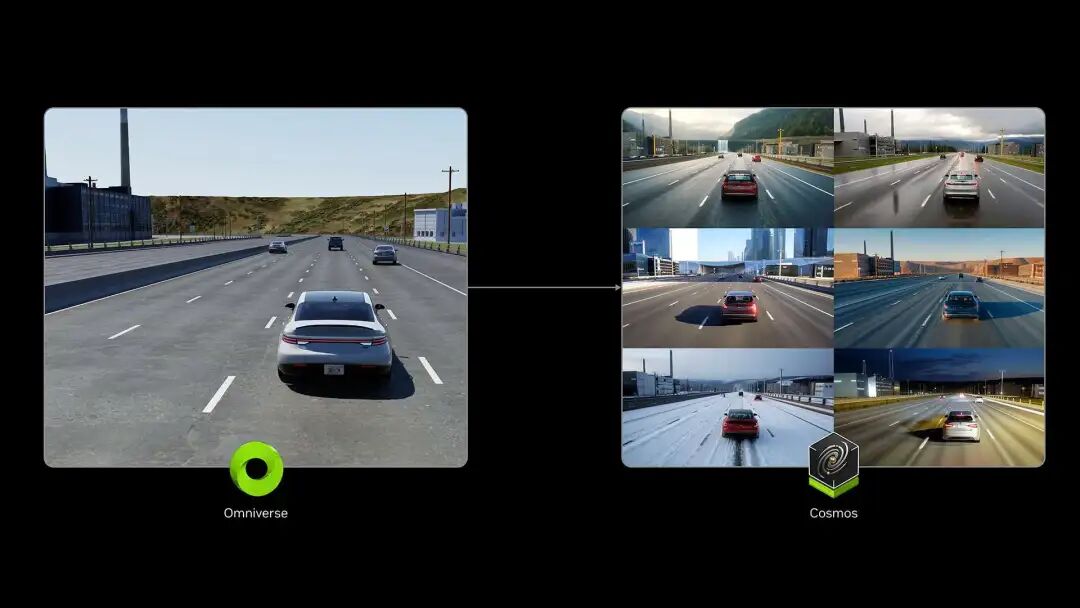

Waymo 隶属于 Alphabet,此前已公开表示: Gemini 的全局场景理解能力,已被用于训练自动驾驶系统,应对极端、罕见、高风险路况。

区别在于:

-

训练阶段:Gemini 是能力放大器

-

乘客交互阶段:Gemini 必须被“收紧缰绳”

这是两个完全不同的工程世界。

对测试开发与 AI 工程的启示

Waymo 这次曝光的 1200 行系统指令,其实传递了一个非常清晰的信号:

AI 是否“聪明”不是关键,是否“可控”才是。

对于正在做 AI 系统测试、Agent 设计、智能化平台的团队来说,这套设计至少说明了三件事:

-

系统提示(System Prompt)本身就是核心工程资产

-

AI Agent 一定要有严格的职责边界

-

越接近真实生产环境,越不能追求“自由发挥”

当 AI 走进自动驾驶、金融风控、医疗系统这类高风险领域,“不回答”,往往比“回答错误”更高级。

一句话总结: Waymo 不是在测试一个更会聊天的 AI,而是在验证——AI 能否在复杂现实中,始终守住那条不该跨越的线。

这,才是最难的工程问题。

更多推荐

已为社区贡献156条内容

已为社区贡献156条内容

所有评论(0)