剖析OpenAI 大模型端:它是一个高度封装的分布式系统

摘要:OpenAI大模型端是一个高度封装的分布式系统,采用四层架构设计。基础大模型集群(如GPT-4-turbo)负责推理决策和结果整合;工具执行引擎层实际运行代码解释器等工具;算力调度层管理资源分配;结果标准化层统一结果格式。各层分工明确,形成"决策-执行-整合"闭环,使开发者无需关心底层实现。这种设计将工具调用全流程封装,显著降低了开发门槛,是OpenAI区别于LangCh

OpenAI 大模型端是一个高度封装的分布式系统

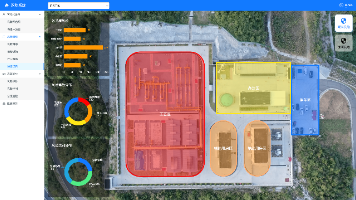

在前文“OpenAI Assistants API的核心架构范式”的架构图中,我们能得出结论:

- GPT-4-turbo 只是大模型端的核心组件之一,而非“大模型端”的全部;

- 大模型端是一个“包含多个子模块的完整系统”,GPT-4-turbo 不负责直接执行工具(比如代码解释器的计算),仅负责“决策是否调用工具、调用哪个工具”,以及“整合工具执行后的结果”。

一、大模型端的核心组成(4层结构:前文架构图中的三块再加一块辅助支撑层)

OpenAI 大模型端是一个高度封装的分布式系统,核心分为4个层级(前3层对应之前架构图中的 M1/M2/M3,第4层是辅助支撑层),各层职责边界清晰,协同完成“推理+工具调用”的全流程:

| 层级名称 | 对应架构图标识 | 核心定位 | 核心职责(结合工具调用场景) |

|---|---|---|---|

| 1. 基础大模型集群 | M1 | 核心推理/决策层 | 即 GPT-4-turbo/GPT-3.5-turbo 等模型,负责需求分析、工具调用决策、结果整合、自然语言回复生成 |

| 2. 工具执行引擎层 | M2 | 工具落地/执行层 | 内置各类工具的执行环境,负责实际执行工具操作(如代码解释器计算、检索增强查数据) |

| 3. 算力调度层 | M3 | 资源支撑/调度层 | 为前两层分配算力、调度GPU/TPU资源,保障推理和工具执行的效率 |

| 4. 结果标准化层(辅助) | - | 结果预处理/适配层 | 将工具执行引擎返回的原始结果(如纯数字31)标准化,方便大模型集群快速整合 |

各层级的详细说明(结合“代码解释器调用”场景)

1. 基础大模型集群(M1):GPT-4-turbo 所在的核心层

这是大模型端的“大脑”,核心就是不同版本的大语言模型(LLM),比如 GPT-4-turbo、GPT-3.5-turbo、GPT-4o 等。

- 核心职责:

✅ 分析用户需求:理解“3朵玫瑰每朵5元,2朵百合每朵8元,总价是多少?”是数值计算需求;

✅ 工具调用决策:结合 Assistant 的配置(要求用代码解释器),判断“需要调用 code_interpreter 工具,而非纯文本估算”;

✅ 生成工具调用指令:向工具执行引擎层下发结构化指令(如{"tool":"code_interpreter","code":"3*5+2*8"});

✅ 整合结果:接收工具执行引擎返回的“31”,生成带计算过程的自然语言回复(“玫瑰总价15元,百合总价16元,合计31元”); - 关键边界:不执行任何工具操作,仅做“决策”和“结果整合”,是“指挥者”而非“执行者”。

2. 工具执行引擎层(M2):代码解释器所在的执行层

这是大模型端的“手和脚”,是 OpenAI 内置的各类工具执行环境,核心包含:

-

代码解释器引擎:运行Python代码的沙箱环境,负责执行数值计算、数据处理、图表生成等;

-

检索增强(RAG)引擎:负责检索知识库、文档中的信息;

-

函数调用执行器:负责调用外部API(需云服务端授权);

-

多模态处理引擎:负责图片/音频的解析与生成(如GPT-4V)。

-

核心职责:

✅ 接收基础大模型集群的工具调用指令;

✅ 执行具体操作:比如在沙箱中运行3*5+2*8,得到结果31;

✅ 返回原始结果:将“31”(或代码执行日志)回传给基础大模型集群; -

关键边界:无推理/决策能力,仅“按指令执行”,是“执行者”而非“指挥者”。

3. 算力调度层(M3):资源支撑层

这是大模型端的“动力系统”,是 OpenAI 分布式算力集群的核心调度模块:

- 核心职责:

✅ 为基础大模型集群分配推理算力(比如GPT-4-turbo推理需要的GPU资源);

✅ 为工具执行引擎层分配执行算力(比如代码解释器运行代码需要的CPU/GPU资源);

✅ 负载均衡:避免单节点过载,保障工具调用的响应速度; - 关键边界:不参与业务逻辑,仅负责“资源分配”,是“后勤保障”。

4. 结果标准化层(辅助层)

这是大模型端的“翻译官”,负责抹平不同工具返回结果的格式差异:

- 核心职责:

✅ 接收工具执行引擎返回的原始结果(比如代码解释器返回的“31”是数字,检索引擎返回的是文本片段);

✅ 标准化处理:将结果转为基础大模型集群易理解的格式(如JSON); - 关键价值:减少基础大模型集群的格式适配成本,提升整合效率。

二、工具调用流程中,大模型端各模块的交互(以鲜花价格计算为例)

交互关键步骤:

- 云服务端将“鲜花价格计算”任务下发给大模型端后,算力调度层先给 GPT-4-turbo 分配推理算力;

- GPT-4-turbo 分析需求后,决策调用代码解释器,并下发执行指令;

- 算力调度层为代码解释器引擎分配算力;

- 代码解释器执行计算,返回原始结果“31”;

- 结果标准化层将“31”转为 JSON 格式(如

{"result":31}); - GPT-4-turbo 接收标准化结果,生成带计算过程的自然语言回复;

- 最终结果回传给云服务端。

三、核心总结(关键点回顾)

- 边界清晰:GPT-4-turbo ≠ 大模型端,只是大模型端“基础大模型集群”的一个组件;

- 角色分工:

- GPT-4-turbo:指挥者(决策工具调用)+ 整合者(整合工具结果);

- 工具执行引擎层:执行者(实际运行代码解释器);

- 算力调度层:保障者(分配算力);

- 逻辑闭环:大模型端通过“决策-执行-整合”的内部闭环,完成工具调用,云服务端仅做管控,客户端无感知。

这个设计的核心目的是:OpenAI 将“工具调用”的全流程封装在大模型端,让开发者无需关心“工具怎么执行”,只需配置“要不要用工具”,最大化降低开发门槛——这也是和 LangChain 最核心的区别(LangChain 需要开发者自己写调用工具的衔接代码,而 OpenAI 把执行层全封装了)。

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)