裁员潮下的自救:我用 Go 写了一个企业级 AI Agent 平台,薪资翻倍(万字复盘)

裁员潮下的自救:我用 Go 写了一个企业级 AI Agent 平台,薪资翻倍(万字复盘)2024 年底,后端开发岗位的“寒气”比以往来得更猛烈些。只会 CRUD 的程序员正在失去议价权,而掌握能力的开发者却成了香饽饽。本文将分享一个普通 Go 开发者,如何利用技术栈,从零构建并上线一个商业级 AI 面试 Agent 平台的完整心路历程与技术复盘。

裁员潮下的自救:我用 Go 写了一个企业级 AI Agent 平台,薪资翻倍(万字复盘)

2024 年底,后端开发岗位的“寒气”比以往来得更猛烈些。只会 CRUD 的程序员正在失去议价权,而掌握 AI Engineering(AI 工程化) 能力的开发者却成了香饽饽。本文将分享一个普通 Go 开发者,如何利用 Eino + Hertz + Milvus 技术栈,从零构建并上线一个商业级 AI 面试 Agent 平台的完整心路历程与技术复盘。

一、 为什么要折腾这个项目?

1.1 职业危机感

实话实说,我也焦虑。

打开招聘软件,你会发现现在的后端 JD 变了:

- 以前:精通 Go/Java,熟悉 MySQL/Redis,了解微服务。

- 现在:熟悉 LangChain/Eino 框架,有 RAG/Agent 落地经验,懂 向量数据库。

结论很残酷:纯传统的 Web 开发技能栈正在贬值,AI 应用开发能力是唯一的增量。

1.2 为什么不选 Python?

虽然 Python 是 AI 界的“第一公民”,但在应用层(Serving),它真的很难打。

- 并发性能:Python 的 GIL 锁注定它扛不住高并发。

- 工程规范:动态类型的“一时爽”,在大型项目中就是灾难。

而 Go 语言 的高并发、强类型、编译速度快,恰恰是构建生产级 AI Agent 的最佳选择。再加上字节跳动开源了 Eino 框架,填补了 Go 在 Agent 编排领域的空白,这让我看到了机会。

二、 项目全景:这不仅仅是一个 Demo

我决定做一个**【面试吧】(Interview Agent)平台。

它不是那种简单的“套壳 ChatGPT”,而是一个全链路的垂直领域 AI 应用**。

2.1 核心功能

- 简历深度解析:上传 PDF,Agent 自动提取技术栈、项目亮点。

- 专项面试官:Go、Java、Redis、MySQL 多个垂直领域的专家 Agent。

- 多轮深度追问:基于 CoT(思维链),针对回答漏洞进行追问。

- 智能评估报告:面试结束后,生成包含雷达图的详细反馈。

2.2 技术栈选型(全大厂标准)

- 语言:Go 1.22

- Web 框架:Hertz(字节开源,性能怪兽)

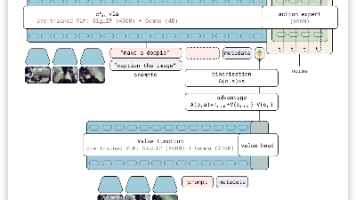

- Agent 框架:Eino(字节开源,图编排模式)

- 向量库:Milvus(企业级 RAG 标配)

- 消息队列:Redis Queue(异步解耦)

三、 核心技术难点攻克

3.1 难点一:如何让 Agent 像人一样思考?

传统的 prompt + completion 模式太死板。

在 Eino 中,我使用了 ReAct (Reasoning + Acting) 范式。

代码复盘:

我定义了一个 SchoolComprehensiveAgent(校招综合面试官)。它不仅仅是对话,而是拥有工具调用能力。

// backend/chatApp/agent/interview/comprehensive/school_comprehensive_agent.go

// 定义 Agent

agent, err := adk.NewChatModelAgent(ctx, &adk.ChatModelAgentConfig{

Name: "SchoolInterviewer",

// 赋予它简历分析工具

ToolsConfig: adk.ToolsConfig{

ToolsNodeConfig: compose.ToolsNodeConfig{

Tools: []componenttool.BaseTool{

tool2.GetResumeInfoTool(),

},

},

},

// 允许它最大思考 15 轮

MaxIterations: 15,

})

效果:当用户上传简历后,Agent 会先自主决定调用 GetResumeInfoTool,拿到简历内容后,再根据内容生成个性化的问题。这种**“自主决策”**的能力,才是 Agent 的灵魂。

3.2 难点二:如何解决大模型“胡说八道”?

面试题必须严谨。如果问 Java 的问题,AI 却用 Python 的语法回答,那就闹笑话了。

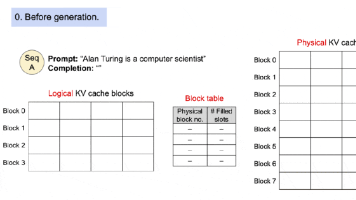

解决方案:RAG(检索增强生成)。

我搭建了一套 Milvus 向量检索系统。但普通的向量搜索不够,我实现了 Hybrid Search(混合检索)。

关键代码:

// backend/internal/eino/milvus/retrieval/retriever.go

// 结合“语义相似度”和“硬性条件过滤”

// 比如:必须是“Redis”分类,且“难度”为“高级”的题目

filter := "category == 'Redis' && difficulty == 'Hard'"

docs, err := retriever.Retrieve(ctx, query, retrieval.WithFilter(filter))

这就像给 AI 装了一个“外挂大脑”,它在回答前会先去查阅经过验证的题库,准确率直接拉满。

3.3 难点三:如何优化用户体验?

AI 生成回复通常需要 3-5 秒,用户等待感很强。

我设计了 Redis Queue + SSE (Server-Sent Events) 的流式架构。

- Hertz 端:接收请求 -> 丢入 Redis 队列 -> 立即返回 TaskID。

- Worker 端:消费队列 -> 调用 Agent 推理 -> 将生成的 Token 逐个推送到 SSE 通道。

- 前端:建立 SSE 长连接 -> 像打字机一样实时显示内容。

这不仅解决了超时问题,还让用户感觉“对面真的有人在打字”,体验极佳。

四、 成果与收获

4.1 项目成果

- 上线:项目已部署上线,支持多用户并发面试。

- 性能:单机 QPS 达到 100+(受限于 LLM API 速率),系统本身延迟 < 10ms。

- 代码量:后端 Go 代码约 1.5w 行,结构清晰,模块解耦。

4.2 个人成长

通过这个项目,我彻底打通了 LLM -> Agent -> RAG -> 微服务 的全链路。

现在看大模型的视角完全变了:它不再是一个神秘的黑盒,而是一个可以被工程化调用的 Function。

五、 给兄弟们的建议

- 别犹豫,转 Go AI:Python 确实生态好,但 Go 在 AI 工程化(特别是 Agent/RAG 落地)上有巨大的先发优势,现在进场就是降维打击。

- 别只看,要动手:看一百遍文档,不如亲手写一个

NewChatModelAgent。 - 重视架构:面试官问 AI 项目,问的不仅是 Prompt,更是你的高并发处理、状态管理、错误兜底能力。

如果你想参考我的完整源码(含 Go 后端、Next.js 前端、Docker 配置),或者想深入了解 Eino 框架。

👉 获取方式:

关注公众号【王中阳】,回复“面试吧”,即可获取项目演示和源码线索。

私信备注“面试吧”,拉你进技术交流群,一起抱团取暖,穿越周期!

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)