《揭秘大数据Flink,为数据处理注入新动力》

批流一体:Flink用同一API处理批和流,解决了传统框架的割裂问题;状态管理:Keyed State和Operator State让流处理“有记忆”,支持大状态存储;时间语义:事件时间+Watermark解决了“数据迟到”的难题;容错机制:Checkpoint+Savepoint保证了Exactly-Once,让系统“永不停机”;Flink SQL:用SQL写实时任务,降低了开发门槛。Flink

揭秘大数据Flink,为数据处理注入新动力

引言:你是否被这些数据处理痛点困住?

凌晨3点,电商运维工程师小张盯着监控屏皱起眉头——双11大促的实时订单 dashboard 又“卡”了:用户支付成功5分钟后,系统才更新订单状态;客服那边已经接到100+投诉,说“明明付了钱却显示未下单”。

同样头疼的还有数据分析师小李:为了做“用户实时行为分析”,他得同时维护两套系统——用Hadoop跑批处理算昨天的GMV,用Spark Streaming跑微批处理算实时流量。两套系统的口径不一致,经常出现“昨天的GMV是1亿,实时统计却是1.2亿”的矛盾,每次对齐数据都要熬到深夜。

还有运维工程师小王:上次系统崩溃后,恢复数据花了3小时——因为流处理任务的状态没保存好,重新计算时丢了10%的订单数据,导致财务对账差了20万。

这些痛点,本质上是传统数据处理框架的“先天不足”:

- 实时性差:Spark Streaming的“微批处理”本质是把流切成小批次,延迟至少秒级;

- 批流割裂:批处理(Hadoop)和流处理(Spark Streaming)是两套架构,数据口径难统一;

- 状态难管:流处理中的“状态”(比如用户的访问次数、订单的累计金额)没有可靠的存储和恢复机制;

- 精确一次难:大部分框架只能保证“至少一次”或“最多一次”,无法避免重复数据或丢失数据。

如果你也遇到过这些问题,Apache Flink 可能是你的“救星”。它不是一个“新玩具”——阿里双11用它处理每秒10亿+的实时订单,美团用它做实时推荐,字节用它做用户行为分析。它的核心目标就是:让数据处理“又快又准”,同时打通批流边界。

先看效果:用Flink解决小张的问题

小张的电商订单系统,原本用Spark Streaming处理,延迟是5-10秒。换成Flink后:

- 延迟降到100毫秒内:用户支付成功后,dashboard 瞬间更新;

- 精确一次处理:即使系统崩溃,恢复后订单数据100%准确,没有重复或丢失;

- 批流一体:实时统计的GMV和凌晨跑批的结果完全一致,不用再对齐数据。

这就是Flink的威力——为数据处理注入“实时+准确+统一”的新动力。

准备工作:从0到1搭建Flink环境

在开始揭秘Flink原理前,我们先做好准备工作——搭建一个可运行的Flink环境。

1. 环境要求

- JDK 1.8+(Flink 1.17及以上推荐JDK 11,但1.8也兼容);

- Flink 1.17.0(官网下载:https://flink.apache.org/downloads/);

- 可选工具:Kafka(用于模拟流数据)、Elasticsearch+Kibana(用于可视化)。

2. 快速安装Flink

- 下载Flink压缩包,解压到本地目录(比如

/opt/flink); - 启动Flink集群:

./bin/start-cluster.sh; - 访问Web UI:http://localhost:8081(能看到Flink dashboard 就说明成功)。

3. 前置知识

- 了解“批处理”(处理有限数据,比如昨天的订单)和“流处理”(处理无限数据,比如实时产生的订单)的基本概念;

- 会写简单的Java/Scala代码(Flink支持Java、Scala、Python,本文用Java);

- 知道Kafka是“消息队列”,用于传输流数据。

核心原理揭秘:Flink为什么这么强?

Flink的强大,源于它的四大核心设计:批流一体的架构、精准的状态管理、灵活的时间语义、可靠的容错机制。我们逐一拆解。

一、批流一体:把“批”当成“有限的流”

传统框架的痛点:批处理和流处理是两套完全不同的API,比如Hadoop的MapReduce和Spark Streaming的DStream。这导致:

- 开发成本高:要学两套API;

- 数据口径不一致:批处理算的“用户活跃度”和流处理算的可能不一样;

- 资源浪费:两套系统要分别部署和维护。

Flink的解决思路很简单:批处理是流处理的特例——批是“有限的流”。换句话说,Flink用同一套API处理“无限流”(实时数据)和“有限流”(历史数据)。

代码示例:用同一API处理批和流

比如,我们要统计“用户访问次数”:

- 对于流数据(比如Kafka中的实时用户行为),用

DataStream API; - 对于批数据(比如HDFS中的历史日志文件),用

DataSet API(Flink 1.12+推荐用DataStream API处理批数据,因为更统一)。

流处理代码(统计实时用户访问次数):

// 创建Flink执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 从Kafka读取流数据

DataStream<UserVisit> userVisits = env.addSource(

KafkaSource.<UserVisit>builder()

.setBootstrapServers("localhost:9092")

.setTopics("user_visits")

.setGroupId("flink_group")

.setValueOnlyDeserializer(new JsonDeserializer<>(UserVisit.class))

.build()

);

// 按用户ID分组,统计访问次数

DataStream<Tuple2<String, Long>> visitCounts = userVisits

.keyBy(UserVisit::getUserId) // 按用户ID分组

.process(new UserVisitCounter()); // 自定义处理函数

// 输出结果到控制台

visitCounts.print();

// 执行任务

env.execute("Real-time User Visit Counter");

批处理代码(统计历史日志中的用户访问次数):

// 创建Flink批处理执行环境(Flink 1.12+推荐用StreamExecutionEnvironment,设置为批模式)

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setRuntimeMode(RuntimeExecutionMode.BATCH); // 开启批模式

// 从HDFS读取历史日志文件

DataStream<UserVisit> userVisits = env.readTextFile("hdfs://localhost:9000/user_visits/*.log")

.map(line -> JSON.parseObject(line, UserVisit.class)); // 解析日志为UserVisit对象

// 和流处理完全一样的逻辑:分组→统计

DataStream<Tuple2<String, Long>> visitCounts = userVisits

.keyBy(UserVisit::getUserId)

.process(new UserVisitCounter());

// 输出到HDFS

visitCounts.writeAsText("hdfs://localhost:9000/visit_counts");

env.execute("Batch User Visit Counter");

关键结论:Flink的DataStream API可以同时处理批和流,只需修改“执行模式”(流模式/批模式)和“数据源”(Kafka/HDFS)。这彻底解决了批流割裂的问题!

二、状态管理:让流处理“有记忆”

流处理的核心是“状态”——比如用户的访问次数、订单的累计金额、设备的在线状态。如果没有状态管理,流处理任务就是“无记忆”的:每次处理一个事件,都要重新计算所有数据,效率极低。

Flink的状态管理是业界最强大的,它支持两种核心状态:

1. Keyed State:按“键”分区的状态

最常用的状态类型,比如“按用户ID分组的访问次数”“按商品ID分组的销量”。每个“键”对应一个独立的状态,Flink会自动把相同键的状态分配到同一个TaskManager(任务管理器)上,保证处理的局部性。

代码示例:用Keyed State统计用户访问次数

// UserVisitCounter:自定义KeyedProcessFunction,处理每个用户的访问事件

public class UserVisitCounter extends KeyedProcessFunction<String, UserVisit, Tuple2<String, Long>> {

// 定义ValueState:保存每个用户的访问次数(Long类型)

private ValueState<Long> visitCountState;

@Override

public void open(Configuration parameters) throws Exception {

// 初始化State:指定状态名称和类型

ValueStateDescriptor<Long> descriptor = new ValueStateDescriptor<>(

"visitCount", // 状态名称(唯一)

Long.class // 状态类型

);

// 从RuntimeContext中获取State(Flink会自动管理状态的存储和恢复)

visitCountState = getRuntimeContext().getState(descriptor);

}

@Override

public void processElement(UserVisit value, Context ctx, Collector<Tuple2<String, Long>> out) throws Exception {

// 1. 从State中获取当前访问次数(如果是第一次访问,count为null)

Long count = visitCountState.value();

if (count == null) {

count = 0L;

}

// 2. 访问次数加1

count++;

// 3. 更新State(Flink会自动把State同步到持久化存储)

visitCountState.update(count);

// 4. 输出结果(用户ID,当前访问次数)

out.collect(Tuple2.of(value.getUserId(), count));

}

}

关键解释:

KeyedProcessFunction:Flink的低阶处理函数,用于处理KeyedStream中的每个元素;ValueState:最简单的Keyed State类型,保存一个单一的值;open方法:初始化State(只执行一次);processElement方法:处理每个事件,更新State并输出结果。

2. Operator State:算子级别的状态

适用于“不按键分区”的场景,比如“Kafka Consumer的偏移量”(每个Consumer实例需要保存自己的偏移量)。Operator State是绑定到“算子实例”的,当算子并行度变化时,Flink会自动重新分配State。

3. 状态的持久化:StateBackend

Flink支持三种StateBackend(状态存储后端):

- MemoryStateBackend:状态保存在JVM堆内存中(适合测试,不适合生产);

- FsStateBackend:状态保存在文件系统(比如HDFS)中(适合大状态,生产常用);

- RocksDBStateBackend:状态保存在RocksDB(嵌入式KV数据库)中(适合超大状态,支持增量Checkpoint)。

配置示例(在flink-conf.yaml中设置):

# 使用RocksDBStateBackend,状态保存到HDFS

state.backend: rocksdb

state.backend.rocksdb.localdir: /tmp/flink-rocksdb

state.checkpoints.dir: hdfs://localhost:9000/flink-checkpoints

三、时间语义:解决“数据迟到”的难题

在实时流处理中,“时间”是个棘手的问题:比如一个用户在10:00:00产生的订单,因为网络延迟,10:00:10才到达Flink。这时候,如何计算“10:00:00-10:00:05”窗口的订单总额?

Flink的时间语义和Watermark(水印)机制,完美解决了这个问题。

1. 三种时间语义

Flink支持三种时间:

- 事件时间(Event Time):事件实际发生的时间(比如订单的创建时间,由用户设备生成);

- 处理时间(Processing Time):Flink处理该事件的时间(比如Flink节点的系统时间);

- 摄入时间(Ingestion Time):事件进入Flink的时间(比如Kafka Consumer收到事件的时间)。

最常用的是事件时间——因为它能反映事件的“真实顺序”,不受网络延迟或系统负载的影响。

2. Watermark:告诉Flink“什么时候不再等迟到的数据”

Watermark是Flink用来跟踪事件时间进度的机制,它的核心思想是:“当前已经处理到事件时间T,后续不会再收到事件时间小于T的事件了”。

比如,我们设置Watermark的延迟为5秒(allowedLateness = 5s):

- 当Flink收到一个事件时间为10:00:10的事件时,Watermark会推进到10:00:05;

- 此时,所有事件时间小于等于10:00:05的窗口(比如10:00:00-10:00:05)都会被触发计算;

- 之后如果收到事件时间为10:00:03的迟到事件,Flink会忽略它(除非设置了

allowedLateness)。

代码示例:用事件时间和Watermark做窗口计算

我们要计算“5分钟滚动窗口内的订单总额”:

// 1. 创建执行环境,设置事件时间语义

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime); // 启用事件时间

// 2. 从Kafka读取订单数据,提取事件时间并生成Watermark

DataStream<Order> orders = env.addSource(kafkaSource)

.assignTimestampsAndWatermarks(

// 周期性Watermark生成器:每200ms生成一次Watermark

WatermarkStrategy.<Order>forBoundedOutOfOrderness(Duration.ofSeconds(5)) // 允许5秒延迟

.withTimestampAssigner((order, timestamp) -> order.getCreateTime()) // 提取事件时间(毫秒)

);

// 3. 按商品ID分组,做5分钟滚动窗口计算

DataStream<Tuple3<String, Long, Double>> windowedSales = orders

.keyBy(Order::getProductId) // 按商品ID分组

.window(TumblingEventTimeWindows.of(Time.minutes(5))) // 5分钟滚动窗口(事件时间)

.sum("amount"); // 求和订单金额

// 4. 输出结果

windowedSales.print();

关键解释:

WatermarkStrategy.forBoundedOutOfOrderness:适用于“数据有固定延迟”的场景(比如最多延迟5秒);TumblingEventTimeWindows:滚动窗口(无重叠),基于事件时间;- 当Watermark推进到窗口结束时间+延迟时间时,窗口会被触发计算。

四、容错机制:Checkpoint与Savepoint,让系统“永不停机”

Flink的容错机制基于**分布式快照(Checkpoint)**技术,它能保证:

- Exactly-Once(精确一次):即使系统崩溃,恢复后数据也不会重复或丢失;

- 低 overhead:Checkpoint是异步的,不会阻塞正常的流处理。

1. Checkpoint:自动的分布式快照

Flink会定期(比如每1分钟)给整个流处理任务做一个“快照”,包括:

- 每个算子的状态(比如用户访问次数);

- 每个数据源的偏移量(比如Kafka的consumer offset)。

当系统崩溃时,Flink会从最近的Checkpoint恢复:

- 重启所有算子;

- 恢复每个算子的状态;

- 从数据源的偏移量重新读取数据(比如从Kafka的offset=1000处开始读)。

配置示例(在flink-conf.yaml中设置):

# 启用Checkpoint,每1分钟做一次

execution.checkpointing.interval: 60000

# exactly-once 语义

execution.checkpointing.mode: EXACTLY_ONCE

# Checkpoint超时时间:10分钟

execution.checkpointing.timeout: 600000

# 最多同时进行1个Checkpoint

execution.checkpointing.max-concurrent-checkpoints: 1

2. Savepoint:手动的快照

Checkpoint是自动的、临时的,用于故障恢复;而Savepoint是手动的、持久的,用于任务升级或迁移。比如:

- 你要把Flink任务从1.15升级到1.17,先做一个Savepoint,升级后从Savepoint恢复;

- 你要扩容Flink集群,先做一个Savepoint,扩容后从Savepoint恢复。

创建Savepoint的命令:

./bin/flink savepoint <job-id> hdfs://localhost:9000/flink-savepoints

从Savepoint恢复的命令:

./bin/flink run -s hdfs://localhost:9000/flink-savepoints/savepoint-xxxxxx -jar my-job.jar

实践:用Flink搭建实时电商数据分析系统

理论讲得再多,不如动手做一个实际项目。我们来搭建一个实时电商数据分析系统,实现:

- 从Kafka读取实时订单数据;

- 用Flink SQL计算“5分钟窗口内的Top 5热销商品”;

- 将结果输出到Elasticsearch;

- 用Kibana可视化实时 dashboard。

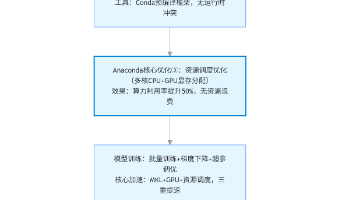

系统架构

Kafka(数据源) → Flink(处理) → Elasticsearch(存储) → Kibana(可视化)

步骤1:准备数据源(Kafka)

- 启动Kafka集群(参考Kafka官网文档);

- 创建主题

order_topic:kafka-topics.sh --create --topic order_topic --bootstrap-server localhost:9092 --partitions 3 --replication-factor 1; - 生成测试数据:用Python脚本向

order_topic发送模拟订单数据(包含order_id、product_id、amount、create_time)。

步骤2:创建Flink SQL表

Flink SQL是Flink的“杀手级特性”——它让你用SQL写实时流处理任务,不用写复杂的Java代码。

首先,在Flink Web UI中打开“SQL Client”(或用命令行./bin/sql-client.sh)。

1. 创建Kafka数据源表

-- 定义Kafka数据源表:order_source

CREATE TABLE order_source (

order_id STRING, -- 订单ID

product_id STRING, -- 商品ID

amount DOUBLE, -- 订单金额

create_time TIMESTAMP(3) -- 订单创建时间(事件时间)

) WITH (

'connector' = 'kafka', -- 连接器类型:Kafka

'topic' = 'order_topic', -- Kafka主题

'properties.bootstrap.servers' = 'localhost:9092', -- Kafka地址

'properties.group.id' = 'flink_sql_group', -- 消费者组ID

'scan.startup.mode' = 'latest-offset', -- 从最新偏移量开始读

'format' = 'json', -- 数据格式:JSON

'json.fail-on-missing-field' = 'false', -- 缺少字段不报错

'json.ignore-parse-errors' = 'true' -- 忽略解析错误

);

2. 创建Elasticsearch结果表

-- 定义Elasticsearch结果表:top_sold_products

CREATE TABLE top_sold_products (

window_start TIMESTAMP(3), -- 窗口开始时间

window_end TIMESTAMP(3), -- 窗口结束时间

product_id STRING, -- 商品ID

sales BIGINT, -- 销量(订单数)

total_amount DOUBLE, -- 总金额

PRIMARY KEY (window_start, window_end, product_id) NOT ENFORCED -- 主键(用于ES的文档ID)

) WITH (

'connector' = 'elasticsearch-7', -- 连接器类型:Elasticsearch 7.x

'hosts' = 'http://localhost:9200', -- ES地址

'index' = 'top_sold_products', -- ES索引名

'document-id.key-delimiter' = '_', -- 文档ID的分隔符(window_start_window_end_product_id)

'sink.batch.size' = '100', -- 每批写入100条数据

'sink.flush.interval' = '5000' -- 每5秒刷新一次

);

步骤3:写Flink SQL查询

我们要计算“5分钟滚动窗口内的Top 5热销商品”(按销量排序):

-- 实时计算Top 5热销商品,插入到结果表

INSERT INTO top_sold_products

SELECT

TUMBLE_START(create_time, INTERVAL '5' MINUTE) AS window_start, -- 窗口开始时间

TUMBLE_END(create_time, INTERVAL '5' MINUTE) AS window_end, -- 窗口结束时间

product_id, -- 商品ID

COUNT(*) AS sales, -- 销量(订单数)

SUM(amount) AS total_amount -- 总金额

FROM order_source

GROUP BY

TUMBLE(create_time, INTERVAL '5' MINUTE), -- 5分钟滚动窗口(事件时间)

product_id -- 按商品ID分组

ORDER BY sales DESC -- 按销量降序排序

LIMIT 5; -- 取Top 5

步骤4:可视化(Kibana)

- 启动Elasticsearch和Kibana(参考官网文档);

- 在Kibana中创建“Index Pattern”(索引模式):匹配

top_sold_products; - 创建“Dashboard”:添加“Line Chart”(展示销量趋势)、“Table”(展示Top 5商品)、“Metric”(展示总金额)。

效果展示

当你向Kafka发送模拟订单数据后,Kibana dashboard 会实时更新:

- 5分钟窗口的销量趋势图会动态变化;

- Top 5商品的表格会自动排序;

- 总金额的数字会实时跳动。

总结与扩展:Flink的“进阶之路”

一、核心要点回顾

- 批流一体:Flink用同一API处理批和流,解决了传统框架的割裂问题;

- 状态管理:Keyed State和Operator State让流处理“有记忆”,支持大状态存储;

- 时间语义:事件时间+Watermark解决了“数据迟到”的难题;

- 容错机制:Checkpoint+Savepoint保证了Exactly-Once,让系统“永不停机”;

- Flink SQL:用SQL写实时任务,降低了开发门槛。

二、常见问题解答(FAQ)

1. Checkpoint失败怎么办?

- 检查StateBackend配置:如果用MemoryStateBackend,可能是状态太大导致OOM,换成RocksDBStateBackend;

- 检查数据源/ sink的连通性:比如Kafka或ES宕机,导致Checkpoint无法完成;

- 检查算子的处理逻辑:比如算子中有耗时太长的操作,导致Checkpoint超时。

2. Watermark设置不合理导致数据丢失?

- 如果Watermark推进得太快(延迟设置太小),会漏掉迟到的数据;

- 如果Watermark推进得太慢(延迟设置太大),会导致窗口触发延迟,实时性下降;

- 解决方案:根据实际数据的延迟情况调整

forBoundedOutOfOrderness的参数(比如从5秒调到10秒)。

3. 状态太大导致Checkpoint时间过长?

- 启用增量Checkpoint(仅RocksDBStateBackend支持):只保存状态的增量变化,减少Checkpoint的数据量;

- 启用状态压缩:在

flink-conf.yaml中设置state.compression.type: snappy(用Snappy算法压缩状态); - 拆分状态:将大状态拆分成多个小状态,比如按时间分片。

三、进阶方向推荐

-

性能优化:

- 调整并行度:根据CPU核心数设置并行度(比如每个TaskManager设置4个并行度);

- 启用算子链(Operator Chaining):将相邻的算子合并成一个任务,减少数据传输开销;

- 使用异步IO:对于慢Sink(比如ES),用异步IO提高吞吐量。

-

自定义Operator:

- 如果Flink的内置算子(比如Map、Reduce)满足不了需求,可以自定义

ProcessFunction(低阶算子); - 比如实现复杂的事件驱动逻辑(比如“用户连续点击3次按钮就触发预警”)。

- 如果Flink的内置算子(比如Map、Reduce)满足不了需求,可以自定义

-

Flink CDC:

- Flink CDC(Change Data Capture)用于捕获数据库的变更数据(比如MySQL的INSERT/UPDATE/DELETE);

- 可以实现“实时数据同步”(比如把MySQL的订单表同步到ES)或“实时数据仓库”(比如用Flink CDC构建实时数仓)。

-

Flink与其他系统集成:

- 与Hive集成:用Flink SQL查询Hive表(批处理),或用Flink将实时数据写入Hive(流处理);

- 与Spark集成:用Flink处理实时数据,用Spark处理复杂的批处理任务(比如机器学习)。

四、资源推荐

- 官网文档:https://flink.apache.org/documentation/(最权威的资料);

- 中文社区:https://flink-learning.org.cn/(有很多实战教程和问题解答);

- 书籍:《Apache Flink实战》(作者:寇云飞,讲解Flink的核心原理和实战);

- GitHub仓库:https://github.com/apache/flink-examples(官方示例代码);

- 视频课程:Coursera的《Apache Flink for Stream Processing》(英文,适合入门)。

最后:Flink的未来

Flink的目标是成为“统一数据处理平台”——无论是批处理、流处理、机器学习还是AI,都能在Flink上完成。随着实时数据的需求越来越大(比如实时推荐、实时监控、实时数仓),Flink的地位会越来越重要。

如果你还没试过Flink,现在就是最好的时机——下载Flink,写一个简单的实时任务,感受它的“快”和“准”。相信我,你会爱上它的!

欢迎在评论区分享你的Flink实战经验,或提出问题,我们一起讨论!

更多推荐

已为社区贡献83条内容

已为社区贡献83条内容

所有评论(0)