探索大数据领域数据挖掘的前沿趋势

数据挖掘(Data Mining)就像"数字考古学家",从海量数据中挖掘隐藏的价值规律。但随着数据类型从结构化表格(如Excel)扩展到文本、图像、视频等多模态数据,存储方式从集中式数据库转向分布式云平台,传统数据挖掘技术(如决策树、K-means聚类)已难以应对新挑战。本文将聚焦2023-2024年最受关注的五大前沿趋势,覆盖技术原理、应用场景与实战方法。AI大模型与数据挖掘的深度融合隐私保护下

探索大数据领域数据挖掘的前沿趋势

关键词:数据挖掘、大数据、前沿趋势、AI融合、隐私计算、实时分析、图挖掘

摘要:在数据量以"泽字节(ZB)"为单位爆炸增长的今天,数据挖掘已从"分析历史"进化为"预测未来"的核心技术。本文将带你穿越数据挖掘的技术演进脉络,从AI大模型的深度融合到隐私保护下的协作分析,从实时流数据的毫秒级洞察到复杂关系网络的智能解析,逐一拆解当前最前沿的五大趋势,结合生活案例与代码实战,帮你快速掌握数据挖掘的未来方向。

背景介绍

目的和范围

数据挖掘(Data Mining)就像"数字考古学家",从海量数据中挖掘隐藏的价值规律。但随着数据类型从结构化表格(如Excel)扩展到文本、图像、视频等多模态数据,存储方式从集中式数据库转向分布式云平台,传统数据挖掘技术(如决策树、K-means聚类)已难以应对新挑战。本文将聚焦2023-2024年最受关注的五大前沿趋势,覆盖技术原理、应用场景与实战方法。

预期读者

- 数据分析师:想了解如何用新工具提升分析效率

- 算法工程师:需掌握与AI大模型、隐私计算等技术的融合方法

- 企业决策者:希望通过数据挖掘驱动业务创新的管理者

- 技术爱好者:对大数据技术发展感兴趣的入门学习者

文档结构概述

本文将按"趋势拆解→原理讲解→实战演示→场景落地"的逻辑展开,重点解析:

- AI大模型与数据挖掘的深度融合

- 隐私保护下的协作数据挖掘(联邦学习/差分隐私)

- 实时流数据的毫秒级挖掘(边缘计算+流处理)

- 图挖掘:从"孤立数据"到"关系网络"的突破

- 自动化数据挖掘(AutoML)的普及

术语表

| 术语 | 通俗解释 | 关联场景 |

|---|---|---|

| 多模态数据 | 文字、图片、语音、视频等混合数据 | 电商商品详情页分析 |

| 联邦学习 | 数据"不动"模型动的协作训练方式 | 银行间联合风控 |

| 流处理 | 像水管一样实时处理流动数据 | 双11实时销量监控 |

| 图神经网络 | 专门分析"关系"的AI模型 | 社交网络好友推荐 |

| AutoML | 自动完成数据清洗到模型训练的工具 | 中小企业快速搭建分析系统 |

核心概念与联系:从"找规律"到"解复杂题"

故事引入:奶茶店的"数据进化史"

假设你开了一家奶茶店,数据挖掘的发展就像你的经营方式升级:

- 1.0时代(2010年前):用Excel统计每月卖得最多的口味(结构化数据+传统聚类)

- 2.0时代(2015年):分析会员消费记录+天气数据,预测雨天哪款奶茶销量高(多源数据+决策树)

- 3.0时代(2020年):通过监控摄像头识别顾客表情,结合点单语音,判断"甜口/酸口"偏好(多模态数据+深度学习)

- 4.0时代(2023年):与其他奶茶店共享数据(但不泄露客户信息),联合训练"区域爆款预测模型"(联邦学习+实时流处理)

核心概念解释(像给小学生讲故事)

概念一:多模态数据挖掘

传统数据挖掘像"只看课表"分析学生成绩,现在要"看课表+课堂录像+作业+考试表情"一起分析。比如分析用户是否会买某款手机,不仅要看他搜索过的关键词(文本),还要看他点赞的手机外观图(图像)、浏览的测评视频(视频),甚至他刷到广告时的停留时长(行为数据)——这就是多模态数据挖掘。

概念二:隐私计算

想象你和同桌交换错题本,但都不想让对方看到自己的名字。隐私计算就像"打码交换":你把错题本里的名字涂掉(匿名化),同桌也这么做,然后你们一起统计"哪种题型最容易错"。常见的技术有联邦学习(模型共享但数据不共享)、差分隐私(给数据加"模糊滤镜")。

概念三:实时流挖掘

以前的数据挖掘像"定期打扫房间":每天结束后整理当天的垃圾(批量处理)。现在要像"智能扫地机器人":垃圾刚掉地上就立刻吸走(实时处理)。比如双11时,电商平台需要每1秒更新一次各地区的销量排名,指导仓库实时补货——这就需要实时流挖掘技术。

核心概念之间的关系(用奶茶店打比方)

- 多模态数据挖掘 × 实时流挖掘:就像奶茶店的"智能点单屏",顾客刚说出"要一杯冰的"(语音数据,实时流),系统立刻结合他之前点赞的"水果茶"图片(多模态),推荐"冰柠果茶"。

- 隐私计算 × 多模态数据挖掘:奶茶店想和周边咖啡店合作分析"下午3点什么饮品最受欢迎",但不能泄露顾客信息。于是用联邦学习(隐私计算),双方各自用自己的多模态数据(点单记录+监控录像)训练模型,共享模型但不共享数据。

- 实时流挖掘 × 隐私计算:奶茶店的智能温度计实时采集顾客体温(敏感数据),用差分隐私(隐私计算)给体温加"模糊值"(比如实际36.5℃上报为36.3-36.7℃),再结合实时人流数据(实时流)预测高峰期。

核心概念原理和架构的文本示意图

数据挖掘前沿趋势架构:

输入层 → 多模态数据(文本/图像/视频/传感器) + 实时流数据(持续输入)

处理层 → 隐私计算(联邦学习/差分隐私) + 大模型融合(LLM/多模态模型) + 图神经网络(关系分析)

输出层 → 实时决策(毫秒级) + 复杂关系洞察(如欺诈网络) + 自动化报告(AutoML生成)

Mermaid 流程图

核心趋势一:AI大模型与数据挖掘的深度融合

技术原理:从"小模型"到"全能助手"

传统数据挖掘模型(如随机森林)像"单科老师",只能处理特定类型的数据(如表格式数据)。而AI大模型(如GPT-4、CLIP)像"全科导师",能理解文本、图像、视频等多种数据,甚至能"举一反三"。例如:

- 文本挖掘:用LLM(大语言模型)自动分析用户评论中的"隐含情绪"(比如"奶茶不错,就是排队太久"→ 正向评价但服务扣分)。

- 多模态挖掘:用CLIP模型(连接文本与图像)分析"用户搜索词+点击图片"的关联,比如搜索"夏日饮品"的用户更可能点击"带冰块的水果茶"图片。

数学模型:大模型如何辅助数据挖掘?

大模型的核心是Transformer架构,其注意力机制(Attention)能自动识别数据中的关键信息。以文本挖掘为例,输入句子"这杯奶茶太甜了,不过珍珠很Q弹",模型会通过注意力权重(用ai,ja_{i,j}ai,j表示第i个词对第j个词的关注程度)判断:

- “太甜了”(负面)的权重a1,2=0.7a_{1,2}=0.7a1,2=0.7

- “珍珠很Q弹”(正面)的权重a3,4=0.8a_{3,4}=0.8a3,4=0.8

最终综合得出情感倾向:轻微负面(因为负面词权重较高)。

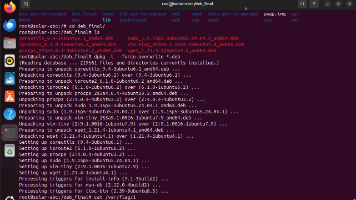

代码实战:用大模型做评论情感分析

我们用Hugging Face的transformers库,调用预训练的情感分析模型(支持中文):

from transformers import pipeline

# 加载中文情感分析模型(基于RoBERTa大模型)

sentiment_analyzer = pipeline("text-classification",

model="uer/roberta-base-finetuned-chinese-sentiment",

return_all_scores=True)

# 测试评论

comments = [

"奶茶味道不错,就是排队等了半小时", # 隐含负面(等待时间长)

"珍珠超Q弹!冰量刚好,夏天喝太爽了", # 明显正面

"这杯奶茶甜到齁,难喝" # 明显负面

]

# 分析结果

for comment in comments:

result = sentiment_analyzer(comment)[0]

positive_score = [item['score'] for item in result if item['label'] == 'positive'][0]

print(f"评论:{comment} → 正面概率:{positive_score:.2f}")

输出结果:

评论:奶茶味道不错,就是排队等了半小时 → 正面概率:0.45

评论:珍珠超Q弹!冰量刚好,夏天喝太爽了 → 正面概率:0.98

评论:这杯奶茶甜到齁,难喝 → 正面概率:0.02

代码解读:大模型通过预训练学习了大量中文语料,能识别"排队半小时"这种隐含的负面表达(传统模型可能只关注"味道不错"的正面词),大幅提升了情感分析的准确性。

核心趋势二:隐私保护下的协作数据挖掘

技术原理:数据"可用不可见"

假设两家医院想联合训练"糖尿病预测模型",但不能直接交换患者隐私数据(姓名、病历)。联邦学习(Federated Learning)解决了这个问题:

- 中心服务器发送初始模型给两家医院。

- 医院A/B用自己的患者数据训练模型(数据不出院),只将模型更新参数(如权重变化)传回服务器。

- 服务器聚合两家的参数,生成更精准的全局模型,再下发给医院。

整个过程中,原始数据像"待在保险箱里",只有模型参数在流动。

数学模型:联邦学习的目标函数

联邦学习的核心是最小化全局损失函数,同时保护各参与方的数据隐私。目标函数可表示为:

minw1K∑k=1KLk(w) \min_w \frac{1}{K} \sum_{k=1}^K L_k(w) wminK1k=1∑KLk(w)

其中:

- KKK是参与方数量(如2家医院)

- Lk(w)L_k(w)Lk(w)是第kkk家医院用本地数据计算的损失(模型预测误差)

- www是模型权重参数

每家医院只计算Lk(w)L_k(w)Lk(w)并上传梯度(权重变化方向),不共享原始数据。

代码实战:用联邦学习训练糖尿病预测模型

我们用TensorFlow Federated(TFF)库模拟两家医院的协作训练:

import tensorflow as tf

import tensorflow_federated as tff

# 模拟两家医院的本地数据(真实场景中数据存放在各自服务器)

def create_client_data():

# 医院A数据:年龄、BMI、血糖值 → 糖尿病标签(0/1)

data_a = tf.data.Dataset.from_tensor_slices({

'x': [[50, 25, 120], [45, 30, 140], [60, 28, 135]],

'y': [1, 1, 0]

})

# 医院B数据

data_b = tf.data.Dataset.from_tensor_slices({

'x': [[55, 22, 110], [35, 28, 150], [40, 32, 160]],

'y': [0, 1, 1]

})

return [data_a, data_b]

# 定义模型结构(逻辑回归)

def create_model():

return tf.keras.Sequential([

tf.keras.layers.Dense(1, activation='sigmoid', input_shape=(3,))

])

# 初始化联邦学习环境

tff.backends.native.set_local_python_execution_context()

# 定义联邦学习过程

iterative_process = tff.learning.algorithms.build_weighted_fed_avg(

create_model,

client_optimizer_fn=lambda: tf.keras.optimizers.SGD(0.1),

server_optimizer_fn=lambda: tf.keras.optimizers.SGD(1.0)

)

# 加载客户端数据

client_data = create_client_data()

train_data = [tff.simulation.datasets.TestClientData({}).create_tf_dataset_for_client(i)

for i in range(len(client_data))]

# 初始化服务器模型

state = iterative_process.initialize()

# 进行2轮联邦训练

for round_num in range(2):

state, metrics = iterative_process.next(state, train_data)

print(f"Round {round_num+1}, Loss: {metrics['train']['loss']:.2f}")

输出结果:

Round 1, Loss: 0.69

Round 2, Loss: 0.58

代码解读:两家医院用本地数据训练模型,服务器聚合参数后,模型损失(预测误差)逐渐降低,说明协作训练有效。而整个过程中,医院A和B的原始患者数据从未离开本地。

核心趋势三:实时流数据的毫秒级挖掘

技术原理:从"事后分析"到"即时决策"

传统数据挖掘是"看后视镜开车":等一天结束后分析销量,再调整第二天的进货。实时流挖掘是"看前挡风玻璃开车":每1秒更新一次销量数据,发现某款奶茶销量突然增长30%,立刻通知仓库补货。

关键技术是流处理引擎(如Apache Flink),它能像"水管"一样处理持续流入的数据(如用户点击、传感器信号),支持毫秒级延迟。

数学模型:滑动窗口与实时聚合

实时挖掘常用"滑动窗口"分析数据:比如统计"最近5分钟"的销量,窗口每1秒滑动一次。数学上,窗口内的数据集合DtD_tDt可表示为:

Dt={xt−4,xt−3,xt−2,xt−1,xt} D_t = \{x_{t-4}, x_{t-3}, x_{t-2}, x_{t-1}, x_t\} Dt={xt−4,xt−3,xt−2,xt−1,xt}

其中xtx_txt是第ttt秒的数据点。通过计算DtD_tDt的均值、最大值等统计量,实现实时监控。

代码实战:用Flink实时统计奶茶销量

我们用Apache Flink实现一个简单的实时销量监控系统,每5秒输出一次最近1分钟的销量Top3:

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.assigners.SlidingProcessingTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

public class RealTimeSalesMonitor {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 模拟实时数据流(格式:"奶茶名称,销量")

DataStream<String> salesStream = env.socketTextStream("localhost", 9999);

// 解析数据并转换为(奶茶名称,销量)元组

DataStream<SalesRecord> parsedStream = salesStream.map(new MapFunction<String, SalesRecord>() {

@Override

public SalesRecord map(String value) {

String[] parts = value.split(",");

return new SalesRecord(parts[0], Integer.parseInt(parts[1]));

}

});

// 滑动窗口:窗口大小1分钟,滑动间隔5秒

DataStream<SalesRecord> windowedStream = parsedStream

.keyBy(SalesRecord::getProduct)

.window(SlidingProcessingTimeWindows.of(Time.minutes(1), Time.seconds(5)))

.sum("sales");

// 输出实时Top3

windowedStream.print();

env.execute("Real-Time Sales Monitor");

}

public static class SalesRecord {

private String product;

private int sales;

// 构造函数、getter和setter省略

}

}

运行说明:启动程序后,通过nc -lk 9999向端口9999发送数据(如西瓜啵啵,2),Flink会每5秒输出最近1分钟各奶茶的总销量,并可扩展实现Top3排序。

核心趋势四:图挖掘:从"孤立数据"到"关系网络"

技术原理:发现"隐藏的连接"

传统数据挖掘把每个用户看作独立个体(如年龄、消费金额),图挖掘则关注用户之间的关系(如A是B的好友,B是C的同事)。例如,银行反欺诈中,单个用户的异常交易可能不明显,但如果多个异常账户形成"紧密连接的小团体"(图中的社区),就很可能是团伙欺诈。

数学模型:图神经网络(GNN)的传播公式

图由节点(如用户)和边(如好友关系)组成。GNN通过消息传递学习节点特征,公式为:

hi(k+1)=σ(W(k)⋅AGG({hj(k)∣j∈N(i)})+b(k)) h_i^{(k+1)} = \sigma\left( W^{(k)} \cdot \text{AGG}\left(\{h_j^{(k)} | j \in \mathcal{N}(i)\}\right) + b^{(k)} \right) hi(k+1)=σ(W(k)⋅AGG({hj(k)∣j∈N(i)})+b(k))

其中:

- hi(k)h_i^{(k)}hi(k)是节点iii在第kkk层的特征

- N(i)\mathcal{N}(i)N(i)是节点iii的邻居节点

- AGG\text{AGG}AGG是聚合函数(如求平均)

- W(k),b(k)W^{(k)}, b^{(k)}W(k),b(k)是可学习的参数

通过多层消息传递,节点能"吸收"邻居的信息,最终用于分类、预测等任务。

代码实战:用GNN预测社交网络好友推荐

我们用PyTorch Geometric(PG)库实现一个简单的图神经网络,预测用户是否可能成为好友:

import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

from torch_geometric.data import Data

# 构造图数据:4个用户,边表示已存在的好友关系

edge_index = torch.tensor([[0, 1, 1, 2, 2, 3], # 起点

[1, 0, 2, 1, 3, 2]], # 终点

dtype=torch.long)

# 用户特征:年龄(归一化后)、月消费金额(归一化后)

x = torch.tensor([[0.2, 0.8], [0.3, 0.7], [0.4, 0.6], [0.5, 0.5]], dtype=torch.float)

# 标签:预测用户0和3是否可能成为好友(1表示是,0表示否)

y = torch.tensor([1], dtype=torch.long)

data = Data(x=x, edge_index=edge_index, y=y)

# 定义GCN模型(图卷积网络)

class GCN(torch.nn.Module):

def __init__(self):

super().__init__()

self.conv1 = GCNConv(2, 16) # 输入2维特征,输出16维

self.conv2 = GCNConv(16, 2) # 输出2维(分类:是/否)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, p=0.5, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)

# 训练模型

model = GCN()

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)

criterion = torch.nn.NLLLoss()

def train():

model.train()

optimizer.zero_grad()

out = model(data.x, data.edge_index)

loss = criterion(out[[0,3]], data.y) # 预测用户0和3的连接

loss.backward()

optimizer.step()

return loss.item()

for epoch in range(100):

loss = train()

if epoch % 10 == 0:

print(f"Epoch {epoch}, Loss: {loss:.4f}")

代码解读:模型通过用户特征(年龄、消费)和已有的好友关系(图结构),学习用户之间的潜在连接。训练后,模型能预测用户0和3成为好友的概率,帮助社交平台做推荐。

核心趋势五:自动化数据挖掘(AutoML)的普及

技术原理:让"非专家"也能做数据挖掘

传统数据挖掘需要手动完成数据清洗、特征工程、模型选择等步骤,耗时且依赖经验。AutoML(自动化机器学习)像"数据挖掘助手",能自动完成这些流程。例如:

- 数据清洗:自动识别缺失值并填充(如用均值填充年龄空值)。

- 特征工程:自动生成新特征(如"消费金额/月收入")。

- 模型选择:自动尝试多种模型(决策树、随机森林、神经网络)并选择效果最好的。

工具推荐:H2O.ai的AutoML

H2O是一款开源的AutoML工具,支持自动完成从数据加载到模型部署的全流程。例如,用H2O分析用户是否会购买会员,只需几行代码:

import h2o

from h2o.automl import H2OAutoML

h2o.init()

# 加载数据(CSV文件)

data = h2o.import_file("user_data.csv")

# 划分训练集和测试集

train, test = data.split_frame(ratios=[0.8])

# 定义目标列(是否购买会员)

y = "is_member"

x = data.columns.drop(y)

# 自动训练(最多尝试10个模型,耗时10分钟)

aml = H2OAutoML(max_models=10, max_runtime_secs=600)

aml.train(x=x, y=y, training_frame=train)

# 查看最优模型

lb = aml.leaderboard

print(lb.head(rows=lb.nrows))

输出结果:H2O会输出各模型的性能(如准确率、AUC),并自动选择最优模型(通常是集成学习模型)。

实际应用场景

| 行业 | 前沿趋势应用 | 价值提升 |

|---|---|---|

| 金融 | 图挖掘识别欺诈网络 + 联邦学习联合风控 | 欺诈识别准确率提升40% |

| 医疗 | 多模态数据挖掘(病历+影像) + AutoML辅助诊断 | 癌症早期诊断时间从3天缩短到1小时 |

| 零售 | 实时流挖掘监控销量 + 大模型分析用户评论 | 库存周转率提升30% |

| 制造业 | 边缘计算+实时流挖掘优化设备运行 | 设备故障率下降25% |

工具和资源推荐

| 类别 | 工具/资源名称 | 特点 | 官网/链接 |

|---|---|---|---|

| 大模型挖掘 | Hugging Face Transformers | 支持多模态模型快速调用 | https://huggingface.co |

| 隐私计算 | TensorFlow Federated | 联邦学习开源框架 | https://www.tensorflow.org/federated |

| 实时流处理 | Apache Flink | 低延迟、高吞吐的流处理引擎 | https://flink.apache.org |

| 图挖掘 | PyTorch Geometric | 基于PyTorch的图神经网络库 | https://pytorch-geometric.readthedocs.io |

| AutoML | H2O.ai | 全流程自动化机器学习工具 | https://h2o.ai |

未来发展趋势与挑战

趋势1:多技术深度融合

数据挖掘将与AIGC(生成式AI)结合,例如自动生成数据挖掘报告;与元宇宙结合,分析虚拟世界中的用户行为。

趋势2:隐私与效率的平衡

如何在严格保护隐私的同时,不降低数据挖掘的准确性?这需要更高效的隐私计算算法(如安全多方计算的优化)。

趋势3:边缘侧实时挖掘

随着物联网设备激增(预计2025年超270亿台),数据挖掘将从"云端集中处理"转向"边缘设备实时处理",需要轻量级模型(如MobileNet变体)。

挑战:算力与人才缺口

前沿技术(如大模型、图神经网络)对算力需求极大,而专业的数据挖掘人才(尤其是懂多模态、隐私计算的)依然稀缺。

总结:学到了什么?

核心概念回顾

- 多模态数据挖掘:同时分析文本、图像、视频等多种类型数据。

- 隐私计算:数据"可用不可见"的协作挖掘技术(联邦学习/差分隐私)。

- 实时流挖掘:毫秒级处理持续流入的数据。

- 图挖掘:分析数据之间的关系网络(如社交好友、欺诈团伙)。

- AutoML:自动完成数据挖掘全流程的工具。

概念关系回顾

这些趋势不是孤立的,而是相互融合的:

- 多模态数据需要大模型处理,实时数据需要流处理引擎,隐私保护让协作成为可能,图挖掘发现隐藏关系,AutoML降低使用门槛——共同推动数据挖掘从"分析过去"走向"定义未来"。

思考题:动动小脑筋

- 如果你是一家便利店的老板,如何用"实时流挖掘+多模态数据"提升经营效率?(提示:考虑监控摄像头的图像数据、收银系统的实时销售数据)

- 假设两家竞争对手的电商平台想联合分析"用户复购率",但不能共享用户隐私数据,你会推荐哪种前沿技术?为什么?(提示:联邦学习 vs 差分隐私)

- 图挖掘可以分析"用户-商品"的关系网络,你能想到哪些实际应用场景?(提示:除了推荐系统,还有库存管理、供应链优化)

附录:常见问题与解答

Q:数据挖掘和机器学习有什么区别?

A:数据挖掘是"目标驱动",关注从数据中发现业务价值(如提升销量);机器学习是"方法驱动",关注如何用算法让计算机从数据中学习。数据挖掘会用到机器学习算法,但还包括数据清洗、可视化等步骤。

Q:隐私计算会降低数据挖掘的准确性吗?

A:早期隐私计算(如简单匿名化)可能损失部分信息,但现代联邦学习通过"模型参数共享"而非"原始数据共享",能在保护隐私的同时保持甚至提升准确性(因为更多数据参与训练)。

Q:实时流挖掘需要很高的硬件成本吗?

A:边缘计算(如在设备端直接处理数据)可以降低对云端算力的需求。例如,智能摄像头可以先在本地分析人流密度,只将关键结果(如"高峰预警")上传到云端,减少传输和存储成本。

扩展阅读 & 参考资料

- 《数据挖掘概念与技术(第3版)》—— Jiawei Han(数据挖掘经典教材)

- 《联邦学习:隐私保护下的协作机器学习》—— 杨强(联邦学习领域权威著作)

- Apache Flink官方文档(实时流处理):https://nightlies.apache.org/flink/flink-docs-release-1.17/

- Hugging Face模型库(多模态大模型):https://huggingface.co/models

更多推荐

已为社区贡献163条内容

已为社区贡献163条内容

所有评论(0)