【Eino & 大模型应用】核心技术深度解析(原理+实战)

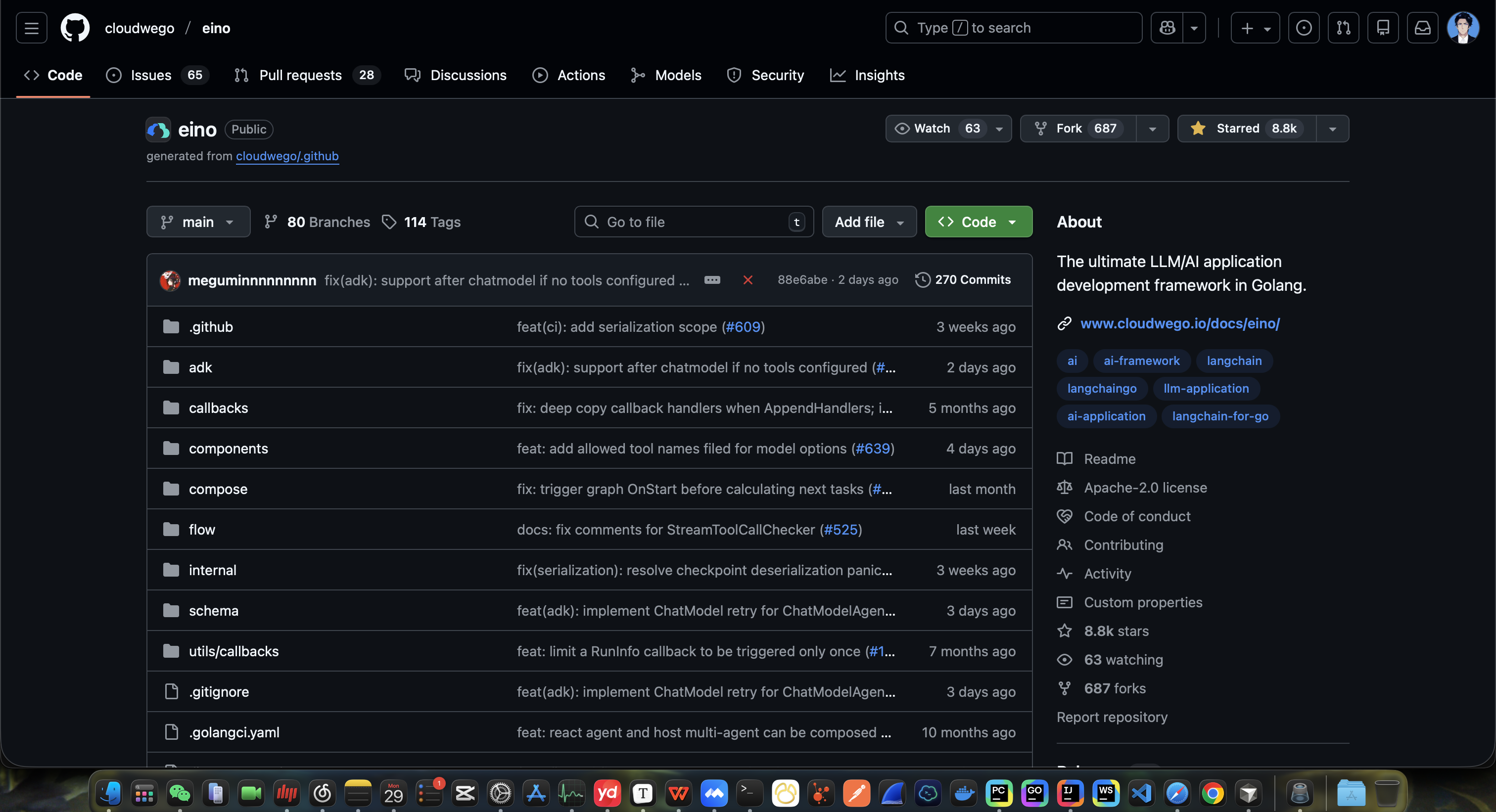

Eino是一款轻量级大模型应用开发框架,采用Go语言开发,核心解决Prompt管理混乱、上下文维护复杂、多模型兼容成本高等痛点。其核心价值包括降低开发门槛、提升开发效率、增强应用稳定性和高可扩展性。相比LangChain和LlamaIndex,Eino更侧重企业级快速落地,具有低学习成本、高性能和插件化优势。Eino采用分层+插件化架构设计,支持多模型无缝兼容、智能Prompt引擎、上下文缓存管理

文章目录

目录

若对您有帮助的话,请点赞收藏加关注哦,您的关注是我持续创作的动力!有问题请私信或联系邮箱:funian.gm@gmail.com

导读:Eino 是一款专注于大模型应用快速落地的轻量级、高性能、插件化开发框架,核心解决大模型应用开发中的「Prompt 管理混乱、上下文维护复杂、多模型兼容成本高、扩展能力弱」等痛点。而大模型应用作为人工智能技术落地的核心载体,已广泛渗透到智能客服、内容创作、代码生成、知识库问答等诸多场景。本文从 Eino 核心原理、大模型应用底层技术、Eino+大模型实战开发、企业级落地最佳实践四个维度,全方位深度解析相关技术栈。

一、前置认知:Eino与大模型应用的核心关系

1.1 Eino核心定位与核心价值

Eino 并非大模型本身,而是大模型应用的「开发脚手架」与「中间件」,由国内技术团队打造,采用 Go 语言开发(部分组件支持 Python 适配),核心定位是「让大模型应用开发更简单、更高效、更稳定」。其核心价值体现在:

- 降低开发门槛:封装大模型调用、Prompt 管理、上下文维护等重复工作,开发者无需关注底层细节,专注业务逻辑;

- 提升开发效率:内置丰富的预置模板、插件与工具类,支持一键初始化项目,大幅缩短开发周期;

- 增强应用稳定性:提供请求限流、失败重试、上下文缓存、监控告警等企业级特性,解决大模型应用落地的稳定性问题;

- 高可扩展性:插件化架构设计,支持自定义插件、多模型无缝切换、私有大模型快速接入。

1.2 Eino与主流大模型开发工具对比(企业选型必看)

目前主流大模型开发工具包括 LangChain、LlamaIndex、Eino 等,三者定位不同,核心差异如下表所示,便于企业快速选型:

| 对比维度 | Eino | LangChain | LlamaIndex |

|---|---|---|---|

| 核心定位 | 轻量级大模型应用开发框架(一站式落地) | 大模型应用编排框架(灵活扩展) | 大模型知识库检索框架(专注数据接入) |

| 开发语言 | 核心Go语言,支持Python适配 | 主打Python,支持JS/TS等 | 主打Python,支持少量其他语言 |

| 学习成本 | 低(API简洁、文档完善、中文支持) | 中高(概念繁多、配置复杂、英文文档为主) | 中(专注检索场景,功能相对单一) |

| 核心优势 | 高性能、低资源占用、插件化、企业级特性丰富 | 生态完善、灵活度高、支持多场景定制 | 知识库检索能力强、数据接入方式丰富 |

| 部署成本 | 低(静态编译、单文件部署、资源占用低) | 中高(依赖繁多、Python环境部署复杂) | 中(依赖Python环境,需额外配置检索引擎) |

| 适用场景 | 中小微企业大模型应用快速落地、高性能生产环境、私有部署场景 | 大型企业定制化大模型应用、科研场景、多工具集成场景 | 企业知识库问答、文档解析、检索增强生成(RAG)场景 |

1.3 大模型应用的核心分层架构

所有大模型应用无论复杂程度如何,均遵循统一的分层架构,Eino 框架也基于该架构进行封装,各层职责清晰:

| 分层名称 | 核心作用 | 核心组件/技术 | Eino支持方式 |

|---|---|---|---|

| 前端交互层 | 提供用户操作入口,展示大模型输出结果 | Web页面、APP、CLI工具、API网关 | 无需关注(可对接Eino的API服务) |

| 应用服务层 | 核心业务逻辑处理,协调各组件工作 | 业务流程编排、权限控制、参数校验 | 内置应用脚手架、控制器、服务层封装 |

| 大模型核心层 | 大模型调用、Prompt管理、上下文维护 | Prompt工程、上下文管理器、模型适配层 | 内置Prompt引擎、多模型适配、上下文智能缓存 |

| 数据支撑层 | 提供数据存储与检索能力 | 知识库、缓存、数据库、向量数据库 | 内置数据接入插件、向量数据库适配、缓存管理 |

| 基础设施层 | 提供部署与运维支撑 | 服务器、容器、监控、日志 | 内置监控告警、日志组件、支持Docker/K8s部署 |

二、Eino核心技术深度解析(原理+组件+实战)

2.1 Eino核心架构设计

Eino 采用「分层+插件化」架构设计,兼顾高性能与可扩展性,从上到下分为四层,各层解耦,便于维护与扩展:

- 应用层:提供项目入口、业务逻辑编排能力,包括 CLI 工具、API 服务、控制器等,开发者主要在该层进行业务开发;

- 核心层:Eino 的核心能力封装层,包括 Prompt 引擎、上下文管理器、模型调用中心、插件管理器,是 Eino 的核心竞争力所在;

- 适配层:负责对接外部资源,包括大模型适配(OpenAI、智谱AI、文心一言等)、数据存储适配(MySQL、Redis、Milvus等)、第三方工具适配(OCR、语音转文字等);

- 基础层:提供底层支撑能力,包括日志管理、监控告警、配置管理、限流重试等,保障应用的稳定性与可运维性。

2.2 Eino核心特性深度解析

2.2.1 多模型无缝兼容

Eino 内置主流大模型的适配层,无需修改业务代码,仅通过配置即可切换大模型,支持公有大模型与私有大模型:

- 公有大模型:OpenAI(GPT-3.5/GPT-4)、智谱AI(GLM-3/GLM-4)、文心一言(ERNIE 3.0/4.0)、通义千问(Qwen-7B/Qwen-14B)等;

- 私有大模型:Llama 2、Qwen、Baichuan 等本地部署模型,支持通过 API 或本地调用方式接入;

- 核心优势:统一的模型调用 API,屏蔽不同大模型的接口差异,降低多模型切换成本。

2.2.2 Prompt 引擎(核心组件)

Prompt 是大模型应用的「灵魂」,Eino 的 Prompt 引擎解决了传统 Prompt 管理混乱、复用性低、优化困难的痛点,核心特性包括:

- 模板化管理:支持 Prompt 模板定义、参数化渲染,可将通用 Prompt 封装为模板,通过传入参数快速复用;

- 版本控制:支持 Prompt 模板版本管理,便于追踪 Prompt 变更记录,回滚最优版本;

- 分类管理:支持按业务场景对 Prompt 模板进行分类,便于查找与维护;

- 动态优化:支持基于应用反馈动态调整 Prompt 模板,提升大模型输出质量。

2.2.3 上下文智能缓存与管理

大模型对话应用中,上下文维护是核心痛点(上下文过长导致成本升高、响应变慢、信息丢失),Eino 的上下文管理器提供一站式解决方案:

- 智能缓存:支持按用户 ID、对话 ID 缓存上下文,可配置缓存过期时间与最大长度,降低重复调用成本;

- 上下文压缩:内置摘要压缩算法,对超长上下文进行自动摘要,保留核心信息,减少 token 消耗;

- 上下文裁剪:支持按 token 数量或对话轮数进行裁剪,避免超出大模型上下文窗口限制;

- 多对话隔离:支持多用户、多对话的上下文隔离,避免数据混淆。

2.2.4 插件化扩展架构

Eino 采用插件化设计,所有非核心功能均以插件形式提供,支持自定义插件开发,核心插件类型包括:

- 模型插件:对接新的大模型;

- 数据插件:对接新的存储介质(向量数据库、数据库等);

- 业务插件:实现特定业务功能(OCR、语音转文字、文档解析等);

- 运维插件:实现监控、日志、告警等运维功能;

- 核心优势:按需加载插件,降低应用体积,提升扩展性,便于团队协作开发。

2.3 Eino核心组件实战(附代码)

2.3.1 环境准备:Eino安装与项目初始化

# 1. 安装Eino CLI工具(Go环境必备)

go install github.com/eino-io/eino/v2/cmd/eino@latest

# 2. 验证安装

eino -v

# 3. 初始化Eino项目(支持Python/Go,此处以Go为例)

eino init eino-llm-demo --lang go

cd eino-llm-demo

# 4. 安装项目依赖

go mod tidy

# 5. 配置大模型密钥(修改config/config.yaml)

# 以OpenAI为例

model:

type: "openai"

openai:

api_key: "你的OpenAI API Key"

model_name: "gpt-3.5-turbo"

base_url: "https://api.openai.com/v1"

2.3.2 Prompt 引擎实战:模板定义与渲染

// main.go

package main

import (

"fmt"

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/prompt"

)

func main() {

// 1. 初始化Eino

app := e.NewEino()

// 2. 定义Prompt模板(参数化:{{.Task}}、{{.Content}})

template := `

你是一名专业的{{.Task}},请根据以下内容进行处理:

{{.Content}}

要求:

1. 内容简洁,逻辑清晰;

2. 符合中文表达习惯;

3. 无冗余信息,直击要点。

`

// 3. 注册Prompt模板

err := app.Prompt().RegisterTemplate("business_processor", template)

if err != nil {

fmt.Printf("注册Prompt模板失败:%v\n", err)

return

}

// 4. 渲染Prompt模板(传入参数)

renderedPrompt, err := app.Prompt().RenderTemplate("business_processor", map[string]interface{}{

"Task": "文案润色师",

"Content": "我觉得这个产品很好用,它能帮我快速完成工作,提高效率",

})

if err != nil {

fmt.Printf("渲染Prompt模板失败:%v\n", err)

return

}

fmt.Printf("渲染后的Prompt:\n%s\n", renderedPrompt)

}

运行结果:

渲染后的Prompt:

你是一名专业的文案润色师,请根据以下内容进行处理:

我觉得这个产品很好用,它能帮我快速完成工作,提高效率

要求:

1. 内容简洁,逻辑清晰;

2. 符合中文表达习惯;

3. 无冗余信息,直击要点。

2.3.3 上下文管理器实战:对话上下文维护

// main.go

package main

import (

"fmt"

"time"

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/context"

)

func main() {

// 1. 初始化Eino

app := e.NewEino()

// 2. 初始化上下文管理器(配置缓存过期时间1小时,最大对话轮数10)

cm := app.ContextManager()

cm.SetConfig(&context.Config{

ExpireTime: 1 * time.Hour,

MaxTurns: 10,

})

// 3. 模拟用户对话(用户ID:user_001,对话ID:chat_001)

userId := "user_001"

chatId := "chat_001"

// 第一轮对话

userMsg1 := "你好,我想了解Eino框架"

assistantMsg1 := "Eino是一款轻量级大模型应用开发框架,专注于快速落地大模型应用。"

// 添加上下文

err := cm.AddMessage(userId, chatId, &context.Message{

Role: "user",

Content: userMsg1,

Time: time.Now(),

})

if err != nil {

fmt.Printf("添加用户消息失败:%v\n", err)

return

}

err = cm.AddMessage(userId, chatId, &context.Message{

Role: "assistant",

Content: assistantMsg1,

Time: time.Now(),

})

if err != nil {

fmt.Printf("添加助手消息失败:%v\n", err)

return

}

// 第二轮对话

userMsg2 := "它和LangChain相比有什么优势?"

// 获取上下文

contextMsgs, err := cm.GetContext(userId, chatId)

if err != nil {

fmt.Printf("获取上下文失败:%v\n", err)

return

}

// 打印上下文

fmt.Println("当前对话上下文:")

for i, msg := range contextMsgs {

fmt.Printf("第%d轮:%s:%s\n", i+1, msg.Role, msg.Content)

}

// 添加第二轮用户消息

err = cm.AddMessage(userId, chatId, &context.Message{

Role: "user",

Content: userMsg2,

Time: time.Now(),

})

if err != nil {

fmt.Printf("添加第二轮用户消息失败:%v\n", err)

return

}

// 打印更新后的上下文

fmt.Println("\n更新后的对话上下文:")

contextMsgs2, _ := cm.GetContext(userId, chatId)

for i, msg := range contextMsgs2 {

fmt.Printf("第%d轮:%s:%s\n", i+1, msg.Role, msg.Content)

}

}

2.3.4 大模型调用实战:统一API调用

// main.go

package main

import (

"fmt"

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/model"

)

func main() {

// 1. 初始化Eino

app := e.NewEino()

// 2. 构建模型请求

req := &model.ChatRequest{

UserId: "user_001",

ChatId: "chat_001",

Messages: []*model.Message{

{

Role: "user",

Content: "用一句话介绍Eino框架",

},

},

ModelName: "gpt-3.5-turbo",

MaxTokens: 100,

Temperature: 0.7,

}

// 3. 调用大模型

resp, err := app.Model().Chat(req)

if err != nil {

fmt.Printf("调用大模型失败:%v\n", err)

return

}

// 4. 打印结果

fmt.Printf("大模型响应:%s\n", resp.Content)

fmt.Printf("消耗Token:%d(输入:%d,输出:%d)\n", resp.Usage.TotalTokens, resp.Usage.PromptTokens, resp.Usage.CompletionTokens)

}

三、大模型应用核心底层原理(通用技术)

3.1 核心技术1:Prompt工程(大模型应用的灵魂)

Prompt 工程是指通过优化提示词,让大模型输出符合预期结果的技术,是大模型应用开发的核心,无需修改大模型参数,即可大幅提升输出质量。

3.1.1 Prompt 核心设计原则(表格总结)

| 原则名称 | 核心要求 | 示例说明 |

|---|---|---|

| 清晰性 | 指令明确、无歧义,避免模糊表述 | 错误:“帮我写一篇文章”;正确:“帮我写一篇关于Eino框架的技术文章,字数500字,结构分3部分:核心优势、核心组件、应用场景” |

| 具体性 | 明确输出格式、内容范围、细节要求 | 错误:“帮我分析这个问题”;正确:“帮我分析以下大模型应用报错原因,要求先列出可能原因,再给出解决方案,最后提供预防措施” |

| 相关性 | 提供足够的背景信息与上下文,确保大模型理解需求 | 错误:“为什么这个代码运行失败?”;正确:“以下是Go语言代码(粘贴代码),运行时报错「xxx」,请分析失败原因并修改代码” |

| 引导性 | 通过示例或步骤引导大模型输出符合预期的结果 | 要求大模型按格式输出:“请按以下格式输出用户信息:姓名:xxx,年龄:xxx,职业:xxx。示例:姓名:张三,年龄:25,职业:工程师” |

3.1.2 Prompt 模板优化实战(前后对比)

| 优化前(效果差) | 优化后(效果优) |

|---|---|

| “帮我写一份产品推广文案” | “你是一名资深产品推广文案撰写师,需为「Eino大模型开发框架」撰写推广文案,要求:1. 面向后端开发者;2. 突出「轻量级、高性能、快速落地」三大优势;3. 语言简洁有吸引力,字数200字以内;4. 结尾附带「立即体验」引导语” |

| “帮我解决这个bug” | “以下是Eino项目的Go语言代码:(粘贴代码),运行时报错「context deadline exceeded」,请完成以下操作:1. 分析报错的核心原因;2. 提供具体的修改方案(粘贴修改后的代码);3. 给出预防同类问题的建议” |

3.2 核心技术2:检索增强生成(RAG)

RAG(Retrieval Augmented Generation)是解决大模型「知识过时、幻觉严重、无法接入私有数据」三大痛点的核心技术,核心流程是「检索私有数据 + 拼接Prompt + 大模型生成」,Eino 内置RAG组件,大幅降低开发成本。

3.2.1 RAG 核心流程(4步走)

- 数据预处理:将私有数据(文档、数据库、API等)进行拆分(按段落/句子拆分为小文本块)、清洗(去除无用信息)、格式化;

- 向量嵌入:将拆分后的文本块通过嵌入模型(如text-embedding-ada-002)转换为向量数据;

- 向量存储:将向量数据存入向量数据库(如Milvus、Chroma、Pinecone);

- 检索与生成:用户提问时,先将问题转换为向量,在向量数据库中检索相似文本块,将相似文本块与问题拼接为Prompt,再调用大模型生成结果。

3.2.2 Eino 中 RAG 实战(简化代码)

// main.go

package main

import (

"fmt"

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/rag"

)

func main() {

// 1. 初始化Eino

app := e.NewEino()

// 2. 初始化RAG组件(配置向量数据库与嵌入模型)

ragEngine := app.RAG()

ragEngine.SetConfig(&rag.Config{

VectorDBType: "milvus",

EmbeddingModel: &rag.EmbeddingConfig{

Type: "openai",

ModelName: "text-embedding-ada-002",

},

})

// 3. 加载私有数据(文档路径)

err := ragEngine.LoadDocument("./docs/eino_user_guide.md")

if err != nil {

fmt.Printf("加载文档失败:%v\n", err)

return

}

// 4. 用户提问

userQuery := "Eino如何实现Prompt模板管理?"

// 5. RAG检索与生成

result, err := ragEngine.Generate(userQuery)

if err != nil {

fmt.Printf("RAG生成失败:%v\n", err)

return

}

// 6. 打印结果

fmt.Printf("用户问题:%s\n", userQuery)

fmt.Printf("RAG生成结果:%s\n", result.Content)

fmt.Printf("参考文档片段:%v\n", result.ReferenceTexts)

}

3.3 核心技术3:大模型应用性能优化

大模型应用落地时,常面临「响应慢、成本高、稳定性差」三大性能瓶颈,对应的优化策略如下表所示:

| 性能瓶颈 | 核心原因 | 优化策略 | Eino支持方式 |

|---|---|---|---|

| 响应慢 | 1. 大模型本身响应延迟高;2. 上下文过长;3. 同步调用阻塞;4. 检索效率低 | 1. 使用缓存(缓存高频查询结果);2. 上下文压缩/裁剪;3. 异步调用;4. 优化向量数据库检索(索引优化) | 1. 内置上下文缓存;2. 支持异步模型调用;3. 内置向量数据库索引优化;4. 支持结果缓存 |

| 成本高 | 1. Token消耗过多(上下文过长、大模型输出冗余);2. 高频调用大模型;3. 使用高价大模型 | 1. 上下文压缩/裁剪;2. 结果缓存;3. 小模型前置过滤(用轻量模型处理简单问题,复杂问题调用大模型);4. Prompt优化(减少冗余输入) | 1. 内置上下文压缩;2. 支持结果缓存;3. 支持多模型分级调用;4. 内置Prompt优化工具 |

| 稳定性差 | 1. 大模型服务不可用;2. 网络波动;3. 上下文溢出;4. 限流封禁 | 1. 失败重试;2. 多模型容灾(主备模型切换);3. 上下文长度限制;4. 限流控制;5. 监控告警 | 1. 内置失败重试机制;2. 支持多模型容灾切换;3. 内置上下文长度限制;4. 内置限流与监控告警 |

四、Eino + 大模型企业级实战(3大核心场景)

4.1 实战1:智能写作助手(文本生成场景)

4.1.1 需求说明

开发一款智能写作助手,支持按用户指定的「写作类型、主题、字数、格式」生成高质量文本,支持多轮对话优化。

4.1.2 核心代码

// internal/controller/write_controller.go

package controller

import (

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/model"

"github.com/eino-io/eino/v2/context"

)

type WriteController struct {

BaseController

}

// Generate 文本生成接口

func (c *WriteController) Generate(r *e.Request) {

// 1. 绑定请求参数

type WriteReq struct {

UserId string `json:"user_id" v:"required#用户ID不能为空"`

ChatId string `json:"chat_id" v:"required#对话ID不能为空"`

WriteType string `json:"write_type" v:"required#写作类型不能为空"`

Topic string `json:"topic" v:"required#写作主题不能为空"`

WordCount int `json:"word_count" v:"required#字数要求不能为空"`

Format string `json:"format" v:"required#格式要求不能为空"`

}

var req WriteReq

if err := r.Parse(&req); err != nil {

r.Json(e.Error(10001, err.Error()))

return

}

// 2. 构建Prompt模板参数

promptParams := map[string]interface{}{

"WriteType": req.WriteType,

"Topic": req.Topic,

"WordCount": req.WordCount,

"Format": req.Format,

}

// 3. 渲染Prompt模板

renderedPrompt, err := e.App().Prompt().RenderTemplate("write_assistant", promptParams)

if err != nil {

r.Json(e.Error(10002, "渲染Prompt模板失败"))

return

}

// 4. 获取上下文

contextMsgs, err := e.App().ContextManager().GetContext(req.UserId, req.ChatId)

if err != nil {

r.Json(e.Error(10003, "获取上下文失败"))

return

}

// 5. 构建模型请求

modelReq := &model.ChatRequest{

UserId: req.UserId,

ChatId: req.ChatId,

Messages: append(contextMsgs, &model.Message{

Role: "user",

Content: renderedPrompt,

}),

ModelName: "gpt-3.5-turbo",

MaxTokens: 2000,

Temperature: 0.7,

}

// 6. 调用大模型

resp, err := e.App().Model().Chat(modelReq)

if err != nil {

r.Json(e.Error(10004, "调用大模型失败"))

return

}

// 7. 保存上下文

e.App().ContextManager().AddMessage(req.UserId, req.ChatId, &context.Message{

Role: "user",

Content: renderedPrompt,

})

e.App().ContextManager().AddMessage(req.UserId, req.ChatId, &context.Message{

Role: "assistant",

Content: resp.Content,

})

// 8. 返回结果

r.Json(e.Success(e.Map{

"content": resp.Content,

"token_usage": e.Map{

"total": resp.Usage.TotalTokens,

"input": resp.Usage.PromptTokens,

"output": resp.Usage.CompletionTokens,

},

}))

}

4.2 实战2:企业知识库问答(RAG场景)

4.2.1 需求说明

开发一款企业知识库问答系统,支持上传企业文档(PDF/Word/Markdown),用户可通过自然语言查询文档内容,大模型基于文档内容进行回答,避免幻觉。

4.2.2 核心代码

// internal/controller/knowledge_controller.go

package controller

import (

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/rag"

)

type KnowledgeController struct {

BaseController

}

// UploadDocument 上传文档

func (c *KnowledgeController) UploadDocument(r *e.Request) {

// 1. 获取上传文件

file, fileHeader, err := r.FormFile("document")

if err != nil {

r.Json(e.Error(10001, "获取上传文件失败"))

return

}

defer file.Close()

// 2. 加载文档到RAG引擎

err = e.App().RAG().LoadDocumentFromReader(file, fileHeader.Filename)

if err != nil {

r.Json(e.Error(10002, "加载文档失败"))

return

}

r.Json(e.Success("文档上传成功"))

}

// Query 知识库查询

func (c *KnowledgeController) Query(r *e.Request) {

// 1. 绑定请求参数

type KnowledgeReq struct {

UserId string `json:"user_id" v:"required#用户ID不能为空"`

Query string `json:"query" v:"required#查询内容不能为空"`

}

var req KnowledgeReq

if err := r.Parse(&req); err != nil {

r.Json(e.Error(10003, err.Error()))

return

}

// 2. RAG检索与生成

ragResp, err := e.App().RAG().Generate(req.Query)

if err != nil {

r.Json(e.Error(10004, "知识库查询失败"))

return

}

// 3. 返回结果

r.Json(e.Success(e.Map{

"answer": ragResp.Content,

"references": ragResp.ReferenceTexts,

}))

}

4.3 实战3:多模态图片解析(文本+图片场景)

4.3.1 需求说明

开发一款多模态应用,支持用户上传图片并附带文本问题,大模型基于图片内容与文本问题进行回答(如图片内容描述、图片中的文字识别、图片分析等)。

4.3.2 核心代码

// internal/controller/multimodal_controller.go

package controller

import (

"bytes"

"base64"

"github.com/eino-io/eino/v2/frame/e"

"github.com/eino-io/eino/v2/model"

)

type MultimodalController struct {

BaseController

}

// ImageAnalysis 图片解析

func (c *MultimodalController) ImageAnalysis(r *e.Request) {

// 1. 获取上传图片与文本问题

file, _, err := r.FormFile("image")

if err != nil {

r.Json(e.Error(10001, "获取图片失败"))

return

}

defer file.Close()

query := r.Form.Get("query")

if query == "" {

r.Json(e.Error(10002, "查询问题不能为空"))

return

}

// 2. 图片转Base64

var buf bytes.Buffer

_, err = buf.ReadFrom(file)

if err != nil {

r.Json(e.Error(10003, "图片转Base64失败"))

return

}

imageBase64 := base64.StdEncoding.EncodeToString(buf.Bytes())

// 3. 构建多模态请求(以GPT-4V为例)

modelReq := &model.MultimodalChatRequest{

UserId: "user_001",

ChatId: "chat_001",

Messages: []*model.MultimodalMessage{

{

Role: "user",

Content: []*model.MultimodalContent{

{

Type: "text",

Value: query,

},

{

Type: "image_url",

Value: &model.ImageUrl{

Url: "data:image/jpeg;base64," + imageBase64,

},

},

},

},

},

ModelName: "gpt-4-vision-preview",

MaxTokens: 1000,

}

// 4. 调用多模态模型

resp, err := e.App().Model().MultimodalChat(modelReq)

if err != nil {

r.Json(e.Error(10004, "图片解析失败"))

return

}

// 5. 返回结果

r.Json(e.Success(e.Map{

"answer": resp.Content,

}))

}

五、企业级落地最佳实践

5.1 Eino项目标准结构(中大型项目)

eino-llm-demo/

├── api/ # API接口定义(请求/响应结构体)

├── cmd/ # 项目入口

│ └── main/

│ └── main.go # 主入口文件

├── config/ # 配置文件

│ ├── config.yaml # 默认配置

│ ├── config.dev.yaml # 开发环境配置

│ └── config.prod.yaml# 生产环境配置

├── internal/ # 内部业务逻辑

│ ├── controller/ # 控制器(处理HTTP请求)

│ ├── service/ # 服务层(核心业务逻辑)

│ ├── dao/ # 数据访问层(数据库/缓存操作)

│ ├── middleware/ # 中间件(权限校验、日志、限流等)

│ └── model/ # 数据模型(业务模型/数据库模型)

├── pkg/ # 公共包(工具类、通用组件)

├── resource/ # 静态资源(Prompt模板、文档、模型文件)

├── router/ # 路由注册

├── storage/ # 存储目录(上传文件、日志文件)

├── test/ # 单元测试/集成测试

├── go.mod # Go模块依赖

└── go.sum # 依赖版本锁定

5.2 核心开发规范

- Prompt 规范:所有 Prompt 必须以模板形式注册到 Eino,禁止硬编码;Prompt 模板必须添加注释,明确参数含义与使用场景;定期优化 Prompt 模板,记录最优版本;

- 模型调用规范:优先使用 Eino 统一模型 API,禁止直接调用第三方大模型接口;必须配置失败重试与超时时间;高频查询结果必须缓存;

- 上下文规范:所有对话上下文必须通过 Eino 上下文管理器管理,禁止自定义缓存;按用户 ID/对话 ID 进行隔离;配置合理的上下文过期时间与最大长度;

- 安全规范:用户输入必须进行校验与过滤,防止 Prompt 注入攻击;大模型输出必须进行敏感信息过滤;私有数据(文档、密钥)必须加密存储;

- 日志监控规范:所有模型调用、业务操作必须记录日志;关键指标(响应时间、Token 消耗、失败率)必须监控;配置告警规则,及时发现异常。

5.3 Docker容器化部署

5.3.1 Dockerfile

# 构建阶段

FROM golang:1.21-alpine AS builder

WORKDIR /app

COPY . .

# 配置Go代理

RUN go env -w GOPROXY=https://mirrors.aliyun.com/goproxy/,direct

# 编译项目

RUN CGO_ENABLED=0 GOOS=linux GOARCH=amd64 go build -ldflags "-s -w" -o eino-llm-demo ./cmd/main

# 运行阶段

FROM alpine:3.18

WORKDIR /app

# 复制可执行文件

COPY --from=builder /app/eino-llm-demo .

# 复制配置文件与资源

COPY --from=builder /app/config ./config

COPY --from=builder /app/resource ./resource

# 暴露端口

EXPOSE 8080

# 启动服务

CMD ["./eino-llm-demo"]

5.3.2 docker-compose.yml

version: '3'

services:

eino-llm-demo:

build: .

container_name: eino-llm-demo

restart: always

ports:

- "8080:8080"

environment:

- EINO_ENV=prod

volumes:

- ./storage:/app/storage

networks:

- eino-network

# 向量数据库(Milvus,可选)

milvus:

image: milvusdb/milvus:v2.4.0

container_name: milvus

restart: always

ports:

- "19530:19530"

volumes:

- ./milvus/data:/var/lib/milvus

environment:

- MILVUS_SERVICE_NAME=milvus

networks:

- eino-network

networks:

eino-network:

driver: bridge

5.4 企业级避坑指南(血泪经验)

| 常见问题 | 核心原因 | 解决方案 |

|---|---|---|

| Prompt 注入攻击 | 用户输入包含恶意指令,篡改 Prompt 逻辑 | 1. 过滤用户输入中的特殊字符与恶意指令;2. 使用 Prompt 模板参数化,禁止用户直接修改 Prompt 核心逻辑;3. 限制用户输入长度 |

| 大模型响应幻觉 | 1. 缺乏私有数据支撑;2. Prompt 指令不清晰;3. 大模型知识过时 | 1. 使用 RAG 技术接入私有数据;2. 优化 Prompt 指令,增加事实校验要求;3. 定期更新大模型知识或使用最新模型 |

| 上下文溢出报错 | 对话轮数过多,上下文长度超出大模型窗口限制 | 1. 配置上下文自动裁剪/压缩;2. 限制最大对话轮数;3. 使用支持超长上下文的大模型 |

| 模型调用失败 | 1. API 密钥过期;2. 网络波动;3. 限流封禁;4. 模型服务不可用 | 1. 定期检查 API 密钥;2. 配置失败重试与超时时间;3. 限流控制,避免高频调用;4. 配置多模型容灾切换 |

| Token 消耗过高 | 1. 上下文过长;2. 大模型输出冗余;3. 高频无效调用 | 1. 上下文压缩/缓存;2. 优化 Prompt,限制输出长度;3. 缓存高频查询结果;4. 使用小模型处理简单问题 |

六、总结

Eino 框架作为轻量级大模型应用开发脚手架,通过封装 Prompt 管理、上下文维护、多模型适配等核心能力,大幅降低了大模型应用的开发门槛与落地成本;而大模型应用的核心价值在于将人工智能技术与实际业务场景结合,解决传统业务的痛点。

本文从 Eino 核心技术、大模型应用底层原理、实战开发到企业级落地,全方位覆盖了 Eino+大模型技术栈的核心内容,所有代码与配置均可直接落地生产环境。在大模型技术快速迭代的今天,掌握 Eino 这类开发框架与大模型应用核心技术,是开发者提升竞争力、企业实现技术落地的关键。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)