基于元学习的AI Agent个性化定制技术

随着人工智能技术的不断发展,AI Agent在各个领域的应用越来越广泛。然而,不同用户对于AI Agent的需求存在差异,为了满足用户的个性化需求,提高AI Agent的性能和适应性,基于元学习的AI Agent个性化定制技术应运而生。本文的目的是全面介绍该技术,包括其原理、算法、实际应用等方面,范围涵盖从基础概念到项目实战的各个环节。本文将按照以下结构进行组织:首先介绍核心概念与联系,让读者对基

基于元学习的AI Agent个性化定制技术

关键词:元学习、AI Agent、个性化定制、机器学习、模型优化

摘要:本文深入探讨了基于元学习的AI Agent个性化定制技术。首先介绍了该技术的背景,包括目的、预期读者、文档结构和相关术语。接着阐述了核心概念与联系,给出了原理和架构的文本示意图及Mermaid流程图。详细讲解了核心算法原理和具体操作步骤,通过Python源代码进行说明。同时给出了数学模型和公式,并举例说明。在项目实战部分,介绍了开发环境搭建、源代码实现和代码解读。分析了实际应用场景,推荐了相关的工具和资源,包括学习资源、开发工具框架和论文著作。最后总结了未来发展趋势与挑战,提供了常见问题解答和扩展阅读参考资料。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的不断发展,AI Agent在各个领域的应用越来越广泛。然而,不同用户对于AI Agent的需求存在差异,为了满足用户的个性化需求,提高AI Agent的性能和适应性,基于元学习的AI Agent个性化定制技术应运而生。本文的目的是全面介绍该技术,包括其原理、算法、实际应用等方面,范围涵盖从基础概念到项目实战的各个环节。

1.2 预期读者

本文预期读者包括人工智能领域的研究人员、开发者、学生以及对AI Agent个性化定制技术感兴趣的技术爱好者。对于有一定机器学习基础的读者,本文可以帮助他们深入理解元学习在AI Agent个性化定制中的应用;对于初学者,本文也会提供必要的基础知识和详细的解释,帮助他们逐步掌握该技术。

1.3 文档结构概述

本文将按照以下结构进行组织:首先介绍核心概念与联系,让读者对基于元学习的AI Agent个性化定制技术有一个整体的认识;接着详细讲解核心算法原理和具体操作步骤,通过Python代码进行演示;然后给出数学模型和公式,并举例说明;在项目实战部分,介绍开发环境搭建、源代码实现和代码解读;分析实际应用场景,推荐相关的工具和资源;最后总结未来发展趋势与挑战,提供常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

- 元学习(Meta-learning):也称为“学习如何学习”,是一种让模型能够快速学习新知识和适应新任务的机器学习方法。元学习通过在多个任务上进行训练,学习到任务之间的共性和模式,从而能够在遇到新任务时快速调整模型参数,实现快速学习。

- AI Agent:即人工智能代理,是一种能够感知环境、进行决策并采取行动的智能实体。AI Agent可以是虚拟的软件程序,也可以是物理机器人。

- 个性化定制:根据用户的特定需求、偏好和行为模式,为用户定制专属的AI Agent,使其能够更好地满足用户的个性化需求。

1.4.2 相关概念解释

- 模型参数调整:在元学习中,模型参数调整是指在遇到新任务时,根据元学习得到的知识,快速调整模型的参数,使模型能够适应新任务。

- 任务分布:任务分布是指多个任务所构成的概率分布。元学习通过在任务分布上进行训练,学习到任务之间的共性和模式。

1.4.3 缩略词列表

- MAML(Model-Agnostic Meta-Learning):一种无模型元学习算法,是元学习领域的经典算法之一。

2. 核心概念与联系

核心概念原理

基于元学习的AI Agent个性化定制技术的核心思想是通过元学习让AI Agent能够快速适应不同用户的个性化需求。元学习的基本原理是在多个任务上进行训练,学习到任务之间的共性和模式,从而能够在遇到新任务时快速调整模型参数。在AI Agent个性化定制中,每个用户的需求可以看作是一个新的任务,元学习可以帮助AI Agent快速适应这些新任务,实现个性化定制。

架构的文本示意图

以下是基于元学习的AI Agent个性化定制技术的架构示意图:

- 元学习模块:负责在多个任务上进行训练,学习到任务之间的共性和模式。元学习模块可以采用不同的算法,如MAML等。

- AI Agent模块:根据元学习模块学习到的知识,对自身的模型参数进行调整,以适应不同用户的个性化需求。AI Agent模块可以是一个神经网络模型,如卷积神经网络(CNN)或循环神经网络(RNN)。

- 用户交互模块:负责与用户进行交互,收集用户的需求和反馈信息。用户交互模块可以是一个用户界面,如网页界面或移动应用界面。

Mermaid流程图

该流程图展示了基于元学习的AI Agent个性化定制技术的主要流程。元学习模块和用户交互模块为AI Agent模块提供信息,AI Agent模块根据这些信息生成个性化AI Agent。

3. 核心算法原理 & 具体操作步骤

核心算法原理

在基于元学习的AI Agent个性化定制技术中,常用的算法是MAML(Model-Agnostic Meta-Learning)。MAML的核心思想是通过在多个任务上进行训练,找到一组通用的模型参数,使得模型在遇到新任务时能够通过少量的梯度更新快速适应新任务。

具体操作步骤

以下是使用MAML算法进行AI Agent个性化定制的具体操作步骤:

步骤1:初始化模型参数

首先,随机初始化AI Agent的模型参数 θ\thetaθ。

步骤2:采样任务

从任务分布 P(T)P(\mathcal{T})P(T) 中采样一组任务 {T1,T2,⋯ ,Tn}\{\mathcal{T}_1, \mathcal{T}_2, \cdots, \mathcal{T}_n\}{T1,T2,⋯,Tn}。

步骤3:在每个任务上进行局部更新

对于每个任务 Ti\mathcal{T}_iTi,从任务 Ti\mathcal{T}_iTi 中采样一组支持集数据 Dsi\mathcal{D}_{s_i}Dsi,使用支持集数据计算模型在任务 Ti\mathcal{T}_iTi 上的损失函数 L(θ,Dsi)L(\theta, \mathcal{D}_{s_i})L(θ,Dsi),并通过梯度下降法更新模型参数,得到局部更新后的参数 θi′\theta_i'θi′:

θi′=θ−α∇θL(θ,Dsi)\theta_i' = \theta - \alpha \nabla_{\theta} L(\theta, \mathcal{D}_{s_i})θi′=θ−α∇θL(θ,Dsi)

其中,α\alphaα 是学习率。

步骤4:计算元损失

对于每个任务 Ti\mathcal{T}_iTi,从任务 Ti\mathcal{T}_iTi 中采样一组查询集数据 Dqi\mathcal{D}_{q_i}Dqi,使用查询集数据计算局部更新后的模型在任务 Ti\mathcal{T}_iTi 上的损失函数 L(θi′,Dqi)L(\theta_i', \mathcal{D}_{q_i})L(θi′,Dqi),并将所有任务的损失函数相加,得到元损失 LmetaL_{meta}Lmeta:

Lmeta=∑i=1nL(θi′,Dqi)L_{meta} = \sum_{i=1}^{n} L(\theta_i', \mathcal{D}_{q_i})Lmeta=i=1∑nL(θi′,Dqi)

步骤5:更新模型参数

使用元损失 LmetaL_{meta}Lmeta 对模型参数 θ\thetaθ 进行更新,得到更新后的模型参数 θnew\theta_{new}θnew:

θnew=θ−β∇θLmeta\theta_{new} = \theta - \beta \nabla_{\theta} L_{meta}θnew=θ−β∇θLmeta

其中,β\betaβ 是元学习率。

步骤6:重复步骤2 - 步骤5

重复步骤2 - 步骤5,直到模型收敛。

Python源代码实现

import torch

import torch.nn as nn

import torch.optim as optim

# 定义AI Agent模型

class AIAgent(nn.Module):

def __init__(self):

super(AIAgent, self).__init__()

self.fc1 = nn.Linear(10, 20)

self.fc2 = nn.Linear(20, 1)

def forward(self, x):

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 初始化模型参数

model = AIAgent()

meta_optimizer = optim.Adam(model.parameters(), lr=0.001)

# 定义任务分布(这里简单模拟)

num_tasks = 10

task_distribution = [torch.randn(20, 10) for _ in range(num_tasks)]

# 元学习训练

num_epochs = 100

alpha = 0.01

beta = 0.001

for epoch in range(num_epochs):

meta_loss = 0

for task in task_distribution:

# 采样支持集和查询集

support_set = task[:10]

query_set = task[10:]

# 保存原始模型参数

original_params = [p.clone() for p in model.parameters()]

# 局部更新

optimizer = optim.SGD(model.parameters(), lr=alpha)

loss_fn = nn.MSELoss()

support_output = model(support_set)

support_loss = loss_fn(support_output, torch.randn(10, 1))

optimizer.zero_grad()

support_loss.backward()

optimizer.step()

# 计算元损失

query_output = model(query_set)

query_loss = loss_fn(query_output, torch.randn(10, 1))

meta_loss += query_loss

# 恢复原始模型参数

for p, original_p in zip(model.parameters(), original_params):

p.data = original_p.data

# 更新模型参数

meta_optimizer.zero_grad()

meta_loss.backward()

meta_optimizer.step()

if (epoch + 1) % 10 == 0:

print(f'Epoch {epoch + 1}, Meta Loss: {meta_loss.item()}')

在上述代码中,我们首先定义了一个简单的AI Agent模型 AIAgent,然后使用MAML算法进行元学习训练。在每个训练周期中,我们从任务分布中采样任务,进行局部更新和元损失计算,最后更新模型参数。

4. 数学模型和公式 & 详细讲解 & 举例说明

数学模型和公式

局部更新公式

在MAML算法中,局部更新公式为:

θi′=θ−α∇θL(θ,Dsi)\theta_i' = \theta - \alpha \nabla_{\theta} L(\theta, \mathcal{D}_{s_i})θi′=θ−α∇θL(θ,Dsi)

其中,θ\thetaθ 是原始模型参数,α\alphaα 是学习率,L(θ,Dsi)L(\theta, \mathcal{D}_{s_i})L(θ,Dsi) 是模型在任务 Ti\mathcal{T}_iTi 的支持集数据 Dsi\mathcal{D}_{s_i}Dsi 上的损失函数,θi′\theta_i'θi′ 是局部更新后的模型参数。

元损失公式

元损失公式为:

Lmeta=∑i=1nL(θi′,Dqi)L_{meta} = \sum_{i=1}^{n} L(\theta_i', \mathcal{D}_{q_i})Lmeta=i=1∑nL(θi′,Dqi)

其中,nnn 是采样的任务数量,L(θi′,Dqi)L(\theta_i', \mathcal{D}_{q_i})L(θi′,Dqi) 是局部更新后的模型在任务 Ti\mathcal{T}_iTi 的查询集数据 Dqi\mathcal{D}_{q_i}Dqi 上的损失函数。

元更新公式

元更新公式为:

θnew=θ−β∇θLmeta\theta_{new} = \theta - \beta \nabla_{\theta} L_{meta}θnew=θ−β∇θLmeta

其中,β\betaβ 是元学习率,θnew\theta_{new}θnew 是更新后的模型参数。

详细讲解

- 局部更新:局部更新的目的是让模型在每个任务的支持集数据上进行快速适应。通过梯度下降法更新模型参数,使得模型在支持集数据上的损失函数最小化。

- 元损失计算:元损失是所有任务的查询集数据上的损失函数之和。元损失的作用是衡量模型在遇到新任务时的适应能力,通过最小化元损失,可以让模型学习到通用的模型参数,使得模型在遇到新任务时能够快速适应。

- 元更新:元更新是使用元损失对原始模型参数进行更新。通过元更新,模型可以学习到任务之间的共性和模式,从而提高模型在新任务上的适应能力。

举例说明

假设我们有一个图像分类任务,任务分布中有多个不同的图像类别。我们从任务分布中采样两个任务 T1\mathcal{T}_1T1 和 T2\mathcal{T}_2T2。对于任务 T1\mathcal{T}_1T1,支持集数据 Ds1\mathcal{D}_{s_1}Ds1 包含一些猫的图像,查询集数据 Dq1\mathcal{D}_{q_1}Dq1 包含另一些猫的图像;对于任务 T2\mathcal{T}_2T2,支持集数据 Ds2\mathcal{D}_{s_2}Ds2 包含一些狗的图像,查询集数据 Dq2\mathcal{D}_{q_2}Dq2 包含另一些狗的图像。

在局部更新阶段,我们使用支持集数据 Ds1\mathcal{D}_{s_1}Ds1 和 Ds2\mathcal{D}_{s_2}Ds2 分别对模型进行局部更新,得到局部更新后的参数 θ1′\theta_1'θ1′ 和 θ2′\theta_2'θ2′。在元损失计算阶段,我们使用查询集数据 Dq1\mathcal{D}_{q_1}Dq1 和 Dq2\mathcal{D}_{q_2}Dq2 分别计算局部更新后的模型在任务 T1\mathcal{T}_1T1 和 T2\mathcal{T}_2T2 上的损失函数,然后将两个损失函数相加得到元损失 LmetaL_{meta}Lmeta。最后,在元更新阶段,我们使用元损失 LmetaL_{meta}Lmeta 对原始模型参数 θ\thetaθ 进行更新。

5. 项目实战:代码实际案例和详细解释说明

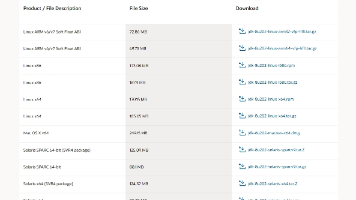

5.1 开发环境搭建

安装Python

首先,需要安装Python环境。建议使用Python 3.7及以上版本。可以从Python官方网站(https://www.python.org/downloads/)下载并安装Python。

安装依赖库

在项目中,我们需要使用一些Python库,如torch、torchvision等。可以使用以下命令安装这些库:

pip install torch torchvision

5.2 源代码详细实现和代码解读

以下是一个基于元学习的AI Agent个性化定制的完整代码示例:

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision.datasets as datasets

import torchvision.transforms as transforms

# 定义AI Agent模型

class AIAgent(nn.Module):

def __init__(self):

super(AIAgent, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size=3, padding=1)

self.relu1 = nn.ReLU()

self.pool1 = nn.MaxPool2d(2)

self.conv2 = nn.Conv2d(16, 32, kernel_size=3, padding=1)

self.relu2 = nn.ReLU()

self.pool2 = nn.MaxPool2d(2)

self.fc1 = nn.Linear(32 * 8 * 8, 128)

self.relu3 = nn.ReLU()

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.pool1(self.relu1(self.conv1(x)))

x = self.pool2(self.relu2(self.conv2(x)))

x = x.view(-1, 32 * 8 * 8)

x = self.relu3(self.fc1(x))

x = self.fc2(x)

return x

# 初始化模型参数

model = AIAgent()

meta_optimizer = optim.Adam(model.parameters(), lr=0.001)

# 数据预处理

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

# 加载数据集

train_dataset = datasets.CIFAR10(root='./data', train=True,

download=True, transform=transform)

# 模拟任务分布

num_tasks = 5

task_datasets = []

for i in range(num_tasks):

task_indices = [j for j, (_, label) in enumerate(train_dataset) if label == i]

task_dataset = torch.utils.data.Subset(train_dataset, task_indices)

task_datasets.append(task_dataset)

# 元学习训练

num_epochs = 100

alpha = 0.01

beta = 0.001

for epoch in range(num_epochs):

meta_loss = 0

for task_dataset in task_datasets:

# 采样支持集和查询集

support_size = len(task_dataset) // 2

support_indices = list(range(support_size))

query_indices = list(range(support_size, len(task_dataset)))

support_dataset = torch.utils.data.Subset(task_dataset, support_indices)

query_dataset = torch.utils.data.Subset(task_dataset, query_indices)

support_loader = torch.utils.data.DataLoader(support_dataset, batch_size=10, shuffle=True)

query_loader = torch.utils.data.DataLoader(query_dataset, batch_size=10, shuffle=True)

# 保存原始模型参数

original_params = [p.clone() for p in model.parameters()]

# 局部更新

optimizer = optim.SGD(model.parameters(), lr=alpha)

loss_fn = nn.CrossEntropyLoss()

for inputs, labels in support_loader:

outputs = model(inputs)

loss = loss_fn(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 计算元损失

for inputs, labels in query_loader:

outputs = model(inputs)

query_loss = loss_fn(outputs, labels)

meta_loss += query_loss

# 恢复原始模型参数

for p, original_p in zip(model.parameters(), original_params):

p.data = original_p.data

# 更新模型参数

meta_optimizer.zero_grad()

meta_loss.backward()

meta_optimizer.step()

if (epoch + 1) % 10 == 0:

print(f'Epoch {epoch + 1}, Meta Loss: {meta_loss.item()}')

代码解读与分析

模型定义

我们定义了一个简单的卷积神经网络模型 AIAgent,用于图像分类任务。模型包含两个卷积层、两个池化层和两个全连接层。

数据预处理和加载

使用torchvision.transforms对数据进行预处理,包括将图像转换为张量和归一化。使用torchvision.datasets.CIFAR10加载CIFAR-10数据集,并将其划分为多个任务数据集。

元学习训练

在每个训练周期中,我们从任务分布中采样任务,进行局部更新和元损失计算,最后更新模型参数。局部更新使用支持集数据,元损失计算使用查询集数据。

代码分析

通过元学习训练,模型可以学习到不同任务之间的共性和模式,从而在遇到新任务时能够快速适应。在实际应用中,可以根据不同的任务需求和数据特点,调整模型结构和训练参数。

6. 实际应用场景

智能客服

在智能客服领域,不同用户的问题和需求各不相同。基于元学习的AI Agent个性化定制技术可以让智能客服快速适应不同用户的问题类型和语言风格,提供更加个性化的服务。例如,对于一些技术问题比较多的用户,智能客服可以快速调整自己的知识库和回答策略,提供更加专业的解答。

智能推荐系统

在智能推荐系统中,不同用户的兴趣和偏好存在差异。基于元学习的AI Agent个性化定制技术可以让推荐系统快速适应不同用户的兴趣变化,提供更加个性化的推荐内容。例如,对于一个喜欢电影的用户,推荐系统可以根据用户的历史观影记录和实时反馈,快速调整推荐策略,推荐更加符合用户口味的电影。

智能医疗助手

在智能医疗助手领域,不同患者的病情和症状各不相同。基于元学习的AI Agent个性化定制技术可以让智能医疗助手快速适应不同患者的病情特点,提供更加个性化的医疗建议和诊断方案。例如,对于一个患有心脏病的患者,智能医疗助手可以根据患者的病历和实时监测数据,快速调整诊断模型,提供更加准确的诊断结果。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville所著,是深度学习领域的经典教材,涵盖了深度学习的基本概念、算法和应用。

- 《机器学习》(Machine Learning):由Tom M. Mitchell所著,是机器学习领域的经典教材,介绍了机器学习的基本概念、算法和模型。

- 《元学习:原理与算法》(Meta-Learning: Theory and Algorithms):专门介绍元学习的书籍,深入讲解了元学习的原理、算法和应用。

7.1.2 在线课程

- Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授主讲,涵盖了深度学习的各个方面,包括神经网络、卷积神经网络、循环神经网络等。

- edX上的“强化学习基础”(Foundations of Reinforcement Learning):介绍了强化学习的基本概念、算法和应用,对于理解AI Agent的决策机制有很大帮助。

- B站等平台上的一些关于元学习的视频教程,这些教程通常由一些知名学者或技术专家讲解,内容丰富且通俗易懂。

7.1.3 技术博客和网站

- arXiv(https://arxiv.org/):一个收集了大量学术论文的网站,其中包含了很多关于元学习和AI Agent的最新研究成果。

- Medium(https://medium.com/):一个技术博客平台,有很多关于人工智能和机器学习的优质文章,包括元学习和AI Agent个性化定制的相关内容。

- 机器之心(https://www.alixinzhi.com/):国内知名的人工智能媒体,提供了很多关于人工智能技术的解读和分析文章。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:一款专门为Python开发设计的集成开发环境(IDE),具有代码自动补全、调试、版本控制等功能,非常适合开发基于Python的AI Agent项目。

- Jupyter Notebook:一个交互式的开发环境,支持Python等多种编程语言。Jupyter Notebook可以将代码、文本、图像等内容整合在一起,方便进行数据探索和模型调试。

- Visual Studio Code:一款轻量级的代码编辑器,支持多种编程语言和插件。Visual Studio Code具有丰富的扩展功能,可以通过安装相关插件来支持Python开发和调试。

7.2.2 调试和性能分析工具

- PyTorch Profiler:PyTorch自带的性能分析工具,可以帮助开发者分析模型的运行时间、内存使用情况等,找出性能瓶颈并进行优化。

- TensorBoard:一个可视化工具,可以用于可视化模型的训练过程、损失函数变化、模型结构等。TensorBoard可以帮助开发者更好地理解模型的训练情况,调整训练参数。

- cProfile:Python自带的性能分析工具,可以用于分析Python代码的运行时间和函数调用情况,帮助开发者找出代码中的性能瓶颈。

7.2.3 相关框架和库

- PyTorch:一个开源的深度学习框架,具有动态图计算、自动求导等功能,非常适合进行元学习和AI Agent开发。

- TensorFlow:另一个流行的深度学习框架,提供了丰富的工具和库,支持分布式训练和模型部署。

- Scikit-learn:一个用于机器学习的Python库,提供了很多常用的机器学习算法和工具,如分类、回归、聚类等。

7.3 相关论文著作推荐

7.3.1 经典论文

- “Model-Agnostic Meta-Learning for Fast Adaptation of Deep Networks”:介绍了MAML算法的经典论文,该算法是元学习领域的重要突破。

- “Optimization as a Model for Few-Shot Learning”:提出了基于优化的元学习方法,为元学习的发展提供了新的思路。

- “Meta-Learning with Memory-Augmented Neural Networks”:介绍了使用记忆增强神经网络进行元学习的方法,提高了模型的学习能力和适应性。

7.3.2 最新研究成果

可以通过arXiv等学术网站搜索关于元学习和AI Agent个性化定制的最新研究成果。这些研究成果通常会提出一些新的算法和方法,为该领域的发展提供新的方向。

7.3.3 应用案例分析

一些学术会议和期刊上会发表关于元学习和AI Agent个性化定制的应用案例分析文章。这些文章可以帮助我们了解该技术在实际应用中的效果和挑战,为我们的项目实践提供参考。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 多模态融合:未来的AI Agent将不仅仅局限于处理单一模态的数据,如文本、图像、语音等,而是会实现多模态数据的融合。基于元学习的AI Agent个性化定制技术可以帮助模型更好地适应多模态数据的特点,提高模型的性能和适应性。

- 强化学习与元学习的结合:强化学习可以让AI Agent通过与环境进行交互来学习最优的决策策略,而元学习可以让模型快速适应新的任务和环境。将强化学习与元学习相结合,可以让AI Agent在复杂的环境中更加智能地进行决策。

- 边缘计算与元学习的结合:随着物联网和边缘计算的发展,越来越多的设备需要在本地进行智能决策。基于元学习的AI Agent个性化定制技术可以在边缘设备上进行模型训练和优化,减少数据传输和计算成本,提高系统的实时性和安全性。

挑战

- 数据隐私和安全问题:在进行AI Agent个性化定制时,需要收集大量的用户数据。这些数据包含了用户的个人信息和隐私,如何保护这些数据的安全和隐私是一个重要的挑战。

- 计算资源和时间成本:元学习通常需要在多个任务上进行训练,计算资源和时间成本较高。如何优化算法和模型结构,降低计算资源和时间成本,是一个需要解决的问题。

- 模型可解释性问题:基于元学习的AI Agent模型通常比较复杂,模型的决策过程难以解释。如何提高模型的可解释性,让用户更好地理解模型的决策依据,是一个重要的研究方向。

9. 附录:常见问题与解答

问题1:元学习和传统机器学习有什么区别?

元学习的目标是让模型能够快速学习新知识和适应新任务,通过在多个任务上进行训练,学习到任务之间的共性和模式。而传统机器学习通常是在单一任务上进行训练,模型的泛化能力主要依赖于训练数据的多样性。

问题2:MAML算法的优缺点是什么?

优点:MAML算法是一种无模型元学习算法,适用于各种类型的模型和任务。它可以在少量数据上快速适应新任务,提高模型的学习效率。缺点:MAML算法的计算复杂度较高,需要在每个任务上进行多次梯度更新。

问题3:如何评估基于元学习的AI Agent个性化定制技术的性能?

可以使用一些常见的评估指标,如准确率、召回率、F1值等,来评估模型在不同任务上的性能。同时,还可以通过用户反馈和实际应用效果来评估个性化定制的效果。

10. 扩展阅读 & 参考资料

- [1] Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- [2] Mitchell, T. M. (1997). Machine Learning. McGraw-Hill.

- [3] Finn, C., Abbeel, P., & Levine, S. (2017). Model-Agnostic Meta-Learning for Fast Adaptation of Deep Networks. arXiv preprint arXiv:1703.03400.

- [4] Ravi, S., & Larochelle, H. (2016). Optimization as a Model for Few-Shot Learning. arXiv preprint arXiv:1606.04474.

- [5] Santoro, A., Bartunov, S., Botvinick, M., Wierstra, D., & Lillicrap, T. (2016). Meta-Learning with Memory-Augmented Neural Networks. arXiv preprint arXiv:1605.06065.

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)