AI在软件开发中的自动化革命:从手动操作到全流程自动化,半年实践历程揭秘!

本文记录了作者从手动到全自动AI开发流程的半年实践历程。6月开始使用Claude Code需要全程盯守,11月实现云端触发解放人力,12月最终完成全自动流程:只需确认PRD后,需求可自动拆分、并发执行、review修复、合并上线并测试闭环。关键经验包括:分阶段渐进实现、职责分离、用现有工具快速验证、控制AI权限、智能选择模型后端。目前系统已实现从需求到上线的全自动处理,仅在PRD阶段需人工确认一次

TLDR

从 6 月用 Claude Code 手动盯着干活,到 11 月云端触发,再到 12 月全自动开发流程,花了半年时间让 AI 从"需要人盯着"变成"自己能跑完"。

现在能做到:丢个需求 → 确认 PRD → 自动拆分并发执行 → 自动 review 修复 → 合并上线 → 测试闭环。

整个过程只需要在 PRD 阶段确认一次。

从手动等待到全自动

6 月开始用 Claude Code,体验到了比 Cursor 更直接的 vibe coding。丢个需求给它,自己去read、write,挺爽的。但有几个问题让人难受:

- 权限卡点 - 遇到权限问题需要人工按回车确认

- 被动等待 - 代码写完了需要人工去 review

- 串行阻塞 - 必须盯着它干完活才能操作下一步

每次坐在电脑前等 Claude Code 工作结束,就会想:能不能把我分身出来盯着它,我自己去干别的?

11 月 2 日发布了 swe-agent.ai,把这个想法落地了:在 GitHub issue 里 comment /code 就能触发后台的 Claude Code。人不用守在电脑前了,但还是需要每次改动都去 comment 触发一下。从"守在电脑前"变成了"守在 GitHub 里",换了个空间继续被限制。

三次迭代:从单次任务到全流程自动化

Claude Code:手动盯着干活

用 Claude Code 时的典型流程:

需求 → 等待分析 → 等待写代码 → 人工 review → 人工提交

优点是直接,缺点是离不开人。

swe-agent 1.0:云端触发

把 Claude Code 搬到云端,通过 GitHub webhook 触发:

Issue comment /code → 后台 Claude Code 执行 → 代码提交 → 结束

解决了"守在电脑前"的问题,但每次还是需要人工去触发下一步。

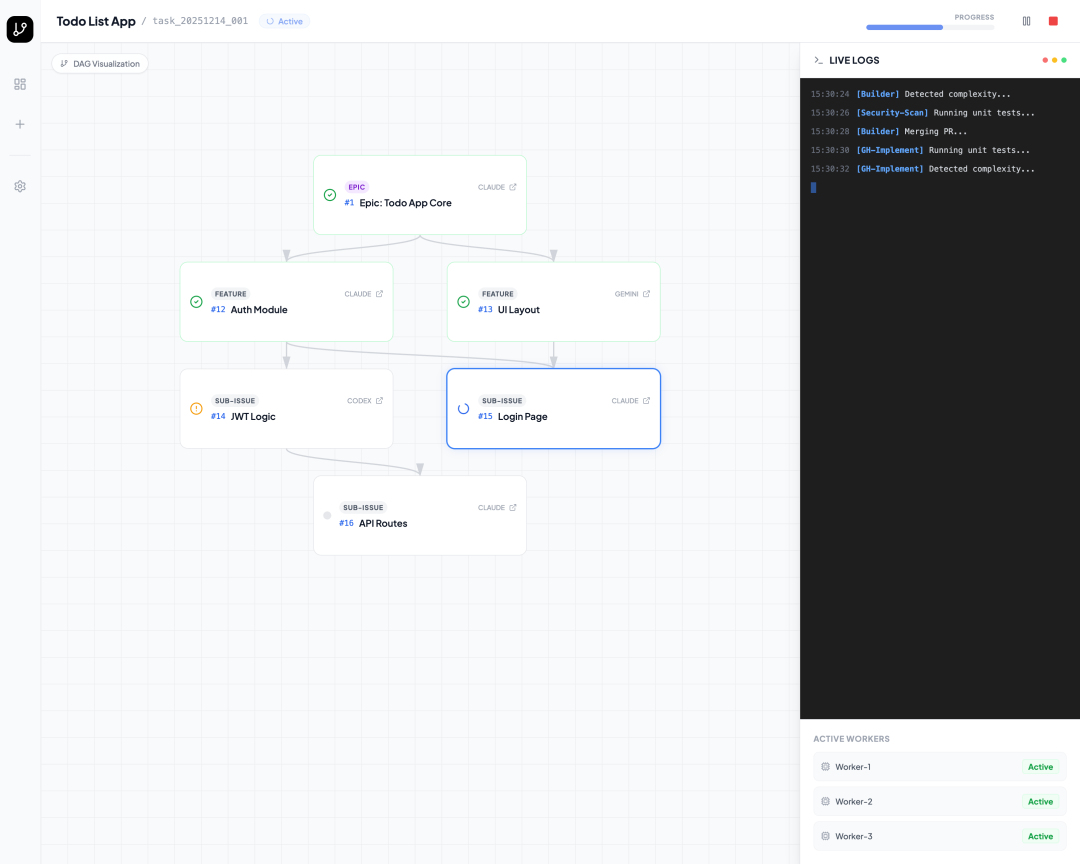

swe-agent 2.0:全流程自动化

核心突破:从"单次任务"升级为"流程编排"。

需求 → PRD (人工确认) → 任务拆分 → 并发执行 → Review → 修复 → 合并 → 测试 → 完成

整个流程只在 PRD 阶段需要人确认一次,后面全自动。

两种模式,各干各的事

单次任务模式

适合快速修 bug 或小改动,评论一下就能触发,改完就结束。

全流程模式

适合完整需求开发,从需求理解到最终上线,自动走完整个流程。

为什么要分两种?

一开始想做一个"超级模式"啥都能干,试了一圈发现容易失控。比如让 AI 在分析需求的时候就能写代码,经常会跳过分析直接开始撸,导致后面逻辑混乱。

分成两种模式后,一个专注"执行",一个专注"编排",职责清晰多了。

几个踩坑经验

1. 别想着重写一套系统

一开始差点陷入"重写一套完美引擎"的陷阱。写了一个月发现越来越复杂,调试都调不动。

后来想明白了:手上已经有能用的东西了,为啥要推倒重来?在现有基础上加个轻量的编排层就够了。

2. AI 得管着点,不能太自由

最大的坑:前期规划阶段别让 AI 写代码。

早期版本里,AI 在分析需求的时候就能开始写代码。结果经常是分析到一半,突然忍不住开始撸代码,写完发现理解偏了,又得回头改。

后来强制规定:前期只能"看"不能"写"。分析需求时只给只读权限,等拆分完任务了再放开写代码的权限。

这个改动之后,执行准确率明显上去了。

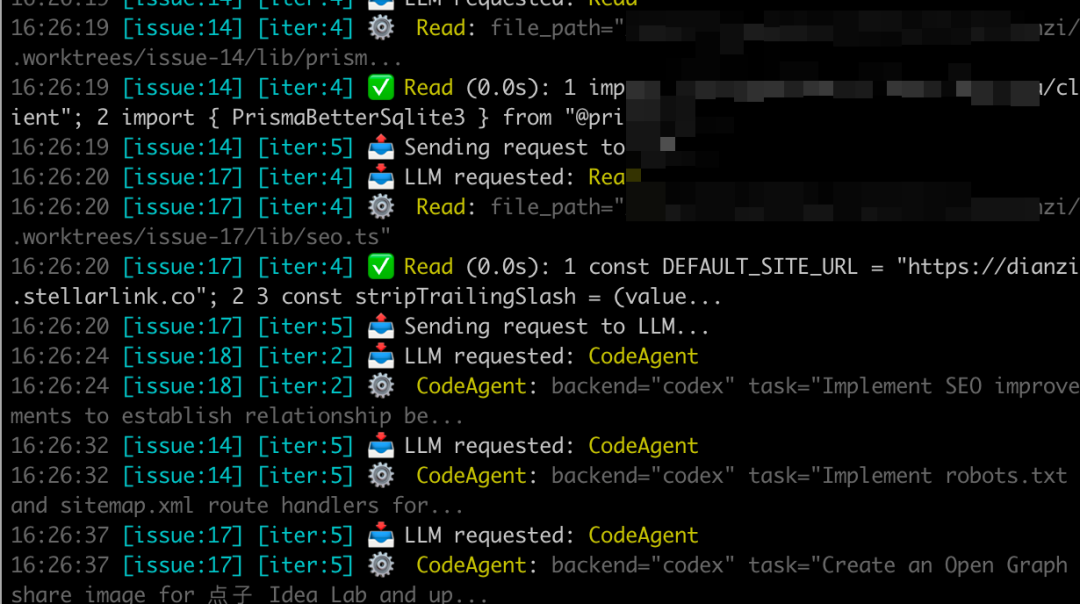

3. 并发执行得解决代码隔离

拆分出来的多个子任务要并发跑,一开始想每个任务 clone 一份代码,后来发现磁盘受不了。

改成用 git worktree 之后解决了:base repo 只 clone 一次,每个任务用独立的工作目录,互不干扰。跑完直接删工作目录,下次复用 base repo。

4. 测试不能只跑后端

后端测试好办,单测 + E2E 跑一遍就知道了。

前端比较麻烦,最后是让 AI 开个浏览器自己点点看,发现问题自动提 issue,然后再触发修复。这个循环跑通之后,基本就是自动闭环了。

基于 Claude Code 快速验证想法

这个项目能跑通,最关键的是用 Claude Code 本身来验证 MVP。

不用从零搭环境,直接在 Claude Code 里写个 slash command 测试流程,把能力封装成 skills 随时调整。调通了之后直接复制到自己的框架里,基本不用改就能跑。

这比从零开始搭 agent 框架再一点点调试,至少快了 3-5 倍。

多后端策略

让 AI 根据任务类型自己选后端,比人工指定效果好:

| 任务类型 | 选的模型 | 为啥 |

|---|---|---|

| UI 原型 | Gemini 3 Flash | 视觉理解强,快 |

| 写代码 | Codex (GPT-5.2) | 代码质量稳定 |

| 简单配置 | Claude Sonnet4.5 | 理解力够,架构强 |

这个策略是实测出来的。一开始全用 Claude,后来发现 UI 类任务 Gemini 更快更便宜,代码类任务 Codex 更稳定。

用

Alpha效果

目前跑通的流程:创建 issue → 自动生成 PRD -> 检查确认 → 拆分并发执行 → 自动 review 修复 → 合并 → 测试闭环。

整个过程只在 PRD 阶段确认一下,其他都是自动的。

另类自举,先实现 cli mvp 快速迭代然后再实现server

现在是通过 swe-agent-cli 来实现 swe-agent2.0

总结

从 6 月到 12 月,把 AI 从"需要人盯着"变成"自己能跑完"。

几个关键经验:

- 别想着一步到位 - 先做单次任务,再做流程编排

- 职责分离比大而全更可控 - 执行和编排分开

- 用 Claude Code 快速验证 - 比从零搭框架快太多

- 强制阶段权限 - 别让 AI 在不该写代码的时候写代码

- 让 AI 选择后端 - 比人工指定更灵活

swe-agent 2.0 的 alpha 版已经在内测,有兴趣可以关注 swe-agent.ai。

如何学习AI大模型?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

想正式转到一些新兴的 AI 行业,不仅需要系统的学习AI大模型。同时也要跟已有的技能结合,辅助编程提效,或上手实操应用,增加自己的职场竞争力。

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

那么针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

学习路线

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献175条内容

已为社区贡献175条内容

所有评论(0)