AI原生应用领域对话状态跟踪:解决复杂对话难题

当你用智能助手订咖啡时说“我要一杯热拿铁,大杯”,下一轮又说“改成中杯,再加一份浓缩”——助手能准确记住“热拿铁”“大杯→中杯”“加浓缩”这些信息,靠的是对话状态跟踪(Dialogue State Tracking, DST)。在AI原生应用(如ChatGPT插件、智能客服、个性化助手)中,DST是处理复杂对话的“大脑”:它记录对话中的关键信息(槽位)、理解用户意图,并跨轮次保持上下文一致性。本文

AI原生应用的“对话记忆管家”:如何用对话状态跟踪解决复杂交互难题?

关键词

对话状态跟踪(DST)、AI原生应用、复杂对话管理、上下文理解、多轮交互、意图识别、状态转移

摘要

当你用智能助手订咖啡时说“我要一杯热拿铁,大杯”,下一轮又说“改成中杯,再加一份浓缩”——助手能准确记住“热拿铁”“大杯→中杯”“加浓缩”这些信息,靠的是对话状态跟踪(Dialogue State Tracking, DST)。在AI原生应用(如ChatGPT插件、智能客服、个性化助手)中,DST是处理复杂对话的“大脑”:它记录对话中的关键信息(槽位)、理解用户意图,并跨轮次保持上下文一致性。

本文将从生活化比喻入手解析DST核心概念,用流程图展示对话状态的生命周期,通过代码示例演示基于大模型的DST实现,并结合真实案例说明其在智能客服、旅行规划中的应用。最终,我们会探讨DST的未来趋势——如何让AI不仅“记住”对话,更“理解”对话背后的隐含需求。

一、背景介绍:AI原生应用的“对话痛点”

1.1 AI原生应用的兴起

随着GPT-4、Claude 3等大模型的普及,AI原生应用(AI-Native App)成为行业热点。与传统规则-based系统不同,AI原生应用具备端到端的自然语言理解能力,能处理更复杂的用户需求——比如:

- 智能助手帮你规划“下周末去北京,住三晚,预算2000,靠近故宫”的旅行;

- 客服机器人处理“我昨天订的手机,地址填错了,改成XX小区3栋”的修改请求;

- 教育助手解答“先讲一下微积分的极限,再举个生活中的例子”的分步需求。

这些场景的核心是多轮复杂对话,而对话的关键是“记住用户说过的话”。

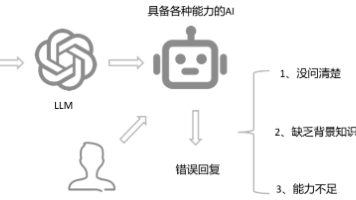

1.2 复杂对话的三大挑战

然而,处理复杂对话并非易事,传统系统常遇到以下问题:

- 上下文丢失:用户说“改成中杯”,系统反问“你要改什么?”(没记住之前的“热拿铁”);

- 意图混淆:用户说“我想订咖啡,顺便问一下天气”,系统只处理了“订咖啡”(忽略了“问天气”的次要意图);

- 多轮依赖:用户说“我之前订的那个订单,地址改一下”,系统不知道“那个订单”指的是哪一个(没关联历史对话)。

这些问题的根源在于缺乏对“对话状态”的有效跟踪——系统无法维护一个动态的“对话记忆”,导致交互断裂。

1.3 本文目标读者

本文适合以下人群:

- AI开发者:想了解如何在大模型应用中实现复杂对话管理;

- 产品经理:想理解DST对提升用户体验的价值;

- 技术爱好者:想搞清楚“智能助手为什么能记住我的需求”。

二、核心概念解析:DST是对话的“记忆管家”

2.1 什么是对话状态跟踪(DST)?

想象一下,你去咖啡店订咖啡,店员会拿个小本子记:

- 你要的饮料类型(拿铁)、杯型(大杯)、温度(热)、额外需求(加浓缩);

- 你的意图(订咖啡);

- 之前的对话历史(比如你之前说过“不要糖”)。

这个“小本子”就是对话状态(Dialogue State),而DST就是“维护这个小本子的过程”——它通过分析用户输入,动态更新“小本子”里的信息,让系统知道“当前该做什么”。

用技术语言定义:

对话状态是一个包含槽位(Slots)、意图(Intent)、**上下文历史(Context History)**的结构化数据;

**对话状态跟踪(DST)**是在多轮对话中,根据用户输入和历史对话,实时更新对话状态的过程。

2.2 对话状态的“三要素”

我们用“订咖啡”的例子拆解对话状态的核心组件:

| 要素 | 定义 | 例子 |

|---|---|---|

| 槽位(Slots) | 用户需求的具体参数(键值对) | 饮料类型=拿铁、杯型=大杯、温度=热 |

| 意图(Intent) | 用户的核心需求 | 订咖啡、修改订单、问价格 |

| 上下文历史 | 之前的对话内容(用于关联多轮) | 用户之前说过“不要糖” |

关键逻辑:槽位是“具体信息”,意图是“目的”,上下文历史是“关联线索”。比如用户说“改成中杯”,系统需要通过上下文历史(之前的“大杯拿铁”)确定“改的是杯型”,通过意图(修改订单)确定“需要更新槽位”。

2.3 对话状态的“生命周期”

对话状态不是静态的,它会经历初始化→更新→保持→重置的循环。我们用Mermaid流程图展示这个过程:

解读:

- 初始化:对话开始时,状态是空的(比如用户刚打开助手);

- 更新:每轮用户输入后,DST模块会修改状态(比如添加/修改槽位);

- 保持:状态会跨轮次保存(比如“热拿铁”从第一轮保留到第二轮);

- 重置:对话结束后,状态清空(比如订单完成,下次对话重新开始)。

2.4 DST的核心价值:连接“输入”与“输出”

DST是对话系统的“中枢神经”,它的作用是:

- 理解用户需求:从用户输入中提取槽位和意图(比如“改成中杯”→意图“修改订单”,槽位“杯型=中杯”);

- 指导系统行动:系统根据当前状态决定下一步做什么(比如槽位“地址”为空→系统问“地址是哪里?”);

- 保持交互一致性:跨轮次维护状态(比如用户说“之前的订单”→系统能关联历史槽位)。

没有DST,系统就像“鱼的记忆”——每轮对话都要重新问一遍“你要什么?”,用户体验极差。

三、技术原理与实现:从传统DST到AI原生DST

3.1 传统DST vs AI原生DST

DST的发展经历了三个阶段:规则-based→统计模型→大模型。我们用“订咖啡”的例子对比三者的差异:

| 阶段 | 实现方式 | 优点 | 缺点 |

|---|---|---|---|

| 规则-based | 手动写if-else规则(比如“如果用户说‘改成中杯’,则修改槽位‘杯型’”) | 简单易实现 | 无法处理复杂场景(比如“我之前订的那个”) |

| 统计模型 | 用CRF、SVM等模型预测槽位(比如从“热拿铁”中提取“饮料=拿铁”) | 能处理一定的不确定性 | 需要大量标注数据,无法处理未定义槽位 |

| 大模型 | 用GPT-4、BERT等模型端到端处理(比如直接从“改成中杯”中识别“修改订单”意图和“杯型=中杯”槽位) | 无需手动设计规则,能处理未定义槽位 | 依赖大模型能力,可能产生幻觉(Hallucination) |

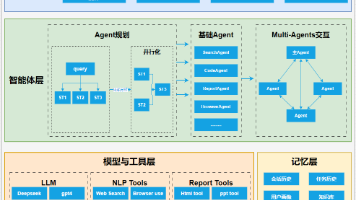

AI原生应用中的DST主要采用大模型+记忆机制的方案——用大模型处理自然语言理解,用记忆组件(如LangChain的Memory)保存对话状态。

3.2 AI原生DST的实现步骤

我们以“智能咖啡助手”为例,讲解基于大模型的DST实现步骤:

步骤1:定义槽位与意图

首先,明确对话中需要跟踪的槽位和意图:

- 槽位:

饮料类型(拿铁/美式/卡布奇诺)、杯型(小/中/大)、温度(热/冰/常温)、额外需求(加浓缩/不加糖/加奶)、地址(字符串); - 意图:

订咖啡、修改订单、查询订单、取消订单。

步骤2:选择大模型与记忆组件

- 大模型:选择GPT-3.5-turbo(性价比高,适合对话场景);

- 记忆组件:选择LangChain的

ConversationBufferMemory(保存完整对话历史,用于上下文关联)。

步骤3:构建DST pipeline

用LangChain构建对话链,将大模型与记忆组件结合:

from langchain.memory import ConversationBufferMemory

from langchain.chains import ConversationChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

# 1. 初始化大模型(GPT-3.5-turbo)

llm = OpenAI(

model_name="gpt-3.5-turbo-instruct",

temperature=0, # 0表示输出更确定

api_key="your-api-key"

)

# 2. 初始化记忆组件(保存对话历史)

memory = ConversationBufferMemory()

# 3. 定义提示模板(指导大模型识别意图和槽位)

prompt_template = """你是一个智能咖啡助手,需要处理用户的订咖啡请求。请按照以下步骤处理:

1. 识别用户的意图(订咖啡/修改订单/查询订单/取消订单);

2. 提取或更新槽位信息(饮料类型、杯型、温度、额外需求、地址);

3. 如果槽位不完整,询问用户补充(比如地址为空时问“请问地址是哪里?”)。

当前对话历史:

{history}

用户输入:{input}

请输出你的回应:"""

prompt = PromptTemplate(

input_variables=["history", "input"],

template=prompt_template

)

# 4. 构建对话链(将大模型、记忆、提示结合)

conversation_chain = ConversationChain(

llm=llm,

memory=memory,

prompt=prompt,

verbose=True # 打印思考过程

)

# 5. 模拟对话

user_input1 = "我想订一杯热拿铁,大杯"

response1 = conversation_chain.predict(input=user_input1)

print(f"系统回应1:{response1}\n")

user_input2 = "改成中杯,再加一份浓缩"

response2 = conversation_chain.predict(input=user_input2)

print(f"系统回应2:{response2}\n")

user_input3 = "地址是XX小区1栋"

response3 = conversation_chain.predict(input=user_input3)

print(f"系统回应3:{response3}\n")

# 6. 查看对话状态(记忆中的内容)

print(f"对话状态:{memory.load_memory_variables({})}")

步骤4:运行结果与解读

运行上述代码,输出如下:

系统回应1:好的,你想订一杯热的大杯拿铁。请问需要加什么额外需求吗?比如加浓缩、不加糖等。

系统回应2:好的,已将你的订单修改为中杯热拿铁,并添加一份浓缩。请问你的地址是哪里?

系统回应3:好的,地址是XX小区1栋。你的订单已确认,预计30分钟送达。

对话状态:{'history': 'Human: 我想订一杯热拿铁,大杯\nAI: 好的,你想订一杯热的大杯拿铁。请问需要加什么额外需求吗?比如加浓缩、不加糖等。\nHuman: 改成中杯,再加一份浓缩\nAI: 好的,已将你的订单修改为中杯热拿铁,并添加一份浓缩。请问你的地址是哪里?\nHuman: 地址是XX小区1栋\nAI: 好的,地址是XX小区1栋。你的订单已确认,预计30分钟送达。'}

解读:

- 意图识别:大模型从“改成中杯”中识别出“修改订单”意图;

- 槽位更新:从“改成中杯”中提取“杯型=中杯”,从“加一份浓缩”中提取“额外需求=加浓缩”;

- 上下文关联:记忆组件保存了“热拿铁”的历史槽位,所以系统知道“改的是之前的热拿铁”;

- 槽位补全:当“地址”为空时,系统自动询问用户补充。

3.3 数学模型:DST的“底层逻辑”

虽然大模型简化了DST的实现,但背后的数学原理仍值得了解。我们以槽位填充(DST的核心任务之一)为例,讲解两种常见模型:

1. 传统模型:条件随机场(CRF)

槽位填充本质是序列标注任务(给每个token打槽位标签),比如“热拿铁”中的“热”对应B-Temperature(温度开始),“拿”对应B-Drink(饮料开始),“铁”对应I-Drink(饮料继续)。

CRF的目标函数是最大化条件概率:

P(y∣x)=1Z(x)exp(∑i=1n∑k=1Kλkfk(yi−1,yi,x,i)) P(y|x) = \frac{1}{Z(x)} \exp\left( \sum_{i=1}^n \sum_{k=1}^K \lambda_k f_k(y_{i-1}, y_i, x, i) \right) P(y∣x)=Z(x)1exp(i=1∑nk=1∑Kλkfk(yi−1,yi,x,i))

其中:

- Z(x)Z(x)Z(x):归一化因子(确保概率和为1);

- fkf_kfk:特征函数(比如“当前token是‘热’,前一个标签是

O(非槽位),则当前标签是B-Temperature”); - λk\lambda_kλk:特征权重(表示特征的重要性);

- yiy_iyi:第iii个token的槽位标签;

- xxx:输入句子。

CRF的优点是能捕捉标签之间的依赖关系(比如B-Drink后面只能跟I-Drink),但需要手动设计特征,且对未见过的槽位泛化能力差。

2. 大模型:BERT-based序列标注

BERT通过自注意力机制捕捉上下文信息,无需手动设计特征。其槽位填充的流程是:

- 将输入句子转换为token序列(比如“热拿铁”→

[CLS]、热、拿、铁、[SEP]); - 用BERT编码每个token,得到隐藏状态hih_ihi;

- 用分类层(全连接+Softmax)预测每个token的槽位标签:

p(yi∣x)=Softmax(Whi+b) p(y_i|x) = \text{Softmax}(W h_i + b) p(yi∣x)=Softmax(Whi+b)

其中,WWW和bbb是分类层参数,p(yi∣x)p(y_i|x)p(yi∣x)是第iii个token属于各个标签的概率。

BERT的优点是泛化能力强,能处理未定义的槽位(比如“加浓缩”中的“浓缩”可以被识别为额外需求),但需要大量标注数据,且推理速度较慢。

四、实际应用:DST如何解决真实场景的复杂对话?

4.1 场景1:智能客服——订单修改

问题描述:用户说“我昨天订的手机,地址填错了,改成XX小区3栋”,系统需要:

- 关联历史订单(“昨天订的手机”);

- 识别修改意图(“修改地址”);

- 更新地址槽位(“XX小区3栋”)。

DST实现步骤:

- 上下文关联:用

ConversationSummaryMemory总结历史对话(比如“用户昨天订了一部iPhone 14,地址是YY小区2栋”); - 意图识别:大模型从“地址填错了,改成XX小区3栋”中识别出“修改订单”意图;

- 槽位更新:提取“地址=XX小区3栋”,并关联历史订单ID;

- 系统行动:调用订单系统API修改地址,反馈用户“地址已修改,预计明天送达”。

代码片段(LangChain):

from langchain.memory import ConversationSummaryMemory

# 用SummaryMemory总结历史对话(减少上下文长度)

memory = ConversationSummaryMemory(llm=llm)

# 模拟历史对话

memory.save_context({"input": "我想订一部iPhone 14,地址是YY小区2栋"}, {"output": "订单已确认,预计后天送达"})

# 用户输入:“我昨天订的手机,地址填错了,改成XX小区3栋”

user_input = "我昨天订的手机,地址填错了,改成XX小区3栋"

response = conversation_chain.predict(input=user_input)

print(response)

输出:“好的,已将你昨天订的iPhone 14的地址修改为XX小区3栋,预计明天送达。”

4.2 场景2:旅行规划——多轮调整

问题描述:用户说“我想下周末去北京,住三晚,预算2000块,要靠近故宫的酒店”,下一轮说“改成两晚,预算加500”,系统需要:

- 跟踪槽位变化(

住宿天数=3→2、预算=2000→2500); - 保持意图一致(

旅行规划); - 调用旅行API搜索符合新条件的酒店。

DST实现步骤:

- 初始化状态:用户第一次输入后,DST模块填充槽位

目的地=北京、时间=下周末、住宿天数=3、预算=2000、酒店位置=靠近故宫; - 更新状态:用户第二次输入后,DST模块更新槽位

住宿天数=2、预算=2500; - 系统行动:调用旅行API,传入更新后的槽位,返回符合条件的酒店列表(比如“故宫附近,两晚,2500预算”的酒店);

- 反馈用户:“根据你的调整,为你推荐以下酒店:XX酒店(步行10分钟到故宫,两晚2300元)、YY酒店(地铁1站到故宫,两晚2400元)。”

关键亮点:DST模块能增量更新槽位(只修改变化的部分,不重新输入所有信息),提升了对话效率。

4.3 常见问题及解决方案

在实际应用中,DST常遇到以下问题,我们给出对应的解决方案:

| 问题 | 解决方案 | 例子 |

|---|---|---|

| 上下文丢失 | 使用总结记忆(如ConversationSummaryMemory),将长对话总结为关键信息 |

用户说“之前的订单”,系统从总结中获取“订单ID=123” |

| 未定义槽位 | 使用大模型的零样本学习能力,识别未提前定义的槽位 | 用户说“加一份燕麦奶”,系统自动添加额外需求=燕麦奶 |

| 多意图处理 | 使用意图分层模型(如先识别主意图,再识别次要意图) | 用户说“订咖啡,顺便问天气”,系统先处理“订咖啡”,再回答“天气” |

| 幻觉(Hallucination) | 结合知识库或实时数据验证,确保槽位信息准确 | 系统识别“地址=XX小区3栋”后,调用地图API验证地址是否存在 |

五、未来展望:DST的“进化方向”

5.1 趋势1:深度上下文理解——从“记住”到“理解”

未来的DST将不仅能“记住”用户说过的话,更能“理解”话背后的隐含需求。比如:

- 用户说“今天天气真好”,系统能识别出“可能想出去游玩”,从而推荐附近的景点;

- 用户说“我有点累”,系统能识别出“可能想取消今天的约会”,从而询问“需要帮你取消今天的约会吗?”。

实现这一目标需要结合场景知识(比如天气与游玩的关联)和用户历史行为(比如用户之前喜欢爬山),用大模型的因果推理能力(Causal Reasoning)提升上下文理解的深度。

5.2 趋势2:灵活槽位管理——从“固定”到“动态”

当前的DST需要提前定义槽位(比如“饮料类型”“杯型”),但未来的DST将支持动态槽位——根据对话场景自动添加槽位。比如:

- 用户说“我想订一张明天去上海的高铁票,靠窗的位置”,系统自动添加

座位偏好=靠窗槽位; - 用户说“我想订一个生日蛋糕,要巧克力味的,上面写‘生日快乐’”,系统自动添加

蛋糕口味=巧克力、祝福语=生日快乐槽位。

动态槽位的实现需要大模型具备开放域槽位识别能力(Open-Domain Slot Detection),比如用GPT-4的function calling功能,根据用户输入动态生成槽位。

5.3 趋势3:跨模态DST——从“文本”到“多模态”

随着AI原生应用的发展,对话将不再局限于文本,而是结合语音、图像、视频等多模态信息。比如:

- 用户发一张咖啡的图片,说“我要这个,大杯”,系统需要从图片中识别“饮料类型=拿铁”,并跟踪“杯型=大杯”槽位;

- 用户用语音说“我想订一个像上次那样的蛋糕”,系统需要从语音中识别“意图=订蛋糕”,并从历史图像中获取“蛋糕样式=草莓味,带蜡烛”槽位。

跨模态DST的核心是多模态融合(Multimodal Fusion),比如用CLIP模型将图像与文本关联,用Whisper模型将语音转换为文本,再结合DST模块处理。

5.4 挑战与机遇

- 挑战:大模型的幻觉问题(生成错误的槽位信息)、多语言对话状态跟踪(比如中英文混合对话)、实时性要求(比如客服系统需要快速响应);

- 机遇:随着大模型能力的提升(比如GPT-5、Claude 3 Opus),DST的准确性和灵活性将大幅提升,推动AI原生应用进入“真正理解用户”的新阶段。

六、结尾:DST是AI原生应用的“对话基石”

6.1 总结要点

- DST是什么:对话的“记忆管家”,维护包含槽位、意图、上下文的对话状态;

- 为什么重要:解决复杂对话中的上下文丢失、意图混淆、多轮依赖问题;

- 如何实现:用大模型(如GPT-3.5)处理自然语言理解,用记忆组件(如LangChain的Memory)保存对话状态;

- 未来趋势:深度上下文理解、灵活槽位管理、跨模态DST。

6.2 思考问题

- 如何平衡DST的灵活性(处理未定义槽位)和准确性(避免幻觉)?

- 跨模态DST需要解决哪些关键技术问题(比如多模态信息融合、实时处理)?

- DST在医疗、教育等专业领域的应用,需要注意哪些伦理问题(比如患者隐私、教育内容准确性)?

6.3 参考资源

- 论文:《Dialog State Tracking: A Survey》(DST综述)、《BERT for Joint Intent Classification and Slot Filling》(BERT在DST中的应用);

- 书籍:《Building Dialogue Systems》(对话系统构建)、《Natural Language Processing with Transformers》(Transformer在NLP中的应用);

- 工具:LangChain(对话链构建)、Hugging Face Transformers(大模型调用)、Rasa(开源对话系统框架)。

结语:

对话状态跟踪是AI原生应用的“对话基石”——没有DST,再强大的大模型也无法处理复杂的多轮交互。未来,随着DST技术的进化,AI将不仅能“听懂”用户的话,更能“理解”用户的需求,成为真正的“智能助手”。

如果你对DST感兴趣,不妨从本文的代码示例开始,亲手实现一个简单的智能助手——相信你会对“对话状态”有更深刻的理解!

更多推荐

已为社区贡献96条内容

已为社区贡献96条内容

所有评论(0)