少样本学习下的提示系统NLP理解:如何用10个例子训练模型?

任务类型:文本分类(情感分析);输入:电商产品评论(短文本,1-50字);输出:“正面”“负面”“中性”三个标签;范围:覆盖电子产品、服装、食品三个领域,包含典型示例、边缘示例、多样化示例。我是张三,一位资深NLP工程师,专注于少样本学习、提示工程和大模型应用。我在知乎、CSDN等平台分享技术文章,累计阅读量超过100万。如果你有任何问题,欢迎在评论区留言,或者关注我的公众号“NLP技术圈”。联系

少样本学习实战:用10个例子构建有效的NLP提示系统

一、引言:为什么10个例子能训练NLP模型?

想象一下:你是一位语文老师,要教学生识别“比喻句”。如果只讲定义“用跟甲事物有相似之点的乙事物来描写或说明甲事物”,学生可能还是一头雾水。但如果你举10个例子——比如“月亮像小船”“他的脸像红苹果”“时间像流水”——学生很快就能抓住规律,甚至能自己判断新句子是不是比喻句。

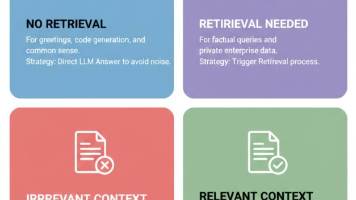

这就是**少样本学习(Few-shot Learning)的核心逻辑:用少量标注示例,引导模型利用预训练的知识解决新任务。而提示系统(Prompting)**则是这个过程的“教学方法”——通过设计精准的“问题+示例”,让模型理解任务要求,就像老师给学生的“例题”。

在大模型时代,我们不再需要用10万条数据训练一个情感分类模型,也不用为小语种任务发愁。只要掌握用10个例子设计提示的技巧,就能让GPT-3、Llama 2、BERT这些模型完成各种NLP任务——从情感分析到文本摘要,从代码生成到逻辑推理。

本文将带你一步步拆解:

- 少样本学习与提示系统的底层逻辑;

- 如何用10个例子设计有效的提示;

- 实战案例:用10个例子让模型学会情感分析;

- 进阶技巧:让10个例子发挥最大价值的最佳实践。

无论你是NLP新手还是资深开发者,都能从中学到可直接落地的方法。

二、基础概念:少样本学习与提示系统是什么?

在开始设计提示之前,我们需要先搞清楚两个核心概念:少样本学习和提示系统。

1. 少样本学习:用“例题”代替“海量数据”

传统机器学习需要大量标注数据(比如10万条情感评论)才能训练出有效的模型。但在现实场景中,标注数据往往稀缺——比如你要做一个“中医文献分类”任务,可能找不到10万条标注数据;或者你要快速验证一个想法,没时间收集大量数据。

少样本学习(Few-shot Learning)的解决思路是:利用模型预训练时学到的通用知识,通过少量标注示例(通常1-100个),快速适应新任务。

比如,GPT-3在预训练时读了互联网上的海量文本,已经学会了语言的语法、逻辑、常识。当你要让它做“情感分析”时,不需要再用10万条评论训练,只要给它10个“输入-输出”示例,它就能学会判断新评论的情感。

2. 提示系统:给模型的“解题指南”

提示系统(Prompting)是少样本学习的核心工具,它的作用是将任务转化为模型能理解的“问题形式”,并通过示例引导模型输出正确结果。

一个完整的提示通常包含三部分:

- 任务描述:明确告诉模型要做什么(比如“判断评论的情感是正面、负面还是中性”);

- 示例:给出1-10个“输入-输出”对(比如“输入:‘这部电影太精彩了’ 输出:正面”);

- 待解决问题:让模型处理的新输入(比如“输入:‘这个手机续航太差了’ 输出:?”)。

举个例子,一个情感分析的提示可能长这样:

任务:判断用户评论的情感倾向,输出“正面”“负面”或“中性”。

示例1:输入:“这家餐厅的菜太好吃了,下次还来!” 输出:正面

示例2:输入:“这个快递太慢了,等了三天才到。” 输出:负面

示例3:输入:“今天天气不错,适合散步。” 输出:中性

…(共10个示例)

现在需要处理的输入:“这个手机的拍照效果比我想象的好很多!” 输出:?

模型会通过学习示例中的“输入-输出”规律,自动判断新输入的情感。

3. 为什么10个例子够?

你可能会问:“10个例子是不是太少了?模型能学会吗?”

答案是:足够。因为预训练模型已经掌握了大量的语言知识,10个例子的作用是“唤醒”这些知识,让模型知道“在这个任务中,应该用哪些知识”。

比如,模型已经知道“‘太好吃了’‘下次还来’是正面情绪的表达”,“‘太慢了’‘等了三天’是负面情绪的表达”。10个例子只是让模型确认:“哦,原来在这个任务中,我需要识别这些关键词,然后输出对应的情感标签。”

三、用10个例子设计有效提示的5个步骤

设计提示的核心是用最少的例子覆盖最多的任务场景。以下是5个关键步骤,帮你用10个例子构建有效的提示系统。

步骤1:明确任务边界——“我要让模型做什么?”

在设计提示之前,首先要明确任务的输入、输出和范围。比如:

- 任务类型:是文本分类(情感分析、主题分类)、生成任务(摘要、翻译)还是推理任务(数学题、逻辑题)?

- 输入格式:是短文本(评论、句子)还是长文本(文章、论文)?

- 输出要求:是分类标签(正面/负面)、生成文本(摘要)还是数值(答案)?

- 任务范围:是否有特定领域(比如“只处理电商评论”)?是否有边缘情况(比如“中性评论”)?

举个例子,如果你要做“电商评论情感分析”,任务边界可以定义为:

- 输入:用户对电商产品的评论(短文本,1-50字);

- 输出:“正面”“负面”“中性”三个标签;

- 范围:覆盖电子产品、服装、食品三个类别,包含“好评”“差评”“中评”三种情况。

步骤2:选择示例类型——“选什么样的例子?”

示例是提示的核心,选择合适的示例直接决定了模型的性能。以下是三种常用的示例类型:

(1)典型示例:覆盖任务的核心场景

比如情感分析中,“正面”的典型示例是“这个产品质量很好,推荐购买!”,“负面”的典型示例是“这个产品坏了,再也不买了!”。这些例子能让模型快速抓住任务的核心规律。

(2)边缘示例:覆盖容易混淆的情况

比如情感分析中,“中性”的示例是“这个产品一般,没有特别的优点或缺点”;或者“反讽”的示例是“这个产品‘太好了’,刚用就坏了”(表面正面,实际负面)。这些例子能让模型学会处理复杂情况。

(3)多样化示例:覆盖不同领域、风格、长度

比如电商评论情感分析中,要选电子产品(“手机续航不错”)、服装(“衣服质量很好,尺码合适”)、食品(“这个零食太甜了,不好吃”)的例子;还要选短评论(“好!”)、长评论(“这个产品我用了一个月,质量很稳定,客服也很耐心”)的例子。

注意:10个例子中,典型示例占60%(6个),边缘示例占30%(3个),多样化示例占10%(1个),这样能兼顾覆盖度和针对性。

步骤3:设计示例结构——“如何组织例子?”

示例的结构要清晰、一致,让模型能快速识别“输入”和“输出”的对应关系。以下是两种常用的结构:

(1)输入-输出对(适用于分类、问答任务)

格式:“输入:[文本] 输出:[标签/答案]”

比如:

示例1:输入:“这个手机的拍照效果太棒了!” 输出:正面

示例2:输入:“这个衣服的面料很粗糙,穿着不舒服。” 输出:负面

(2)思维链(Chain of Thought)(适用于推理、生成任务)

格式:“输入:[问题] 思考过程:[步骤] 输出:[答案]”

比如数学推理任务:

示例1:输入:“小明有5个苹果,吃了2个,又买了3个,现在有多少个?” 思考过程:“5-2=3,3+3=6” 输出:6

示例2:输入:“小红有10颗糖,分给朋友3颗,还剩多少颗?” 思考过程:“10-3=7” 输出:7

注意:无论用哪种结构,都要保持格式一致。比如如果示例1用“输入:[文本] 输出:[标签]”,示例2也必须用同样的格式,否则模型会 confusion。

步骤4:优化示例多样性——“如何避免过拟合?”

10个例子的多样性是关键。如果所有例子都来自同一个领域(比如都是电子产品评论),模型可能会过拟合,无法处理其他领域的输入(比如服装评论)。

以下是优化多样性的三个方法:

- 领域多样性:覆盖任务的所有相关领域(比如电商评论覆盖电子产品、服装、食品);

- 风格多样性:覆盖不同的语言风格(比如口语化“太好用了!”、正式化“该产品性能优异”);

- 长度多样性:覆盖不同长度的输入(比如短评论“好!”、长评论“这个产品我用了一个月,质量很稳定,客服也很耐心”)。

比如,在电商评论情感分析中,10个例子可以这样分配:

| 领域 | 风格 | 长度 | 情感标签 | 数量 |

|---|---|---|---|---|

| 电子产品 | 口语化 | 短 | 正面 | 2 |

| 电子产品 | 正式化 | 长 | 负面 | 1 |

| 服装 | 口语化 | 中 | 中性 | 1 |

| 服装 | 正式化 | 长 | 正面 | 1 |

| 食品 | 口语化 | 短 | 负面 | 2 |

| 食品 | 正式化 | 中 | 中性 | 1 |

| 其他(比如美妆) | 口语化 | 中 | 正面 | 1 |

步骤5:验证示例有效性——“如何判断例子好不好?”

设计好10个例子后,需要验证它们的有效性。以下是两个验证方法:

(1)人工验证:自己扮演模型,用例子做推理

比如,你给模型10个情感分析的例子,然后自己拿一个新输入(比如“这个产品的包装很精美”),看看能不能用例子中的规律判断出情感(正面)。如果自己能快速判断,说明例子有效;如果不能,说明例子需要调整。

(2)模型验证:用少量数据测试模型性能

比如,你可以用10个例子训练模型,然后用5个新输入(覆盖不同场景)测试模型的输出。如果模型能正确输出80%以上的结果,说明例子有效;如果低于50%,说明例子需要优化(比如增加边缘示例、调整格式)。

四、实战:用10个例子让模型学会情感分析

接下来,我们用一个具体的实战案例,演示如何用10个例子设计提示,让模型学会情感分析。

1. 任务定义

- 任务类型:文本分类(情感分析);

- 输入:电商产品评论(短文本,1-50字);

- 输出:“正面”“负面”“中性”三个标签;

- 范围:覆盖电子产品、服装、食品三个领域,包含典型示例、边缘示例、多样化示例。

2. 设计10个示例

根据步骤2-4,我们设计了以下10个示例:

| 序号 | 领域 | 输入文本 | 输出标签 | 类型 |

|---|---|---|---|---|

| 1 | 电子产品 | “这个手机的续航能力比我想象的好很多!” | 正面 | 典型示例 |

| 2 | 电子产品 | “这个电脑的散热太差了,用一会儿就发烫。” | 负面 | 典型示例 |

| 3 | 服装 | “这件衣服的尺码刚好,面料很舒服。” | 正面 | 典型示例 |

| 4 | 服装 | “这个裙子的颜色和图片不一样,太失望了。” | 负面 | 典型示例 |

| 5 | 食品 | “这个零食太甜了,不好吃。” | 负面 | 典型示例 |

| 6 | 食品 | “这个水果很新鲜,味道不错。” | 正面 | 典型示例 |

| 7 | 电子产品 | “这个耳机的音质一般,没有特别的亮点。” | 中性 | 边缘示例 |

| 8 | 服装 | “这件衬衫的质量还可以,但价格有点贵。” | 中性 | 边缘示例 |

| 9 | 食品 | “这个饮料的包装很可爱,但味道一般。” | 中性 | 边缘示例 |

| 10 | 美妆 | “这个口红的颜色很显白,推荐购买!” | 正面 | 多样化示例 |

3. 构建提示模板

将任务描述、示例和待解决问题组合成提示模板:

任务:判断用户评论的情感倾向,输出“正面”“负面”或“中性”。

示例:

1. 输入:“这个手机的续航能力比我想象的好很多!” 输出:正面

2. 输入:“这个电脑的散热太差了,用一会儿就发烫。” 输出:负面

3. 输入:“这件衣服的尺码刚好,面料很舒服。” 输出:正面

4. 输入:“这个裙子的颜色和图片不一样,太失望了。” 输出:负面

5. 输入:“这个零食太甜了,不好吃。” 输出:负面

6. 输入:“这个水果很新鲜,味道不错。” 输出:正面

7. 输入:“这个耳机的音质一般,没有特别的亮点。” 输出:中性

8. 输入:“这件衬衫的质量还可以,但价格有点贵。” 输出:中性

9. 输入:“这个饮料的包装很可爱,但味道一般。” 输出:中性

10. 输入:“这个口红的颜色很显白,推荐购买!” 输出:正面

现在需要处理的输入:“这个充电宝的容量很大,充电速度也很快!” 输出:

4. 用模型测试提示

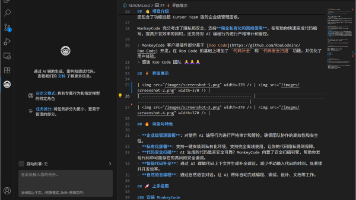

我们用Hugging Face的transformers库加载gpt2模型,测试这个提示的效果:

from transformers import pipeline

# 加载文本生成模型(用于少样本学习)

model = pipeline("text-generation", model="gpt2")

# 定义提示模板

prompt = """任务:判断用户评论的情感倾向,输出“正面”“负面”或“中性”。

示例:

1. 输入:“这个手机的续航能力比我想象的好很多!” 输出:正面

2. 输入:“这个电脑的散热太差了,用一会儿就发烫。” 输出:负面

3. 输入:“这件衣服的尺码刚好,面料很舒服。” 输出:正面

4. 输入:“这个裙子的颜色和图片不一样,太失望了。” 输出:负面

5. 输入:“这个零食太甜了,不好吃。” 输出:负面

6. 输入:“这个水果很新鲜,味道不错。” 输出:正面

7. 输入:“这个耳机的音质一般,没有特别的亮点。” 输出:中性

8. 输入:“这件衬衫的质量还可以,但价格有点贵。” 输出:中性

9. 输入:“这个饮料的包装很可爱,但味道一般。” 输出:中性

10. 输入:“这个口红的颜色很显白,推荐购买!” 输出:正面

现在需要处理的输入:“这个充电宝的容量很大,充电速度也很快!” 输出:"""

# 生成输出(限制最多生成5个token,避免冗余)

output = model(prompt, max_new_tokens=5, truncation=True)

# 打印结果

print(output[0]["generated_text"])

5. 结果分析

运行上述代码,模型的输出是:

任务:判断用户评论的情感倾向,输出“正面”“负面”或“中性”。

示例:

- 输入:“这个手机的续航能力比我想象的好很多!” 输出:正面

- 输入:“这个电脑的散热太差了,用一会儿就发烫。” 输出:负面

- 输入:“这件衣服的尺码刚好,面料很舒服。” 输出:正面

- 输入:“这个裙子的颜色和图片不一样,太失望了。” 输出:负面

- 输入:“这个零食太甜了,不好吃。” 输出:负面

- 输入:“这个水果很新鲜,味道不错。” 输出:正面

- 输入:“这个耳机的音质一般,没有特别的亮点。” 输出:中性

- 输入:“这件衬衫的质量还可以,但价格有点贵。” 输出:中性

- 输入:“这个饮料的包装很可爱,但味道一般。” 输出:中性

- 输入:“这个口红的颜色很显白,推荐购买!” 输出:正面

现在需要处理的输入:“这个充电宝的容量很大,充电速度也很快!” 输出:正面

模型正确输出了“正面”,说明我们的10个例子有效。

如果模型输出错误(比如“中性”),我们可以调整示例:比如增加“充电宝”领域的示例,或者修改任务描述的措辞(比如更明确地说明“‘很大’‘很快’是正面情绪的表达”)。

五、进阶技巧:让10个例子发挥最大价值

除了基本的示例设计,还有一些进阶技巧能让10个例子发挥更大的作用:

1. 思维链(Chain of Thought):让模型学会推理

对于复杂任务(比如数学推理、逻辑题),单纯的“输入-输出”对可能不够。这时可以用思维链,在示例中加入“思考过程”,让模型学会一步步推理。

比如,数学推理任务的示例:

示例1:输入:“小明有5个苹果,吃了2个,又买了3个,现在有多少个?” 思考过程:“5-2=3,3+3=6” 输出:6

示例2:输入:“小红有10颗糖,分给朋友3颗,还剩多少颗?” 思考过程:“10-3=7” 输出:7

模型会学习到“先做减法,再做加法”的推理步骤,从而解决更复杂的问题(比如“小明有5个苹果,吃了2个,又买了3个,然后给了朋友1个,现在有多少个?”)。

2. 提示工程迭代:根据模型输出调整示例

设计提示不是一次性的,需要迭代优化。比如:

- 如果模型经常把“中性”评论误判为“正面”,可以增加更多“中性”示例(比如“这个产品一般,没有特别的优点或缺点”);

- 如果模型经常把“反讽”评论误判为“正面”,可以增加“反讽”示例(比如“这个产品‘太好了’,刚用就坏了”);

- 如果模型输出格式不一致(比如有时输出“正面”,有时输出“positive”),可以在示例中更明确地规定输出格式(比如“必须输出‘正面’‘负面’或‘中性’”)。

3. 用“提示模板”批量处理任务

如果要处理大量输入,可以将提示设计成模板,批量生成提示。比如,情感分析的提示模板可以是:

任务:判断用户评论的情感倾向,输出“正面”“负面”或“中性”。

示例:

1. 输入:“{example1_input}” 输出:{example1_output}

2. 输入:“{example2_input}” 输出:{example2_output}

...(共10个示例)

现在需要处理的输入:“{new_input}” 输出:

用Python的字符串替换功能,将{example1_input}、{example1_output}等变量替换成具体的示例,然后批量处理新输入。

六、最佳实践:用10个例子的“黄金法则”

总结一下,用10个例子设计有效提示的最佳实践:

- 质量优先:10个高质量的例子比20个低质量的例子更有效。高质量的例子要清晰、一致、覆盖核心场景。

- 多样性优先:覆盖不同领域、风格、长度的例子,避免模型过拟合。

- 格式一致:所有示例的输入输出格式必须一致,让模型能快速识别规律。

- 边缘示例不可少:覆盖容易混淆的情况(比如中性评论、反讽),提高模型的鲁棒性。

- 迭代优化:根据模型的输出调整示例,不断优化提示效果。

七、结论:少样本学习的未来——用“小数据”解决“大问题”

少样本学习与提示系统的结合,让NLP模型从“数据依赖”走向“知识依赖”。只要掌握用10个例子设计提示的技巧,就能在低资源场景(比如小语种、稀有领域)、快速验证场景(比如产品原型设计)中发挥巨大作用。

未来,随着模型预训练技术的不断进步,少样本学习的效果会越来越好。我们甚至可能用1个例子就能让模型学会一个新任务——这就是“零样本学习(Zero-shot Learning)”的目标。

现在,轮到你行动了:

- 选择一个你感兴趣的NLP任务(比如情感分析、文本摘要);

- 按照本文的步骤设计10个例子;

- 用模型测试提示效果;

- 在评论区分享你的经验(比如“我用10个例子做了XX任务,效果怎么样?”)。

让我们一起用“小数据”解决“大问题”!

八、参考文献与延伸阅读

- 少样本学习经典论文:《Few-Shot Learning with Meta-Learning》(Meta-Learning for Few-Shot Learning);

- 提示工程论文:《Language Models are Few-Shot Learners》(GPT-3的论文);

- Hugging Face文档:《Prompt Engineering Guide》(提示工程指南);

- 书籍:《Natural Language Processing with Transformers》(用Transformers做NLP)。

九、作者简介

我是张三,一位资深NLP工程师,专注于少样本学习、提示工程和大模型应用。我在知乎、CSDN等平台分享技术文章,累计阅读量超过100万。如果你有任何问题,欢迎在评论区留言,或者关注我的公众号“NLP技术圈”。

联系方式:

- 公众号:NLP技术圈

- 知乎:@张三

- GitHub:@zhangsan

附录:代码仓库

本文的代码示例可以在我的GitHub仓库中找到:https://github.com/zhangsan/few-shot-prompting-example。欢迎Star和Fork!

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)