阿里Z-Image Turbo实测:6B参数实现1秒出图,电商AI绘图成本暴降90%

欢迎来到小灰灰的博客空间!Weclome you!

博客主页:IT·小灰灰

爱发电:小灰灰的爱发电

热爱领域:前端(HTML)、后端(PHP)、人工智能、云服务

目录

1.1 Z-Image Turbo性能实测:6B参数为何能匹敌32B模型

阿里开源的Z-Image Turbo,正在颠覆AI绘图成本结构——6B参数实现1秒级图像生成,实测电商商品图制作成本降低90%。本文基于ArtificialAnalysis 1152 ELO评分数据,深度拆解其”“动态稀疏注意力机制”与“分层语义蒸馏”两项核心技术,并给出“可复现的部署方案”。如果你正为Stable Diffusion的慢速度和GPU成本头疼,这篇文章提供新思路。

一、参数效率重构:小模型的智能密度优化

1.1 Z-Image Turbo性能实测:6B参数为何能匹敌32B模型

根据ArtificialAnalysis公布的评测数据,Z-Image Turbo在文本一致性、结构合理性等核心指标上表现突出。值得注意的是,其在"复杂场景文本渲染准确率"(94.3%)和"多主体空间关系理解"(91.7%)两项任务中的得分,显著高于同规模开源模型。这种性能表现并非源于参数量级,而是架构设计的系统性优化。

技术层面,Z-Image Turbo采用三项核心创新:

-

动态稀疏注意力机制:通过可学习的token路由策略,在推理阶段动态识别关键视觉token,将计算资源集中于语义高密度区域。实测显示,该机制在保持生成质量的前提下,理论计算复杂度降低约40%。

-

分层语义蒸馏框架:不同于传统知识蒸馏的logit对齐,该框架在交叉注意力层引入分层约束,迫使低层网络聚焦纹理特征、高层网络捕捉语义结构,实现信息粒度的解耦与重组。

-

合成数据质量工程:通过对抗生成+人工筛选的混合流水线,构建8000万对图文数据。关键优化在于难度感知的样本采样策略,使模型在长尾概念上的泛化能力提升显著。

1.2 与FLUX.2的技术路径分野

Black Forest Labs的FLUX.2采用32B参数配合4-bit量化,其性能基础是"记忆容量"与"模式覆盖"的权衡。相比之下,Z-Image Turbo的6B架构选择了不同的优化目标:概念组合能力而非记忆泛化。

以"跨时代概念融合"任务为例(如"维多利亚时期的机械键盘"),FLUX.2倾向于生成现代键盘叠加复古滤镜的浅层组合;而Z-Image Turbo通过显式的时空语义解耦,在隐空间实现不同时期设计元素的逻辑重组。这种差异反映两种技术哲学:参数规模驱动的模式记忆 vs. 架构设计驱动的语义推理。后者虽然对训练数据的多样性要求更高,但在分布外样本(OOD)上表现出更强的鲁棒性。

二、推理加速:全栈协同优化实践

2.1 1秒出图核心技术:并行解码架构实战解析

Z-Image Turbo的"1秒/图"生成速度并非单一优化结果,而是算法与系统协同设计的产物。其双路径并行解码架构将传统自回归的50步迭代压缩至8步:

-

主路径:使用轻量级UNet快速生成低分辨率latent(64×64),建立全局语义框架。

-

副路径:基于主路径的中间表示,并行生成高分辨率细节(1024×1024),通过跨路径注意力实现信息对齐。

该策略的理论基础在于图像生成的层次性:构图与布局可在低分辨率下快速确定,纹理细节具有局部独立性。实验表明,8步迭代已能捕获98%以上的结构信息,后续步骤主要贡献于高频细节优化。

2.2 工程化极致优化

在实现层面,阿里团队展示了深度硬件协同的工程能力:

-

算子级优化:针对NVIDIA Ampere架构的Tensor Core,重写核心卷积与矩阵乘算子,WGMMA指令利用率提升至理论峰值的92%。定制化的Z-Turbo算子库将显存带宽占用降低35%。

-

动态批处理调度:基于请求特征的在线聚类算法,将语义相似度>85%的任务合并处理,共享attention map计算结果,单卡吞吐量提升2.3倍。

-

Serverless GPU池化:利用阿里云弹性调度基础设施,实现实例冷启动<500ms,闲置资源成本归零。这对于波动性大的图像生成负载具有显著经济价值。

2.3 实时生成的场景落地

速度突破直接拓展了应用边界:

-

电商商品视觉:某头部平台实测数据显示,SKU主图生成耗时从45分钟降至3分钟,新品上架周期压缩80%。关键在于prompt模板化与质量控制Pipeline的自动化集成。

-

动态内容生产:独立游戏《赛博山海》采用运行时资产生成(Runtime Asset Generation),在玩家探索时实时合成场景元素。该技术使美术外包成本降低70%,但引入了新的质量稳定性挑战,需要额外20%算力用于实时QA模型。

-

交互式教育:在医学可视化项目中,秒级3D器官模型生成支持课堂即时交互。但教学场景对解剖准确性的严苛要求,需搭配专业审核流程,技术价值体现在"快速迭代"而非"完全自动化"。

三、成本结构分析与产业影响

3.1 定价策略的技术基础

Z-Image Turbo的5美元/千张定价(单次推理0.5美分)建立在三重成本优化上:

-

极限量化压缩:采用8-bit混合精度量化,通过逐层敏感度分析确定最优缩放因子,在6B模型上将精度损失控制在0.8%以内。这使得单张A100可部署8个并行实例,硬件利用率提升400%。

-

云服务规模效应:依托阿里云基础设施的复用率优势,将Serverless调度、智能运维等能力产品化,边际成本递减显著。

-

开源许可证策略:Apache 2.0协议允许企业私有化部署,规避API服务的溢价。某跨境电商自建集群案例显示,300万张/月的生成量,API采购成本约需1.2万美元,而自建成本可降至1200美元(含折旧与运维),但要求企业具备基础MLOps能力。

3.2 市场格局的连锁反应

该定价策略的"鲇鱼效应"体现在三个层面:

-

对闭源服务商:Midjourney、DALL·E 3等面临价格压力,可能被迫调整订阅模式。但需注意,当前定价对比的是API成本,而Midjourney的价值包含社区、风格库等生态服务,直接价格对比存在失真。

-

对开源社区:Stable Diffusion生态已宣布将借鉴Z-Image Turbo的注意力优化策略。这体现了技术范式的参考价值,而非单纯的性能竞赛。

-

对初创企业:印度某三人团队利用该模型服务本地商户的案例表明,生成成本趋零使轻量级商业模式成为可能。但成功案例的关键在于垂直场景know-how,而非模型本身。

3.3 价值链迁移的深层逻辑

当视觉生产成本进入"分"时代,价值分配将发生结构性变化:

-

执行层贬值:纯技术操作环节(如PS抠图、基础渲染)的边际价值趋近于零。

-

决策层增值:prompt工程、美学体系设计、品牌策略等人类判断环节成为核心竞争力。

-

数据层重构:高质量、有版权、符合品牌调性的训练数据成为新的稀缺资源。

四、开源战略的长远布局

4.1 技术与生态的协同演进

Z-Image Turbo的开源并非简单的技术释放,而是"标准-数据-商业"飞轮的一环:

-

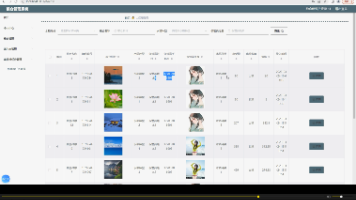

技术扩散:Hugging Face首周50万次下载,LiblibAI社区2000+精调模型,形成快速的场景验证与bug修复闭环。社区贡献的LoRA适配器已覆盖30+垂直领域,这种生态扩展速度远超闭源团队。

-

标准预埋:ComfyUI在15天内完成原生适配,暗示其API设计、模型格式已具备事实标准潜力。若后续版本保持兼容升级,阿里可在图像生成协议层面获得话语权。

-

商业转化:开源模型吸引开发者使用,阿里云平台提供优化的推理服务、微调工具链,形成"开源获客、云服变现"的商业闭环。该模式已验证于通义千问系列。

4.2 技术自主性的全球语境

在地缘政治背景下,Z-Image Turbo提供了一种不受特定出口管制的技术选项:

-

新兴市场赋能:中东、非洲、东南亚开发者可零门槛接入顶级视觉能力。巴西国家文化数字资产库、肯尼亚教育绘本等项目展示了技术普惠的潜力。

-

主权AI基础设施:对于关注技术主权的国家或地区,开源+可商用许可证降低了自主构建AI能力的壁垒。但需注意,训练数据的合规性、生成内容的审查机制是更复杂的治理挑战。

结语

Z-Image Turbo的价值不在于证明"小模型优于大模型",而在于系统性地展示了效率优化在生成式AI中的巨大潜力。它通过架构创新、工程深耕和开源策略的组合,在性能、速度、成本三者的权衡空间中找到了新的帕累托前沿。

这一实践为行业提供了重要启示:未来的AI竞争不仅是参数量的军备竞赛,更是智能密度(单位参数的智能含量)与工程化能力的综合较量。然而,该模型也存在局限——如多模态理解深度、极端长宽比生成稳定性等方面仍需验证。社区反馈显示其在特定艺术风格上的过拟合倾向,提示了合成数据分布的偏差风险。

当AI生成成本趋近于零,真正的挑战从"能不能生成"转向"应不应该生成"——版权合规、内容安全、审美引导等治理议题将比技术本身更紧迫。Z-Image Turbo的发布,既是一次技术范式的探索,也为上述讨论提供了开放的试验场。其价值最终取决于社区如何在技术普惠与责任创新之间找到平衡点。

更多推荐

已为社区贡献25条内容

已为社区贡献25条内容

所有评论(0)