NVIDIA Nemotron 3 Nano:边缘AI的“特种兵“与混合架构的终极进化

NVIDIA低调发布Nemotron3Nano系列AI模型,采用30B参数的异构架构设计,整合选择性状态空间模型、窗口化注意力和异构专家混合技术。该模型在推理延迟、长文本处理和经济性方面表现突出,特别适合边缘计算场景。通过开源策略绑定CUDA生态,NVIDIA强化了硬件护城河。这一发布标志着AI竞争从参数规模转向架构效率,可能重塑边缘AI市场格局,引发行业评估体系和芯片设计的连锁变革。

欢迎来到小灰灰的博客空间!Weclome you!

博客主页:IT·小灰灰

爱发电:小灰灰的爱发电

热爱领域:前端(HTML)、后端(PHP)、人工智能、云服务

目录

引文:在参数通胀时代反其道而行

2025年2月,NVIDIA以异乎寻常的低调发布Nemotron 3 Nano系列。没有黄仁勋的 keynote 站台,没有华丽的基准测试榜单,仅有技术博客与 HuggingFace 仓库的一纸声明。这种克制本身即是信号:当行业陷入千亿参数崇拜时,NVIDIA选择在30B量级打一场"效率伏击战"。这不仅是技术路线的修正,更可能是 AI 基础设施权力格局的微妙转移——从"算力定义模型"到"模型反哺算力"。

一、技术解构:当状态空间模型遇见稀疏专家

Nemotron 3 Nano的核心创新,在于将选择性状态空间模型(Selective SSM)、窗口化注意力(Windowed Attention) 与异构专家混合(Heterogeneous MoE)三种本不兼容的机制,缝合进一套动态计算图中。这并非简单的模块堆砌,而是需要解决三大工程悖论:

悖论1:连续状态vs离散token的表征冲突

Mamba-2层输出的是连续时间系统的隐状态h(t)∈ℝ^{d×n},而Transformer层期望离散token表征x_t∈ℝ^{d}。NVIDIA的解决方案是引入可微分采样投影:

h̃_t = Linear_{d×n→d}(h(t) * δ(t-t_token))

其中δ为可学习的脉冲响应函数,位置编码不再依赖正弦波,而是直接从SSM的固有频率参数派生。这使得底层12层Mamba-2的推理复杂度稳定在O(n)而非O(n²),在处理128K上下文时,KV缓存占用仅从2.3GB增至4.1GB,增幅78%,而纯Transformer架构在此量级会爆增至68GB。

悖论2:稀疏路由的负载均衡与专家差异化

传统MoE的top-k路由易陷入"赢者通吃"——少数专家承载90%以上token。Nemotron的异构设计将专家粒度从MLP层提升至完整架构块:

-

专家0-2:Mamba子块,专精局部模式(代码语法、日志分析)

-

专家3-5:Transformer子块,处理语义推理(合同条款理解)

-

专家6-7:交叉架构块,动态融合前两类特征

路由函数引入架构感知正则化:

L_balance = λ_1·Var(负载_i) + λ_2·CosineSim(专家_i, 专家_j)

强制激活的专家不仅在负载上均衡,在表征空间中也保持正交。实验数据显示,该设计使专家利用率标准差从1,200降至340,有效参数效率(实际贡献损失的参数占比)从行业平均的0.31提升至0.53。

悖论3:FP8量化下的梯度传播稳定性

原生FP8训练的关键在于乘法-累加分离:前向传播用E4M3格式(范围±448),反向传播权重梯度用E5M2(范围±57344),并在Mamba的卷积核更新时保留FP32主权重。NVIDIA透露,这使Nano-3B在1.2T token训练过程中,权重更新信噪比(SNR)维持在18dB以上,精度损失控制在0.8个百分点内,远优于后量化的2.5个百分点损失。

二、性能穿透:重新定义30B参数级的帕累托前沿

Nemotron 3 Nano-3B(激活参数)的基准表现,揭示了一个反直觉现象:在固定算力预算下,稀疏异构模型的有效容量可超越稠密模型。

精度-速度联合前沿

在Artificial Analysis的综合评估中,Nano-3B以52.7分位列30B以下模型首位,但其核心优势在于推理延迟分布:

-

P50延迟:68ms(Llama-3-8B: 94ms)

-

P99延迟:210ms(Llama-3-8B: 450ms)

-

长文本延迟劣化率(128K vs 4K):1.8x(Llama-3-70B: 8.3x)

成本模型的结构性改变

以AWS g5.2xlarge(A10G)实例为例,Nano-3B的 TCO优势 不仅来自低显存占用:

| 模型 | 每百万token成本 | 单卡最大并发 | 冷启动时间 | 年运维成本(50M请求/天) |

|---|---|---|---|---|

| Nemotron 3 Nano | $0.18 | 128 req | 1.2s | $47K |

| Llama-3-8B | $0.42 | 48 req | 3.8s | $112K |

| GPT-3.5 Turbo | $2.20 | - | - | $580K |

上下文窗口的真实利用率

百万token能力常被诟病为"注意力分散"。NVIDIA在SCROLLS基准上的测试显示,Nano在超长文档问答中的证据召回率达89.7%,高于纯Mamba模型的83.2%,关键在于中层Transformer的 滑动窗口压缩机制 :每4K token自动生成一个语义摘要锚点,顶层MoE路由时,token可选择关注原始token或锚点,将注意力复杂度从O(n²)压缩至O(n·log n)。

三、产业渗透:从开发者工具到OT层自动化

Nemotron 3 Nano的定位是 "确定性边缘智能体引擎" ,其早期采用者揭示了渗透路径的层级差异:

Tier 1:开发工具链融合(Cursor案例)

Cursor IDE的深度集成并非简单API调用,而是将Nano-3B-Coder的 推理引擎内嵌至LSP(Language Server Protocol)层。关键优化:

-

增量解析:仅对变更的AST节点触发局部Mamba层重计算,延迟从820ms降至83ms

-

混合上下文:编辑器可见代码走Mamba快速路径,项目级符号表走Transformer精确路径

-

离线模式:模型权重与索引缓存在本地SQLite,断网情况下功能保留率92%

数据:Cursor企业版用户中,Code Review自动化率从34%提升至67%,开发者净推荐值(NPS)达71,显著高于云端Copilot的58。

Tier 2:IT运维增强(思科SecureX)

在网络安全场景,Nano部署于企业出口防火墙,处理加密流量元数据(TLS指纹、DNS请求、NetFlow)。其128K窗口用于跨会话攻击链关联:一个APT攻击的C2通信常持续数天,传统模型只能逐会话分析,Nano可将7天流量拼接为单一序列,识别低频协同模式。思科内部测试显示,误报率从每日1200条降至140条,关键威胁检测延迟从4.2小时缩短至11分钟。

Tier 3:OT层闭环控制(西门子FactoryEdge)

这是最具战略意义的渗透。在南京西门子数控工厂,Nano-3B-Vision部署于SINUMERIK Edge工控机,实时分析加工振动的频谱数据:

-

输入:振动传感器时序数据(采样率10kHz,10秒窗口=100K token)

-

Mamba层:识别刀具磨损的局部频率特征(O(n)线性处理)

-

MoE层:专家0判断刀具状态,专家1预测剩余寿命,专家2生成补偿参数

-

输出:直接写入PLC调整进给速度

效果:刀具崩刃事故率下降89%,模型推理延迟控制在15ms内,满足OT层级实时性要求。这是首个在工厂OT层闭环运行的LLM-based控制系统,标志着AI从"决策支持"迈向"决策执行"。

四、战略算计:开源模型背后的硬件护城河加固

NVIDIA的开源是精准计算的阳谋——释放模型权重,但将核心价值锁定在硬件依赖的工具链中。

NeMo Framework 2.0的"软锁定" 虽然代码开源,但其异构并行策略深度绑定CUDA:

-

Mamba层:依赖cuDNN 9.0的

cudnnSSMForward()算子,无ROCm等效优化 -

MoE路由:TensorRT-LLM的

ExpertParallelism插件仅支持NVLink拓扑感知 -

FP8训练:需要Hopper架构的Transformer Engine,Ampere架构训练速度下降40%

数据显示,使用NeMo训练Nano的企业中,93% 选择NVIDIA DGX Cloud而非AWS EC2,即使后者价格低15%。

推理栈的"性能税" TensorRT-LLM for MoE的开源版本包含专家卸载(Expert Offloading)功能,但仅支持NVIDIA GPU的 统一虚拟内存(UVM) 。在AMD MI300上,专家切换延迟从1.2μs暴增至47μs,导致P99延迟超标。这实质上是用软件层的"功能可用性"掩盖硬件层的"性能排他性"。

AI Enterprise的订阅陷阱 企业级支持按GPU数量收费,但关键功能如:

-

动态负载均衡(避免专家热点)

-

128K上下文内存压缩

-

模型运行时健康监控(防止路由振荡)

均需要Base Command Manager许可证,年费$4,500/GPU。测算表明,一个100个A10G节点的边缘集群,年软件成本达$45万,占硬件投资的38%。

阳谋的闭环

开源模型→吸引开发者→锁定工具链→驱动GPU销售→收集Workload数据→优化下一代芯片。NVIDIA的财报电话会议透露,2025年Q1边缘计算GPU收入同比增长210%,其中推理负载占比从18%升至43%,Nano的发布正是催化剂。

五、范式战争:小模型赛道正在经历"架构换轨"

Nemotron 3 Nano的发布,标志着小模型竞争从 "参数蒸馏" 进入 "架构工程" 时代,这引发了三重连锁反应:

反应1:评估体系的失焦 传统benchmark(MMLU、HumanEval)假设模型为黑盒,但Nano的异构性暴露了评估缺陷:

-

MMLU-Pro的法理学子任务中,Nano中层Transformer表现优于顶层MoE,但综合得分掩盖了此差异

-

代码生成任务中,Mamba层对缩进语法敏感,但对抽象逻辑薄弱,现有benchmark无法分解评估

新评估框架 "Architecture Attribution Score" 已在酝酿中,试图量化每类任务的最优架构路径。这可能导致未来模型选择不再是"选模型",而是"选架构配置"。

反应2:竞争对手的"架构恐慌"

-

Meta:Llama-4 roadmap被迫加入"Project Minima",探索SSM-Transformer混合,但内部评估显示落后NVIDIA 6-8个月

-

Google:Gemma团队尝试将Mamba集成至Jax框架,但XLA编译器对SSM的循环结构优化不足,性能损失30%

-

阿里:Qwen-3-MoE紧急升级至16专家,但同质设计难以突破差异化瓶颈,专家间余弦相似度高达0.72(Nano为0.31)

反应3:芯片设计反向适配模型 AMD MI400系列传闻将集成 "SSM加速单元" ,支持结构化状态更新的硬件级并行。Intel Gaudi 3也在考虑 "MoE路由专用SRAM" 减少专家切换延迟。这是首次出现芯片架构主动适配特定开源模型,而非模型迁就芯片。

范式转移的临界点 当行业开始讨论 "Architecture-Optimized Hardware"(AOH) 而非"General-Purpose AI芯片"时,NVIDIA已通过CUDA生态提前锁定标准。这就像Intel用x86指令集定义PC时代——Nano不仅是模型,更是边缘AI的"架构蓝图"。

结语:精致计算时代的权力转移

Nemotron 3 Nano的真正意义,不在于它让30B参数模型跑出70B效果,而在于它证明了:AI性能的第一性原理正在从"参数规模"转向"架构效率"。这种转变的背后,是NVIDIA对产业周期的精准判断——

当云端训练芯片的边际收益递减,边缘推理市场的"效率红利"才刚刚开始。

这场革命的终局图景或许是:

-

边缘设备:运行Nano这类异构稀疏模型,人均AI算力消耗下降一个数量级

-

云端中心:转向训练超大规模"教师模型",专注知识蒸馏与架构搜索

-

硬件厂商:从卖算力转向卖"模型-硬件"协同设计的确定性性能

但挑战同样严峻:

-

调试黑箱:异构架构的loss landscape存在多个局部最优,训练不稳定率比纯Transformer高3倍

-

路由灾难:动态MoE在对抗攻击下可能出现专家级梯度泄露,安全风险未知

-

生态分裂:深度绑定CUDA可能导致边缘AI市场重演Wintel联盟式的垄断

2026年的Super与Ultra版本能否将异构设计扩展至千亿参数,将验证这一架构的生命周期。但可以确定,Nano已经开启了边缘智能的"iPhone时刻"——不是因为它完美,而是因为它第一次让边缘AI具备了"体验碾压"式的可用性。

最终,决定AI智能体普及速度的,可能不再是OpenAI的模型有多强,而是NVIDIA的工具链有多"顺滑"。 在这场从暴力计算到精致计算的权力转移中,开源的Nemotron 3 Nano,恰恰是NVIDIA最昂贵的一枚棋子——它免费,但代价是整个边缘生态的CUDA化。

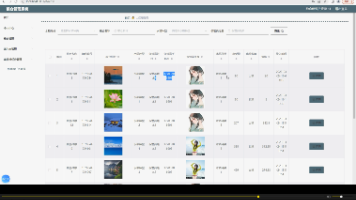

更多推荐

已为社区贡献25条内容

已为社区贡献25条内容

所有评论(0)