Triton-Ascend 算子开发基础与实战指南

摘要:《Triton-Ascend算子开发基础与实战指南》介绍了基于昇腾NPU的高效算子开发方法。传统昇腾算子开发需手写ASCENDC/汇编,而Triton-Ascend结合Python编程便捷性与昇腾硬件特性(如AICore、UB缓存、Cube单元),提供更优的开发体验。文章详细解析了昇腾特化的SPMD模型、核心概念差异,并通过向量加法等实战案例,重点阐述了UB分配、Cube单元适配、内存调度等

Triton-Ascend 算子开发基础与实战指南

1. 背景介绍与核心价值

大模型时代下,昇腾 NPU(如 910B)的算力释放高度依赖高效算子实现。传统昇腾算子开发需手写 ASCEND C/汇编,学习成本高且优化难度大;而 Triton-Ascend 基于 Triton 编译器架构,将 Python 级别的高层编程接口与昇腾 NPU 硬件特性深度融合,既保留了 Triton 「Python 写 Kernel」的便捷性,又针对性适配了昇腾 AI Core、UB 缓存、Cube 计算单元等核心硬件特性。

本篇文章全程围绕 Triton-Ascend 昇腾后端设计学习路径,从昇腾特化的 SPMD 模型讲起,通过实战案例,拆解昇腾 NPU 算子开发的核心要点(UB 分配、Cube 单元适配、内存调度),并分析官方典型 Kernel 的优化思路,最终形成「理解硬件→实现算子→性能调优」的完整闭环。

2. Triton-Ascend 核心概念:适配昇腾的 SPMD 模型

2.1 从 GPU 并行到昇腾 NPU 并行的核心差异

传统 GPU 并行思维(通用 Triton)聚焦 SM 单元、Shared Memory 调度;而 Triton-Ascend 的 SPMD 模型需深度适配昇腾硬件架构:

|

维度 |

GPU (通用 Triton) |

昇腾 NPU (Triton-Ascend) |

|

计算核心 |

SM 单元(通用计算) |

AI Core(含 Cube/Vector 专用单元) |

|

片上缓存 |

Shared Memory (几十KB) |

UB (Unified Buffer,256KB/AI Core) |

|

并行调度 |

Grid→Block |

Grid→Block(映射到 AI Core)→UB/L1分片 |

|

核心优化点 |

全局内存合并访存 |

UB 分配/ Cube 单元粒度对齐/寄存器调度 |

2.2 Triton-Ascend 的 SPMD 层级(昇腾特化)

Triton-Ascend 对 SPMD 模型做了昇腾硬件定制,核心层级关系直接映射到昇腾 NPU 物理资源:

- Grid:对应整个算子任务的并行规模,每个 Grid 维度映射到昇腾 AI Core 集群的维度(如 2D Grid 对应 AI Core 的行列排布);

- Block:一个 Block 固定调度到单个 AI Core 执行,Block 大小直接决定 AI Core 的 UB/寄存器占用;

核心认知:Triton-Ascend 的 SPMD 编程本质是「将计算任务拆解到多个 AI Core,每个 AI Core 利用 UB/寄存器完成本地计算」,所有优化都围绕「最大化 AI Core 利用率、减少 Global Memory 访存」展开。

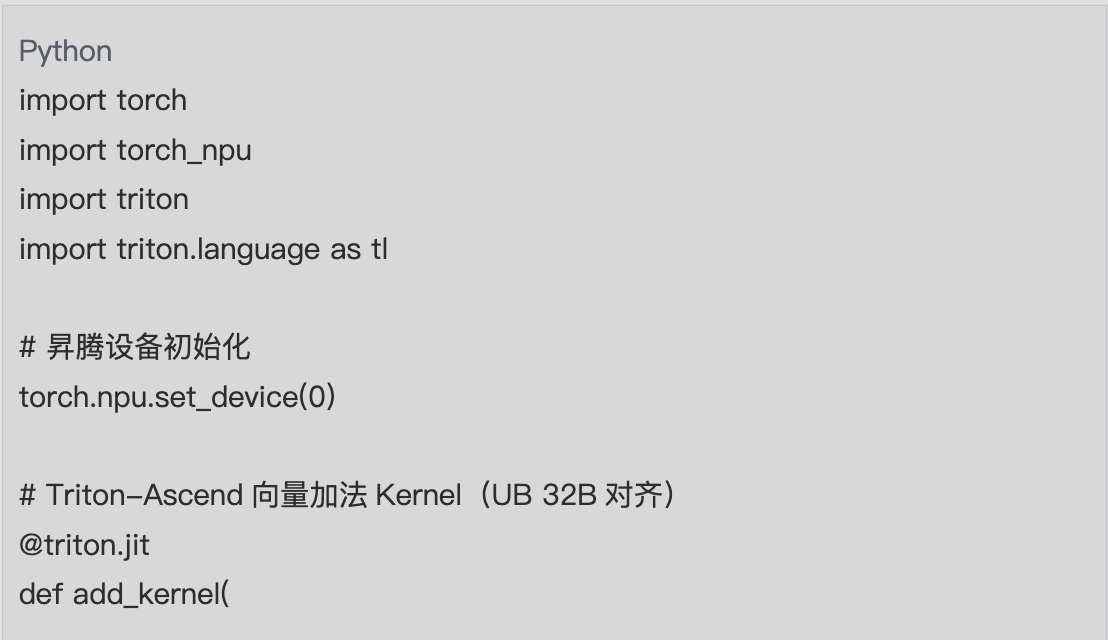

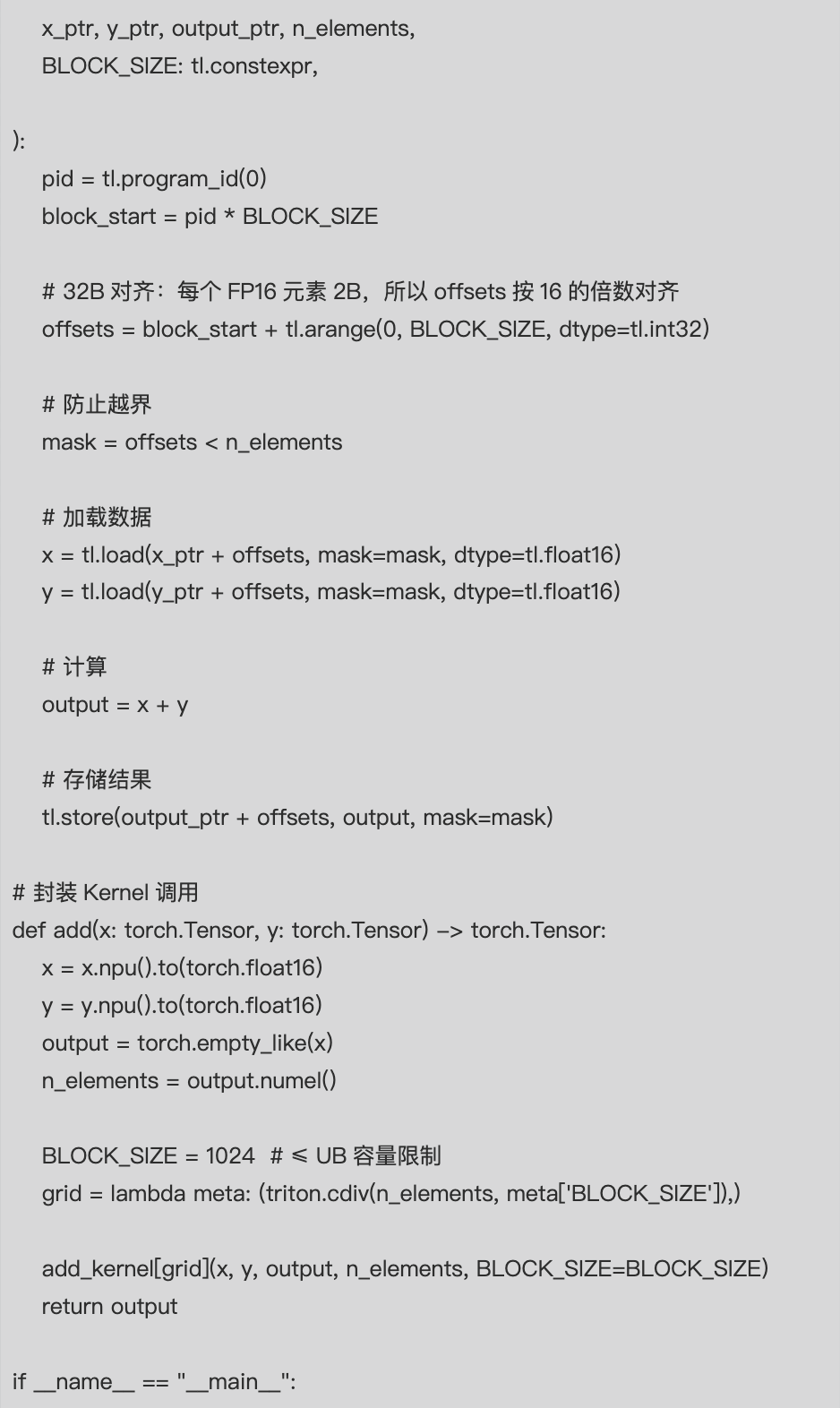

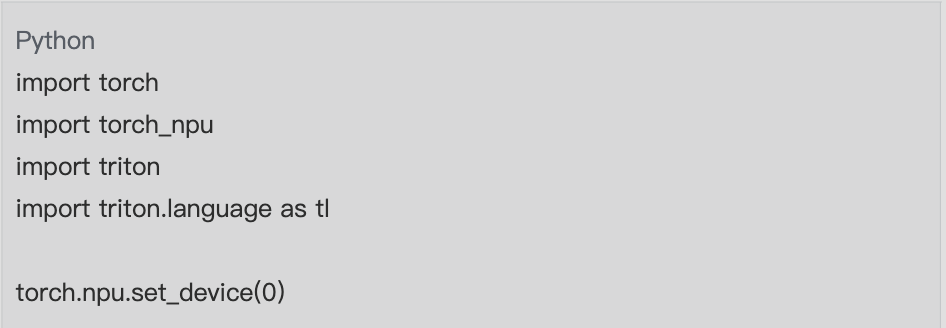

3. Triton-Ascend 基础实战:向量加法

向量加法是理解 Triton-Ascend 基础流程的最小案例,重点体现昇腾特化的 Mask 机制、UB 适配、数据类型选择,代码可直接在昇腾 NPU 环境运行。

3.1 实战代码

3.2 核心关键点解析

- 设备与数据类型:必须显式绑定昇腾 NPU(torch.npu.set_device),且优先使用 float16——昇腾 AI Core 对 FP16 的计算效率是 FP32 的 2 倍以上;

- BLOCK_SIZE 限制:昇腾每个 AI Core 的 UB 仅 192KB,BLOCK_SIZE 过大(如 4096)会导致 UB 溢出,建议 1024/2048 为最优值;

- Mask 机制:昇腾 NPU 对越界访问无容错性(GPU 可能仅报警,昇腾直接 Device Hang),Mask 必须严格过滤无效偏移;

- 内存搬运:tl.load/tl.store 自动适配昇腾 Global→UB→寄存器的三级内存流转,无需手动调用昇腾 CCE 缓存指令。

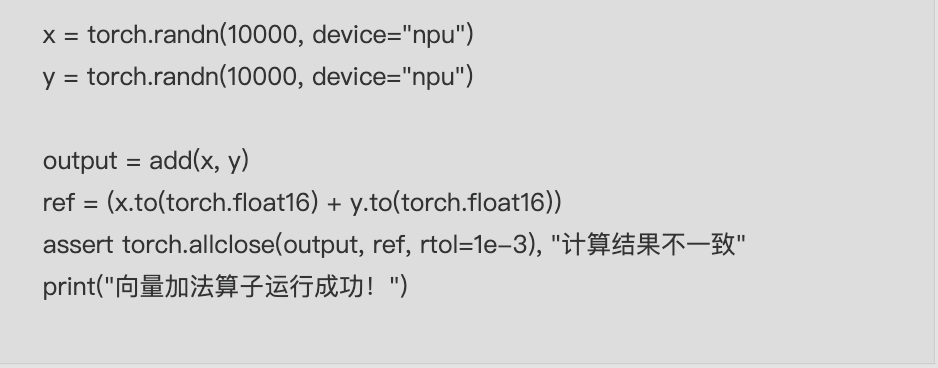

4. Triton-Ascend 核心特性:Schedule/Register/UB 分配

Triton-Ascend 与通用 Triton 最核心的差异在于「硬件资源调度逻辑」,以下是昇腾后端独有的关键特性:

4.1 Schedule 调度:适配昇腾 AI Core 集群

- 二维 Grid 映射:昇腾 AI Core 通常按行列排布(如 4x16),Triton-Ascend 推荐使用 2D Grid(pid_m=tl.program_id(0)/pid_n=tl.program_id(1)),直接映射到 AI Core 的物理布局,减少跨核调度开销;

- 静态 Schedule:昇腾后端不支持动态调度(GPU 支持),所有 Block 大小、维度拆分必须在编译期确定(tl.constexpr 修饰);

- 核绑定策略:Triton-Ascend 会将连续的 Block 绑定到同一 AI Core 核心,充分利用单卡多核计算资源,避免不必要的核心切换开销。

4.2 寄存器与 UB 分配

|

资源类型 |

昇腾硬件限制 |

Triton-Ascend 优化策略 |

|

寄存器 |

每个 AI Core 约 32K 个 FP16 寄存器 |

1. 优先使用 tl.zeros 初始化临时变量(编译器自动分配寄存器);2. 避免大张量在寄存器中缓存(拆分计算) |

|

UB |

256KB/AI Core,Global→UB 带宽 100GB/s |

1. BLOCK_SIZE 匹配 UB 容量(如 FP16 单元素 2 字节,1024 元素仅占 2KB);2. Double Buffer 复用 UB(乒乓加载数据);3. 避免 UB 碎片化(连续访存) |

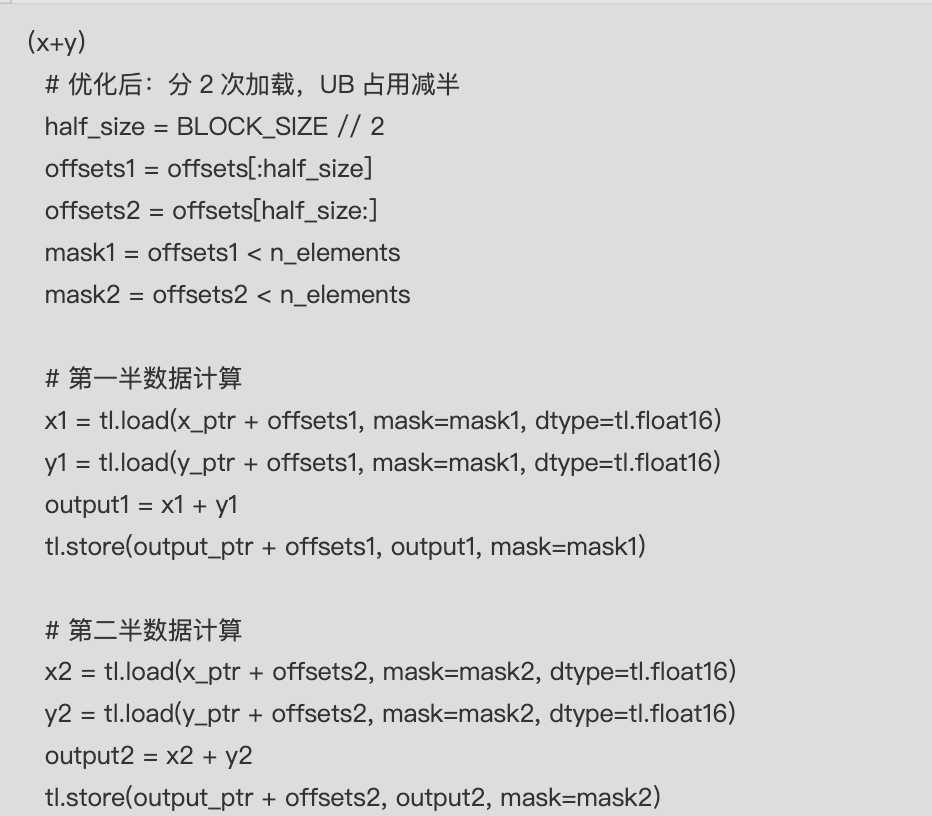

4.3 实战:UB 分配优化示例

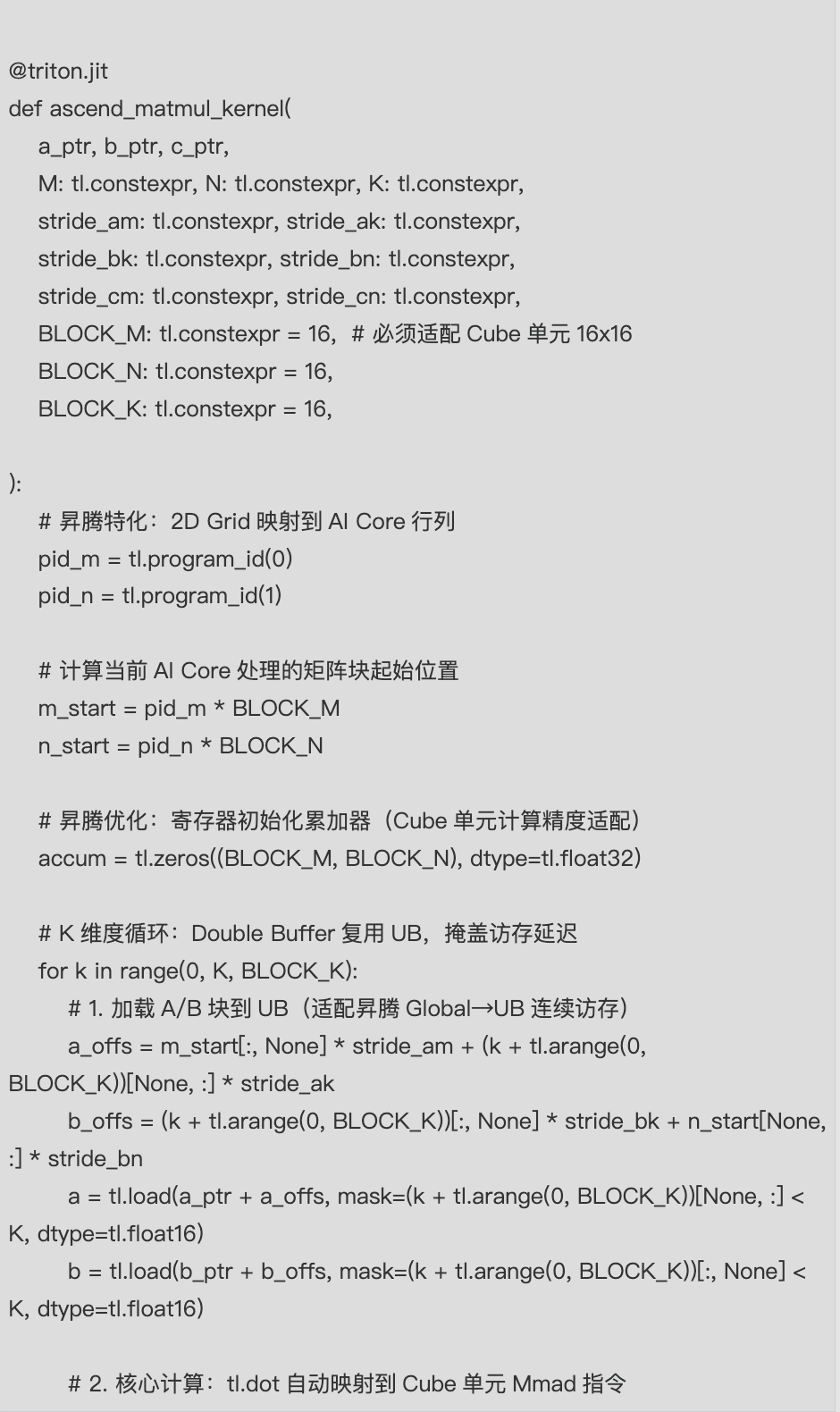

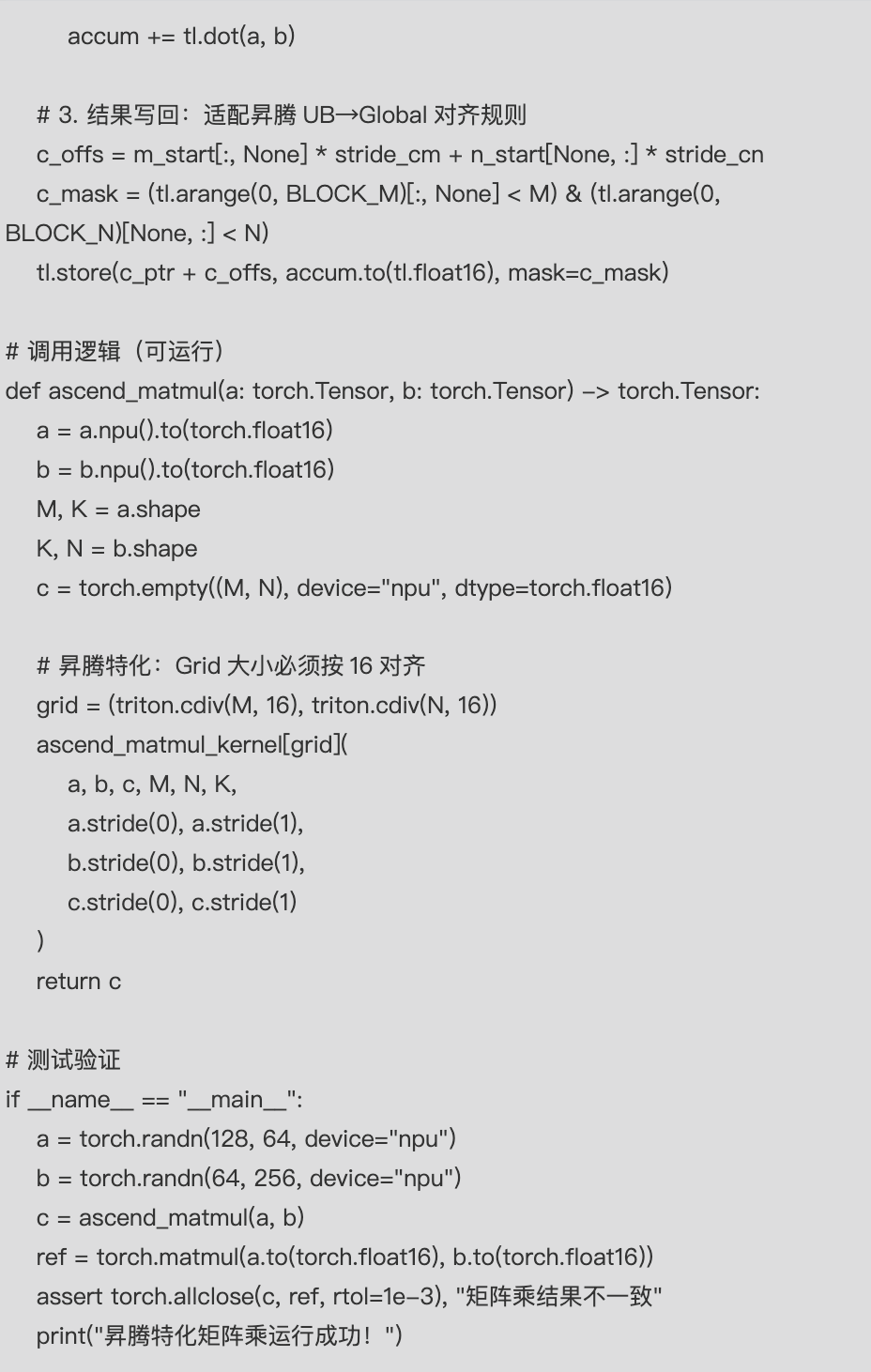

5. 官方典型 Kernel 解析:MatMul/Softmax

5.1 矩阵乘法(MatMul):适配 Cube 计算单元

昇腾 Cube 单元是矩阵乘的核心算力载体,仅支持 16x16 基础计算粒度,Triton-Ascend 官方 MatMul Kernel 核心适配逻辑如下:

核心差异点

- Cube 粒度对齐:BLOCK_M/BLOCK_N/BLOCK_K 必须设为 16,否则无法触发 Cube 单元(GPU 可任意设置);

- 精度策略:累加器用 float32(避免 FP16 精度损失),最终写回 float16(适配昇腾存储);

- UB 复用:K 维度循环采用 Double Buffer 策略,最大化 UB 利用率(GPU 更关注 Shared Memory 复用)。

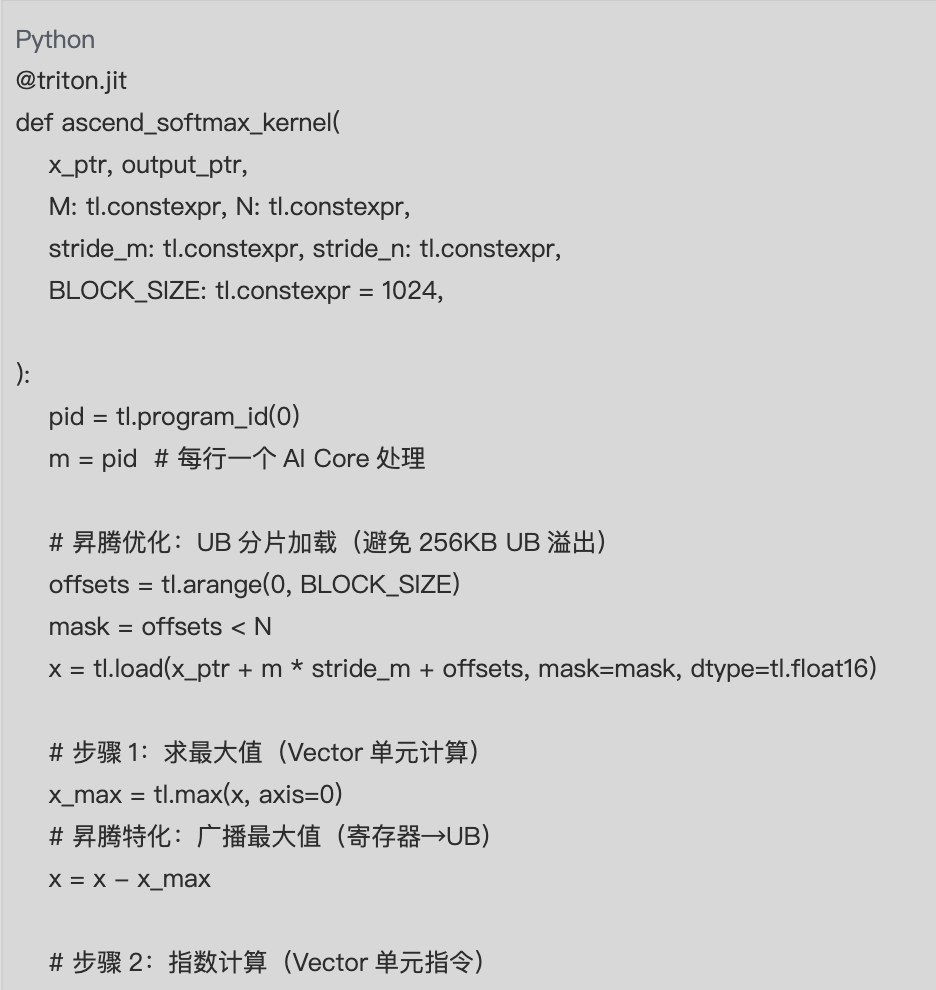

5.2 Softmax:适配昇腾 UB 与 Vector 单元

昇腾 Softmax 算子的核心痛点是「分母求和的数值稳定性+UB 资源限制」,官方 Kernel 优化逻辑如下:

6. 昇腾后端性能坑与 Workaround

6.1 常见性能坑及解决方案

|

性能坑 |

现象 |

根本原因 |

Workaround |

|

UB 溢出 |

编译报错/运行时 OOM |

BLOCK_SIZE 过大,超出 256KB UB |

1. 减小 BLOCK_SIZE;2. UB/L1分片加载(如 Softmax 示例);3. 拆分计算逻辑 |

|

Cube 单元未命中 |

性能仅为理论值的 10% |

矩阵分块未按 16 对齐 |

强制 BLOCK_M/N/K=16;非 16 倍数维度手动补齐 |

|

非连续访存 |

访存带宽仅 20% 利用率 |

内存偏移跳跃(如 offsets*2) |

1. 调整数据布局为连续;2. 编译器层面开启访存重排 |

|

核间通信开销大 |

多 Grid 场景性能下降 |

AI Core 集群间数据搬运 |

1. 增大 Block 粒度;2. 2D Grid 匹配 AI Core 物理布局 |

|

FP16 精度损失 |

计算结果偏差大 |

Cube 单元 FP16 累加误差 |

累加器用 FP32,最终写回 FP16;开启昇腾数值稳定模式 |

7. Triton-Ascend 完整开发流程

7.1 标准化开发步骤

- 硬件适配设计:

- 确定算子维度是否适配 Cube/Vector 单元(矩阵乘→Cube,激活函数→Vector);

- 预估 UB/寄存器占用,确定 BLOCK_SIZE 初始值(如 1024/16)。

- Kernel 实现:

- 基于昇腾 SPMD 模型拆分任务(2D Grid 优先);

- 严格添加 Mask 防止越界;

- 适配昇腾数据类型(FP16 优先,累加器 FP32)。

- 正确性验证:

- 对比 PyTorch-NPU 原生实现(误差 rtol=1e-3);

- 测试非对齐维度(如 127x63)的边界情况。

- 性能调优:

- 查看 UB/寄存器占用(通过 ASCEND_PROFILING_LEVEL=2);

- 优化访存连续性、UB 复用、Cube 单元命中。

- 部署验证:

- 集成到 PyTorch 模型中,测试端到端性能;

- 对比原生 ASCEND C 算子性能(目标:达到 90% 以上)。

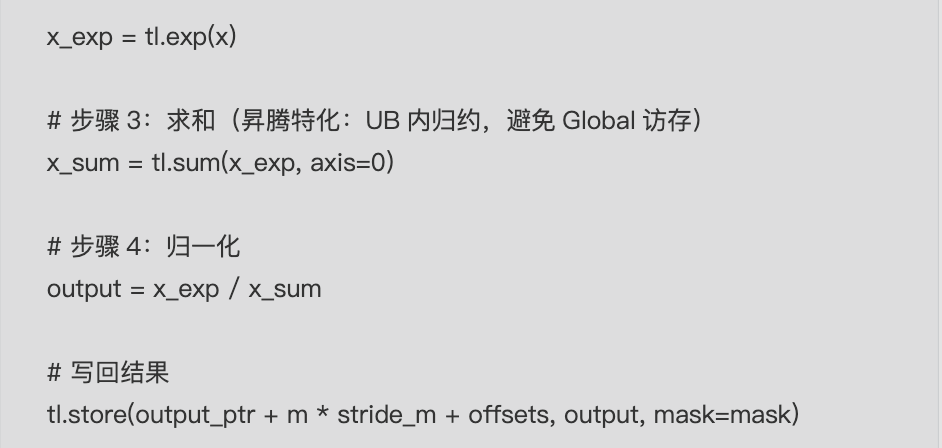

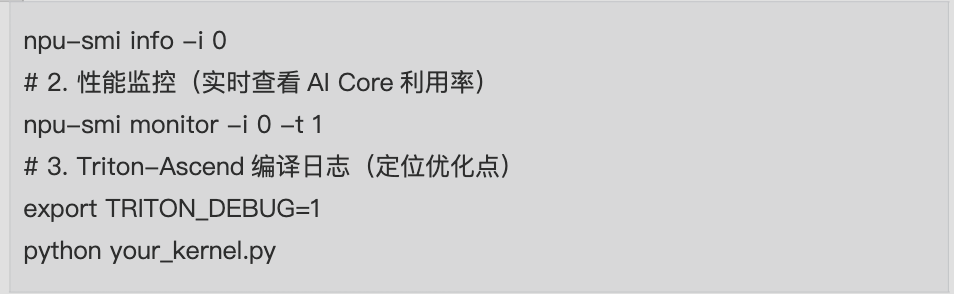

7.2 性能分析工具

8. 总结

核心知识点总结

- 昇腾特化模型:理解 AI Core、UB、Cube/Vector 单元的硬件特性,是 Triton-Ascend 开发的基础;

- 资源调度:UB 分配、寄存器复用、Cube 粒度对齐是性能优化的核心;

- 避坑要点:Mask 防越界、UB 防溢出、连续访存是可运行+高性能的关键;

- 典型模式:矩阵乘(Cube 单元)、Softmax(UB/L1分片)是昇腾算子开发的通用模板。

阶梯式学习路径

- 入门:实现可运行的向量加法/ReLU,掌握 Triton-Ascend 基础语法+昇腾设备适配;

- 进阶:实现矩阵乘,理解 Cube 单元适配、UB 复用、2D Grid 调度;

- 高阶:优化 Softmax/LayerNorm 等复杂算子,解决数值稳定性+资源限制问题;

- 实战:对比官方 Kernel,复刻并优化昇腾特化算子(如 FlashAttention)。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)