智谱首席科学家唐杰:领域大模型是伪命题!AI模型应用的第一性不应是创造新App,在线学习和自我评估是新Scaling范式

唐杰认为,在 AGI 尚未实现之前,领域模型会长期存在,其背后更多是应用企业的战略选择——不愿意在 AI 企业面前完全失去主导权,希望通过领域 know-how 构建护城河,把 AI 驯化为工具。最近,清华大学教授、智谱AI首席科学家唐杰发了一条长微博,总结了自己2025年对大模型进展的感悟。从预训练到中后训练、长尾场景的对齐能力,再到Agent、多模态和具身智能的发展,其中有不少亮点。

唐杰认为,在 AGI 尚未实现之前,领域模型会长期存在,其背后更多是应用企业的战略选择——不愿意在 AI 企业面前完全失去主导权,希望通过领域 know-how 构建护城河,把 AI 驯化为工具。

最近,清华大学教授、智谱AI首席科学家唐杰发了一条长微博,总结了自己2025年对大模型进展的感悟。从预训练到中后训练、长尾场景的对齐能力,再到Agent、多模态和具身智能的发展,其中有不少亮点。

唐杰教授这段话,本质上是在回答一个问题:大模型正在从“学会世界”走向“进入世界”,而真正的挑战已经从智能本身,转移到了如何把智能变成现实生产力。

他强调,Agent的落地是大模型从认知系统转变为生产系统的关键一步,但目前的问题在于,不同 agent 环境之间的泛化和迁移依然极其困难,只能不断增加更多环境数据,以及针对不同环境的强化学习。

唐杰提出了AI应用的第一性原理:“AI 模型应用的第一性原理不应该是创造新的 App,它的本质是 AGI 替代人类工作,因此研发替代不同工种的 AI 是应用的关键。”

此外,他还指出模型的自学习、自迭代会是下一个阶段必然具有的能力,在线学习和自我评估可能成为下一个 Scaling 范式。

1.预训练没死,但接下来重点是中后训练

首先在预训练层面,唐杰教授的判断非常明确也非常务实。

经过过去几年的大规模预训练,大模型已经系统性地掌握了世界常识,并具备了基础推理能力。从工程效率的角度看,更多数据、更大参数、更充分的算力利用,依然是提升基座模型能力最直接、最有效的方式。

也就是说,scaling 并没有失效,它依然是当前阶段性价比最高的路径。行业里关于“scaling 是否走到尽头”的争论,更多是在讨论边际收益是否下降,而不是它是否仍然成立。

问题在于,预训练解决的是“平均意义上的智能”,并不能保证模型在真实世界中的可用性。唐杰教授在这里重点讨论了激活对齐与推理增强:随着通用 benchmark 的普及,模型在标准化测试上的表现越来越好,但这同时也带来了过拟合风险——模型变得更擅长“考试”,却未必更擅长应对真实、复杂、长尾的场景。

类似的问题,Ilya Sutskever在前段时间的采访中也提到过:当前的大语言模型在高难度评测上表现优异,能拿数学奥赛(IMO)的金牌,但在一些简单任务中仍会出错。

Karpathy在其年终总结中表示,自己“在 2025 年对基准测试产生了普遍的冷感和不信任”,原因是在典型的刷榜流程中,实验室团队不可避免地会在基准测试所占据的嵌入空间小角落周围构建训练环境,使大模型在这些领域附近的能力会突飞猛进。

但结果很有可能是,我们刷爆了所有基准测试,但依然没有实现AGI。

现实环境的问题往往分布不均、边界模糊、变化频繁,真正决定用户体感的,恰恰是这些 benchmark 覆盖不到的角落。因此,如何让模型更快、更稳地对齐真实场景,尤其是激活长尾能力,成为新的关键。这也是 mid-training 和 post-training 价值凸显的原因:它们让模型不只是“更聪明”,而是“更好用”。

2.Agent 是模型进入现实世界的关键

唐杰用了一个形象的比喻:

“大模型就像一个人不停地学习,一直学到博士,也只是知识积累,还没有转化为实际生产力;而Agent则是模型能力扩展的里程碑,标志着大模型真正进入了人类真实世界。”

值得注意的是,agent 的实现路径也在发生变化:过去更多依赖应用层编排,而现在 agent 行为和数据正逐步被纳入模型训练过程本身,以增强通用性。

但真正的难点并没有消失,不同 agent 环境之间的泛化和迁移依然极其困难。现实可行的解法仍然相当“朴素”:更多环境数据,以及针对不同环境的强化学习。

3.模型记忆是必需能力

唐杰认为:模型要在真实环境中行动,记忆能力是必需的。他用人类记忆结构做了一个很有启发性的类比:

- 短期记忆,对应Context

- 中期记忆,对应RAG

- 长期记忆,对应模型参数

- 人类历史,对应公共知识库

当前的大模型体系中,这些机制各自解决了一部分问题,但整体仍然不完善。

一种看似直接的思路是,通过超长 context 和记忆压缩,把更多信息直接“塞进”模型的上下文中,从而同时覆盖短期和中期记忆。

但真正棘手的问题在于:如何迭代模型已有的知识、如何修改模型参数而不引发灾难性遗忘。这仍然是一个悬而未决的核心难题。

4.在线学习和自我评估,可能是下一个 Scaling 范式

一旦引入记忆机制,在线学习就自然成为下一个焦点。

现在的模型是“离线”的,训练好就不变了。这有几个问题:模型不能真正自我迭代,重新训练浪费资源,还会丢失大量真实交互数据。

唐杰认为,具备自学习、自进化能力的模型,几乎是下一个阶段的必然形态,而在线学习的前提是模型具备自我评估能力。

换句话说,模型必须能够判断“自己对还是不对”,哪怕只是概率意义上的判断,也足以形成优化目标。如果这一点能够成立,那么自我评估机制本身,可能会成为下一种新的 scaling 范式,也就是从“堆资源”走向“自我进化”。

唐杰提到了几个词:continual learning、real time learning、online learning。

关于这一点,OpenAI 的前联合创始人John Schulman以及谷歌DeepMind CEO Demis Hassabis 也都发表过类似观点。Demis曾指出,大模型的持续在线学习能力仍是通往AGI的重要缺失环节;而 Schulman则认为短时间内上下文学习非常强,几乎无可替代。

这与 Karpathy 提到的可验证奖励的强化学习(RLVR)也有相通之处。RLVR 的核心思路就是让 LLM 在一系列「答案可以自动验证」的环境中训练,比如数学题、编程挑战等。神奇的是,经过这种训练,模型会自发地「学会思考」:它们开始把复杂问题拆解成中间步骤,并摸索出各种解题策略,比如反复推敲、来回验证。

如果这个机制能泛化到更多场景,在线学习就有可能实现。

5.AI 应用的第一性原理是「替代工种」

在应用层面,唐杰的判断回到了第一性原理。

他认为,随着模型能力不断增强,大模型的发展必然走向端到端,模型研发与模型应用将越来越难以分离。

AI 应用的核心目标,并不是创造新的 App 形态,而是替代或重构人类工作。Chat 在某种程度上已经替代了搜索,同时还融合了部分情感交互能力。沿着这条逻辑继续推演,2026 年很可能会成为 AI 替代不同工种的集中爆发期。

6.多模态和具身智能:前景广阔,道阻且长

至于多模态和具身智能,唐杰的态度相对冷静而克制。

多模态无疑前景广阔,但在当前阶段,它并不能显著抬升 AGI 的智能上界,而这个上界本身仍然未知。更现实的路径,可能是文本、多模态理解、多模态生成分别推进,同时保持一定程度的交叉探索。

具身智能的问题则更加尖锐:如果理解了 Agent 的难点,就能理解具身为何如此困难。少样本激活通用具身能力几乎不现实,而无论是采集真实数据还是合成数据,成本都极高。

同时,机器人本体的不稳定性和高故障率,也在客观上限制了具身智能的发展。但一旦数据规模真正上去,通用能力自然会形成门槛。唐杰判断,到 2026 年,这一领域会出现明显进展。

7.领域大模型是个「伪命题」

最后,在领域大模型与应用的问题上,唐杰给出了一个相当直白的判断:领域大模型是个“伪命题”。他直言:都AGI了,哪还有什么domain-specific agi……

唐杰认为,在 AGI 尚未实现之前,领域模型会长期存在,其背后更多是应用企业的战略选择——不愿意在 AI 企业面前完全失去主导权,希望通过领域 know-how 构建护城河,把 AI 驯化为工具。

但从更长期来看,AI 的本质更像海啸,而不是插件。领域中的数据、流程和 agent 行为,最终都会被吸纳进更通用的主模型之中。相应地,大模型应用也必须回到创造真实价值这一原点:要么把原本需要人参与的软件彻底 AI 化,要么直接打造对齐某个工种的 AI 系统,替代人类完成工作。

如果一个 AI 产品无法真正帮助人、创造价值,那它注定没有生命力。

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

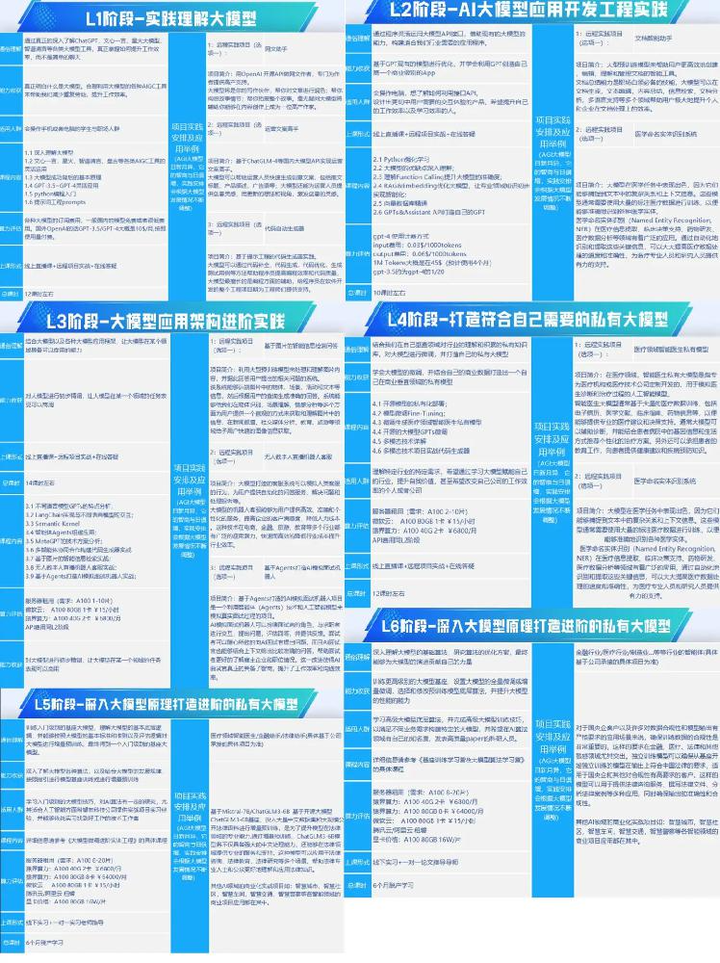

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

更多推荐

已为社区贡献96条内容

已为社区贡献96条内容

所有评论(0)