大模型的私有化部署细节

大模型(如 LLM,Large Language Models)的私有化部署是指将原本运行在公有云或第三方平台上的大模型,部署到企业或组织内部的私有环境(如本地服务器、私有云、边缘设备等),以满足数据安全、合规性、定制化和低延迟等需求。量化(Quantization):FP16 → INT8/INT4,降低显存占用和推理成本(如使用 GGUF、AWQ、GPTQ)开源模型(如 Llama 系列、Qw

大模型(如 LLM,Large Language Models)的私有化部署是指将原本运行在公有云或第三方平台上的大模型,部署到企业或组织内部的私有环境(如本地服务器、私有云、边缘设备等),以满足数据安全、合规性、定制化和低延迟等需求。以下是私有化部署的关键细节:

一、部署前的准备工作

1. 明确业务需求

是否需要微调(Fine-tuning)?

是否需要支持多语言或多模态?

对响应延迟、吞吐量、并发用户数的要求?

2. 模型选型

开源模型(如 Llama 系列、Qwen、ChatGLM、Baichuan、Falcon、Mistral 等)

商业闭源模型(部分厂商提供私有化授权版本,如通义千问、智谱 AI、百川等)

注意:使用开源模型需遵守其许可证(如 Llama 需 Meta 审批;Qwen 可商用但需注明来源)。

3. 硬件资源评估

GPU/TPU/NPU:主流选择 NVIDIA A100/H100/L40S、华为昇腾、寒武纪等

显存要求:例如:

Qwen-7B 推理约需 16GB 显存(FP16)

使用量化(如 INT4/INT8)可降至 6–10GB

CPU/内存/存储:用于加载模型权重、缓存、日志等

二、部署方式选择

|

方式 |

特点 |

适用场景 |

|

裸机部署 |

直接在物理服务器上运行 |

高性能、低延迟、完全控制 |

|

容器化部署(Docker/K8s) |

可移植、易扩展、便于管理 |

云原生环境、微服务架构 |

|

虚拟机部署 |

资源隔离好,但性能略低 |

多租户、测试环境 |

|

边缘部署 |

在终端或边缘节点运行小模型 |

IoT、离线场景、隐私敏感 |

三、关键技术环节

1. 模型优化

量化(Quantization):FP16 → INT8/INT4,降低显存占用和推理成本(如使用 GGUF、AWQ、GPTQ)

剪枝(Pruning):移除冗余参数

蒸馏(Distillation):用大模型训练小模型

LoRA 微调:高效适配特定领域,节省资源

2. 推理引擎选择

vLLM:高吞吐、支持 PagedAttention

TensorRT-LLM(NVIDIA):极致性能优化

llama.cpp / Ollama:CPU/GPU 通用,适合轻量部署

DeepSpeed / FasterTransformer:微软/NVIDIA 的高性能推理框架

3. API 封装与服务化

使用 FastAPI / Flask / gRPC 提供 RESTful 或 RPC 接口

支持流式输出(SSE/WebSocket)

添加认证、限流、日志、监控等中间件

4. 安全与合规

数据不出内网

模型访问权限控制(RBAC)

审计日志留存

符合《数据安全法》《个人信息保护法》等法规

四、运维与监控

健康检查:服务可用性、GPU 利用率、显存使用

日志收集:Prometheus + Grafana / ELK

自动扩缩容:Kubernetes HPA(基于 QPS 或 GPU 负载)

模型版本管理:支持灰度发布、回滚

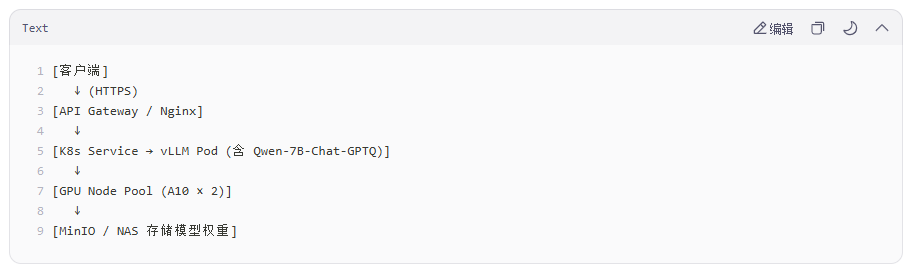

五、典型部署架构示例(K8s + vLLM)

六、成本考量

|

项目 |

说明 |

|

硬件成本 |

GPU 服务器(单台 10–100 万+) |

|

软件成本 |

商业模型授权费、运维工具许可 |

|

人力成本 |

AI 工程师、DevOps、安全合规人员 |

|

能耗成本 |

高功耗 GPU 需配套制冷与电力 |

七、常见挑战

模型太大无法加载到单卡 → 使用模型并行(Tensor Parallelism)

推理延迟高 → 优化批处理、使用更快的推理引擎

中文效果不佳 → 领域微调 + 高质量语料

缺乏专业运维团队 → 考虑一体化私有化解决方案(如阿里云百炼、火山引擎大模型套件)

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)