【ModelEngine 实战】从 0 到 1 打造“全能型”AI 智能体:MCP 接入全过程评测

摘要:ModelEngine作为AI应用开发平台,从知识库构建到多智能体协作提供全链路支持。其亮点包括:知识库自动生成摘要功能,提升检索置信度;Prompt自动增强可将简单指令转化为结构化提示词;所见即所得的调试台支持实时预览修改效果;独有的MCP服务让Agent具备本地工具调用能力。相比Dify和Coze等平台,ModelEngine在多源工具集成和调试透明度方面更具优势,既降低了开发门槛,又提

前言:AI 应用开发的“快车道”

在 Agent 领域,我们正从“对话机器人”转向“智能协同体”。最近参与了 ModelEngine 的「AI 应用开发实践计划」,深度体验了其从知识库构建到多智能体协作的全链路。ModelEngine 给我的第一感觉是:它不仅是一个大模型调用工具,更是一个高度集成的 Agent 生态实验室。

今天通过一个“智能行业研究助手”的案例,带大家沉浸式体验 ModelEngine 的核心产品能力。

一、 知识库构建:从堆砌文档到“自动生成摘要”

痛点: 以前做 RAG(检索增强生成),最头疼的是文档切片太乱,不知道 AI 到底读懂了没。

ModelEngine 体验:

-

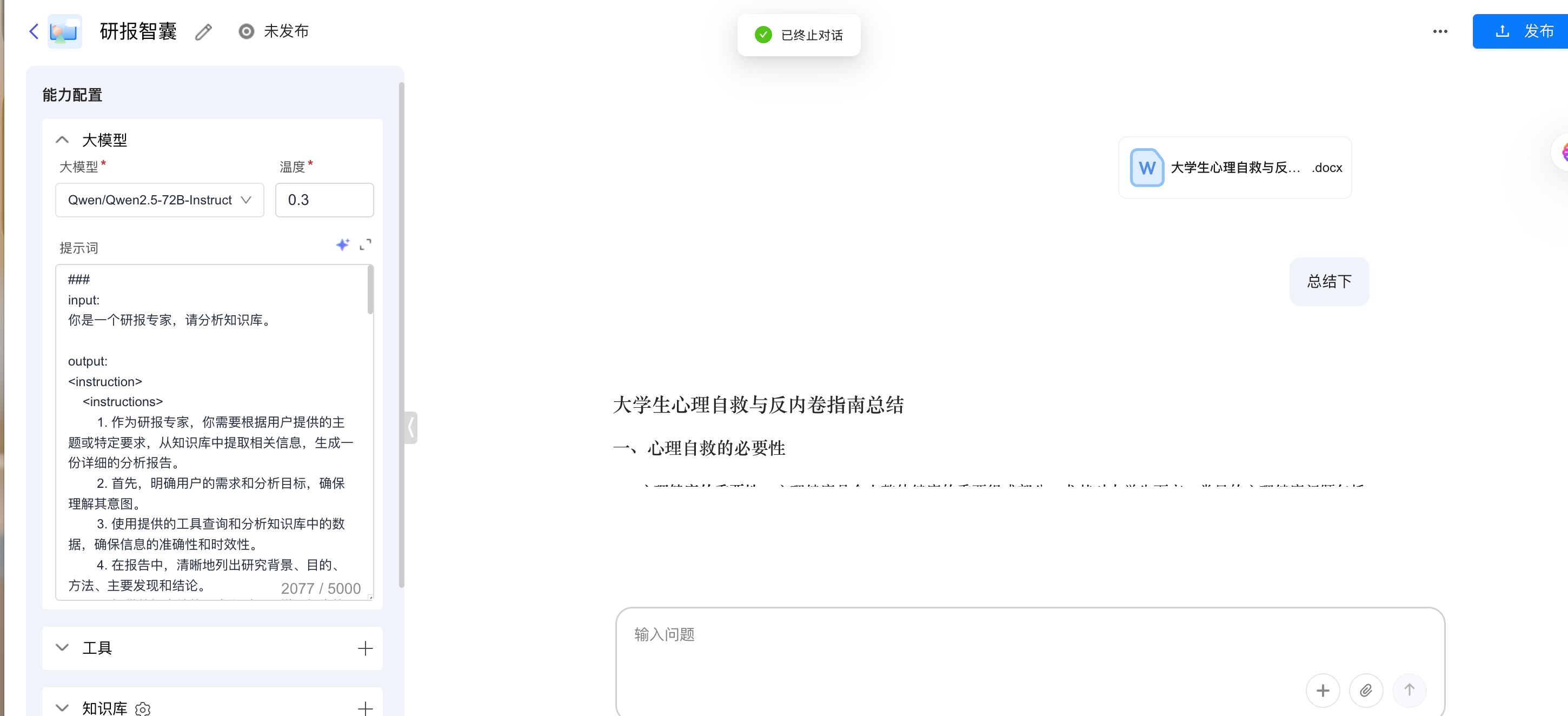

一键导入: 我上传了一份大学生心理自救的文档。

-

知识库总结自动生成(必看亮点): 在解析完成后,ModelEngine 并不是简单地堆砌片段,其内置的算法会自动对整库或单篇文档生成核心摘要。这让我一眼就能确认:系统是否准确捕捉到了文档的关键语义,极大提升了后续检索的置信度。

-

语义召回: 在调试中,其混合搜索表现稳定,即使我提问比较模糊,它也能准确关联到知识库中的隐藏细节。

二、 提示词自动生成:让“玄学”变“科学”

痛点: 很多开发者卡在 Prompt 编写上,调优半天还是“胡言乱语”。

ModelEngine 体验:

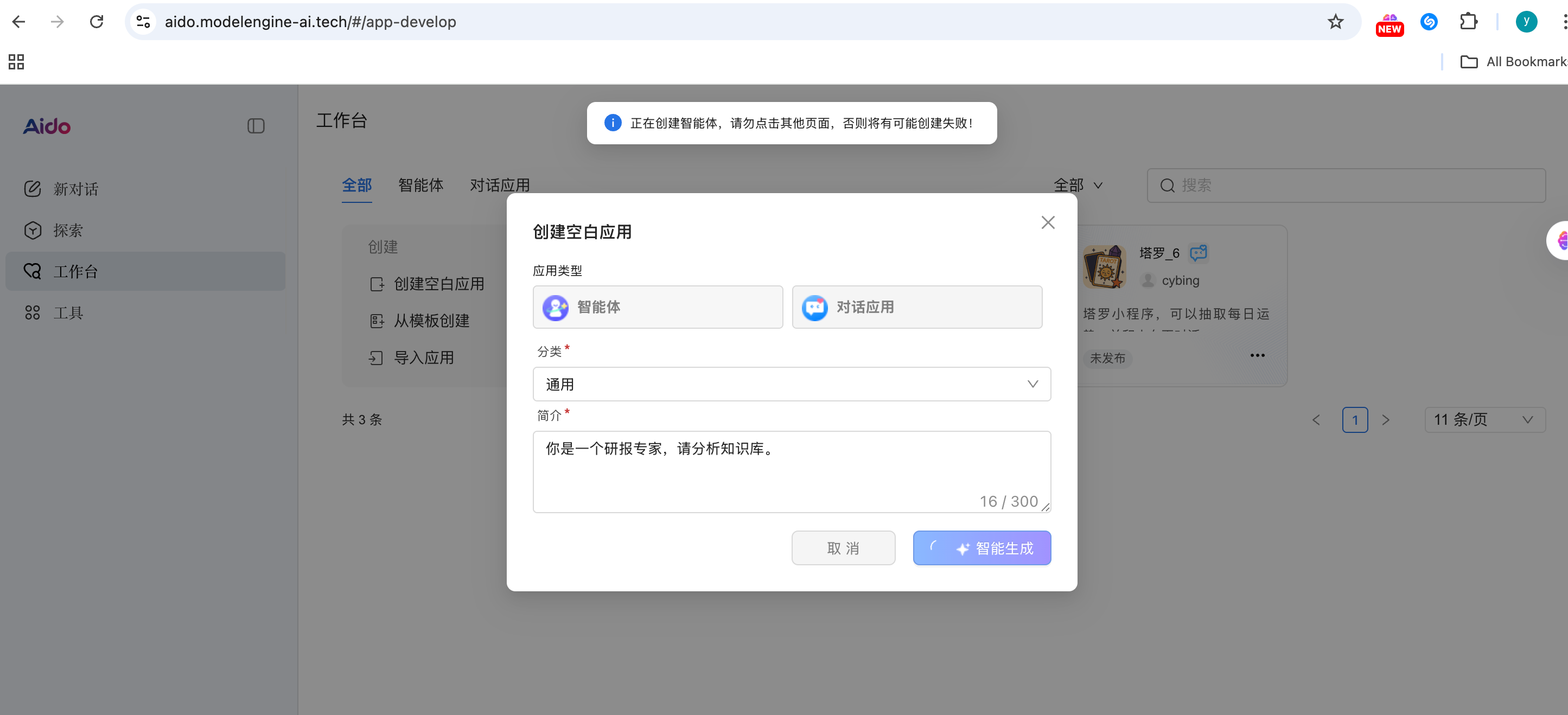

- Prompt 自动增强: 在 ModelEngine 的 Agent 编辑器里,我只输入了:“你是一个研报专家,请分析知识库。”

- 魔法棒操作: 点击“自动生成/优化”按钮,系统立即将其转化为一套包含 Role(角色设置)、Objective(任务目标)、Workflow(标准作业程序) 的结构化提示词。

- 感受: 它能自动补齐诸如“请在回答时引用知识库来源”、“如果没有找到信息请诚实回答”等专业约束条件,新手也能瞬间写出大师级 Prompt。

三、 开发与调试:所见即所得的“手术室”

ModelEngine 的调试台是我最喜欢的环节:

- 左侧配置,右侧预览: 修改完提示词或切换了底层模型(如 Qwen2.5-72B-instruct 切换到 Qwen2.5-36B-instruct),右侧聊天窗口可以立即刷新效果。

- 运行日志追踪: 每一个回答背后,我能清晰地看到:

- 每一步的运行结果、运行时长

- 知识库的调用情况

这种透明度是复杂应用调优的基础。

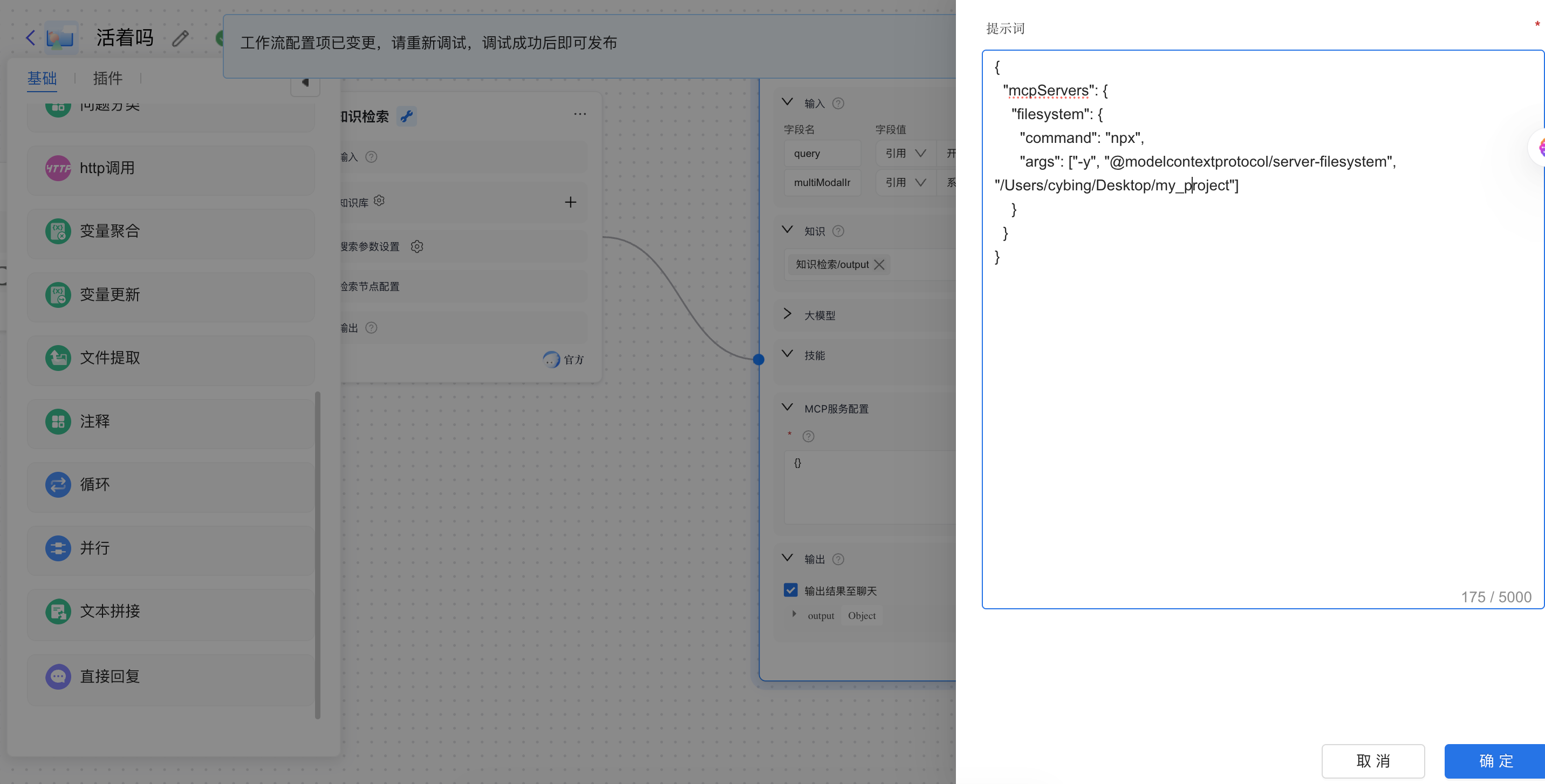

四、 进阶探索:MCP 服务接入(让 Agent 拥有“手脚”)

这是 ModelEngine 区别于普通平台的“杀手锏”。

- 什么是 MCP? 它是 Model Context Protocol。通过 ModelEngine,我可以轻松接入本地或外部的工具集。

- 场景演示: 我接入了本地文件系统 的 MCP 服务。

- 实测效果: 我的智能体瞬间拥有了“本地视野”。我不再需要手动上传文件,直接对它说:“分析一下我本地项目里的 README.md,看看还缺少哪些安装步骤。” 这才是一个成熟 Agent 该有的样子。

五、 对比与总结:为什么选择 ModelEngine?

对比了市面上主流的平台(如 Dify、Coze 等):

- 对比 Dify: ModelEngine 在 MCP 协议的支持和多源工具集成上显得更加极客且开放。

- 对比 Coze: ModelEngine 的工作流调试日志更加详尽,更适合追求精准度的开发者。

总结:

ModelEngine 通过提示词自动生成降低了门槛,通过知识库自动总结增强了理解力,再通过 MCP 与多智能体编排拉高了天花板。

无论你是想做一个简单的“文档小助手”,还是一个复杂的“企业级数字员工”,ModelEngine 都提供了一个足够坚实的底座。

开发者避坑指南:

- 善用变量: 在工作流编排时,注意节点间变量的传递逻辑。

- Prompt 迭代: 自动生成的提示词虽好,但结合业务微调后效果更佳。

体验地址: ModelEngine 官网

开源贡献: ModelEngine 贡献者社区

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)