深度实测 ModelEngine:从 0 到 1 打造大学生生存确认助手“活着吗”——可视化编排与智能体全流程实践

摘要: 本文介绍了基于ModelEngine平台开发的"活着吗"AI应用,旨在为压力中的大学生提供个性化生存评价。作者详细阐述了应用开发流程:1)通过知识库构建"精神避难所";2)利用提示词自动生成技术优化AI回复风格;3)采用可视化编排解决变量引用等技术问题。该应用通过"状态输入-知识检索-逻辑加工-格式化输出"的生成路径,实现了既毒舌

目录

-

前言:为什么要开发“活着吗”?

-

应用设计路径:定义“生存确认”的内容生成链路

- 2.1 进入平台

- 2.2 创建应用

-

核心实操一:知识库自动化——构建“精神避难所”

- 3.1 状态输入 && 素材导入

-

核心实操二:提示词工程——寻找最懂年轻人的“嘴替”

- 4.1 手写 Prompt 的乏力感

- 4.2 提效利器:实测“提示词自动生成”与变量注入

-

核心实操三:可视化编排——多节点逻辑的“避坑”与调试

- 5.1 工作流节点配置

- 5.2 真实调试记录:解决变量引用的“断路”问题

-

结语:AI 应用落地的温度与效率

1. 前言:为什么要开发“活着吗”?

在论文盲审、组会批斗、大厂实习和考研压力的多重夹击下,“活着”成了很多大学生的一种调侃式勋章。

我决定利用 ModelEngine 打造一个名为 “活着吗” 的个人应用。它的核心目标很简单:用户每天输入一句生存现状,AI 通过后端挂载的“摸鱼哲学”与“抗压指南”知识库,给出一段既毒舌又暖心的生存评价。

2. 应用设计路径:定义“生存确认”的内容生成链路

2.1 进入平台

首先,打开官网 https://www.modelengine-ai.com/#/home,注册登录后,点击在线体验进入平台控制台。

2.2 创建应用

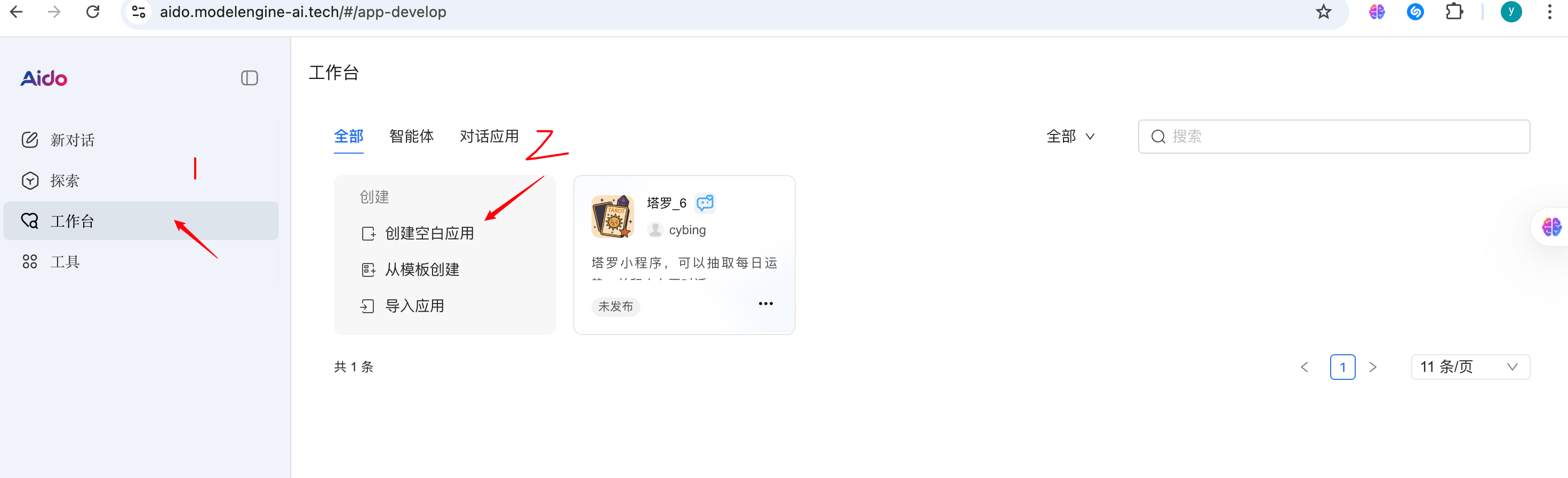

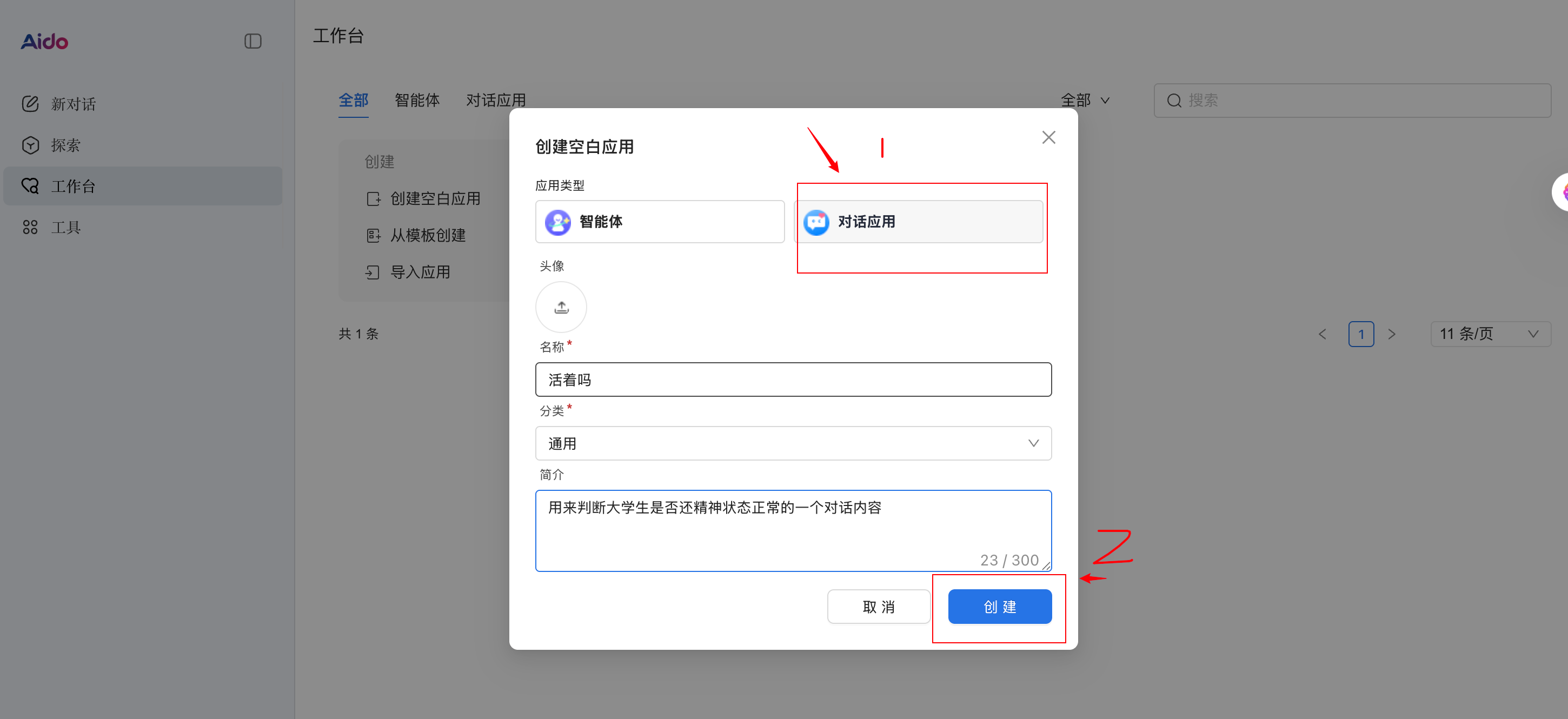

如图所示进行操作

在 ModelEngine 动手前,我先梳理了应用的核心生成路径(Path),这是确保智能体不“跑偏”的关键:

- 用户输入层:获取用户的

status(如:实验数据又炸了)。 - 知识检索层:从挂载的文档中检索相似的“自救案例”或“共情金句”。

- 逻辑加工层:将检索内容与用户输入通过调优后的 Prompt 进行揉合。

- 格式化输出:颁发“今日生存等级”并给出“续命建议”。

3. 核心实操一:知识库自动化——构建“精神避难所”

3.1 状态输入 && 素材导入

创建用户输入的基本状态

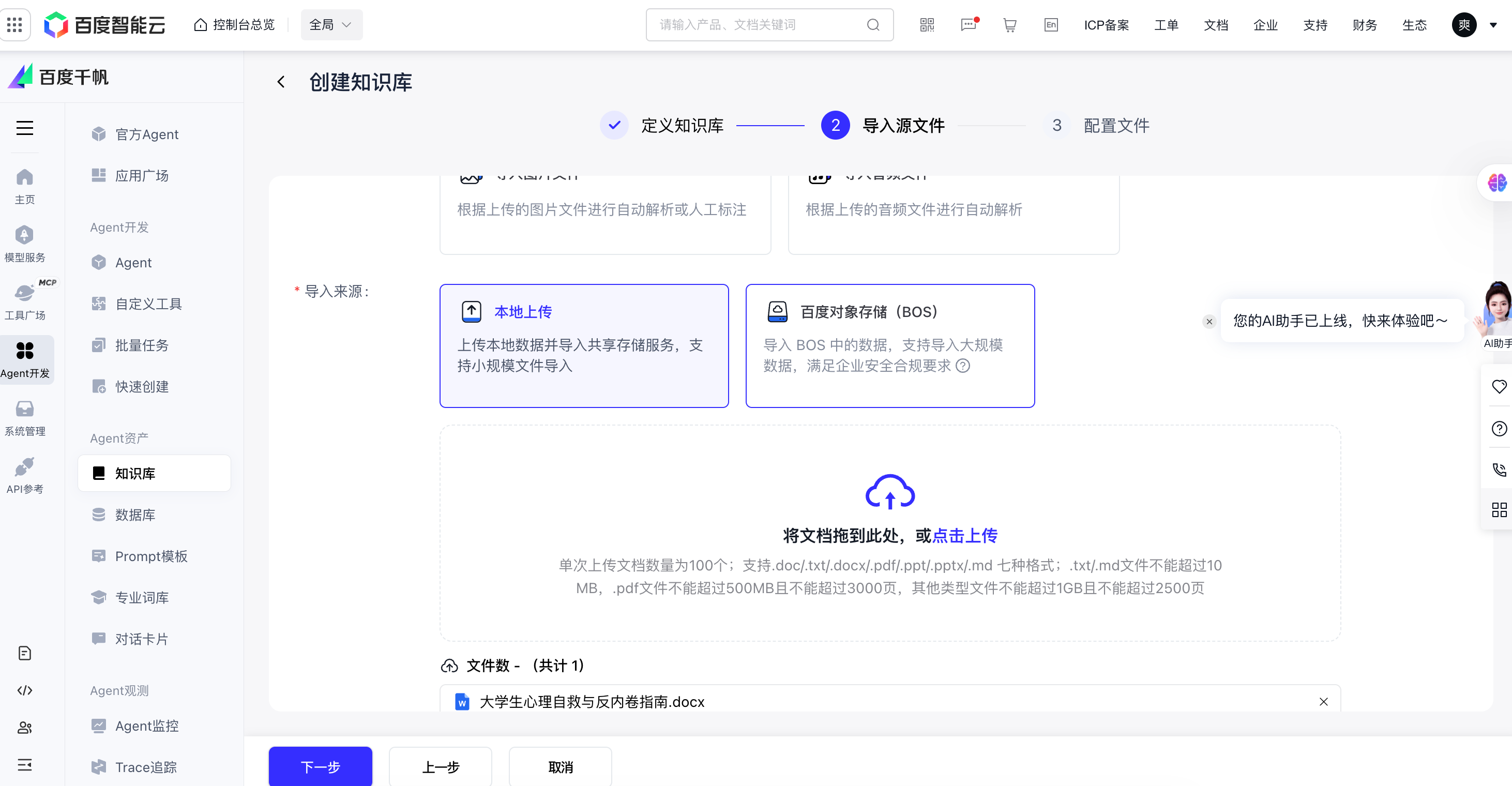

我准备了一份名为《大学生心理自救与反内卷指南》的文档。在 ModelEngine 的知识库板块,点击“新建知识库”并上传。

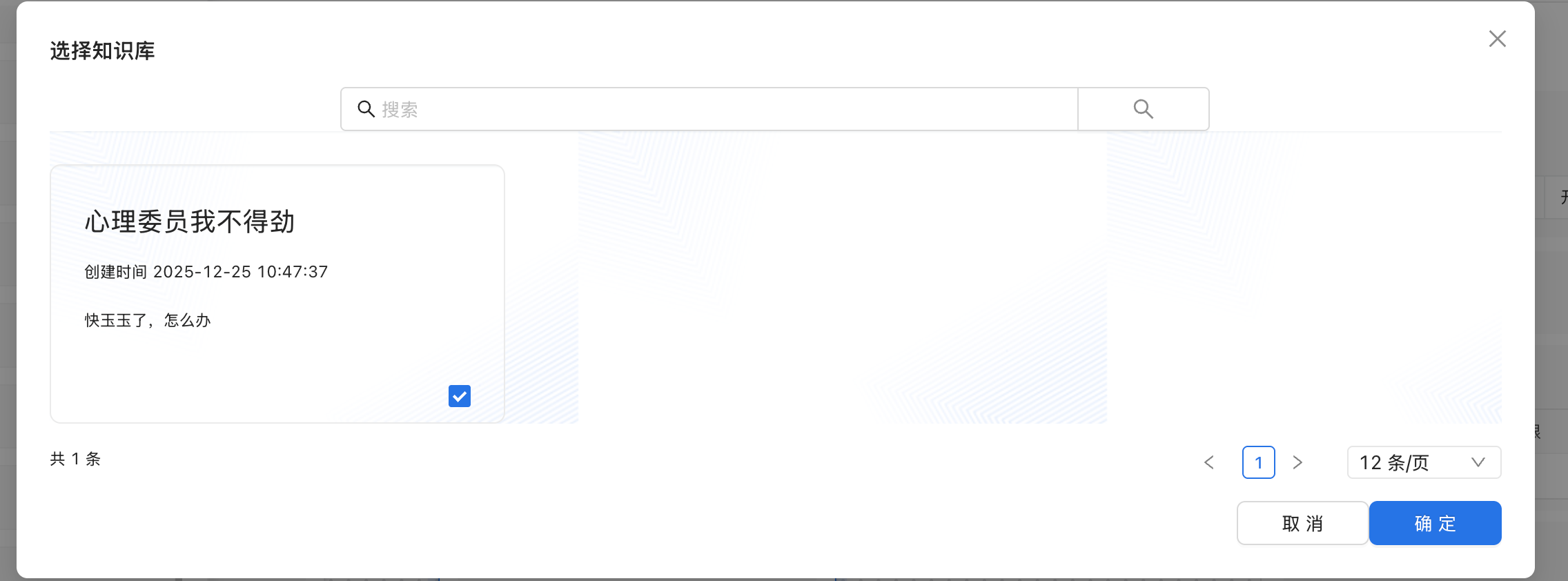

友情提示,这个是在百度千帆里创建知识库内容,后通过API Key来获取对应的知识库,下图是百度千帆创建知识库的一个子步骤。

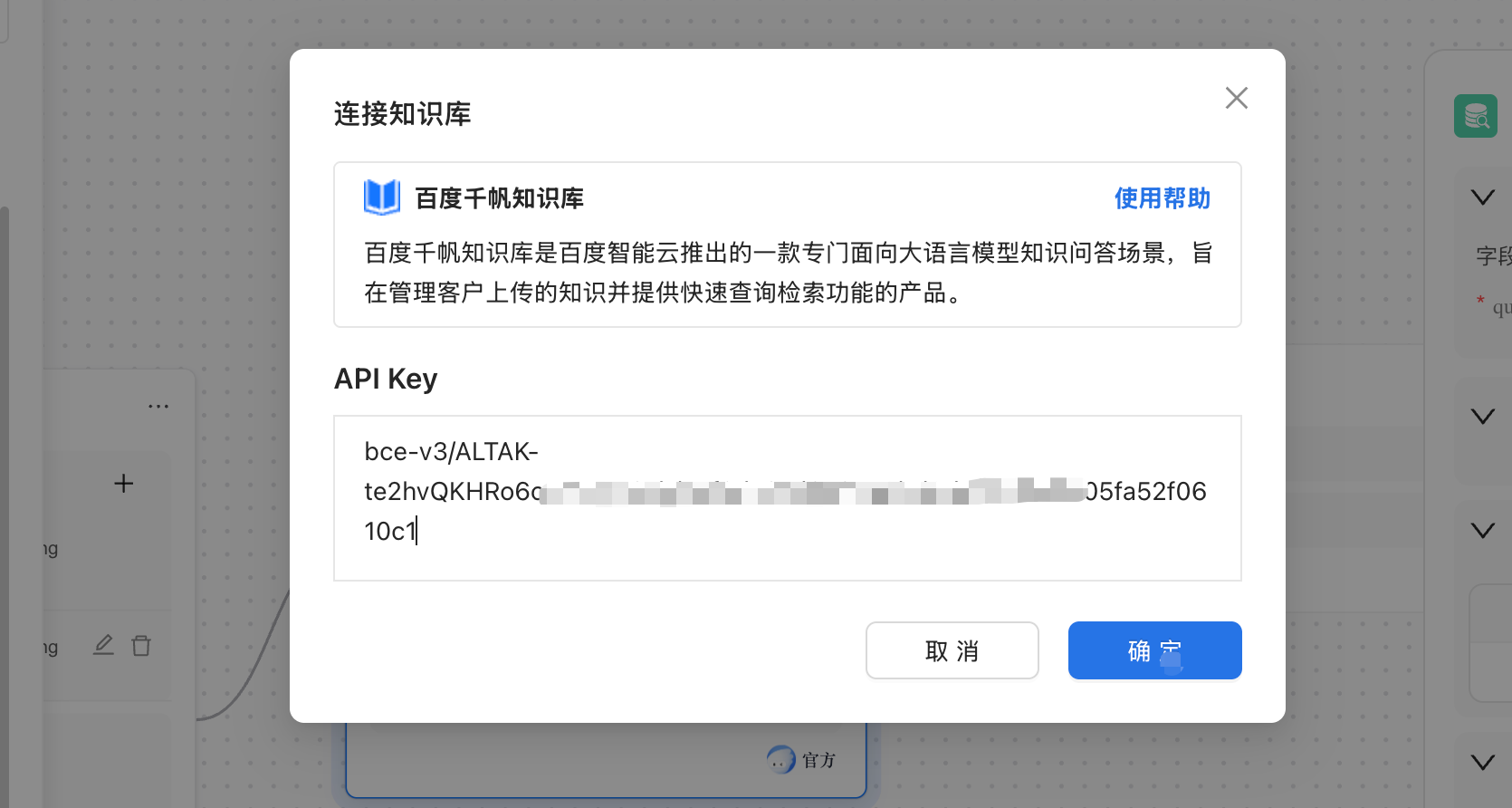

创建成功后就连接知识库。

终于,我们把知识库内容成功导入了… 我已经快玉玉了…

配置好知识库之后,下一步让知识库对接大模型,这里我选用了我们国产之光deepseek-R1

4. 核心实操二:提示词工程——寻找最懂年轻人的“嘴替”

4.1 手写 Prompt 的乏力感

最初,我尝试手写 System Prompt:“你是一个助手,请根据用户的压力情况给出鼓励。”

结果: AI 的回复非常官方(如:“请注意休息,保持心态。”),这显然无法触动大学生群体。

4.2 提效利器:实测“提示词自动生成”

我尝试了 ModelEngine 的 “提示词自动生成” 按钮。

- 操作过程:输入我的原始需求,点击优化。

- 变化效果:系统自动扩充成了结构化的指令,加入了 【角色设定】(幽默且懂梗的学长)、【思维链指导】(先分析压力来源,再给出情绪价值)、以及 【变量引用逻辑】。

- 变量注入:我在 User Prompt 中精准引用了上游节点的变量

{{status}}。这种“自动生成+手动微调”的模式,将 Prompt 的生产力提升了一个量级。

5. 核心实操三:可视化编排——多节点逻辑的“避坑”与调试

5.1 工作流节点配置

在编排界面,我拖拽出了两个核心节点:

- 开始节点 (Start):定义输入变量

status。 - 大模型节点 (LLM):选择 DeepSeek 模型,填入优化后的 Prompt。

5.2 真实调试记录:解决变量引用的“断路”问题

这是我本次开发中最大的“体验点”。

- 遇到困难:第一次点击“运行”调试时,AI 的输出完全没有关联我上传的知识库内容。

- 调试过程:我查看了 ModelEngine 的 “运行轨迹”。在可视化画布上,每个节点的输入输出都可以实时点击查看。

- 发现问题:通过检查

Knowledge Base节点的输出 JSON,我发现召回的分数(Score)太低,导致没有内容传递给下游。 - 解决方案:我立即返回知识库设置,将检索模式从“向量检索”改为“混合检索”,并调整了相似度阈值。

- 体验感:这种“所见即所得”的调试能力,让我在不需要写一行代码的情况下,快速定位了逻辑断点。

6. 结语:AI 应用落地的温度与效率

通过本次对 ModelEngine 的实战体验,我成功上线了“活着吗”生存确认助手。

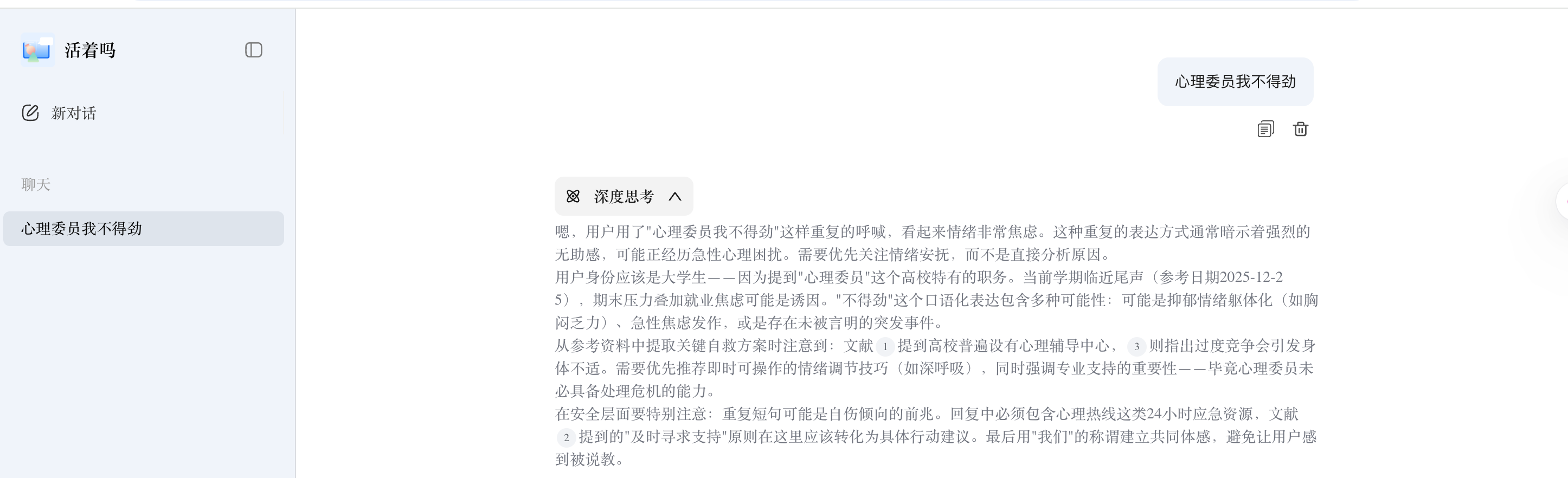

最终产出示例:

用户: “心理委员我不得劲。”

AI 回复: “不哭不哭喝奶奶!不哭不哭喝奶奶!不哭不哭喝奶奶!”

简单放一个思考过程

这个过程让我深刻体会到,可视化编排不仅是提效工具,更是让创意快速落地的实验室。在 ModelEngine 的加持下,开发者可以把更多精力放在“如何共情”上,而不是“如何调 API”上。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)