利用 MCP 构建「个人信息信号系统」--信息获取篇

本文提出构建个人认知与决策支持系统,通过MCP协议实现可控的外部信息获取。系统核心不是收集更多信息,而是将外部信息与个人关注主题对齐筛选,形成可复盘的结构化数据。技术实现上复用开源PersonalizationMCP项目,接入YouTube API并添加个人化筛选逻辑(主题定义、白名单、时间窗口等),最终输出受控的每日Top3信息信号。MCP协议解决了工具集成、能力扩展和智能体协作问题,通过标准化

(首先会介绍该项目的相关信息,然后补齐相关技术知识)

MCP实践

背景:

信息并不稀缺,真正稀缺的是能够持续反映“我当下阶段应该关注什么”的信号,并且这些信号可以被长期积累、回看与复盘。

零散地阅读文章、刷视频或收藏链接,往往只能解决“当下获取信息”的问题,却很难回答更重要的三个问题:

- 最近一段时间真正反复关注的主题是什么?

- 外部世界是否在这些主题上持续释放信号?

- 这些信号是否意味着需要调整接下来的行动或方向?

基于此,计划搭建一个个人认知与决策支持系统,其核心并不是“收集更多信息”,而是:

- 持续记录个人的复盘内容与关注主题

- 将外部信息与个人主题进行对齐与筛选

- 以结构化方式沉淀结果,用于周报、月报以及阶段性方向判断

在这一系统中,信息搜集并不是目的,而只是输入层的一部分。

真正重要的是:

信息如何被筛选、压缩、对齐,并最终转化为可复盘的个人判断依据。

本文将聚焦于其中的第一个子模块:

如何利用 MCP,构建一个可控、可扩展的外部信息获取模块,为后续的个人分析与复盘提供稳定的数据输入。

技术选择:为什么使用 MCP

在实现过程中,并没有从零搭建 MCP Server,而是选择复用 GitHub 上的开源项目 PersonalizationMCP 作为基础能力层:

- MCP 提供了标准化的工具协议与调用方式,适合作为“信息能力层

- 通过复用成熟的 MCP Server,可以将注意力集中在信息筛选逻辑、主题对齐策略、以及结果的长期存档方式的构建,而不是基础设施

实现过程

1)外部信息源接入

- 通过 Google Cloud Console 申请并配置 YouTube Data API v3

- 使 MCP Server 具备稳定、可复用的 YouTube 搜索能力

- 所有部署均在本地完成,便于调试与后续迭代

2)个人化信息筛选逻辑

在 MCP 提供的基础搜索能力之上,额外实现了一层个人化筛选逻辑:

- 使用 themes.yaml 定义当前关注的主题集合

- 使用 channels.yaml 定义信任的频道白名单

- 编写独立 Python 脚本,对搜索结果进行:

- 关键词匹配评分

- 白名单频道加权

- 时间窗口过滤(设置仅通过14天内的视频)

- 最终只保留每日 Top 3 信息信号

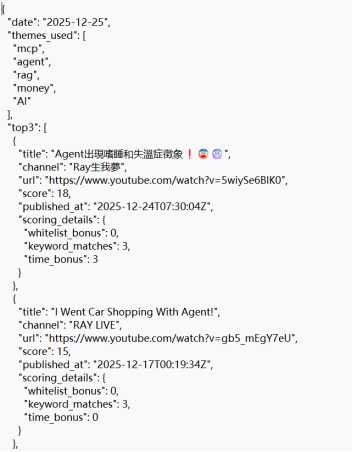

筛选结果以 JSON 形式输出并存档,作为后续日报、周报与趋势分析的基础数据。

结果展示

通过该流程,获得的不再是“搜索结果列表”,而是:数量受控、来源可控、结构稳定的信息

MCP

:(Model Context Protocol)由 Anthropic 团队提出,其核心设计理念是标准化智能体与外部工具/资源的通信方式

-

缺失mcp的问题:

- 首先是工具集成的困境:每当需要访问新的外部服务(如 GitHub API、数据库、文件系统),我们都必须编写专门的 Tool 类,处理不同的 API、认证方式、错误处理等。这不仅工作量大,而且不同开发者编写的工具无法互相兼容。

- 其次是能力扩展的瓶颈:智能体的能力被限制在预先定义的工具集内,无法动态发现和使用新的服务。

- 最后是协作的缺失:当任务复杂到需要多个专业智能体协作时(如研究员+撰写员+编辑),我们只能通过手动编排来协调它们的工作。

-

接入mcp效果:

- 标准化接口让不同服务提供统一的访问方式

- 互操作性使得不同开发者的工具可以无缝集成

- 动态发现允许智能体在运行时发现新的服务和能力

- 可扩展性让系统能够轻松添加新的功能模块

-

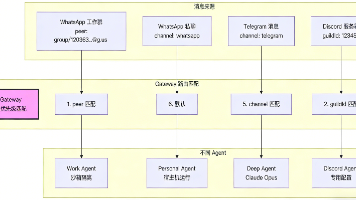

MCP协议处理流程:

- Host:Host 是用户直接交互的界面,接受用户问题并决定联系哪些组件。

- Client:负责与适当的 MCP Server 建立连接,发送请求并接收响应。

- Server:执行操作,具体功能实现。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)