多轮对话式测试设计:重构软件质量保障新范式

AI驱动对话式测试设计变革传统测试脚本面临场景覆盖不足、维护成本高和反馈延迟等问题。AI测试代理通过动态生成测试场景、数据和用例模板,显著提升测试效率。其三层交互模型(需求转化、场景扩展、自愈优化)可实现40%场景覆盖提升和60%维护成本降低。实践表明,金融APP回归测试时长缩短70%,新人设计效率提升300%。但需设置交互深度阈值防止资源浪费。未来测试工程师将转向业务治理、风险策略和伦理监护等更

一、传统测试设计的瓶颈与AI驱动变革

在快速迭代的DevOps环境中,传统脚本化测试面临三大核心挑战:

-

场景覆盖盲区:仅能验证预设路径,难以捕捉用户非常规操作

-

维护成本飙升:业务逻辑变更导致30%以上用例需重构(2025年行业调研数据)

-

反馈延迟:平均缺陷发现周期>72小时,影响CI/CD流水线效率

对话式测试设计通过引入AI对话代理(Testing Agent),建立“需求-场景-数据”的动态生成闭环。例如:

测试员输入:“模拟高龄用户使用医保支付功能的异常流程”

AI响应:

1. 生成7组测试场景(含语音输入识别失败、证件拍照模糊等边缘情况)

2. 自动构建测试数据集(含65-80岁用户画像库)

3. 输出Gherkin语法用例模板

二、多轮交互框架的三层进化模型

|

交互层级 |

技术支撑 |

输出产物 |

测试覆盖率提升 |

|---|---|---|---|

|

L1 需求转化 |

NLP意图识别 |

用户旅程图谱 |

+40%场景覆盖 |

|

L2 场景扩展 |

强化学习决策树 |

动态测试路径矩阵 |

缺陷检出率↑35% |

|

L3 自愈优化 |

差分日志分析 |

智能测试维护建议报告 |

维护成本↓60% |

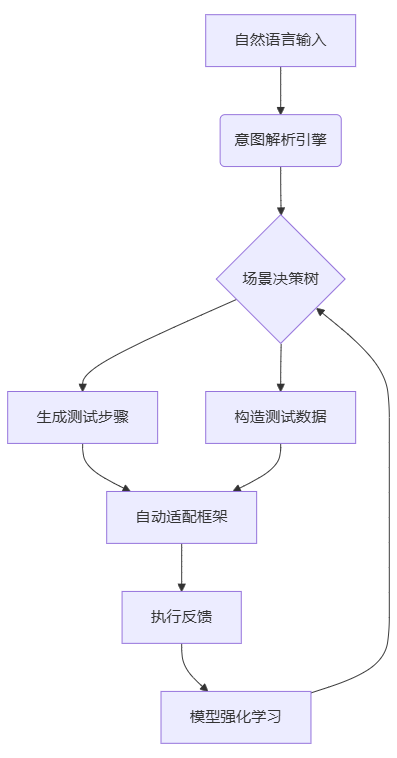

典型交互流程:

-

需求澄清:AI追问业务规则细节(如“请说明跨境支付的货币转换容错阈值”)

-

场景衍生:基于历史缺陷库生成变异用例(如“支付中断后余额校验”)

-

数据反哺:将执行结果反馈至模型训练闭环

三、落地实践:对话式测试平台架构

关键技术实现:

-

动态语境维持:通过Session Token保持多轮对话上下文关联

-

风险权重算法:基于代码变更分析自动提升高危模块测试密度

-

视觉化校验:CV技术比对UI截图与原型差异(ΔE<2.0色容差标准)

四、行业验证数据(2025 Q3基准报告)

-

金融APP项目:对话式设计使回归测试时长从14.3h→4.2h

-

IoT设备测试:通过语音交互发现23%未定义硬件异常场景

-

测试团队效能:新人用例设计效率提升300%(IBM质量工程实验室数据)

警示点:需建立伦理边界机制,防止测试场景过度生成导致资源浪费(推荐设置<5轮/会话的交互深度阈值)

结语:人机协作的测试新纪元

当AI成为“永不疲倦的测试构想者”,测试工程师的核心价值将转向:

-

业务规则治理:训练领域知识图谱的准确性与完整性

-

风险策略制定:定义测试深度与广度的平衡点

-

伦理合规监护:确保AI生成的测试行为符合法规要求

人机协同的对话式测试不是替代,而是将人类创造力从重复劳动中释放,转向更高阶的质量战略设计。

精选文章

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)