机器学习046:深度学习【经典神经网络】循环神经网络(RNN)-- 让AI拥有“短期记忆”的智慧

循环神经网络(RNN)是一种能够处理序列数据的特殊神经网络,通过引入记忆机制来理解上下文信息。RNN的核心在于其反馈连接结构,使当前输出不仅依赖当前输入,还取决于前一时刻的状态,从而实现对时间序列数据的建模。然而,RNN存在梯度消失/爆炸问题,难以捕捉长期依赖关系,这催生了LSTM、GRU等改进模型。RNN广泛应用于机器翻译、语音识别、文本生成等场景,但在处理独立数据或超长序列时表现不佳。通过Py

每次和智能音箱对话时,你是否好奇它如何“记住”你刚刚说过的话?

想象这样一个场景:你和智能助手小爱同学聊天。你说:“今天天气不错,我们…” 小爱立刻接上:“去公园散步怎么样?” 这个看似简单的回应背后,隐藏着一种特殊的神经网络技术——它能像人类一样,理解上下文,记住刚刚的信息,从而做出合理的回应。今天,我们就来揭开这项技术的神秘面纱:循环神经网络(RNN)。

一、认识循环神经网络:神经网络家族中的“记忆大师”

RNN在神经网络家族中的位置

如果把神经网络比作一个大家庭,那么RNN绝对是其中最擅长处理时间序列信息的那位成员。

从网络结构拓扑来看,神经网络主要分为两类:

- 前馈神经网络(如全连接网络、CNN):信息像单向流水线,从输入层流向输出层,中间没有“回路”

- 反馈/循环神经网络(RNN):信息可以“转圈圈”,形成环路,让网络拥有记忆能力

从功能用途来看,RNN是序列数据处理专家。什么是序列数据?任何顺序很重要的数据:一句话(词的序列)、一段语音(声音信号的序列)、股票价格(时间序列)、电影(图像的序列)等等。

提出的背景和时间:

RNN的概念最早可以追溯到20世纪80年代。1982年,美国学者约翰·霍普菲尔德提出了霍普菲尔德网络,这是最早的循环网络之一。但真正奠定现代RNN基础的是1990年杰弗里·辛顿等人的工作。当时,科学家们面临一个核心问题:传统神经网络无法有效处理序列信息,因为它们把每个输入当作独立的,忽视了数据在时间上的关联性。

一句话概括RNN的核心价值:

RNN通过引入“记忆”机制,让神经网络能够理解和处理具有时间顺序的数据,是让AI学会“联系上下文”的关键技术。

二、底层原理:RNN如何工作?——从“记忆面包”说起

核心类比:记忆面包与短期记忆

看过《哆啦A梦》吗?里面有一种神奇的道具叫**“记忆面包”——把面包印在书上,吃下去就能记住书上的内容。但问题是,这种记忆是短期的**,很快就会忘记。

基础RNN的工作方式很像这种“短期记忆”:

- 每次处理新信息时,都带着一点之前的记忆

- 新的记忆会覆盖旧的记忆

- 时间间隔越长,对过去的记忆越模糊

RNN的核心设计:带“记忆”的神经元

普通神经元的输出只取决于当前的输入。RNN神经元则不同——它的输出不仅取决于当前输入,还取决于自己上一刻的状态。

让我用一个简单的比喻来解释:

想象你在读一本小说。当你读到第10页时,你的理解不仅基于这第10页的文字,还基于前面9页的情节。RNN的工作原理与此类似——它有一个**“隐状态”(hidden state)**,就像是神经网络的“记忆”,随着时间不断更新。

信息传递方式:

RNN采用的是反馈连接。具体来说:

- 当处理序列中的第t个元素时,RNN会接收两个输入:

- 当前时刻的输入(如当前单词)

- 上一时刻的“隐状态”(即之前的记忆)

- 然后产生两个输出:

- 当前时刻的输出(如对这个单词的理解)

- 更新后的“隐状态”(作为下一时刻的记忆)

用文字描述RNN的核心计算逻辑

假设我们正在用RNN处理一句话:“我/爱/人工智能”。处理过程如下:

-

处理“我”字时:

- 输入:“我”的编码

- 记忆:初始化为零(还没有任何记忆)

- 输出:基于“我”字的理解

- 更新记忆:形成关于“我”的记忆

-

处理“爱”字时:

- 输入:“爱”的编码

- 记忆:关于“我”的记忆

- 输出:基于“我”和“爱”的理解(如“我爱”)

- 更新记忆:形成关于“我爱”的记忆

-

处理“人工智能”时:

- 输入:“人工智能”的编码

- 记忆:关于“我爱”的记忆

- 输出:基于整个句子的理解(如“我爱人工智能”)

- 更新记忆:形成关于整句话的记忆

RNN的数学表达(了解即可)

对于初学者,你不需要记住这些公式,只需要了解它们表达了什么思想:

ht=tanh(Wxh∗xt+Whh∗ht−1+bh) h_t = tanh(W_xh * x_t + W_hh * h_{t-1} + b_h)ht=tanh(Wxh∗xt+Whh∗ht−1+bh)

yt=Why∗ht+byy_t = W_hy * h_t + b_y yt=Why∗ht+by

通俗解释:

h_t:当前时刻的“记忆”(隐状态)h_{t-1}:上一时刻的“记忆”x_t:当前输入W_xh:输入到记忆的权重(决定当前输入对记忆的影响)W_hh:记忆到记忆的权重(决定旧记忆对新记忆的影响)tanh:激活函数(给网络增加非线性,让它可以学习更复杂的关系)y_t:当前输出

训练的核心逻辑:

RNN通过**反向传播通过时间(BPTT)**算法学习。简单来说:

- 网络先顺着时间正向处理整个序列,得到一系列输出

- 计算输出与正确答案的差距(损失)

- 将这个差距沿着时间反方向传播回去,调整网络参数

- 目标是让网络学会:在序列的每个位置,都做出更准确的预测或判断

三、局限性:RNN的“记忆短板”

虽然RNN引入了记忆机制,但它有一个致命的弱点:短期记忆问题。

梯度消失/爆炸问题

这是RNN最著名的问题。让我们用一个比喻来理解:

想象你在玩“传话游戏”:第一个人说一句话,传给第二个人,第二个人传给第三个人…传到第十个人时,原话往往已经面目全非。

RNN在训练时也会遇到类似问题。当序列很长时(比如100个词),网络需要将误差从第100个词反向传播到第1个词。在这个过程中,梯度(可以理解为“调整信号”)会不断相乘:

- 如果这些乘数都小于1,梯度会越来越小,直到消失——前面层的参数几乎得不到更新,网络学不到长距离依赖

- 如果这些乘数都大于1,梯度会越来越大,直到爆炸——参数更新过大,训练不稳定

为什么会有这个局限?

因为基础RNN的“记忆更新”机制太简单:新的记忆完全覆盖旧的记忆。就像一块黑板,每次写新内容时,旧内容就被擦掉一部分。时间长了,最早写的内容就几乎看不清了。

其他局限性

- 难以并行计算:由于RNN必须按顺序处理序列,无法同时计算所有时间步,导致训练速度较慢

- 对长期依赖捕捉能力弱:即使没有梯度消失,基础RNN也难以记住几十步之前的信息

这些局限性促使研究人员发明了RNN的改进版本,最著名的是LSTM(长短期记忆网络)和GRU(门控循环单元)。它们通过引入“门控机制”,像有选择性地记住重要信息、忘记不重要信息,大大增强了网络的长期记忆能力。

四、使用范围:何时该用RNN?

适合RNN解决的问题类型:

-

序列到序列的任务:

- 机器翻译(中文→英文)

- 语音识别(声音→文字)

- 视频描述生成(视频→文字描述)

-

序列到标签的任务:

- 文本情感分析(一句话→积极/消极)

- 股票走势预测(历史价格→涨/跌)

- 用户行为分类(用户操作序列→用户意图)

-

序列生成任务:

- 文本生成(给定开头,续写文章)

- 音乐生成(生成连贯的旋律)

- 对话生成(聊天机器人)

-

时间序列预测:

- 天气预报

- 电力负荷预测

- 销售量预测

不适合使用RNN的场景:

- 独立同分布的数据:如果每个样本相互独立,没有时间或顺序关系(如图像分类),用CNN或全连接网络更好

- 超长序列:如果序列长度达到数百或数千,即使LSTM/GRU也可能力不从心,这时可以考虑Transformer架构

- 对实时性要求极高的场景:由于RNN的串行特性,处理速度可能成为瓶颈

简单判断法则:

如果你的数据顺序很重要,改变顺序会改变含义(如文字、语音),或者数据随时间变化(如传感器读数、股票价格),那么RNN家族很可能是一个好选择。

五、应用场景:RNN在我们身边

1. 智能输入法预测

场景:用手机打字时,输入法会猜测你下一个要输入的词

RNN的作用:分析你已经输入的部分,基于上下文预测最可能的下一个词。例如,输入“今天天气”,RNN根据大量文本训练的经验,会高概率预测“不错”“很好”“怎么样”等词。

2. 智能客服与聊天机器人

场景:电商平台的智能客服、手机语音助手

RNN的作用:理解用户整个对话历史,给出连贯的回应。如果用户说:“我想买一双运动鞋。要黑色的。”RNN会记住“运动鞋”这个上下文,知道“黑色的”指的是运动鞋的颜色,而不是其他商品。

3. 股票价格预测

场景:金融机构预测股票走势

RNN的作用:分析历史价格序列,识别价格变化的模式和趋势。虽然不能100%准确(市场受太多因素影响),但可以捕捉到一些技术指标难以发现的复杂时间模式。

4. 视频动作识别

场景:监控系统中识别可疑行为、短视频平台自动打标签

RNN的作用:视频是图像的序列。RNN分析连续帧之间的关系,识别动作的连续性。例如,区分“挥手告别”和“招手过来”这两个动作,关键就在于分析手部运动的时序模式。

5. 作曲与音乐生成

场景:AI音乐创作工具

RNN的作用:将音符看作序列,学习音乐作品中的和声、节奏模式,然后生成新的、连贯的旋律。比如,给定几个起始音符,RNN可以续写成一段完整的旋律。

六、实践案例:用Python实现简单的RNN情感分析

让我们通过一个简单的例子,看看RNN如何判断一段评论是正面还是负面的。

import numpy as np

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, SimpleRNN, Dense

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

# 1. 准备数据(简化版)

texts = [

"这部电影太好看了,演员演技一流",

"完全浪费时间,剧情糟糕透顶",

"音乐很棒,但故事有点拖沓",

"年度最佳,强烈推荐给大家",

"看到一半就睡着了,太无聊了",

"导演功力深厚,画面精美绝伦"

]

labels = [1, 0, 0.5, 1, 0, 1] # 1:正面, 0:负面, 0.5:中性

# 2. 文本转为数字序列

tokenizer = Tokenizer(num_words=1000)

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

# 统一序列长度(填充/截断)

data = pad_sequences(sequences, maxlen=10)

# 3. 划分训练集和测试集(这里简单处理)

train_data = data[:4]

train_labels = labels[:4]

test_data = data[4:]

test_labels = labels[4:]

# 4. 构建RNN模型

model = Sequential([

# 嵌入层:将词索引转换为密集向量

Embedding(input_dim=1000, output_dim=16, input_length=10),

# SimpleRNN层:核心循环层

SimpleRNN(units=32, activation='tanh'),

# 输出层:二分类(正面/负面)

Dense(1, activation='sigmoid')

])

# 5. 编译模型

model.compile(

optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy']

)

# 6. 训练模型

model.fit(

train_data,

train_labels,

epochs=20,

batch_size=2,

verbose=1

)

# 7. 测试模型

test_loss, test_acc = model.evaluate(test_data, test_labels)

print(f"\n测试准确率: {test_acc:.2%}")

# 8. 使用模型进行预测

new_texts = ["这部电影一般般,不算太好也不算太差", "非常感人的故事,我看哭了"]

new_sequences = tokenizer.texts_to_sequences(new_texts)

new_data = pad_sequences(new_sequences, maxlen=10)

predictions = model.predict(new_data)

for text, pred in zip(new_texts, predictions):

sentiment = "正面" if pred > 0.6 else "负面" if pred < 0.4 else "中性"

print(f"文本: {text}")

print(f"情感倾向: {sentiment} (置信度: {pred[0]:.2%})\n")

代码解释:

- 嵌入层:将每个词转换为一个向量(可以理解为词的“数学表示”)

- SimpleRNN层:核心循环层,处理词序列,逐步积累对句子的理解

- 输出层:输出一个0-1之间的值,表示正面情感的概率

- 模型通过学习大量带标签的文本,学会如何从词序列推断情感倾向

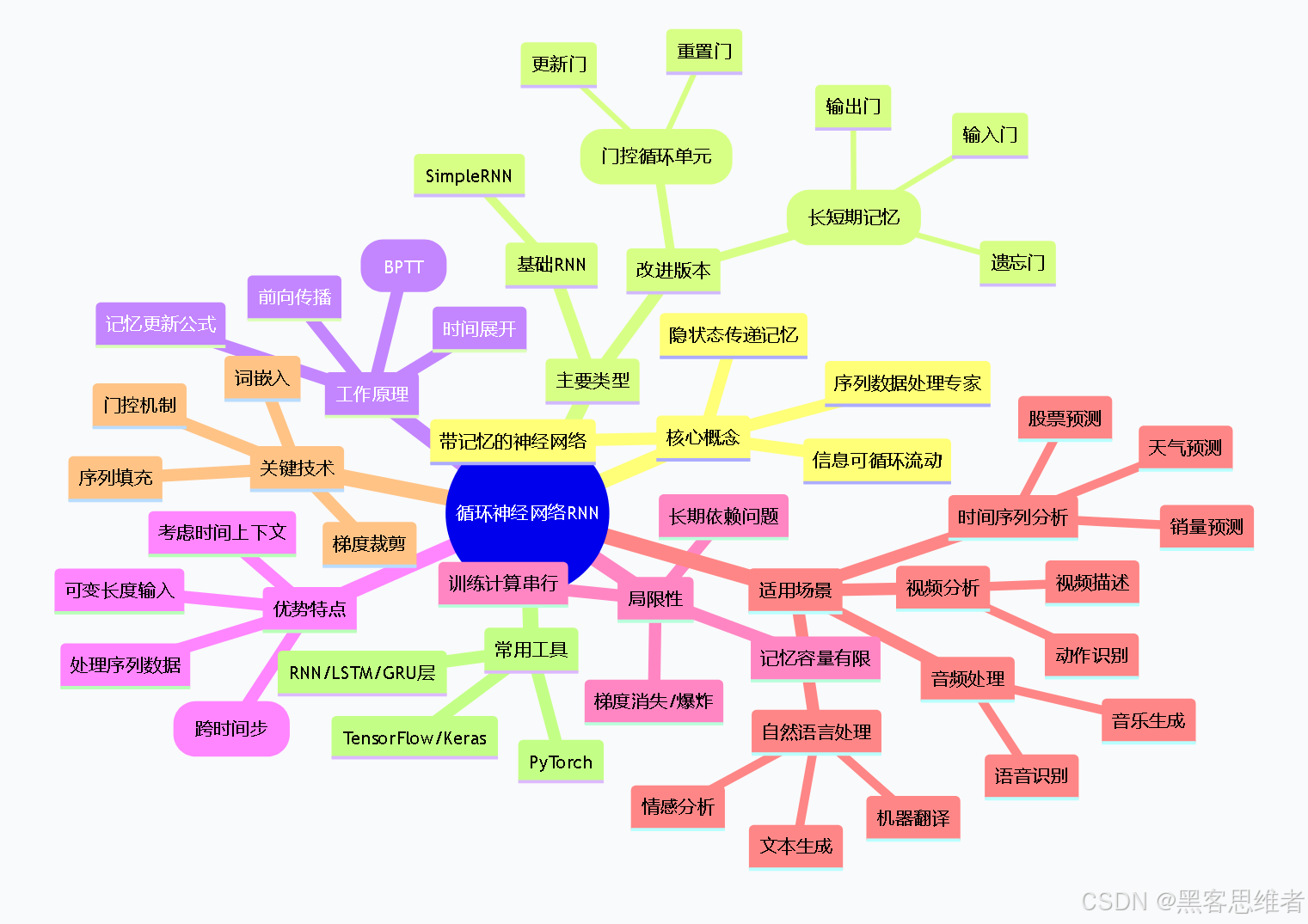

七、思维导图:RNN知识体系全景

mindmap

root((循环神经网络RNN))

核心概念

序列数据处理专家

带记忆的神经网络

信息可循环流动

隐状态传递记忆

主要类型

基础RNN

SimpleRNN

改进版本

LSTM(长短期记忆)

遗忘门

输入门

输出门

GRU(门控循环单元)

更新门

重置门

工作原理

时间展开

记忆更新公式

前向传播

反向传播(BPTT)

优势特点

处理序列数据

考虑时间上下文

参数共享(跨时间步)

可变长度输入

局限性

梯度消失/爆炸

长期依赖问题

训练计算串行

记忆容量有限

适用场景

自然语言处理

机器翻译

文本生成

情感分析

时间序列分析

股票预测

销量预测

天气预测

音频处理

语音识别

音乐生成

视频分析

动作识别

视频描述

关键技术

词嵌入

序列填充

梯度裁剪

门控机制

常用工具

TensorFlow/Keras

PyTorch

RNN/LSTM/GRU层

总结:理解RNN的核心要点

循环神经网络(RNN)的核心思想可以用一句话概括:通过让信息在网络中循环流动,RNN赋予了神经网络短期记忆能力,使其能够理解和处理序列数据中的时间依赖关系。

对于初学者,记住以下三个关键点就够了:

- RNN是为序列数据设计的:如果你的数据有顺序(如文字、语音、时间序列),就该考虑RNN

- RNN有记忆但会遗忘:它像短期记忆,能记住近期信息,但对很久以前的信息会逐渐模糊

- LSTM/GRU是RNN的升级版:它们通过“门控”机制,更智能地选择记住什么、忘记什么,解决了基础RNN的长期依赖问题

学习RNN的价值不仅在于掌握一种神经网络,更在于理解如何处理序列数据这一AI核心问题。从RNN到LSTM,再到如今大火的Transformer,这些技术都在尝试回答同一个问题:如何让机器更好地理解上下文和顺序?

现在,当你的输入法准确预测出你想说的下一个词时,当智能音箱理解你的多轮对话时,你都能会心一笑——你知道,这背后很可能有一位“记忆大师”在默默工作,它的名字叫循环神经网络。

更多推荐

已为社区贡献91条内容

已为社区贡献91条内容

所有评论(0)