AI 运维入门必懂:AI 项目落地全流程的运维关注点

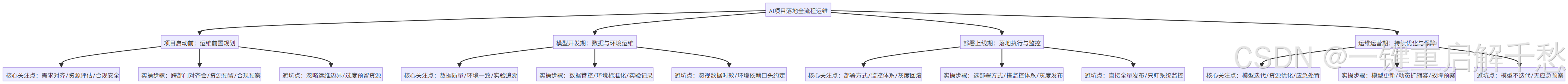

AI运维全流程指南:从项目启动到持续运营 摘要:本文系统梳理AI项目落地的4大关键阶段运维要点。1)启动前:需求对齐、资源评估及合规规划;2)开发期:数据质量管理、环境标准化及实验追溯;3)部署期:模型部署选择、监控体系搭建及灰度发布;4)运营期:模型迭代更新、资源优化及故障应急。通过实操步骤、典型案例和避坑指南,帮助运维人员掌握AI项目全生命周期管理要点,解决"模型训练好却跑不好&qu

核心提要:本文聚焦 AI 项目从启动前到运维运营期的全流程,拆解 4 大关键阶段的核心运维关注点,附实操步骤、避坑指南与真实案例,帮入门者快速掌握“AI 运维该在什么时候做什么、怎么避坑”,助力 AI 项目平稳落地与持续运行。

在 AI 技术落地热潮中,很多企业面临“模型训练得好,却跑不起来、跑不好”的困境——问题往往出在“AI 运维”的缺失。与传统 IT 运维不同,AI 运维不仅要保障“系统能跑”,还要兼顾数据质量、模型性能、资源适配等特殊需求。对于入门者而言,最困惑的是“不知道在 AI 项目的哪个阶段该关注什么”。本文按 AI 项目落地时间线,一步步拆解每个阶段的运维核心动作。

以下树形图清晰呈现 AI 项目落地全流程的运维核心框架:

一、项目启动前:运维前置规划(把风险挡在前面)

AI 项目的运维不是“上线后才开始”,而是要在启动前就前置介入,核心是“对齐需求、评估资源、规避先天风险”——就像盖房子前要先规划地基大小、承重能力,避免后续返工。

核心关注点

-

需求与运维目标对齐

-

资源(硬件/软件/网络)评估

-

合规与安全前置规划

实操步骤(拆细+为什么)

-

召开跨部门对齐会(目的:明确 AI 项目的业务目标与运维边界)

-

对接业务方:确认 AI 项目的核心指标(如推荐系统的点击率、风控模型的准确率),明确“运维需要保障什么”(如 7×24 可用、响应延迟<500ms);

-

对接算法团队:明确模型类型(如深度学习/机器学习)、数据量级(日增量 GB/TB 级)、推理时的资源需求(CPU/GPU 算力),避免后续资源不足或浪费。

-

-

资源评估与预留(目的:匹配项目需求,避免上线后“卡脖子”)

-

硬件资源:按模型规模估算(例:深度学习模型推理优先选 GPU,日均 1000 万次调用需预留 2-4 块 V100 显卡;简单机器学习模型用 CPU 即可满足);

-

软件与环境:确认依赖的框架(TensorFlow/PyTorch)、版本兼容性,提前规划容器化(Docker)或云原生(K8s)部署方案(推荐中小项目用 Docker,大型分布式项目用 K8s);

-

网络资源:若涉及跨区域数据传输(如边缘节点采集数据到云端训练),需评估带宽是否满足(例:日增量 100GB 数据需预留 100Mbps 以上带宽)。

-

-

合规与安全预案(目的:规避法律风险,保护数据与模型安全)

-

数据合规:梳理数据来源(是否涉及用户隐私),确认是否符合《个人信息保护法》,规划数据脱敏方案(如手机号脱敏为“138****1234”);

-

模型安全:明确模型是否涉及核心业务(如算法专利),规划访问权限控制(仅算法与运维人员可查看模型文件)。

-

避坑点

-

坑 1:只关注业务目标,忽略运维边界。案例:某企业 AI 客服项目启动时未明确响应延迟要求,上线后因峰值并发调用导致延迟超 3 秒,用户投诉激增;

-

坑 2:过度预留资源造成浪费。案例:某小型分类模型按大型深度学习模型预留 GPU 资源,每月多花 5 万元服务器成本,实际 CPU 即可满足需求。

二、模型开发期:数据与环境运维(打好“训练地基”)

模型开发期的核心是“保障数据靠谱、环境稳定”——数据是 AI 模型的“食物”,环境是“训练场地”,食物变质、场地混乱,再优秀的算法也练不出好用的模型。

核心关注点

-

数据质量与版本管理

-

开发环境一致性

-

实验过程可追溯

实操步骤(拆细+注意点)

-

数据质量管控(目的:避免“垃圾数据练出垃圾模型”)

-

步骤 1:数据清洗自动化脚本开发(注意:重点处理缺失值、异常值,例:用 Pandas 过滤偏离均值 3 倍标准差的数据);

-

步骤 2:数据质量校验(每天定时执行校验脚本,检查数据完整性≥99%、准确率≥98%,例:用户行为数据中“点击时间”字段不能为空);

-

步骤 3:数据版本管理(用 DVC 工具记录数据变更,每轮训练的数据集打上版本标签,例:data_v1.0 对应 2024 年 1-3 月数据)。

-

-

开发环境标准化(目的:避免“本地能跑,换台机器就报错”)

-

用 Docker 封装开发环境,编写 Dockerfile 记录依赖包版本(例:指定 TensorFlow==2.10.0、Python==3.9);

-

搭建共享开发环境(如 JupyterHub),算法团队统一使用相同环境,减少环境差异导致的问题。

-

-

实验过程追溯(目的:方便后续排查问题、复现结果)

-

用 MLflow 工具记录每轮实验的参数(如学习率、迭代次数)、指标(如准确率、损失值)、模型文件;

-

要求算法团队每轮实验提交“实验报告”,标注数据版本、环境配置、核心结果。

-

避坑点

-

坑 1:忽视数据时效性。案例:某电商推荐模型用 1 年前的用户行为数据训练,上线后推荐准确率仅 30%,因用户偏好已发生变化;

-

坑 2:环境依赖“口头约定”。案例:算法工程师本地用 TensorFlow 2.8 开发,运维部署时用 2.12 版本,导致模型加载失败,延误上线 2 天。

三、部署上线期:落地执行与监控(让模型“平稳上岗”)

部署上线是 AI 项目从“实验室”走向“生产环境”的关键一步,运维核心是“保障模型稳定部署、实时监控、快速响应”——就像把训练好的“智能机器人”送到工作岗位,既要确保它能顺利启动,还要实时盯着它的工作状态。

核心关注点

-

模型部署方式选择

-

实时监控体系搭建

-

灰度发布与回滚预案

实操步骤(拆细+为什么)

-

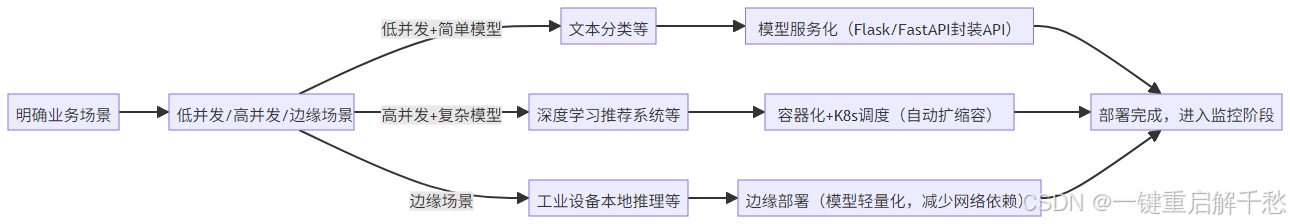

选择合适的部署方式(目的:匹配业务场景,平衡性能与成本)

不同业务场景对应的部署方式选择流程如下:

-

搭建全链路监控体系(目的:实时发现问题,避免故障扩大)

-

监控维度:

-

模型层:推理延迟(≤500ms 为合格)、准确率/召回率(每日统计,波动超 5% 触发告警)、模型漂移(用 PSI 指标监控数据分布变化,PSI>0.2 需警惕);

-

系统层:CPU/GPU 使用率(峰值不超过 80%)、内存占用、接口调用成功率(≥99.9%);

-

-

工具选择:Prometheus+Grafana(监控系统指标)、自定义脚本监控模型性能、ELK 栈收集日志。

-

-

灰度发布与回滚预案(目的:降低上线风险)

-

灰度发布:先将模型部署到 10% 的用户流量,观察 24 小时监控数据(无异常再逐步扩量到 50%、100%);

-

回滚预案:提前备份旧版本模型与环境配置,若新版本出现问题(如准确率暴跌、延迟超标),10 分钟内触发回滚。

-

避坑点

-

坑 1:直接全量发布。案例:某金融风控模型未做灰度,全量上线后因模型漂移导致误判率激增,产生百万级损失;

-

坑 2:监控只盯系统不盯模型。案例:某 AI 图像识别项目上线后,系统 CPU/GPU 正常,但模型识别准确率从 95% 降至 70%,因未监控模型指标,3 天后才发现问题。

四、运维运营期:持续优化与保障(让模型“越跑越好”)

AI 模型上线不是终点,而是“持续运营”的起点——模型会随着数据变化、业务迭代出现“性能衰退”,运维核心是“持续监控、及时优化、保障长期价值”。

核心关注点

-

模型迭代与更新

-

资源动态优化

-

故障应急处置

实操步骤(拆细+注意点)

-

模型迭代运维(目的:应对模型漂移,保持性能稳定)

-

定期数据更新:每周/每月更新训练数据集(纳入最新业务数据),重新训练模型(用 MLflow 对比新旧模型指标,达标后再部署);

-

模型版本管理:每次迭代的模型打上版本标签(如 model_v2.1),保留历史版本,方便回滚;

-

迭代发布流程:复用“灰度发布”逻辑,避免迭代导致的故障。

-

-

资源动态优化(目的:平衡性能与成本)

-

高峰扩容:根据监控数据,设置 K8s 自动扩缩容规则(例:接口并发量>1000 时,自动增加 2 个容器实例);

-

低峰缩容:非高峰时段(如凌晨 0-6 点),减少闲置资源(如将 GPU 实例从 4 块减至 1 块);

-

资源升级评估:若长期 CPU/GPU 使用率超 80%,且扩缩容无法解决,评估升级硬件(如更换更高算力的 GPU)。

-

-

故障应急处置(目的:快速解决问题,减少业务损失)

-

制定故障分级预案:

-

一级故障(模型不可用、响应延迟超 3 秒):5 分钟内响应,优先回滚旧版本,再排查问题;

-

二级故障(准确率波动 5%-10%):30 分钟内响应,分析原因(数据漂移/环境问题),针对性处理;

-

-

建立故障复盘机制:每次故障后 24 小时内完成复盘,记录“问题原因、处理过程、改进措施”,避免重复发生。

-

避坑点

-

坑 1:模型“一劳永逸”不迭代。案例:某天气预测 AI 模型上线后未更新数据,半年后预测准确率从 85% 降至 60%,失去业务价值;

-

坑 2:应急处置无预案。案例:某 AI 翻译项目因服务器宕机,运维人员未准备回滚方案,导致业务中断 2 小时,损失超 10 万元。

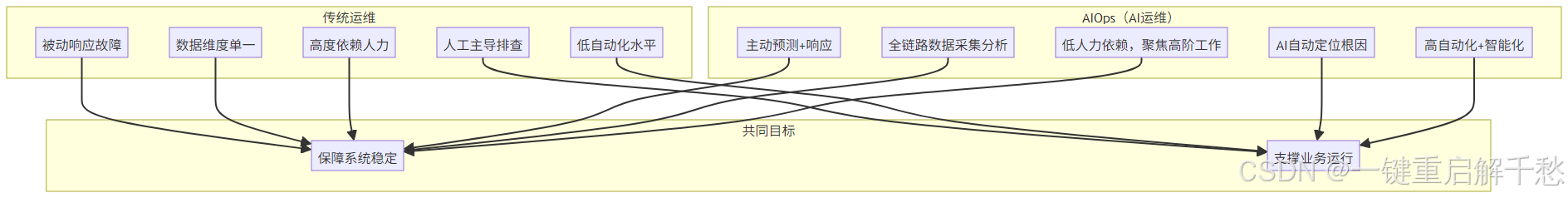

五、AI 运维核心术语小词典(新手必备)

AI运维与传统运维核心差异对比(双重气泡图):

-

模型漂移:AI 模型的输入数据分布或业务场景发生变化,导致模型性能(准确率、召回率)下降的现象;

-

灰度发布:将新版本模型逐步推向部分用户,验证无问题后再全量发布的方式,降低上线风险;

-

容器化(Docker):将模型、依赖包、环境配置封装成独立“容器”,实现“一次打包,到处运行”,解决环境一致性问题;

-

K8s(Kubernetes):容器编排工具,可自动管理容器的部署、扩缩容、故障恢复,适合高并发 AI 项目;

-

MLflow/DVC:AI 实验与数据版本管理工具,用于记录实验过程、数据变更、模型版本,方便追溯与复现;

-

PSI(群体稳定性指标):衡量数据分布变化的指标,PSI<0.1 表示数据分布稳定,PSI>0.2 表示数据漂移严重。

-

模型漂移:AI 模型的输入数据分布或业务场景发生变化,导致模型性能(准确率、召回率)下降的现象;

-

灰度发布:将新版本模型逐步推向部分用户,验证无问题后再全量发布的方式,降低上线风险;

-

容器化(Docker):将模型、依赖包、环境配置封装成独立“容器”,实现“一次打包,到处运行”,解决环境一致性问题;

-

K8s(Kubernetes):容器编排工具,可自动管理容器的部署、扩缩容、故障恢复,适合高并发 AI 项目;

-

MLflow/DVC:AI 实验与数据版本管理工具,用于记录实验过程、数据变更、模型版本,方便追溯与复现;

-

PSI(群体稳定性指标):衡量数据分布变化的指标,PSI<0.1 表示数据分布稳定,PSI>0.2 表示数据漂移严重。

总结

AI 运维的核心逻辑是“前置规划+过程管控+持续优化”,它不是孤立的“运维工作”,而是贯穿 AI 项目全生命周期的“协同工作”——从启动前的资源评估,到开发期的数据与环境管控,再到上线后的监控与迭代,每个阶段都要紧扣“业务目标+模型特性+系统稳定”。

对于入门者而言,不用追求一步掌握所有技术,先按“全流程阶段”理清核心关注点,再通过实操案例积累经验,避开常见坑,就能逐步实现“让 AI 模型平稳落地、持续创造价值”的目标。随着 AI 技术的普及,AI 运维将成为运维领域的核心能力,提前掌握全流程关注点,能让你在 AI 落地浪潮中抢占先机。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)