薅羊毛也要讲技术:AI Ping 平台免费体验 GLM-4.7 与 MiniMax-M2.1

AI Ping 平台提出了“一站式大模型服务评测与 API 调用”的解决方案,试图通过统一入口、统一调用方式和统一体验,帮助开发者更高效地使用大模型。本文将围绕 AI Ping 平台展开,重点聚焦当前平台中两款较新且能力突出的模型——GLM-4.7 与 MiniMax-M2.1,从平台定位、模型能力、工程实践和选型建议等多个维度进行系统梳理与分析,力求为开发者提供一篇具有实用价值的参考指南。

https://aiping.cn/#?channel_partner_code=GQCOZLGJ (注册登录立享30元算力金)

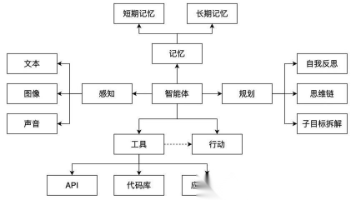

大模型正在从“通用对话能力展示阶段”迈入“深度参与真实业务系统”的新阶段。无论是代码生成、智能体构建,还是复杂流程编排与多工具协同,大模型已经不再只是一个“会聊天的助手”,而逐渐成为软件系统中的关键能力组件。

然而,在实际落地过程中,开发者往往会面临一系列现实问题:

模型太多,接口各异; 评测成本高,切换成本大; 计费复杂,难以精细控制; 新模型更新快,跟进困难。

正是在这样的背景下,AI Ping 平台提出了“一站式大模型服务评测与 API 调用”的解决方案,试图通过统一入口、统一调用方式和统一体验,帮助开发者更高效地使用大模型。

本文将围绕 AI Ping 平台展开,重点聚焦当前平台中两款较新且能力突出的模型——GLM-4.7 与 MiniMax-M2.1,从平台定位、模型能力、工程实践和选型建议等多个维度进行系统梳理与分析,力求为开发者提供一篇具有实用价值的参考指南。

1. AI Ping 平台概览

1.1 平台定位与设计理念

AI Ping 平台的核心定位可以概括为一句话:

让大模型调用更快、更稳、更省钱。

围绕这一目标,平台在设计上遵循了三个重要原则:

- 降低接入门槛

通过统一的 API 调用方式,屏蔽不同模型厂商在接口设计、参数定义和鉴权机制上的差异。

- 强化横向对比能力

支持在同一平台环境下体验和评测多款模型,便于开发者快速判断模型差异与适配度。

- 强调工程可落地性

不止提供概念介绍,而是直接给出可运行的 API 示例,确保“看完即可用”。

对于需要频繁进行模型测试、原型验证或技术选型的开发者而言,这样的平台形态具有非常明显的效率优势。

1.2 典型用户与应用场景

从实际使用角度来看,AI Ping 平台适合以下几类人群:

- 需要进行大模型选型与验证的技术负责人

- 构建 AI 应用或智能体系统的开发团队

- 关注成本控制的个人开发者或初创团队

- 教学、科研或技术学习场景下的使用者

在这些场景中,平台“统一入口 + 多模型并存”的优势会被充分放大。

2. 平台模型生态与激励机制

2.1 多模型接入与持续更新

AI Ping 平台并不局限于单一厂商模型,而是持续接入主流大模型资源,形成较为完整的模型生态。开发者无需分别注册多个平台账号,也无需维护多套 SDK 版本,即可在同一环境中完成多模型调用与对比。

在当前阶段,GLM-4.7 与 MiniMax-M2.1 是平台中关注度最高的两款模型之一,原因不仅在于其能力表现突出,还在于平台对其提供了限时免费体验,极大降低了试用成本。

2.2 邀请机制与奖励金策略

为了进一步降低使用门槛,AI Ping 平台设计了较为直接的激励机制:

- 邀请好友注册并体验平台

- 好友注册成功后,邀请双方各获得 20 元平台奖励金

- 邀请人数不设上限

对于需要反复进行 API 调用测试的开发者来说,这种机制在一定程度上可以抵消调用成本,使模型评测与实验更加“无负担”。

3. GLM-4.7:面向 Agentic Coding 的旗舰级模型

3.1 模型定位与能力概述

GLM-4.7 是智谱推出的最新旗舰模型,核心定位明确指向 Agentic Coding 与复杂智能体任务。与以往版本相比,该模型在编码能力、长程任务规划以及工具协同方面均进行了针对性强化。

在通用能力层面,GLM-4.7 的回复风格更加简洁自然,文本连贯性明显提升;在技术能力层面,模型对复杂指令的理解深度更高,能够在多轮对话和长上下文场景中保持较好的稳定性。在多项公开评测中,GLM-4.7 也取得了当期开源模型中的领先表现,为其工程可用性提供了有力支撑。

3.2 Agentic Coding 场景下的表现

在 Agentic Coding 场景中,模型需要持续参与任务执行过程,而不仅是一次性生成结果。GLM-4.7 在这一类任务中展现出较强的整体一致性,能够在多轮交互中持续围绕既定目标展开,而不易出现偏离。

在复杂需求下,模型更倾向于以工程化思路拆解任务步骤,并在涉及函数调用或工具协同时保持较高的指令遵循度。同时,其生成的 Artifacts(如前端结构或代码骨架)层次清晰,可读性和可用性较高,适合直接作为项目原型或初始实现。

除技术场景外,GLM-4.7 在通用文本生成方面同样表现稳定。其长文本输出逻辑清晰,段落衔接自然,适用于技术方案撰写、系统说明文档生成等场景,在准确性与表达质量之间保持了良好平衡。

4. MiniMax-M2.1:多语言编程能力的实用型升级

4.1 模型定位与特点

MiniMax-M2.1 的整体设计更偏向于“工程实用性”,重点强化了多语言编程能力和代码生成的稳定性。相较于强调智能体能力的模型定位,MiniMax-M2.1 更关注在日常开发中提供高质量、可维护的代码输出。

新版本在主流编程语言覆盖范围、代码结构规范性以及风格一致性方面均有所提升,使生成结果更接近真实项目中的工程代码。

4.2 编程体验与适用场景

在实际使用中,MiniMax-M2.1 对需求的理解较为准确,生成代码时语义偏差较少。其在函数级和模块级代码生成方面表现稳定,逻辑结构清晰,便于开发者阅读和二次修改。

在处理中等复杂度逻辑时,模型对条件分支和边界情况考虑相对完整,生成代码的可用率较高。总体来看,MiniMax-M2.1 更适合作为日常开发过程中的编程助手,用于代码补全、功能实现参考以及多语言实现对照等场景。

5. API 调用体验与工程实践

5.1 多种调用方式支持

AI Ping 平台在工程友好性方面表现突出,目前已直接提供三种常见 API 调用方式示例:

- OpenAI Python SDK

- 基于 requests 的 HTTP 调用

- 使用 curl 的命令行调用

这些示例代码可以直接使用,开发者只需配置 API Key,即可快速完成调用和测试。

5.2 调用方式对比分析

|

调用方式 |

适合人群 |

主要优势 |

使用建议 |

|

Python SDK |

Python 后端开发者 |

封装完善,代码简洁 |

推荐用于服务端集成 |

|

requests |

通用开发者 |

灵活可控,易调试 |

适合定制化需求 |

|

curl |

测试与运维人员 |

无依赖,快速验证 |

适合接口测试 |

这种多层次的调用支持,使平台能够覆盖从快速验证到正式工程集成的完整流程。

5.3 API 调用示例(以 Python 为例)

AI Ping 平台提供了与 OpenAI 风格一致的 API 调用方式,开发者可以直接使用熟悉的 Python SDK 快速完成模型调用。只需在请求中指定所需模型(如 glm-4.7 或 minimax-m2.1),即可在同一套代码结构下灵活切换模型。

|

Python |

通过这种统一的 API 形式,开发者可以在不修改整体工程结构的前提下,自由切换 GLM-4.7 与 MiniMax-M2.1 等模型,非常适合用于模型对比测试、智能体系统集成以及实际业务场景落地。

6. 基于 AI Ping 平台的 GLM-4.7 与 MiniMax-M2.1 选型建议

在实际工程中,大模型选型往往需要同时考虑能力、稳定性与成本。AI Ping 平台通过统一接入与统一 API 调用方式,使开发者能够在同一环境下灵活使用 GLM-4.7 与 MiniMax-M2.1,并根据业务需求进行组合,而非简单取舍。

从能力侧重点来看,GLM-4.7 更适合承担复杂任务与智能体核心能力。在涉及长程任务规划、多步骤执行、工具调用或复杂代码结构生成的场景中,GLM-4.7 更具优势。借助 AI Ping 平台,开发者可以快速将其集成到智能体或自动化流程中,用于高层逻辑与关键决策输出。

相比之下,MiniMax-M2.1 更适合作为高频使用的编程助手模型。在日常开发、功能实现、代码补全以及多语言编程场景中,其稳定性和性价比表现更为突出。通过 AI Ping 平台统一调用 MiniMax-M2.1,可以在保证代码质量的同时有效控制整体调用成本。

AI Ping 平台的核心价值在于支持模型协同使用。实际工程中,可以由 GLM-4.7 负责任务规划与复杂逻辑生成,再由 MiniMax-M2.1 承担具体代码实现与细节补全。这种分工方式在统一平台调度下更加清晰、可控,也更符合真实项目的工程实践需求。

综合来看,AI Ping 平台在当前大模型应用生态中找准了自身定位: 不制造模型,但让模型真正“可用、好用、敢用”。

通过一站式的模型评测与 API 调用能力,加上对 GLM-4.7 与 MiniMax-M2.1 等新一代模型的快速接入和限时免费策略,平台为开发者提供了一个低门槛、高价值的实践环境。

如果你正在寻找一个可以高效评测模型、快速落地工程实践,并兼顾成本控制的平台,AI Ping 无疑是一个值得深入体验的选择。

更多推荐

已为社区贡献74条内容

已为社区贡献74条内容

所有评论(0)