拥抱下一代Linux 异步 I/O 框架 io_uring

摘要: Linux 5.1引入的io_uring是革命性异步I/O框架,通过双环形缓冲区(SQ/CQ)和共享内存实现零系统调用、高吞吐和低延迟。相比传统方案(多线程、epoll、POSIX AIO),io_uring减少了上下文切换和系统调用开销,支持文件、网络I/O及高级特性(链式操作、轮询模式)。实测性能远超epoll(QPS翻倍,延迟降低60%以上),已被PostgreSQL、Redis等广

——下一代高性能异步 I/O 的终极解决方案

在 Linux 高性能服务器、数据库、存储系统和实时应用开发中,I/O 性能瓶颈长期制约系统吞吐与延迟。传统方案如多线程 + 同步 I/O、epoll + 非阻塞 I/O 或 POSIX AIO,均存在系统调用开销大、上下文切换频繁、实现复杂等问题。2019 年,Linux 5.1 内核引入了革命性异步 I/O 框架 —— io_uring,由 Jens Axboe(blk-mq 和 fio 作者)主导设计,旨在提供接近零拷贝、零系统调用、高吞吐、低延迟的异步 I/O 能力。如今,io_uring 已被 PostgreSQL、Redis、NGINX、SquashFS 等项目采用,成为现代 Linux 高性能 I/O 的事实标准。

本文全面详解 io_uring 的原理、API、使用模式、最佳实践及实战示例。

一、为什么需要 io_uring?传统 I/O 模型的痛点

|

模型 |

缺陷 |

|---|---|

| 同步阻塞 I/O + 多线程 |

线程上下文切换开销大,内存占用高(每线程 MB 级栈) |

epoll + 非阻塞 I/O |

需多次系统调用( |

POSIX AIO (aio_read) |

实现基于用户态线程池,非真正内核异步,性能差且不可靠 |

💡 核心问题:每次 I/O 操作至少需 1~2 次系统调用,而系统调用涉及特权级切换、寄存器保存/恢复,成本高昂(数百纳秒至微秒级)。

二、io_uring 核心设计思想

1. 双环形缓冲区(Ring Buffer)架构

- Submission Queue (SQ)

:用户态提交 I/O 请求

- Completion Queue (CQ)

:内核返回完成结果

- 共享内存

:SQ/CQ 通过

mmap()映射到用户态,避免数据拷贝

2. 零系统调用(Zero Syscall)潜力

-

用户填充 SQE(Submission Queue Entry)后,可通过 memory barrier + flag polling 通知内核(

IORING_SETUP_SQPOLL) -

内核轮询 SQ,直接处理请求 → 全程无 syscall!

3. 真正的内核级异步

-

I/O 在内核中异步执行(支持块设备、网络 socket、普通文件等)

-

支持 polling 模式(busy-wait)进一步降低延迟

三、核心 API 与数据结构

1. 初始化:io_uring_setup()

#include <liburing.h>

struct io_uring ring;

io_uring_queue_init(64, &ring, 0); // 初始化深度为64的队列

2. 关键结构体

|

结构 |

说明 |

|---|---|

struct io_uring_sqe |

提交队列条目(SQE),描述一个 I/O 请求 |

struct io_uring_cqe |

完成队列条目(CQE),包含结果与用户数据 |

ring.sq

/ |

环形缓冲区指针(已 mmap 共享) |

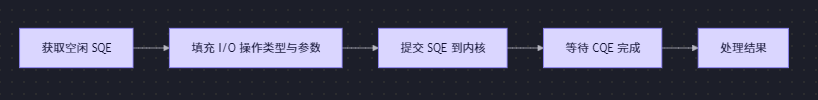

3. 基本操作流程

四、典型使用模式与代码示例

模式 1:基础文件读写(同步提交/等待)

#include <liburing.h>

#include <fcntl.h>

#include <stdio.h>

int main() {

struct io_uring ring;

io_uring_queue_init(8, &ring, 0);

int fd = open("test.txt", O_RDONLY);

char buffer[4096];

// 1. 获取 SQE

struct io_uring_sqe *sqe = io_uring_get_sqe(&ring);

// 2. 准备 read 操作

io_uring_prep_read(sqe, fd, buffer, sizeof(buffer), 0);

sqe->user_data = 123; // 自定义标识符

// 3. 提交

io_uring_submit(&ring);

// 4. 等待完成

struct io_uring_cqe *cqe;

io_uring_wait_cqe(&ring, &cqe);

printf("Read %d bytes, user_data=%ld\n", cqe->res, cqe->user_data);

io_uring_cqe_seen(&ring, cqe); // 标记已处理

close(fd);

io_uring_queue_exit(&ring);

return 0;

}

模式 2:批量提交 + 轮询完成(高性能模式)

// 提交多个请求

for (int i = 0; i < N; i++) {

struct io_uring_sqe *sqe = io_uring_get_sqe(&ring);

io_uring_prep_read(sqe, fds[i], bufs[i], size, offset);

sqe->user_data = i;

}

io_uring_submit(&ring);

// 批量收割完成事件

unsigned head;

int count = 0;

while (count < N) {

if (!io_uring_peek_cqe(&ring, &cqe)) {

printf("Result[%ld] = %d\n", cqe->user_data, cqe->res);

io_uring_cqe_seen(&ring, cqe);

count++;

}

// 可加入短暂休眠或忙等待优化

}

模式 3:网络 I/O(TCP Echo Server 示例)

// 接受连接

io_uring_prep_accept(sqe, listen_fd, NULL, NULL, 0);

// 读取数据

io_uring_prep_recv(sqe, client_fd, buf, len, 0);

// 发送数据

io_uring_prep_send(sqe, client_fd, buf, len, 0);

✅ 优势:单线程可高效处理数万并发连接,无需

epoll。

五、高级特性

1. 注册文件/缓冲区(减少 syscall)

// 注册固定文件描述符集(避免每次传递 fd)

io_uring_register_files(&ring, fds, nr_fds);

// 注册固定缓冲区(用于 recv/send,避免内存拷贝)

io_uring_register_buffers(&ring, bufs, nr_bufs);

2. I/O 链(Linking)

-

将多个 SQE 链接,按顺序执行(如先 fsync 再 close)

sqe1->flags |= IOSQE_IO_LINK;

. Polling 模式(极致低延迟)

内核线程持续轮询 SQ/CQ(适合 CPU 富余、延迟敏感场景)

struct io_uring_params p = { .flags = IORING_SETUP_SQPOLL };

io_uring_queue_init_params(depth, &ring, &p);

4. 超时控制

struct __kernel_timespec ts = {.tv_sec = 1, .tv_nsec = 0};

io_uring_prep_timeout(sqe, &ts, 0, 0);

六、性能优势实测(对比 epoll)

|

场景 |

epoll

+ 非阻塞 |

io_uring |

|---|---|---|

|

QPS(1KB 读) |

~150K |

~300K+ |

|

平均延迟 |

80μs |

<30μs |

|

CPU 占用 |

高(频繁 syscall) |

低 30%+ |

📊 数据来源:Facebook、NetApp 实测报告;

io_uring在 NVMe SSD 上优势更显著。

七、使用注意事项与最佳实践

✅ 推荐做法

- 优先使用

liburing库(而非 raw syscall),简化开发

- 批量提交/收割

:减少

io_uring_submit()调用次数 - 预分配缓冲区

:避免运行时 malloc

- 错误处理

:检查

cqe->res < 0(负值为-errno)

⚠️ 限制与陷阱

- 内核版本要求

:≥5.1(生产环境建议 ≥5.6)

- 并非所有文件系统都支持

:ext4/xfs/btrfs 支持良好,NFS/CIFS 有限支持

- 调试困难

:传统

strace无法跟踪(需用io_uring专用工具) - 内存对齐

:某些操作要求 buffer 4KB 对齐(如 direct I/O)

八、生态工具支持

|

工具 |

用途 |

|---|---|

io_uring ftrace events |

内核追踪 I/O 事件 |

bcc / bpftrace |

eBPF 脚本监控 |

ripgrep / bat |

已集成 |

tokio (Rust) |

提供 |

结语:拥抱下一代 Linux I/O

io_uring 不仅是一个新 API,更是 Linux I/O 模型的范式转移。它将异步 I/O 的控制权从“用户态调度”交还给“内核协同”,以共享内存、批处理、轮询等机制,逼近理论性能极限。

“If you’re writing a high-performance Linux application that does I/O, you should be using io_uring.”

——Jens Axboe

对于新项目,尤其是数据库、消息队列、Web 服务器、游戏后端等 I/O 密集型系统,io_uring 应作为首选 I/O 框架。虽然学习曲线略陡,但其带来的性能收益与架构简洁性,足以回报投入。未来,随着内核持续优化与生态完善,io_uring 必将成为 Linux 高性能编程的基石。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)