大模型驱动的安全测试:AI赋能SQL注入与XSS攻击向量智能生成

摘要:大语言模型为SQL注入和XSS等Web安全漏洞测试带来革新,能自动生成多样化攻击向量,突破传统依赖规则库和人工经验的局限。通过理解漏洞原理和学习攻击模式,大模型可生成上下文相关的测试Payload,显著提升测试覆盖率和效率。但实际应用中仍需注意误报漏报、语境理解局限等挑战,需结合人工复核与隔离测试环境。未来大模型将与AST分析等结合,推动安全测试向智能化、自动化方向发展。

在软件开发生命周期中,安全测试是保障应用韧性的关键屏障。面对日益复杂的攻击手法与敏捷开发节奏,传统依赖固定规则库和人工经验的渗透测试方法,在效率和覆盖率上逐渐面临瓶颈。近年来,以GPT、Codex等为代表的大语言模型展现出强大的代码理解、语义分析和内容生成能力,为自动化安全测试开辟了新的技术路径。本文旨在面向软件测试从业者,深入探讨大模型如何革新SQL注入与跨站脚本攻击这两个核心Web安全漏洞的测试向量生成工作,分析其运作机制、实践价值与当前面临的挑战,以期为测试团队引入智能化工具提供决策参考。

一、传统攻击向量生成的局限与大模型的潜能

SQL注入与XSS作为长期位列OWASP Top 10的高危漏洞,其测试核心在于构造大量多样化、且能绕过基础防御(如WAF)的攻击载荷(Payload)。传统方法主要依赖:

手工构造:高度依赖测试人员的经验和创造力,效率低,覆盖面有限。

基于规则的字典/模糊测试:使用预定义的Payload库进行遍历。其局限性在于难以应对新颖的编码绕过技巧、复杂的逻辑漏洞,且维护和更新字典需要持续的人力投入。

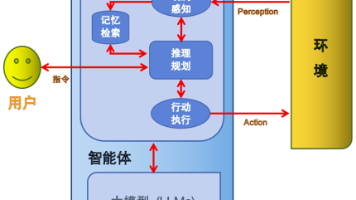

大语言模型通过在海量代码、文档和网络文本数据上进行预训练,不仅掌握了编程语言的语法,更深入理解了其背后的语义逻辑、上下文关联和常见编程模式。这种能力使其能够:

理解漏洞原理:模型能解析“通过用户输入操纵数据库查询”或“向网页中注入可执行脚本”这样的漏洞描述。

学习攻击模式:从公开的漏洞报告、安全研究论文和Payload数据集中,学习到各种攻击技术的特征和变体。

生成上下文相关的Payload:根据目标应用的特点(如疑似使用的数据库类型、输入点过滤规则),动态生成更具针对性和隐蔽性的测试向量。

二、大模型生成攻击向量的核心流程与应用实例

将大模型集成到安全测试流程中,通常遵循以下步骤:

1. 上下文提示与任务定义

测试人员或自动化框架向大模型提供结构化的提示,明确任务。例如:

“针对一个用户登录接口的‘用户名’参数,该参数后端直接拼接到SQL查询中。请生成10个用于检测SQL注入漏洞的测试Payload,要求尝试不同的注入类型(如Union查询、布尔盲注、时间盲注)和常见绕过技巧(如注释符、编码、大小写变换)。假设后端数据库可能是MySQL。”

2. 模型推理与向量生成

基于提示,大模型利用其内部知识生成符合要求的Payload。其优势在于能组合多种技术,生成超出固定字典范围的“新颖”组合。

3. 结果筛选与验证

生成的Payload需要被送入实际的测试靶场或被测系统进行验证,确认其有效性和安全性(避免对生产数据造成破坏)。有效载荷可被收录到项目的智能测试用例库中。

应用实例对比:

SQL注入向量生成:

传统:admin' OR '1'='1

大模型可能生成:admin' AND 1=1 UNION SELECT NULL, database(), NULL -- 或利用十六进制/Unicode编码绕过过滤的变体:admin%27%20AND%201%3D1%20-- 。

XSS向量生成:

传统:<script>alert('XSS')</script>

大模型可能生成:利用事件处理程序、SVG标签、JavaScript伪协议等构造的更隐蔽Payload,例如:<img src=x onerror=alert(document.cookie)> 或 <svg/onload=alert`1`>。

三、为测试工作带来的核心价值

极大提升测试覆盖率与深度:能够快速生成海量、多样化、贴合上下文的测试用例,覆盖更多边缘情况和新型绕过手法,弥补人工思维和固定规则的盲区。

加速测试左移:在开发阶段,可将大模型集成到CI/CD管道中,自动为代码变更生成相关的安全测试用例,实现早期、快速的安全反馈。

降低专业门槛与工作负荷:辅助初级或中级安全测试人员,提供高质量的测试思路和Payload建议,使其能执行更复杂的安全测试任务,同时让高级专家聚焦于更复杂的逻辑漏洞和架构评审。

促进知识沉淀与复用:模型生成的优质Payload和测试场景,可以结构化地存入知识库,形成组织内部不断进化的智能安全测试资产。

四、当前面临的挑战与注意事项

尽管前景广阔,但在实际部署大模型进行安全测试时,测试团队必须审慎应对以下挑战:

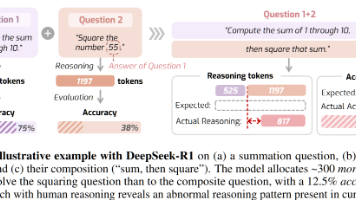

误报与漏报风险:模型可能生成语法正确但实际无效的Payload(误报),或因训练数据偏见或提示不当而遗漏某些关键攻击模式(漏报)。人工复核与结果验证环节不可或缺。

语境理解局限:模型对目标应用具体业务逻辑、定制化框架和深层防御机制的“理解”有限,生成的Payload可能脱离实际环境。

运行成本与性能:调用大模型API(尤其是高性能版本)可能产生显著成本,且生成响应时间相较于本地规则引擎更长,需在测试效率和成本间权衡。

安全与伦理边界:必须严格控制模型的使用范围,仅用于授权的测试目标,防止其能力被滥用。所有生成的攻击代码都应在隔离的测试环境中运行。

提示工程依赖:输出质量高度依赖于输入提示的精确性和完整性,需要测试人员具备一定的“提示工程”技能来引导模型。

五、未来展望与实施建议

未来,大模型在安全测试中的应用将朝着多模态、自动化、精细化方向发展。例如,结合AST(抽象语法树)分析代码结构,或集成到DAST/IAST工具中,实现从代码到运行时的全方位智能分析。

精选文章

更多推荐

已为社区贡献121条内容

已为社区贡献121条内容

所有评论(0)