AI编程:程序员的职业新机遇

随着人工智能技术的飞速发展,AI编程逐渐成为编程领域的热门方向。本文的目的是深入剖析AI编程为程序员带来的职业新机遇,涵盖AI编程的核心概念、算法原理、实际应用场景等多个方面,旨在为程序员提供全面且深入的了解,帮助他们把握这一新兴领域的发展趋势,提升自身的职业竞争力。本文将按照以下结构展开:首先介绍AI编程的核心概念与联系,让读者对AI编程有一个初步的认识;接着详细讲解核心算法原理和具体操作步骤,

AI编程:程序员的职业新机遇

关键词:AI编程、程序员、职业机遇、人工智能、编程技术、职业发展、新兴技术

摘要:本文深入探讨了AI编程为程序员带来的职业新机遇。首先介绍了文章的背景信息,包括目的、预期读者、文档结构和相关术语。接着阐述了AI编程的核心概念、联系、算法原理、数学模型等基础知识。通过项目实战展示了AI编程的具体实现过程。分析了AI编程在不同领域的实际应用场景。推荐了相关的学习资源、开发工具和论文著作。最后总结了AI编程的未来发展趋势与挑战,并解答了常见问题,提供了扩展阅读和参考资料,旨在帮助程序员全面了解AI编程带来的机遇,提升自身职业竞争力。

1. 背景介绍

1.1 目的和范围

随着人工智能技术的飞速发展,AI编程逐渐成为编程领域的热门方向。本文的目的是深入剖析AI编程为程序员带来的职业新机遇,涵盖AI编程的核心概念、算法原理、实际应用场景等多个方面,旨在为程序员提供全面且深入的了解,帮助他们把握这一新兴领域的发展趋势,提升自身的职业竞争力。

1.2 预期读者

本文主要面向广大程序员群体,包括有一定编程基础但对AI编程领域尚不熟悉的初学者,以及希望拓展技术边界、寻求职业突破的有经验的程序员。同时,对于对人工智能和编程行业发展感兴趣的相关人员,本文也具有一定的参考价值。

1.3 文档结构概述

本文将按照以下结构展开:首先介绍AI编程的核心概念与联系,让读者对AI编程有一个初步的认识;接着详细讲解核心算法原理和具体操作步骤,并结合Python代码进行阐述;然后介绍AI编程中的数学模型和公式,通过举例加深理解;之后通过项目实战展示AI编程的实际应用过程;分析AI编程在不同领域的实际应用场景;推荐相关的学习资源、开发工具和论文著作;最后总结AI编程的未来发展趋势与挑战,解答常见问题,并提供扩展阅读和参考资料。

1.4 术语表

1.4.1 核心术语定义

- AI编程:指利用编程语言和相关工具实现人工智能算法和系统的过程,涉及机器学习、深度学习、自然语言处理等多个领域。

- 机器学习:是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。它专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

- 深度学习:是机器学习的一个分支领域,它是一种基于对数据进行表征学习的方法。深度学习通过构建具有很多层的神经网络模型,自动从大量数据中学习特征和模式。

- 自然语言处理:是计算机科学、人工智能和语言学的交叉领域,旨在让计算机能够理解、处理和生成人类语言,包括文本分类、机器翻译、问答系统等应用。

1.4.2 相关概念解释

- 神经网络:是一种模仿人类神经系统的计算模型,由大量的神经元组成。神经元之间通过连接进行信息传递和处理,神经网络可以自动学习数据中的模式和特征。

- 数据集:是用于训练和测试机器学习模型的数据集合,通常包含输入数据和对应的标签。数据集的质量和规模对模型的性能有重要影响。

- 模型训练:是指通过将数据集输入到机器学习模型中,调整模型的参数,使模型能够学习到数据中的模式和规律,从而提高模型的预测能力。

1.4.3 缩略词列表

- AI:Artificial Intelligence,人工智能

- ML:Machine Learning,机器学习

- DL:Deep Learning,深度学习

- NLP:Natural Language Processing,自然语言处理

- API:Application Programming Interface,应用程序编程接口

2. 核心概念与联系

核心概念原理

AI编程的核心在于实现人工智能的各种算法和系统,以模拟人类的智能行为。其中,机器学习是AI编程的重要基础,它通过数据驱动的方式让计算机自动学习和改进。深度学习则是机器学习的一个高级分支,通过构建深度神经网络来处理复杂的数据和任务。自然语言处理则专注于让计算机理解和处理人类语言。

架构的文本示意图

AI编程

├── 机器学习

│ ├── 监督学习

│ │ ├── 分类问题

│ │ ├── 回归问题

│ ├── 无监督学习

│ │ ├── 聚类问题

│ │ ├── 降维问题

│ ├── 强化学习

├── 深度学习

│ ├── 卷积神经网络(CNN)

│ ├── 循环神经网络(RNN)

│ ├── 长短时记忆网络(LSTM)

│ ├── 生成对抗网络(GAN)

├── 自然语言处理

│ ├── 文本分类

│ ├── 情感分析

│ ├── 机器翻译

│ ├── 问答系统

Mermaid流程图

3. 核心算法原理 & 具体操作步骤

监督学习 - 线性回归算法原理

线性回归是一种简单而常用的监督学习算法,用于预测连续数值的输出。其基本原理是通过寻找一条最佳的直线(在多维空间中是超平面)来拟合输入数据和输出数据之间的关系。

算法原理

假设我们有一个包含 nnn 个样本的数据集 {(x1,y1),(x2,y2),⋯ ,(xn,yn)}\{(x_1, y_1), (x_2, y_2), \cdots, (x_n, y_n)\}{(x1,y1),(x2,y2),⋯,(xn,yn)},其中 xix_ixi 是输入特征向量,yiy_iyi 是对应的输出值。线性回归模型的假设函数可以表示为:

hθ(x)=θ0+θ1x1+θ2x2+⋯+θmxmh_{\theta}(x) = \theta_0 + \theta_1x_1 + \theta_2x_2 + \cdots + \theta_mx_mhθ(x)=θ0+θ1x1+θ2x2+⋯+θmxm

其中,θ=[θ0,θ1,⋯ ,θm]\theta = [\theta_0, \theta_1, \cdots, \theta_m]θ=[θ0,θ1,⋯,θm] 是模型的参数,mmm 是特征的数量。

为了找到最佳的参数 θ\thetaθ,我们通常使用最小二乘法,即最小化预测值 hθ(x)h_{\theta}(x)hθ(x) 与真实值 yyy 之间的误差平方和:

J(θ)=12n∑i=1n(hθ(x(i))−y(i))2J(\theta) = \frac{1}{2n}\sum_{i=1}^{n}(h_{\theta}(x^{(i)}) - y^{(i)})^2J(θ)=2n1i=1∑n(hθ(x(i))−y(i))2

我们的目标是找到一组参数 θ\thetaθ,使得 J(θ)J(\theta)J(θ) 取得最小值。

具体操作步骤

- 初始化参数 θ\thetaθ:通常将 θ\thetaθ 初始化为零向量。

- 计算梯度:对 J(θ)J(\theta)J(θ) 求关于 θ\thetaθ 的偏导数,得到梯度。

- 更新参数:使用梯度下降算法更新参数 θ\thetaθ,直到收敛。

Python源代码实现

import numpy as np

class LinearRegression:

def __init__(self, learning_rate=0.01, num_iterations=1000):

self.learning_rate = learning_rate

self.num_iterations = num_iterations

self.weights = None

self.bias = None

def fit(self, X, y):

num_samples, num_features = X.shape

self.weights = np.zeros(num_features)

self.bias = 0

for _ in range(self.num_iterations):

y_pred = np.dot(X, self.weights) + self.bias

dw = (1 / num_samples) * np.dot(X.T, (y_pred - y))

db = (1 / num_samples) * np.sum(y_pred - y)

self.weights -= self.learning_rate * dw

self.bias -= self.learning_rate * db

def predict(self, X):

return np.dot(X, self.weights) + self.bias

无监督学习 - K-Means聚类算法原理

K-Means是一种常用的无监督学习算法,用于将数据集划分为 KKK 个不同的簇。

算法原理

K-Means算法的基本思想是通过迭代的方式将数据点分配到不同的簇中,并不断更新簇的中心,直到簇的中心不再发生变化或达到最大迭代次数。

具体步骤如下:

- 初始化簇中心:随机选择 KKK 个数据点作为初始的簇中心。

- 分配数据点:计算每个数据点到各个簇中心的距离,将数据点分配到距离最近的簇中。

- 更新簇中心:计算每个簇中所有数据点的均值,将该均值作为新的簇中心。

- 重复步骤2和3:直到簇的中心不再发生变化或达到最大迭代次数。

Python源代码实现

import numpy as np

class KMeans:

def __init__(self, k=3, max_iterations=100):

self.k = k

self.max_iterations = max_iterations

self.centroids = None

def fit(self, X):

# 随机初始化簇中心

random_indices = np.random.choice(len(X), self.k, replace=False)

self.centroids = X[random_indices]

for _ in range(self.max_iterations):

# 分配数据点到最近的簇

clusters = [[] for _ in range(self.k)]

for point in X:

distances = [np.linalg.norm(point - centroid) for centroid in self.centroids]

cluster_index = np.argmin(distances)

clusters[cluster_index].append(point)

# 更新簇中心

new_centroids = []

for cluster in clusters:

if len(cluster) > 0:

new_centroid = np.mean(cluster, axis=0)

new_centroids.append(new_centroid)

else:

# 如果某个簇为空,重新随机选择一个数据点作为中心

new_centroid = X[np.random.choice(len(X))]

new_centroids.append(new_centroid)

new_centroids = np.array(new_centroids)

# 判断是否收敛

if np.allclose(new_centroids, self.centroids):

break

self.centroids = new_centroids

def predict(self, X):

predictions = []

for point in X:

distances = [np.linalg.norm(point - centroid) for centroid in self.centroids]

cluster_index = np.argmin(distances)

predictions.append(cluster_index)

return np.array(predictions)

4. 数学模型和公式 & 详细讲解 & 举例说明

线性回归的数学模型和公式

模型假设

线性回归的模型假设为:

hθ(x)=θ0+θ1x1+θ2x2+⋯+θmxm=θTxh_{\theta}(x) = \theta_0 + \theta_1x_1 + \theta_2x_2 + \cdots + \theta_mx_m = \theta^T xhθ(x)=θ0+θ1x1+θ2x2+⋯+θmxm=θTx

其中,x=[1,x1,x2,⋯ ,xm]Tx = [1, x_1, x_2, \cdots, x_m]^Tx=[1,x1,x2,⋯,xm]T 是输入特征向量(添加了一个常数项 1 用于表示截距),θ=[θ0,θ1,⋯ ,θm]T\theta = [\theta_0, \theta_1, \cdots, \theta_m]^Tθ=[θ0,θ1,⋯,θm]T 是模型的参数向量。

损失函数

线性回归常用的损失函数是均方误差(Mean Squared Error,MSE),定义为:

J(θ)=12n∑i=1n(hθ(x(i))−y(i))2J(\theta) = \frac{1}{2n}\sum_{i=1}^{n}(h_{\theta}(x^{(i)}) - y^{(i)})^2J(θ)=2n1i=1∑n(hθ(x(i))−y(i))2

其中,nnn 是样本数量,x(i)x^{(i)}x(i) 是第 iii 个样本的输入特征向量,y(i)y^{(i)}y(i) 是第 iii 个样本的真实输出值。

梯度下降算法

为了最小化损失函数 J(θ)J(\theta)J(θ),我们使用梯度下降算法。梯度下降算法的更新公式为:

θj:=θj−α∂J(θ)∂θj\theta_j := \theta_j - \alpha \frac{\partial J(\theta)}{\partial \theta_j}θj:=θj−α∂θj∂J(θ)

其中,α\alphaα 是学习率,控制每次更新的步长。

对 J(θ)J(\theta)J(θ) 求关于 θj\theta_jθj 的偏导数,得到:

∂J(θ)∂θj=1n∑i=1n(hθ(x(i))−y(i))xj(i)\frac{\partial J(\theta)}{\partial \theta_j} = \frac{1}{n}\sum_{i=1}^{n}(h_{\theta}(x^{(i)}) - y^{(i)})x_j^{(i)}∂θj∂J(θ)=n1i=1∑n(hθ(x(i))−y(i))xj(i)

举例说明

假设我们有一个简单的数据集,包含两个特征 x1x_1x1 和 x2x_2x2,以及对应的输出值 yyy:

| x1x_1x1 | x2x_2x2 | yyy |

|---|---|---|

| 1 | 2 | 3 |

| 2 | 3 | 5 |

| 3 | 4 | 7 |

我们使用线性回归模型来拟合这个数据集。首先,我们初始化参数 θ=[0,0,0]\theta = [0, 0, 0]θ=[0,0,0],学习率 α=0.01\alpha = 0.01α=0.01,迭代次数为 1000 次。

在每次迭代中,我们计算梯度并更新参数:

import numpy as np

# 数据集

X = np.array([[1, 2], [2, 3], [3, 4]])

y = np.array([3, 5, 7])

# 添加常数项

X = np.c_[np.ones((X.shape[0], 1)), X]

# 初始化参数

theta = np.zeros(X.shape[1])

# 学习率和迭代次数

alpha = 0.01

num_iterations = 1000

# 梯度下降

for _ in range(num_iterations):

y_pred = np.dot(X, theta)

error = y_pred - y

gradient = np.dot(X.T, error) / len(y)

theta = theta - alpha * gradient

print("最终参数:", theta)

逻辑回归的数学模型和公式

模型假设

逻辑回归用于解决分类问题,其模型假设为:

hθ(x)=g(θTx)h_{\theta}(x) = g(\theta^T x)hθ(x)=g(θTx)

其中,g(z)=11+e−zg(z) = \frac{1}{1 + e^{-z}}g(z)=1+e−z1 是 sigmoid 函数,用于将线性组合 θTx\theta^T xθTx 映射到 [0,1][0, 1][0,1] 区间,表示样本属于正类的概率。

损失函数

逻辑回归使用对数损失函数(Log Loss),定义为:

J(θ)=−1n∑i=1n[y(i)log(hθ(x(i)))+(1−y(i))log(1−hθ(x(i)))]J(\theta) = -\frac{1}{n}\sum_{i=1}^{n}[y^{(i)}\log(h_{\theta}(x^{(i)})) + (1 - y^{(i)})\log(1 - h_{\theta}(x^{(i)}))]J(θ)=−n1i=1∑n[y(i)log(hθ(x(i)))+(1−y(i))log(1−hθ(x(i)))]

梯度下降算法

同样使用梯度下降算法来最小化损失函数,梯度的计算公式为:

∂J(θ)∂θj=1n∑i=1n(hθ(x(i))−y(i))xj(i)\frac{\partial J(\theta)}{\partial \theta_j} = \frac{1}{n}\sum_{i=1}^{n}(h_{\theta}(x^{(i)}) - y^{(i)})x_j^{(i)}∂θj∂J(θ)=n1i=1∑n(hθ(x(i))−y(i))xj(i)

举例说明

假设我们有一个二分类数据集,包含两个特征 x1x_1x1 和 x2x_2x2,以及对应的类别标签 yyy:

| x1x_1x1 | x2x_2x2 | yyy |

|---|---|---|

| 1 | 2 | 0 |

| 2 | 3 | 1 |

| 3 | 4 | 1 |

我们使用逻辑回归模型来进行分类。

import numpy as np

# 数据集

X = np.array([[1, 2], [2, 3], [3, 4]])

y = np.array([0, 1, 1])

# 添加常数项

X = np.c_[np.ones((X.shape[0], 1)), X]

# 初始化参数

theta = np.zeros(X.shape[1])

# 学习率和迭代次数

alpha = 0.01

num_iterations = 1000

# sigmoid 函数

def sigmoid(z):

return 1 / (1 + np.exp(-z))

# 梯度下降

for _ in range(num_iterations):

z = np.dot(X, theta)

h = sigmoid(z)

error = h - y

gradient = np.dot(X.T, error) / len(y)

theta = theta - alpha * gradient

print("最终参数:", theta)

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

安装Python

首先,确保你已经安装了Python。可以从Python官方网站(https://www.python.org/downloads/)下载并安装适合你操作系统的Python版本。建议安装Python 3.6及以上版本。

安装必要的库

在AI编程中,常用的库包括NumPy、Pandas、Scikit-learn、TensorFlow、PyTorch等。可以使用以下命令来安装这些库:

pip install numpy pandas scikit-learn tensorflow torch

5.2 源代码详细实现和代码解读

项目描述

我们将实现一个简单的手写数字识别项目,使用Scikit-learn库中的MNIST数据集和支持向量机(SVM)算法。

代码实现

import numpy as np

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# 加载MNIST数据集

digits = datasets.load_digits()

X = digits.data

y = digits.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建SVM分类器

clf = SVC(kernel='linear')

# 训练模型

clf.fit(X_train, y_train)

# 预测测试集

y_pred = clf.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

print("准确率:", accuracy)

代码解读

- 加载数据集:使用

datasets.load_digits()函数加载MNIST数据集,X是特征矩阵,y是标签向量。 - 划分训练集和测试集:使用

train_test_split()函数将数据集划分为训练集和测试集,测试集占比为 20%。 - 创建SVM分类器:使用

SVC(kernel='linear')创建一个线性核的支持向量机分类器。 - 训练模型:使用

clf.fit(X_train, y_train)函数对模型进行训练。 - 预测测试集:使用

clf.predict(X_test)函数对测试集进行预测。 - 计算准确率:使用

accuracy_score(y_test, y_pred)函数计算模型的准确率。

5.3 代码解读与分析

数据预处理

在这个项目中,我们直接使用了Scikit-learn库中已经预处理好的MNIST数据集。在实际应用中,可能需要对数据进行更多的预处理,如归一化、标准化等,以提高模型的性能。

模型选择

我们选择了支持向量机(SVM)作为分类器,SVM是一种强大的分类算法,适用于小数据集。在处理大规模数据集时,可能需要选择其他更高效的算法,如深度学习模型。

模型评估

我们使用准确率作为模型的评估指标,准确率是分类问题中常用的评估指标之一。除了准确率,还可以使用其他指标,如精确率、召回率、F1值等,以更全面地评估模型的性能。

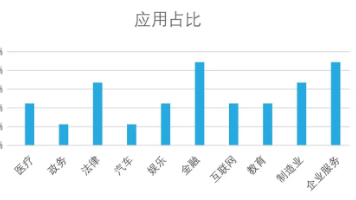

6. 实际应用场景

医疗领域

AI编程在医疗领域有着广泛的应用,如疾病诊断、医学影像分析、药物研发等。例如,通过深度学习模型可以对X光、CT等医学影像进行分析,帮助医生更准确地诊断疾病。在药物研发方面,AI可以通过分析大量的生物数据,预测药物的疗效和副作用,加速药物研发的进程。

金融领域

在金融领域,AI编程可以用于风险评估、欺诈检测、投资决策等。例如,银行可以使用机器学习算法对客户的信用风险进行评估,降低贷款违约的风险。同时,通过分析交易数据,AI可以检测出异常的交易行为,及时发现欺诈活动。

交通领域

AI编程在交通领域的应用包括自动驾驶、智能交通管理等。自动驾驶技术通过传感器和AI算法,让车辆能够自动感知周围环境,做出决策并控制车辆行驶。智能交通管理系统可以通过分析交通流量数据,优化信号灯的控制,提高交通效率。

教育领域

在教育领域,AI编程可以实现个性化学习、智能辅导等功能。例如,通过分析学生的学习数据,AI可以为每个学生制定个性化的学习计划,提供针对性的辅导和建议。智能辅导系统可以模拟教师的教学过程,解答学生的问题。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《机器学习》(周志华):这本书是机器学习领域的经典教材,涵盖了机器学习的基本概念、算法和应用。

- 《深度学习》(Ian Goodfellow、Yoshua Bengio、Aaron Courville):这本书是深度学习领域的权威著作,对深度学习的理论和实践进行了深入的阐述。

- 《Python机器学习实战》(Sebastian Raschka):这本书结合Python代码,详细介绍了机器学习的各种算法和应用。

7.1.2 在线课程

- Coursera上的“机器学习”课程(Andrew Ng教授):这是一门非常经典的机器学习课程,对机器学习的基本概念和算法进行了系统的讲解。

- edX上的“深度学习”课程(Geoffrey Hinton教授):该课程由深度学习领域的先驱Geoffrey Hinton教授授课,深入介绍了深度学习的理论和实践。

- 吴恩达的“机器学习专项课程”:该课程涵盖了机器学习的多个方面,包括监督学习、无监督学习、深度学习等。

7.1.3 技术博客和网站

- Medium:这是一个技术博客平台,有很多关于AI编程的优质文章。

- Towards Data Science:专注于数据科学和机器学习领域的技术博客,提供了很多实用的教程和案例。

- Kaggle:是一个数据科学竞赛平台,上面有很多关于AI编程的开源代码和数据集,可以学习和参考。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专门为Python开发设计的集成开发环境(IDE),提供了丰富的功能和插件,方便进行代码编写、调试和测试。

- Jupyter Notebook:是一个交互式的开发环境,适合进行数据分析和机器学习实验。可以实时运行代码,查看结果,并进行可视化展示。

- Visual Studio Code:是一款轻量级的代码编辑器,支持多种编程语言,有丰富的插件可以扩展功能。

7.2.2 调试和性能分析工具

- TensorBoard:是TensorFlow提供的一个可视化工具,可以用于监控模型的训练过程,查看损失函数、准确率等指标的变化情况。

- PyTorch Profiler:是PyTorch提供的性能分析工具,可以帮助开发者找出代码中的性能瓶颈,优化代码性能。

- cProfile:是Python内置的性能分析工具,可以统计代码中各个函数的执行时间和调用次数。

7.2.3 相关框架和库

- TensorFlow:是Google开发的一个开源机器学习框架,广泛应用于深度学习领域。提供了丰富的API和工具,支持分布式训练和模型部署。

- PyTorch:是Facebook开发的一个开源深度学习框架,具有动态图的特点,易于使用和调试。在学术界和工业界都有广泛的应用。

- Scikit-learn:是一个简单易用的机器学习库,提供了各种机器学习算法和工具,如分类、回归、聚类等。

7.3 相关论文著作推荐

7.3.1 经典论文

- “ImageNet Classification with Deep Convolutional Neural Networks”(Alex Krizhevsky、Ilya Sutskever、Geoffrey E. Hinton):这篇论文提出了AlexNet,开启了深度学习在计算机视觉领域的应用热潮。

- “Long Short-Term Memory”(Sepp Hochreiter、Jürgen Schmidhuber):这篇论文提出了长短时记忆网络(LSTM),解决了循环神经网络中的梯度消失问题。

- “Generative Adversarial Nets”(Ian J. Goodfellow、Jean Pouget-Abadie、Mehdi Mirza等):这篇论文提出了生成对抗网络(GAN),为生成式模型的发展带来了新的思路。

7.3.2 最新研究成果

可以关注顶级学术会议和期刊,如NeurIPS(神经信息处理系统大会)、ICML(国际机器学习会议)、CVPR(计算机视觉与模式识别会议)等,了解AI编程领域的最新研究成果。

7.3.3 应用案例分析

可以参考一些知名公司的技术博客和研究报告,如Google AI Blog、Facebook AI Research等,了解AI编程在实际应用中的案例和经验。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 自动化编程:随着AI技术的发展,自动化编程将成为未来的一个重要趋势。AI可以根据需求自动生成代码,提高编程效率。

- 跨领域融合:AI编程将与其他领域,如生物学、物理学、社会学等进行更深入的融合,创造出更多的创新应用。

- 边缘计算与AI:边缘计算可以将AI算法部署在设备端,减少数据传输延迟,提高系统的响应速度。未来,边缘计算与AI的结合将更加紧密。

挑战

- 数据隐私和安全:AI编程需要大量的数据进行训练,如何保护数据的隐私和安全是一个重要的挑战。

- 算法可解释性:深度学习等复杂算法的可解释性较差,在一些关键领域,如医疗、金融等,算法的可解释性至关重要。

- 人才短缺:AI编程是一个新兴领域,相关的专业人才短缺,如何培养和吸引更多的人才是一个亟待解决的问题。

9. 附录:常见问题与解答

问题1:学习AI编程需要具备哪些基础知识?

学习AI编程需要具备一定的数学基础,如线性代数、概率论、统计学等。同时,还需要掌握一门编程语言,如Python。此外,对机器学习、深度学习等相关概念有一定的了解也很重要。

问题2:AI编程和传统编程有什么区别?

AI编程更注重数据驱动和模型训练,通过大量的数据来让计算机自动学习和改进。而传统编程则更侧重于按照预先设定的规则和逻辑来实现功能。

问题3:如何选择适合自己的AI框架?

选择适合自己的AI框架需要考虑多个因素,如项目需求、个人技术水平、框架的易用性和性能等。对于初学者来说,可以选择Scikit-learn等简单易用的框架;对于深度学习项目,可以选择TensorFlow或PyTorch。

问题4:AI编程在实际应用中会遇到哪些问题?

AI编程在实际应用中可能会遇到数据质量问题、模型过拟合或欠拟合问题、计算资源不足问题等。需要通过数据预处理、模型调优等方法来解决这些问题。

10. 扩展阅读 & 参考资料

扩展阅读

- 《人工智能时代的算法与数据安全》

- 《智能时代:大数据与智能革命重新定义未来》

- 《AI未来进行式》

参考资料

- 《Python数据分析实战》

- 各开源框架的官方文档,如TensorFlow、PyTorch、Scikit-learn等。

- 相关学术会议和期刊的论文,如NeurIPS、ICML、CVPR等。

更多推荐

已为社区贡献114条内容

已为社区贡献114条内容

所有评论(0)